摘要:

Gatys等人最近引入了一种神经算法,以另一幅图像的样式呈现内容图像,实现所谓的样式转换。但是,工作需要缓慢的迭代优化过程,这限制了其实际应用。后来有人提出了一种基于前馈神经网络的快速逼近方法,以加快神经网络的传输速度。不幸的是,速度的提高需要付出代价:网络通常绑定到一组固定的样式,无法适应任意的新样式。在本文中,我们提出了一种简单而有效的方法,它首次实现了任意样式的实时传输。我们方法的核心是一个新颖的自适应实例规范化(AdaIN)层,它将内容特征的均值和方差与样式特征的均值和方差对齐。我们的方法实现了与现有最快方法相媲美的速度,而不受对预定义样式集的限制。此外,我们的方法允许用户进行灵活的控制,如内容折中,样式插值,颜色和空间控制等,所有这些都使用单一的前馈神经网络。

该论文在CIN的基础上做了一个改进,提出了AdaIN(自适应IN层)。顾名思义,就是自己根据风格图像调整缩放和平移参数,不在需要像CIN一样保存风格特征的均值和方差,而是在将风格图像经过卷积网络后计算出均值和方差。

BN(Batch Normalization)

- 归一化一批样例以一个单一风格为中心,但是每个样本仍然可能有自己的风格。

- 对一批样例进行计算每通道的均值和方差。

- BNlayers在训练和测试时采用的是不同的数据集,训练时是采用小批数据。

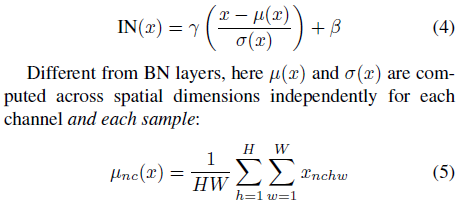

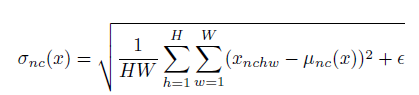

IN(Instance Normalization)

- 每个样例以及每个通道都独立计算均值、方差。

IN layers在训练以及测试时使用相同的数据统计。

- 归一化每个样例到一个单一的风格。

总的来说batch norm是对一个batch里所有的图片的所有像素求均值和标准差。而instance norm是对单个图片的所有像素求均值和标准差。

CIN(Conditional Instance Normalization)

条件实例归一化,A learned representation for artistic style论文中主要提到的方法。网络可以通过使用相同的卷积参数来生成完全不同风格的图像,而只需要对归一化

论文提出AdaIN层,改进了风格转换技术,不再需要预先保存风格特征的均值和方差。通过计算风格图像的实时均值和方差,对内容图像进行归一化,实现快速、任意风格的转换。Decoder部分将特征空间转换回图像,训练过程中关注内容损耗和风格损耗,以VGG网络的特征层计算损耗,风格损耗仅基于AdaIN统计的损耗。

论文提出AdaIN层,改进了风格转换技术,不再需要预先保存风格特征的均值和方差。通过计算风格图像的实时均值和方差,对内容图像进行归一化,实现快速、任意风格的转换。Decoder部分将特征空间转换回图像,训练过程中关注内容损耗和风格损耗,以VGG网络的特征层计算损耗,风格损耗仅基于AdaIN统计的损耗。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

9285

9285

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?