背景

- 之前通过公众号了解到了Aidlux,机缘巧合的情况下参加了『In AidLux,To AIoT』AI应用案例征集活动,在活动过程中,初识了Aidlux平台,该平台可以极大的方便深度学习落地,为智慧工厂,智慧交通等提供了快捷的落地方案。

- 本人最近因为公司需要,开始入门深度学习领域,随着一点点的深入,感觉深度学习是十分有意思的一个学科。关注了很多从事机器学习,深度学习这方面的博客,公众号等。在学习过程中,学习到了江大白老师的《万字长文手把手教你YoloV5制作家庭安防告警系统》,满满的干货,里面的技术要点清晰明了,对于刚入门深度学习的技术人员十分友好。随着学习的深入,参加了最近Aidlux组织,由江大白老师主讲的Aidlux&AI实战训练营,在本次学习中学习了越界识别功能,由人体检测+人体追踪+目标检测组成,本篇博文记录一下开发过程中是如何一步步实现越界识别功能

运行环境

| 硬件环境 | 软件环境 |

|---|---|

| Windows系统电脑 | LabelImg |

| 安卓手机 | YOLOV5 |

| 喵提醒SDK | |

| Aidiux |

总体功能

该系统实现的主要功能需求如下:

(1)数据采集与预处理:

Yolov5 目标检测有部署简单、速度快、易上手等优点。本系统选择 Yolov5 系列中深度最小,特征图宽度最小的 Yolov5n。本系统需要实现对复杂场景中的行人视频进行采集,数据来源有两部分,一部分是使用安卓手机的摄像机进行实时录像和检测,还有一部分是从网络中收集的MOT16视频数据集-东京街道人流量统计的公开数据集(注:来源于旷视的Crowdhuman数据集),然后使用labelImg对采集得到的照片标注然后将标注完成的数据输入YOLOv5目标检测模型中,提取人体特征,训练得到行人模型。

(2)行人检测:

本模块主要是使用上一步得到的行人模型进行推理。

(3)人体轨迹追踪:

常规来说,⽬标追踪主要分成两个类别:⼀种是多⽬标追踪,⼀种是单⽬标追踪。 两者的区别从字⾯意思上也很好理解,多⽬标追踪主要是针对视频中所有的⽬标都进⾏检测+追踪分析。本博文讲的越界识别,主要是监测视频画⾯中,某⼀个区域是否有⼈越界的情况。并且这时的相机采⽤ 的主要是固定枪机摄像头,相机⻆度是不变的,且监测的是多个⼈,因此我们主要采⽤多⽬标检测的方法,即MOT(Multi-Object Tracking)。

(3)结果展示:

最后通过喵提醒SDK,把越界的人员数量实时推送的相关人员的微信上,进行快速的响应及处理

功能模块设计

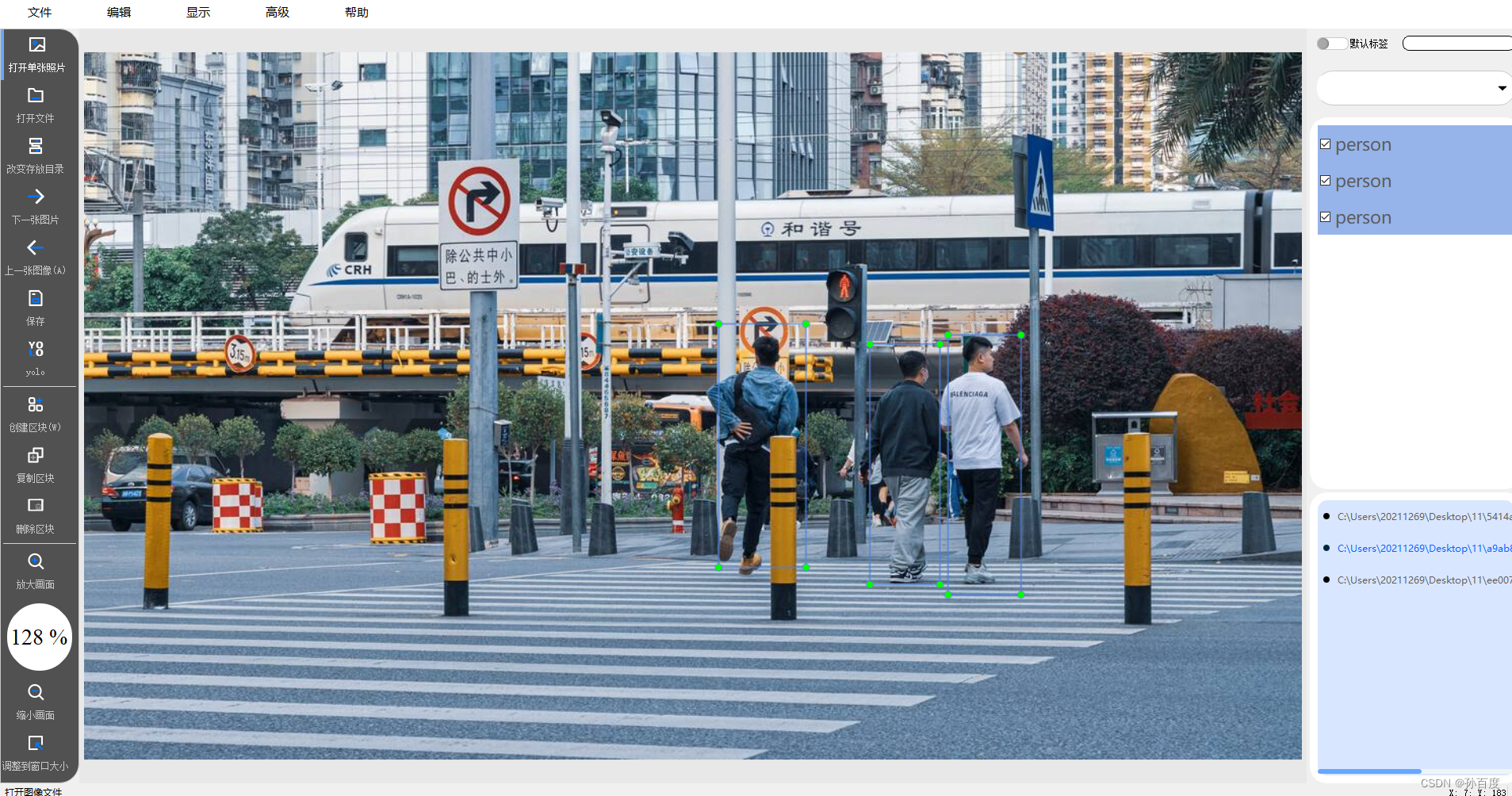

(1)LabelImg

Labelimg是一款可视化图片标注工具,YOLOV5目标检测网络所需要的人体数据集,均需要借此工具标定图像中的目标,生成的txt文件是遵循YOLOV5格式的。从github上下载源码后,安装PyQt+lxml,运行labelimg.py即可打开窗口,进行数据标注工作。本次使用的labelImg,进行了二次开发,优化了整体布局样式,汉化了界面,新增了自动标注,格式转换等新功能(想要的伙伴,可以关注我一下,私信获取)

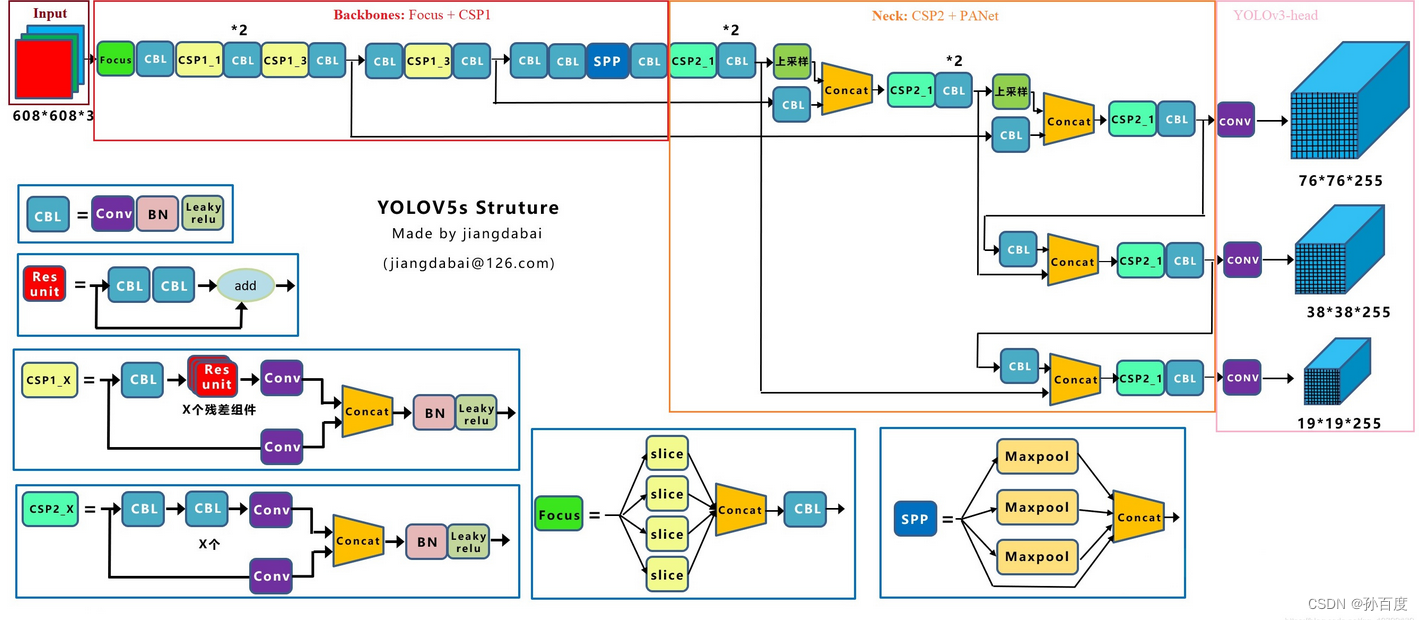

(2)YOLOV5

YOLOV5模型框架图

YOLOV5是在 COCO 数据集上预训练的一系列对象检测架构和模型,代表Ultralytics 对未来视觉 AI 方法的开源研究(官方解释)。从github上下载源码后,安装requirements.txt文件中程序运行所依赖的python包后,导入自定义训练数据集,调整对应的参数后,运行train.py和detect.py进行自定义模型的训练及推理,运行export可以转换为多种类型的模型文件。(最新YOLOV5版本已更新至V6.2版本,新增图片分类模型,及训练代码)

训练完成后,推理效果

(3)多目标检测:

多目标追踪算法包括:sort多目标算法、deepsort多目标检测算法、Bytetrack多目标检测算法。该博文中我们使用最后一个多目标检测算法-Bytetrack,该算法会尽量减少人物之间的遮挡而带来的目标的丢失

三者多⽬标追踪其中涉及了⼤量的逻辑⽅式,⼤家感兴趣也可以好好研究下,也找了⼀些不错的⽂章,可以参考:

(1)带你⼊⻔多⽬标跟踪(⼀)领域概述 7

(2)带你⼊⻔多⽬标跟踪(⼆)SORT&DeepSORT

(3)带你⼊⻔多⽬标跟踪(三)匈⽛利算法&KM算法

(4)带你⼊⻔多⽬标跟踪(四)外观模型 Appearance Model

(5)ByteTrack: Multi-Object Tracking by Associating Every Detection Box阅读笔记

当然,客观来说,多⽬标追踪在遮挡情况下,还存在很多的交错丢失的问题,这也是业内⽬前的⼀个研究瓶颈。

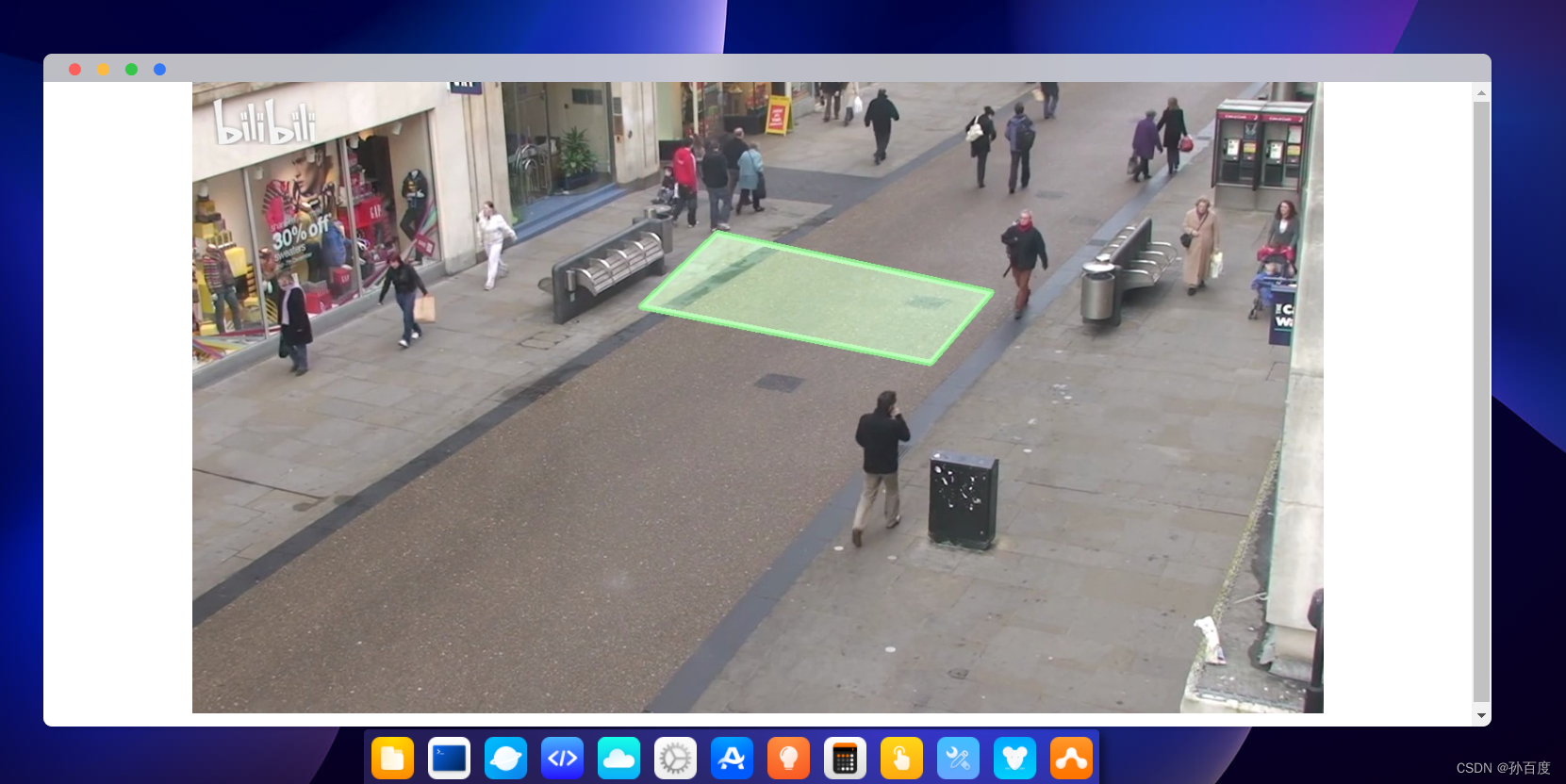

以越界识别为例子,我们主要是设置一个感兴趣的区域,比如下图中绿色区域,当感兴趣的区域内识别到人体的时候,就要重点关注,完成技术功能,(可以使用画图功能,确定区域在图片中的坐标信息)

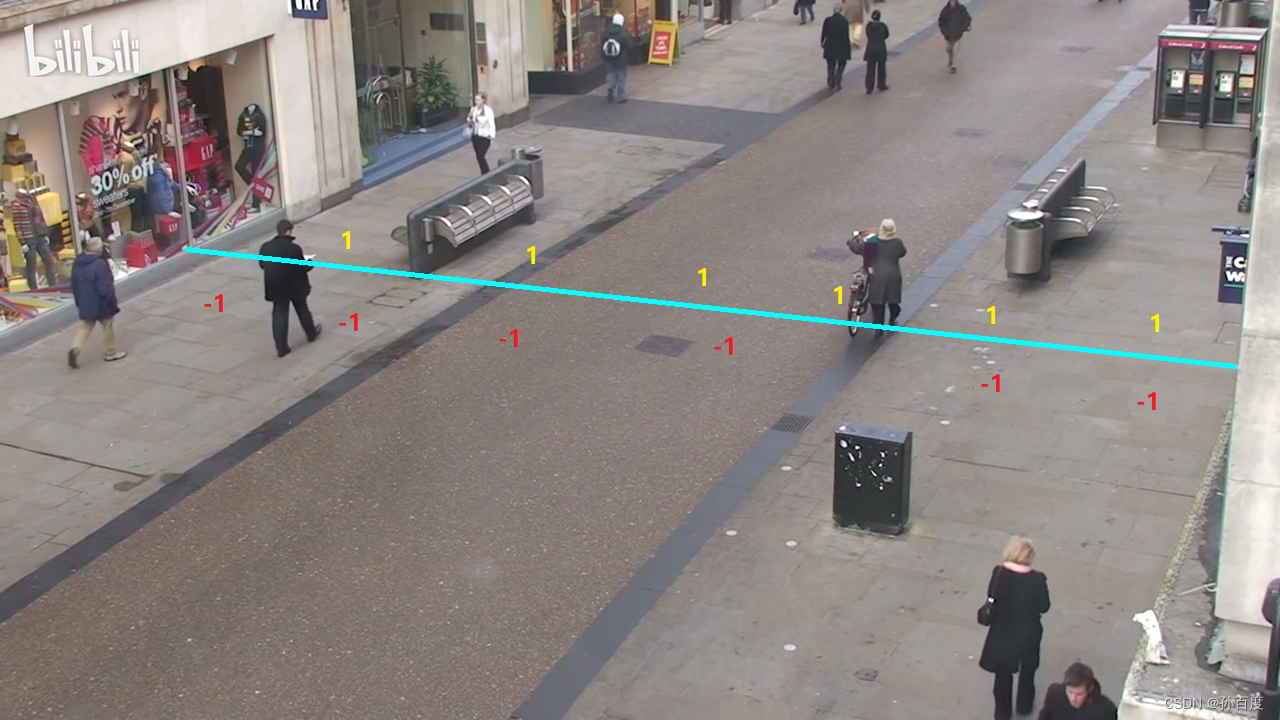

当⼈体在线段的下⽅时,⼈体状态是-1 。当⼈体在线段的上⽅时,⼈体状态是 1。我们这⾥主要统计从- 1 ,到 1 区域的⼈流的数量。

(4)喵提醒

完成越界人员统计后,需要一个工具将数据信息推送到相应人员的手机上,能实时收到应急消息,这个功能可以通过喵提醒公众号来实现,喵提醒是一个提供提醒服务的微信公众号。用户在这创建提醒后可以得到一个网址,将网址交给提供服务的开发者,开发者只需访问这个网址就能给用户发送手机提醒,十分的方便。

(5)AidLux

是基于ARM架构的跨生态(Android/鸿蒙+Linux)一站式AIoT应用快速开发和部署平台APP。通过共享 Linux 内核实现Android 和 Linux 生态融合,为单一设备同时提供Android和Linux运行环境,集成国际主流AI框架和多种开发环境、后台服务程序、编译器及图形开发组件,无须配置开箱即用,极大地简化了开发步骤;自主研发的AI智能加速技术可实现CPU+GPU+NPU智能加速,大幅提高AI应用运行效率;平台广泛而深度的适配外设接口,省去大量调试工作;内置完整的跨平台桌面和命令行终端连接(SSH),一个平台完成多终端协同开发、测试、部署。将上述整合后的代码上传后,运行即可。通过软件商城下载搜索即可。

此时调用手机摄像头开始监控,当检测人员越界后,会接收到一条数据信息,查看人员计数情况

完整代码

# aidlux相关

# 下面的utils函数包和track函数包要到公众号“AidLUx”上回复lesson5

from cvs import *

import aidlite_gpu

from utils import detect_postprocess, preprocess_img, draw_detect_res, scale_coords, process_points, is_in_poly, \

is_passing_line

import cv2

# bytetrack

from track.tracker.byte_tracker import BYTETracker

from track.utils.visualize import plot_tracking

import requests # 库的引用

import time

# 加载模型

model_path = '/home/lesson4_codes/aidlux/best-fp16.tflite'

in_shape = [1 * 640 * 640 * 3 * 4]

out_shape = [1 * 25200 * 6 * 4]

# 载入模型

aidlite = aidlite_gpu.aidlite()

# 载入yolov5检测模型

aidlite.ANNModel(model_path, in_shape, out_shape, 4, 0)

# 初始化文件

tracker = BYTETracker(frame_rate=30)

track_id_status = {}

cap = cvs.VideoCapture("/home/aidlux/person.mp4")

frame_id = 0

count_person = 0

while True:

frame = cap.read()

if frame is None:

print("Camera is over!")

# 填写对应的喵码

id = 'xxxxx'

# 填写喵提醒中,发送的消息,这里放上前面提到的图片外链

text = "越界人流统计:" + str(count_person)

ts = str(time.time()) # 时间戳

type = 'json' # 返回内容格式

request_url = "http://miaotixing.com/trigger?"

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.67 Safari/537.36 Edg/87.0.664.47'}

result = requests.post(request_url + "id=" + id + "&text=" + text + "&ts=" + ts + "&type=" + type,

headers=headers)

break

frame_id += 1

if frame_id % 3 != 0:

continue

# 预处理

img = preprocess_img(frame, target_shape=(640, 640), div_num=255, means=None, stds=None)

# 数据转换:因为setTensor_Fp32()需要的是float32类型的数据,所以送入的input的数据需为float32,大多数的开发者都会忘记将图像的数据类型转换为float32

aidlite.setInput_Float32(img, 640, 640)

# 模型推理API

aidlite.invoke()

# 读取返回的结果

pred = aidlite.getOutput_Float32(0)

# 数据维度转换

pred = pred.reshape(1, 25200, 6)[0]

# 模型推理后处理

pred = detect_postprocess(pred, frame.shape, [640, 640, 3], conf_thres=0.4, iou_thres=0.45)

# 绘制推理结果

res_img = draw_detect_res(frame, pred)

# 目标追踪相关功能

det = []

# Process predictions

for box in pred[0]: # per image

box[2] += box[0]

box[3] += box[1]

det.append(box)

if len(det):

# Rescale boxes from img_size to im0 size

online_targets = tracker.update(det, [frame.shape[0], frame.shape[1]])

online_tlwhs = []

online_ids = []

online_scores = []

# 取出每个目标的追踪信息

for t in online_targets:

# 目标的检测框信息

tlwh = t.tlwh

# 目标的track_id信息

tid = t.track_id

online_tlwhs.append(tlwh)

online_ids.append(tid)

online_scores.append(t.score)

# 针对目标绘制追踪相关信息

res_img = plot_tracking(res_img, online_tlwhs, online_ids, 0, 0)

# 1.绘制统计人流线

lines = [[167, 541], [1191, 539]]

cv2.line(res_img, (167, 541), (1191, 539), (255, 255, 0), 3)

# 2.计算得到人体下方中心点的位置(人体检测监测点调整)

pt = [tlwh[0] + 1 / 2 * tlwh[2], tlwh[1]] # 以人头为识别点

# 3人体和违规线的判断(状态追踪)

track_info = is_passing_line(pt, lines)

if tid not in track_id_status.keys():

track_id_status.update({tid: [track_info]})

else:

if track_info != track_id_status[tid][-1]:

track_id_status[tid].append(track_info)

# 4.判断是否有track_id越界,有的话保存成图片

# 当某个track_id的状态,上一帧是-1,但是这一帧是1时,说明越界了

if track_id_status[tid][-1] == 1 and len(track_id_status[tid]) > 1:

# 判断上一个状态是否是-1,是否的话说明越界,为了防止继续判别,随机的赋了一个3的值

if track_id_status[tid][-2] == -1:

track_id_status[tid].append(3)

# cv2.imwrite("overstep.jpg",res_img)

count_person += 1 # 之前已经定义count_person=0,不然会报未定义的错

# 5.再判断当前一个状态为1,后一个状态为-1时的情况

if track_id_status[tid][-1] == -1 and len(track_id_status[tid]) > 1:

# 判断上一个状态是否是1,是否的话说明越界,为了防止继续判别,随机的赋了一个3的值

if track_id_status[tid][-2] == 1:

track_id_status[tid].append(3)

# cv2.imwrite("overstep.jpg",res_img)

count_person += 1

cv2.putText(res_img, "Pereson_count in the gate of Hospital:" + str(count_person), (50, 50),

cv2.FONT_HERSHEY_SIMPLEX, 1, (255, 0, 255), 3)

cvs.imshow(res_img)

176

176

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?