论文标题:How Can Large Language Models Understand Spatial-Temporal Data?

论文链接:https://arxiv.org/abs/2401.14192

作者:Lei Liu, Shuo Yu, Runze Wang, Zhenxun Ma, Yanming Shen(申彦明)

关键词:交通预测,LLM,少样本,零样本

Cool Paper:https://papers.cool/arxiv/2401.14192

🌟【紧跟前沿】“时空探索之旅”与你一起探索时空奥秘!🚀

欢迎大家关注时空探索之旅

摘要:虽然大型语言模型 (LLM) 在自然语言处理和计算机视觉等任务中占据主导地位,但利用其能力进行时空预测仍然具有挑战性。 顺序文本和复杂的时空数据之间的差异阻碍了这种应用。 为了解决这个问题,本文介绍了 STG-LLM,这是一种支持 LLM 进行时空预测的创新方法。 解决数据不匹配问题:1)STG-Tokenizer:时空图Tokenizer将复杂的图数据转换为捕获空间和时间关系的简洁tokens; 2) STG-Adapter:这种简约的适配器由线性编码和解码层组成,弥补了token化的数据和 LLM 理解之间的差距。 仅通过微调一小部分参数,它可以有效地掌握 STG-Tokenizer 生成的token语义,同时保留 LLM 原有的自然语言理解能力。 对不同时空基准数据集的广泛实验表明,STG-LLM 成功展现了 LLM 在时空预测方面的潜力。 该方法与时空预测专用 SOTA 方法有相当的性能。

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何利用大型语言模型(LLMs)进行时空(spatial-temporal)预测。尽管LLMs在自然语言处理和计算机视觉等领域表现出色,但将它们应用于时空预测任务仍然面临挑战。主要问题包括:

- 数据不匹配:传统的LLMs设计用于处理序列文本数据,而时空数据具有复杂的结构和动态性,这两者之间存在显著差异。

- 模型设计限制:现有的时空预测方法通常需要为特定领域设计专门的模型,这限制了模型的通用性和适应性。

- 数据稀缺和泛化能力:传统的时空预测方法在面对数据稀缺或稀疏的情况下表现不佳,且泛化能力有限。

为了解决这些问题,论文提出了STG-LLM(Spatial-Temporal Graph-Large Language Model),一种创新的方法,旨在通过以下两个关键组件来赋予LLMs处理时空数据的能力:

- STG-Tokenizer:这是一个时空图(graph)标记器(Tokenizer),它将复杂的图数据转换为简洁的tokens,这些token能够捕捉空间和时间关系。

- STG-Adapter:这是一个轻量级的适配器,包含线性编码和解码层,用于在LLMs和token化数据之间架起桥梁,通过微调少量参数,使LLMs能够理解由STG-Tokenizer生成的token的语义,同时保留LLMs原有的自然语言理解能力。

通过这种方法,论文旨在解锁LLMs在时空预测任务中的潜力,并在多个时空基准数据集上的实验表明,STG-LLM能够成功地使LLMs理解时空数据,并实现与现有最先进方法(SOTA)相当的性能。

Q: 有哪些相关研究?

A: 相关研究主要集中在以下几个领域:

- 时空预测(Spatial-Temporal Forecasting):

- 研究涉及统计学习方法和传统机器学习技术,如VAR(向量自回归模型)和SVR(支持向量回归)。

- 深度学习方法,如STGCN(时空图卷积网络)、DCRNN(动态卷积循环神经网络)、STSGCN(时空同步图卷积网络)等,这些方法通过堆叠神经网络模块来捕捉复杂的时空依赖关系。

- 大型语言模型(Large Language Models, LLMs)在时间序列分析中的应用:

- PromptCast:尝试将时间序列描述为文本,并利用LLMs进行推理。

- LLMTIME:将时间序列编码为数字字符串,将时间序列预测转化为下一个token的预测问题。

- GPT4TS:使用补丁策略将时间序列转换为token,然后进行局部微调以确保LLMs理解token的语义。

- TIME-LLM:引入可训练的重编程模块,而不是微调LLMs,以更好地保留LLMs的原始语义。

- 时空图(Spatial-Temporal Graph)数据的处理:

- GraphWaveNet:用于深度时空图建模的方法。

- AGCRN:自适应图卷积循环网络,用于交通流量预测。

- STNorm:用于多变量时间序列预测的空间和时间归一化方法。

这些研究为理解和改进时空数据的预测提供了多种方法和模型,但大多数方法专注于特定领域或数据结构,且在处理时空依赖关系时可能需要复杂的模型设计和大量的数据。STG-LLM的提出旨在通过利用LLMs的强大能力,简化模型设计,提高时空预测的泛化性和适应性。

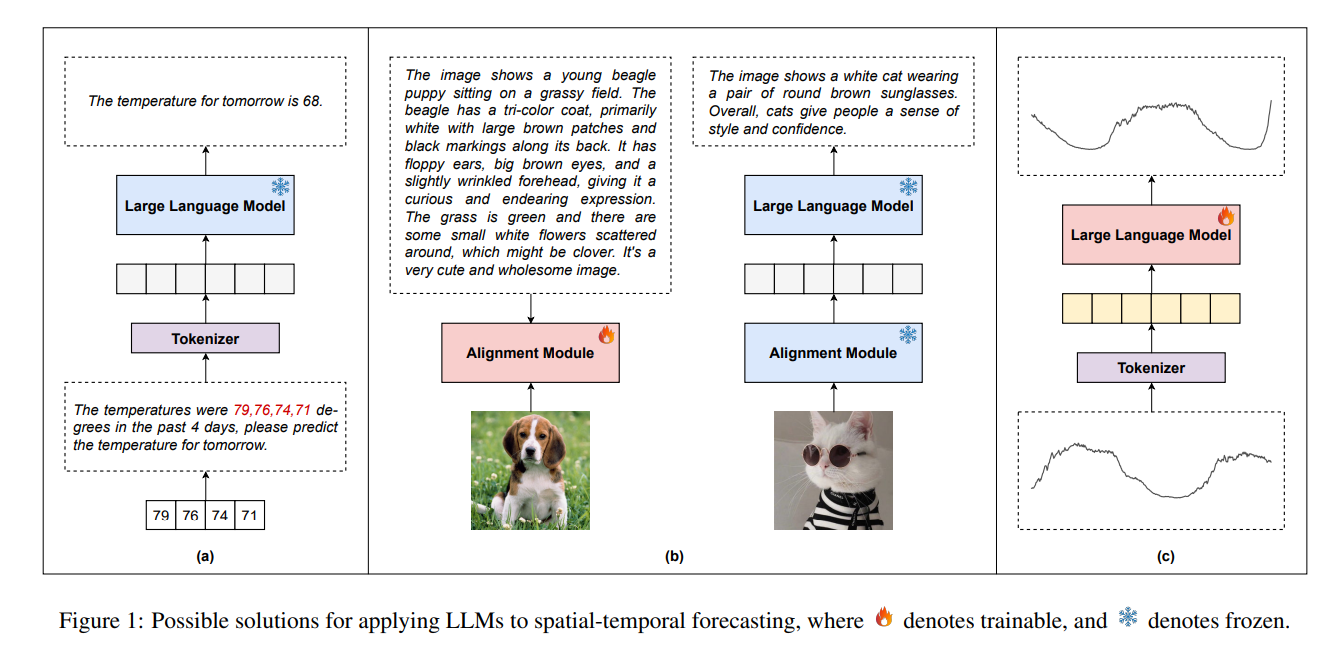

Figure1(a): 使用自然语言描述时空数据,其中时空数据被转换为文本,这种方法需要大量的token来充分描述时空数据。例如,要描述PEMS07(883个节点)中的1小时的时空交通数据,至少需要10596个token。为了进一步描述任务、网络拓扑结构和其他信息,将需要更多的token。大量的token可能超过现有llm的上下文窗口,使其不适用。此外,现有的LLM没有能力基于自然语言描述来推断复杂的时空依赖性。

Figure1(b):利用时空数据和相关文本。这样,就可以通过对齐模块等方法将时空数据映射到文本中。这种方法目前在计算机视觉领域被广泛使用,但它在很大程度上依赖于大规模高质量的文本和非文本配对数据的可用性。但是不适用于时空预测,因为时空数据集通常是小尺度特征(characterized by small scale)且缺乏文本信息。

**Figure1(c)**微调时间序列的做法最近越来越流行。这种方法需要将时间序列转换为LLM无法理解的一组有限的token,然后对LLM进行微调,以掌握token的语义。然而,现有的方法主要集中于处理时间序列数据,没有准确捕捉时空依赖性的能力,这对时空预测至关重要。此外,由于任务差异,时间序列的微调策略不适用于时空预测。

Q: 论文如何解决这个问题?

A: 论文提出了STG-LLM(Spatial-Temporal Graph-Large Language Model)来解决大型语言模型(LLMs)在时空预测中的应用问题。STG-LLM通过以下两个主要组件来实现这一目标:

- STG-Tokenizer:

- STG-Tokenizer将时空图中的每个节点视为一个token,并为每个节点生成包含时间序列数据和额外信息(如时间信息)的token。

- 通过这种方式,可以将复杂的时空数据转换为LLMs可以理解的有限数量的token,同时保持数据的时空语义信息。

- STG-Adapter(时空图适配器):

- STG-Adapter由线性编码层和线性解码层组成,用于在LLMs和token化数据之间建立联系。

- 编码层将token映射到LLMs的嵌入维度,同时捕捉token内的时序语义。

- 解码层则根据LLMs捕捉到的时空依赖关系生成预测。

STG-LLM的关键优势在于:

- 无需复杂模型设计:STG-LLM不需要为特定领域设计复杂的模型,而是通过简单的适配器来利用LLMs的自然语言理解能力。

- 泛化能力:STG-LLM能够适应多种时空预测任务,通过提示(prompting)和微调(fine-tuning)来定制模型以适应特定领域。

- 参数效率:STG-LLM只需要微调少量参数即可理解时空数据,这与当前的方法相比,参数数量更少,训练成本更低。

通过这些方法,STG-LLM能够有效地使LLMs理解时空数据,并在多个时空基准数据集上实现与现有最先进方法(SOTA)相当的性能。

冻结多头注意力,训练位置编码与层归一化

下面显示了LLM的组合token的一个例子,其中“ ÷ \div ÷”和“ ◃ \triangleleft ◃”等符号的含义表示LLM生成的尚未理解的token,并将通过轻量级微调来解决。

Q: 论文做了哪些实验?

A: 论文进行了一系列的实验来验证STG-LLM的有效性,包括以下几个方面:

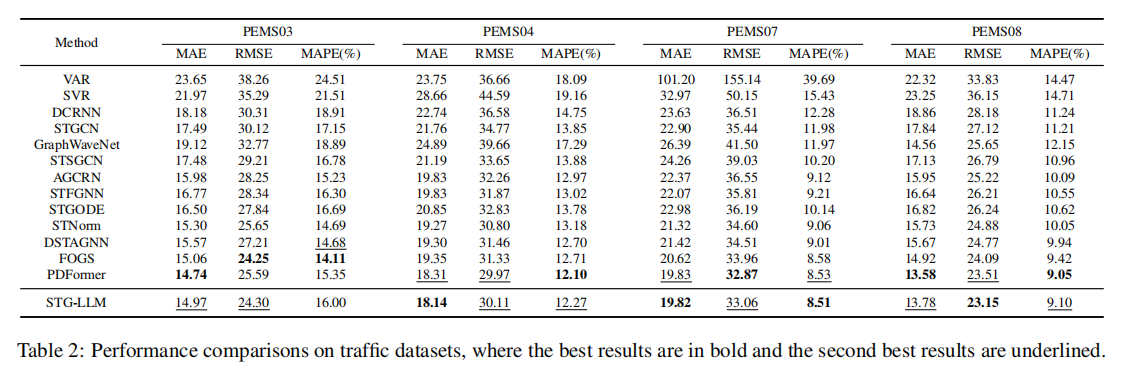

- 整体性能(Overall Performance):

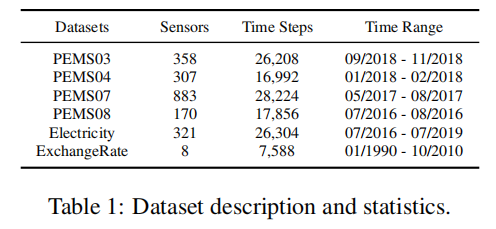

- 在六个代表性的真实世界时空公共数据集上验证STG-LLM的有效性,这些数据集包括四个交通数据集(PEMS03, PEMS04, PEMS07, PEMS08)、一个电力消耗数据集(Electricity)和一个金融数据集(ExchangeRate)。

- 与多种基线方法进行比较,包括传统的时空预测方法、基于深度学习的有预定义图结构的方法以及没有预定义图结构的方法。

- 少样本预测(Few-shot Forecasting):

- 验证STG-LLM在只有少量数据的情况下对新下游数据集的泛化能力。通过在PEMS04和PEMS08数据集上进行实验,观察在不同样本大小下STG-LLM的性能。

- 提示效果(Prompt Effectiveness):

- 研究在STG-LLM中添加时间提示对预测性能的影响。通过移除时间嵌入模块并直接在LLMs中提供时间信息,来验证提示的有效性。

- 消融研究(Ablation Study):

- 对STG-LLM的各个关键组件进行消融研究,包括移除LLM、位置嵌入(PE)、标记器(Tokenizer)和适配器(Adapter),以评估每个组件对整体性能的贡献。

- 参数效率(Parameter Efficacy):

- 分析STG-LLM中需要微调的参数数量,并与整体参数数量进行比较,以证明STG-LLM在参数效率方面的优势。

这些实验旨在全面评估STG-LLM在不同场景下的性能,包括其在新任务上的泛化能力、对提示的敏感性、各组件的重要性以及在参数使用上的效率。通过这些实验,论文展示了STG-LLM在时空预测任务中的潜力和实用性。

Q: 有什么可以进一步探索的点?

A: 尽管STG-LLM在时空预测任务中取得了显著的成果,但仍有一些潜在的研究方向可以进一步探索:

- 模型泛化能力:

- 研究STG-LLM在更多样化和复杂性更高的时空数据集上的性能,例如涉及更多变量和更复杂的动态变化的数据集。

- 模型解释性:

- 提高STG-LLM的可解释性,以便更好地理解模型是如何进行时空预测的,特别是在关键决策点上。

- 实时预测与在线学习:

- 探索STG-LLM在实时预测场景中的应用,以及如何实现在线学习,以便模型能够持续适应新的数据和环境变化。

- 多模态数据融合:

- 研究如何将STG-LLM与多模态数据(如图像、文本、传感器数据等)结合,以提高预测的准确性和稳健性。

- 计算效率:

- 优化STG-LLM的计算效率,使其能够在资源受限的环境中运行,例如在边缘设备上进行实时预测。

- 模型稳健性:

- 提高STG-LLM对异常值和噪声数据的稳健性,确保在实际应用中能够稳定地提供预测。

- 跨领域应用:

- 探索STG-LLM在其他领域的应用,如环境监测、健康医疗、金融风险评估等,以验证其跨领域的适用性。

- 模型压缩与轻量化:

- 研究如何压缩STG-LLM模型,减少模型大小和推理时间,以便在移动设备或嵌入式系统中部署。

- 交互式预测:

- 开发交互式预测系统,允许用户通过自然语言与模型进行交流,获取更详细的预测解释和建议。

- 长期预测:

- 研究STG-LLM在长期预测任务中的性能,特别是在需要考虑季节性变化和趋势的情况下。

这些研究方向不仅有助于进一步提升STG-LLM的性能,还能够扩展其在实际应用中的广度和深度。

Q: 总结一下论文的主要内容

A: 这篇论文介绍了STG-LLM(Spatial-Temporal Graph-Large Language Model),一种创新的方法,旨在利用大型语言模型(LLMs)进行时空预测。以下是论文的主要内容概述:

- 问题背景:

- 论文指出,尽管LLMs在自然语言处理和计算机视觉等领域表现出色,但将它们应用于时空预测任务仍然面临挑战,主要是因为文本数据与时空数据之间的差异。

- STG-LLM方法:

- 为了解决这一问题,论文提出了STG-LLM,它包含两个关键组件:STG-Tokenizer和STG-Adapter。

- STG-Tokenizer将复杂的时空图数据转换为LLMs可以理解的tokens,这些token捕捉了空间和时间关系。

- STG-Adapter是一个轻量级的适配器,通过线性编码和解码层,帮助LLMs理解这些token的语义,同时保留其自然语言理解能力。

- 实验与结果:

- 在多个时空基准数据集上进行了广泛的实验,包括交通流量、电力消耗和汇率数据。

- 实验结果表明,STG-LLM能够有效地解锁LLMs在时空预测任务中的潜力,并与现有的最先进方法(SOTA)相比,取得了具有竞争力的性能。

- 贡献总结:

- 提出了一种新的LLM应用方法,无需复杂的模型设计即可进行时空预测。

- 设计了STG-Tokenizer,将时空数据转换为LLMs可以理解的token。

- 提出了STG-Adapter,通过微调少量参数使LLMs理解token的语义。

- 实验验证了STG-LLM在时空预测任务中的有效性,并展示了其在数据稀缺情况下的泛化能力。

- 相关工作:

- 论文回顾了时空预测和LLMs在时间序列分析中的应用的相关研究,指出了现有方法的局限性,并强调了STG-LLM的创新点。

- 结论:

微调少量参数使LLMs理解token的语义。- 实验验证了STG-LLM在时空预测任务中的有效性,并展示了其在数据稀缺情况下的泛化能力。

- 相关工作:

- 论文回顾了时空预测和LLMs在时间序列分析中的应用的相关研究,指出了现有方法的局限性,并强调了STG-LLM的创新点。

- 结论:

- STG-LLM展示了LLMs在时空预测任务中的潜力,通过简单的适配器和token化策略,实现了与现有方法相当的性能,同时具有更好的泛化能力和参数效率。

🌟【紧跟前沿】“时空探索之旅”与你一起探索时空奥秘!🚀

欢迎大家关注时空探索之旅

- STG-LLM展示了LLMs在时空预测任务中的潜力,通过简单的适配器和token化策略,实现了与现有方法相当的性能,同时具有更好的泛化能力和参数效率。

论文探讨了如何让大型语言模型处理时空数据,提出STG-LLM方法,通过时空图Tokenizer和STG-Adapter,有效解决数据匹配问题,实现在时空预测任务中的竞争力。

论文探讨了如何让大型语言模型处理时空数据,提出STG-LLM方法,通过时空图Tokenizer和STG-Adapter,有效解决数据匹配问题,实现在时空预测任务中的竞争力。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?