首先确定线性模型函数,以及损失函数的公式

编写代码主要有四个步骤:

以下是我对于本节做的笔记,话不多说,上图

线性模型的pytorch实现代码如下:

import torch

# prepare dataset 第一步:准备数据集

# x,y是矩阵,3行1列 也就是说总共有3个数据,每个数据只有1个特征

x_data = torch.tensor([[1.0],[2.0],[3.0]]) #每个元素一定要用[]括起来

y_data = torch.tensor([[2.0],[4.0],[6.0]])

#design model using class 第二步:设计模型使用的类

"""

我们的模型类应该从nn(neural network神经网络)继承。它是所有神经网络模块的基类。

成员方法__init__()和forward()必须在类nn中实现。线性包含两个成员张量:权量和偏置类nn。Linear实现了神奇的方法__call__(),

它使类的实例可以像函数一样被调用。通常会调用forward()

"""

class LinearModel(torch.nn.Module): #把模型构建成一个类

def __init__(self):

super(LinearModel,self).__init__()

# (1,1)是指输入x和输出y的特征维度,这里数据集中的x和y的特征都是1维的

# 该线性层需要学习的参数是w和b 获取w/b的方式分别是~linear.weight/linear.bias

self.linear = torch.nn.Linear(1,1)

def forward(self,x):

y_pred = self.linear(x)

return y_pred

model = LinearModel()

# construct loss and optimizer 第三步:构造损失和优化器

# criterion(损失准则) = torch.nn.MSELoss(size_average = False)

criterion = torch.nn.MSELoss(size_average=False)

optimizer = torch.optim.SGD(model.parameters(),lr=0.02) # model.parameters()自动完成参数的初始化操作,lr学习率

#training cycle forward, backward, update 第四步:训练前向,后向更新周期

for epoch in range(1000):

y_pred = model(x_data) # forward:predict

loss = criterion(y_pred,y_data) # forward: loss

print(epoch,loss.item())

optimizer.zero_grad() # the grad computer by .backward() will be accumulated(累积). so before backward, remember set the grad to zero

loss.backward() # backward: autograd,自动计算梯度

optimizer.step() # update 参数,即更新w和b的值

print('w=',model.linear.weight.item())

print('b=',model.linear.bias.item())

x_test = torch.tensor([[4.0]])

y_test = model(x_test)

print('y_pred=',y_test)

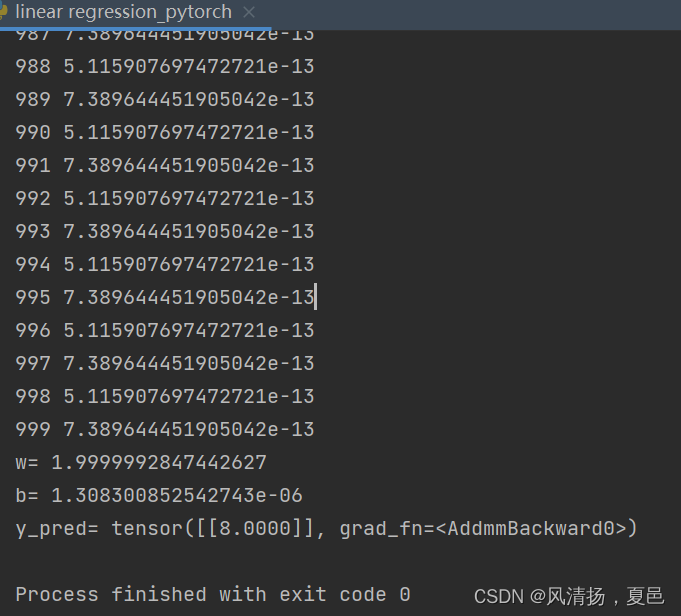

以下是迭代100,1000次得到的结果:

426

426

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?