二、logstash数据采集

我们在开启一台虚拟机server3充当logstash服务器

简介

-

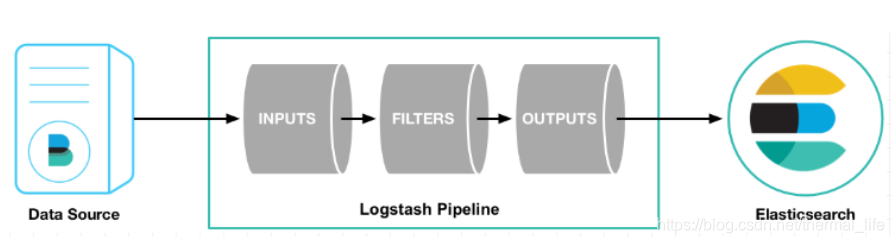

Logstash是一个开源的服务器端数据处理管道。

-

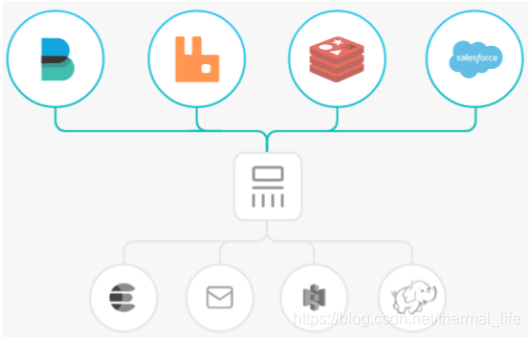

logstash拥有200多个插件,能够同时从多个来源采集数据,转

换数据,然后将数据发送到您最喜欢的 “存储库” 中。(大多都

是 Elasticsearch。) -

Logstash管道有两个必需的元素,输入和输出,以及一个可选元素过滤器

-

输入:采集各种样式、大小和来源的数据

- Logstash 支持各种输入选择 ,同时从众多常用来源捕捉事件。

- 能够以连续的流式传输方式,轻松地从您的日志、指标、 Web 应用、数据存储以及各种 AWS 服务采集数据。

-

过滤器:实时解析和转换数据

-

数据从源传输到存储库的过程中,Logstash 过滤器能够解析各个事件,识别已命名的字段以构建结构,并将它们转换成通用格式,以便更轻松、更快速地分析和实现商业价值。

-

利用 Grok 从非结构化数据中派生出结构

-

从 IP 地址破译出地理坐标

-

将 PII 数据匿名化,完全排除敏感字段

-

简化整体处理,不受数据源、格式或架构的影响

-

-

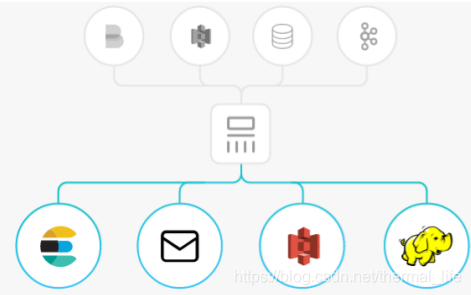

输出:选择您的存储库,导出您的数据

- 尽管 Elasticsearch 是我们的首选输出方向,能够为我们的搜索和分析带来无限可能,但它并非唯一选择。

- Logstash 提供众多输出选择,您可以将数据发送到您要指定的地

方,并且能够灵活地解锁众多下游用例。

Logstash安装与配置

软件下载:

https://elasticsearch.cn/download/

logstash安装:

[root@server3 ~]# rpm -ivh jdk-8u181-linux-x64.rpm # 由于是java开发的,需要jdk的支持,我们不用系统自带的

[root@server3 ~]# rpm -ivh logstash-7.6.1.rpm

它的命令存放在:

[root@server3 bin]# ls

benchmark.sh dependencies-report logstash logstash-keystore logstash.lib.sh logstash-plugin.bat pqrepair setup.bat

cpdump ingest-convert.sh logstash.bat logstash-keystore.bat logstash-plugin pqcheck ruby system-install

[root@server3 bin]# pwd

/usr/share/logstash/bin

测试:

[root@server3 bin]# ./logstash -e 'input { stdin { } } output { stdout {} }' # -e 使用命令行

hello # 我们在这里输入什么

/usr/share/logstash/vendor/bundle/jruby/2.5.0/gems/awesome_print-1.7.0/lib/awesome_print/formatters/base_formatter.rb:31: warning: constant ::Fixnum is deprecated

{

"host" => "server3",

"message" => "hello", # 下面就会显示什么

"@version" => "1",

"@timestamp" => 2020-06-09T14:33:25.403Z

}

world

{

"host" => "server3",

"message" => "world",

# ctrl + c 退出

说明我们刚才写的命令没问题。我们去配置文件中编写。

file输出插件

[root@server3 conf.d]# vim /etc/logstash/conf.d/test.conf

input {

stdin {}

}

output {

stdout {}

}

[root@server3 bin]# ./logstash -f /etc/logstash/conf.d/test.conf # -f 指定文件去调用,这样更推荐使用

这种的输入输出都再命令行中,我们也可以使用输出的文件路径

[root@server3 conf.d]# vim /etc/logstash/conf.d/test.conf

...

output {

file {

path => "/tmp/logstash.txt"

codec => line { format => "custom format: %{message}"}

[root@server3 bin]# ./logstash -f /etc/logstash/conf.d/test.conf

wo

[INFO ] 2020-06-09 22:45:32.269 [[main]>worker0] file - Opening file {:path=>"/tmp/logstash.txt"}

# 可以看出这里的输出指定到了 :path=>"/tmp/logstash.txt

ai

ni

[root@server3 bin]# cat /tmp/logstash.txt

custom format: wo

custom format: ai

custom format: ni # 确实保存到了这里,当然我们最常用的是指定输出到ES 中

输出至ES,ES进行分析,然后kibana在进行展示.

elasticsearch输出插件

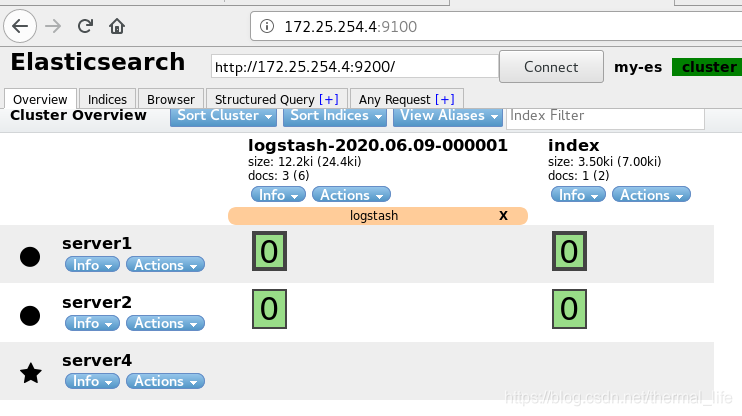

输出至ES:

[root@server3 conf.d]# vim es.conf

input {

stdin {}

}

output {

stdout {}

elasticsearch {

hosts => "172.25.254.4:9200" # 输出到的ES主机与端口

index => "logstash-%{+YYYY.MM.dd}" # 定制索引名称

}

}

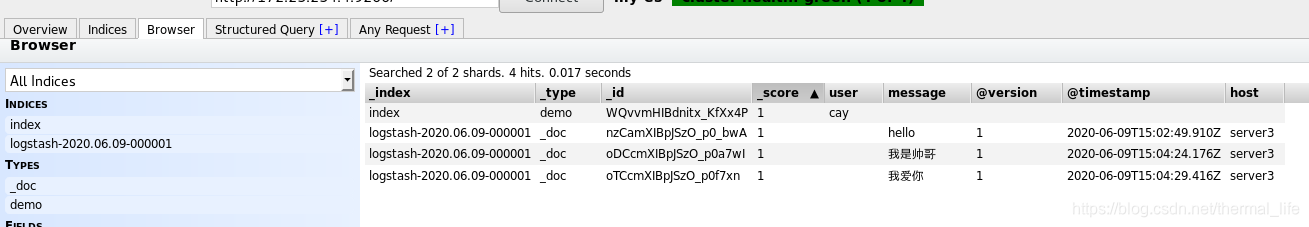

[root@server3 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/es.conf

hello

/usr/share/logstash/vendor/bundle/jruby/2.5.0/gems/awesome_print-1.7.0/lib/awesome_print/formatters/base_formatter.rb:31: warning: constant ::Fixnum is deprecated

{

"message" => "hello",

"@version" => "1",

"@timestamp" => 2020-06-09T15:02:49.910Z,

"host" => "server3"

}

我是帅哥

{

"message" => "我是帅哥",

"@version" => "1",

"@timestamp" => 2020-06-09T15:04:24.176Z,

"host" => "server3"

}

我爱你

{

"message" => "我爱你",

"@version" => "1",

"@timestamp" => 2020-06-09T15:04:29.416Z,

"host" => "server3"

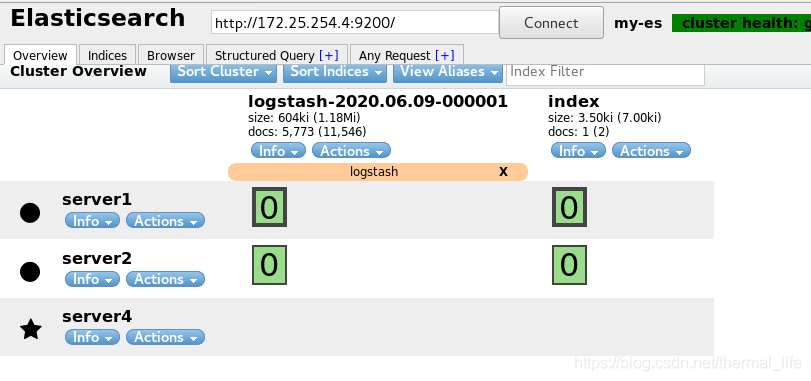

然后再web端查看

就在ES上可以查看了。

这种的输入是我们一直在手敲,是不方便的,所以我们可以把文件中的内容输出至ES。

file输入插件

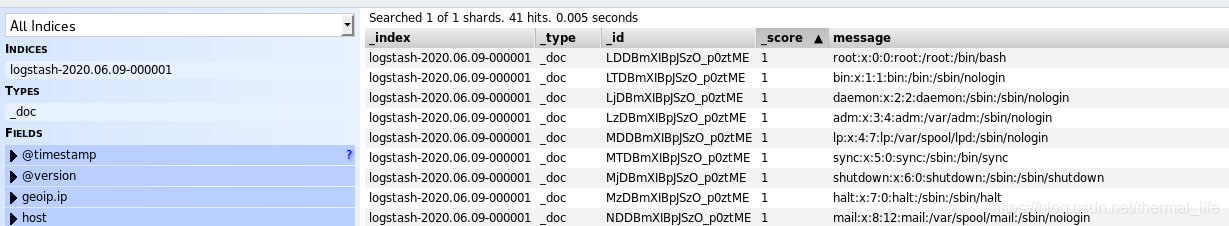

[root@server3 conf.d]# vim es.conf

input {

file {

path => "/etc/passwd" # 输入这个文件中的内容

start_position => "beginning" # begin 是从头开始读,end从末尾读,即只读新的内容

}

}

output {

stdout {}

elasticsearch {

hosts => "172.25.254.4:9200"

index => "logstash-%{+YYYY.MM.dd}"

}

}

[root@server3 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/es.conf # 运行

# 然后再web查看:

就过来了。

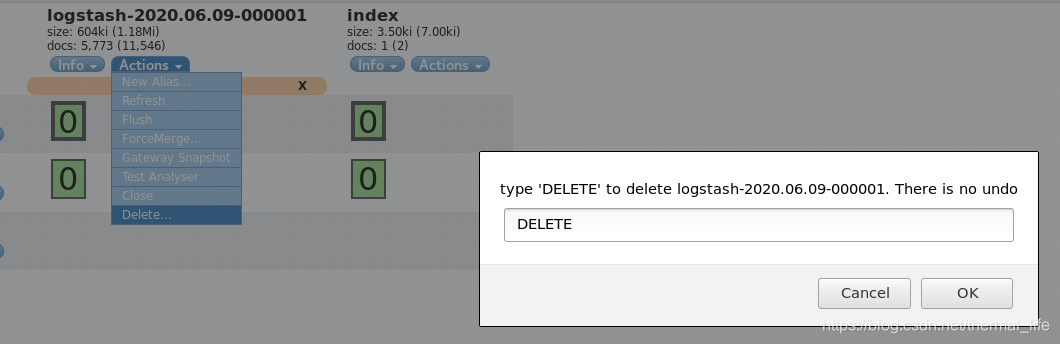

这样又出现了一种问题,就是,我们删除这个logstash

现在没有logstash了,我们在重新发送

[root@server3 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/es.conf

[INFO ] 2020-06-09 23:33:25.506 [[main]<file] observingtail - START, creating Discoverer, Watch with file and sincedb collections

[INFO ] 2020-06-09 23:33:26.105 [Api Webserver] agent - Successfully started Logstash API endpoint {:port=>9600}

# 现在它就卡在这里了,不会在重新输入数据了,这样就避免了数据的冗余。

它是怎样实现的那,也就是说logstash如何区分设备、文件名、文件的不同版本?:

因为 logstash会把进度保存到sincedb文件中,这样在下次读取的时候会直接读取这个since文件,从上次的位置在开始。

[root@server3 ~]# find / -name .sincedb*

/usr/share/logstash/data/plugins/inputs/file/.sincedb_452905a167cf4509fd08acb964fdb20c

/usr/share/logstash/data/plugins/inputs/file/.sincedb_c5068b7c2b1707f8939b283a2758a691

#sincedb文件内容解释

[root@server3 file]# cat .sincedb_c5068b7c2b1707f8939b283a2758a691

17236146 0 64768 960 1591716805.901863 /etc/passwd

sincedb文件一共6个字段:

- inode编号

- 文件系统的主要设备号

- 文件系统的次要设备号

- 文件中的当前字节偏移量 (进度)

- 最后一个活动时间戳(浮点数)

- 与此记录匹配的最后一个已知路径

我们想重新读的话删除这个文件就可以了。

[root@server3 file]# rm -fr .sincedb_*

[root@server3 file]# ls .

./ ../

[root@server3 file]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/es.conf # 不退出重开一个终端,查看年偏移量,这样会持续关注文件内容

[root@server3 file]# ls -a

. .. .sincedb_c5068b7c2b1707f8939b283a2758a691

[root@server3 file]# cat .sincedb_c5068b7c2b1707f8939b283a2758a691

17236146 0 64768 960 1591717513.779288 /etc/passwd

## 此时的文件偏移量是960

我们在插入一条数据:

[root@server3 file]# useradd caoaoyuan

[root@server3 file]# cat .sincedb_c5068b7c2b1707f8939b283a2758a691

17759114 0 64768 1009 1591717900.9324548 /etc/passwd

# 增加了

我们还可以吧文件路径这里改成我们的日志路径,比如/etc/log/httpd/access_log.

[root@server3 ~]# vim /etc/logstash/conf.d/es.conf

input {

file {

path => "/var/log/httpd/access_log"

start_position => "beginning"

}

}

output {

stdout {}

elasticsearch {

hosts => "172.25.254.4:9200"

index => "apache-%{+YYYY.MM.dd}"

}

}

[kiosk@rhel7host ~]$ ab -c 1 -n 100 http://172.25.254.3/index.html #压力测试

[root@server3 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/es.conf # 导入

就有了100条数据。

但是这样的话太繁琐,x需要在每台机器上装个logsatsh,我们可以把logstash伪装成日志服务器,直接接受远程日志,做一个日志采集服务器。

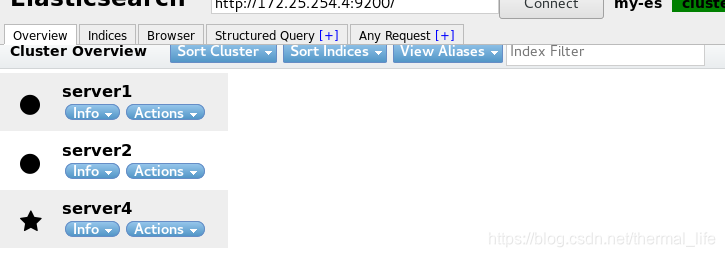

比如我们现在想把这几个结点的日志都汇集到server3上去

[root@server3 conf.d]# vim syslog.conf

input {

syslog{

port => 514 # 默认的端口可以不加

}

}

output {

stdout {}

elasticsearch {

hosts => "172.25.254.4:9200"

index => "syslog-%{+YYYY.MM.dd}"

}

}

[root@server3 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/syslog.conf

开启后就会开启514端口,udp,tcp都支持。

然后我们其他三个结点中的rsyslog中去配置:

[root@server4 _site]# vim /etc/rsyslog.conf

#*.* @@remote-host:514

#### end of the forwarding rule ###

*.* @@172.25.254.3:514 # 末尾加上这一行,*.*所有日志

[root@server4 _site]# systemctl restart rsyslog.service # 然后重启这个服务

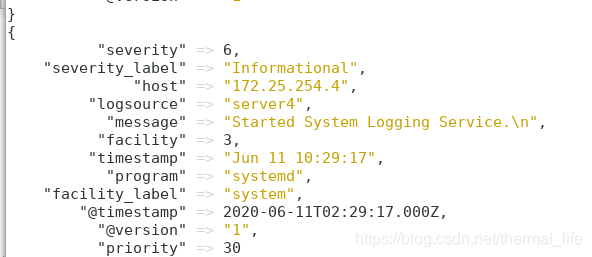

然后server3上就采集到server4上的信息了,其它两个结点同理

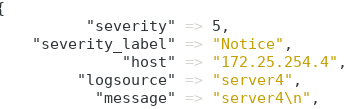

[root@server4 _site]# logger server4 # 生成日志

[root@server4 _site]# tail -1 /var/log/messages # 会记录到这里

Jun 11 10:30:47 server4 root: server4

注意看message 哪一行,就是我们输入的内容。

我们也可以利用官方的插件,不部署logstash就采集日志。

多行过滤插件

在标准输入中,我们只能敲一行按回车就提交了,那我们如果想输入多行,怎麼办那,就可以用这个多行过滤插件。

[root@server3 conf.d]# vim multline.conf

input {

stdin {

codec => multiline {

pattern => "^EOF" # 匹配到这个字符时结束,可以指定

negate => true

what => previous # 向上匹配,next向下匹配

}

}

}

output {

stdout {}

}

# 指定运行

[root@server3 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/multline.conf

wo

ai

ni

EOF # 不出现顶格的EOF,就可以一直回车进入下一行输入

/usr/share/logstash/vendor/bundle/jruby/2.5.0/gems/awesome_print-1.7.0/lib/awesome_print/formatters/base_formatter.rb:31: warning: constant ::Fixnum is deprecated

{

"host" => "server3",

"tags" => [

[0] "multiline"

],

"message" => "wo\nai\nni",

"@timestamp" => 2020-06-11T02:50:20.470Z,

"@version" => "1"

但这样没有太大的意义。

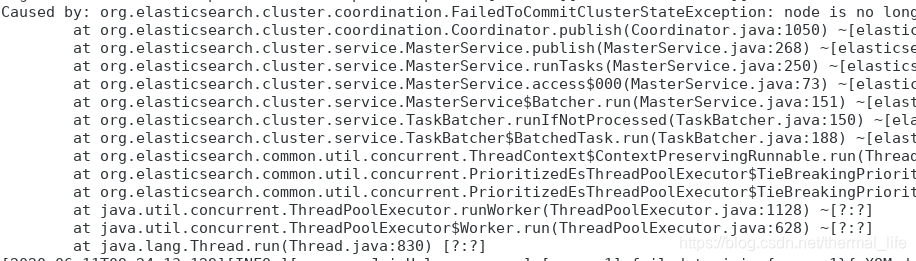

[root@server1 elasticsearch]# cd /var/log/elasticsearch/

[root@server1 elasticsearch]# ls

gc.log gc.log.03 gc.log.07 gc.log.11 gc.log.15 my-es-2020-06-09-1.json.gz

我们查看日志时发现被压缩了,

这是ES当日志超过一定大小就会自动压缩。

[root@server1 elasticsearch]# scp my-es-2020-06-09-1.log.gz server3: #复制一份给server3,用于传输。

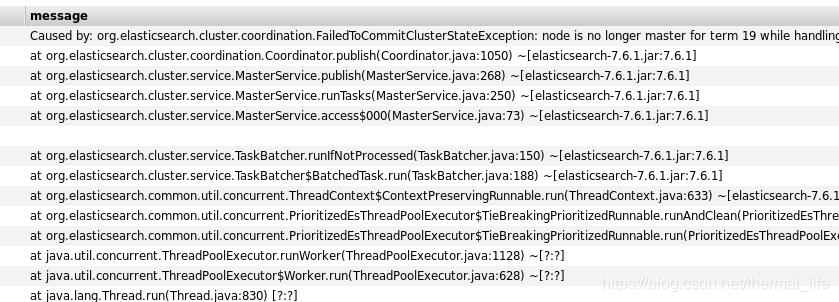

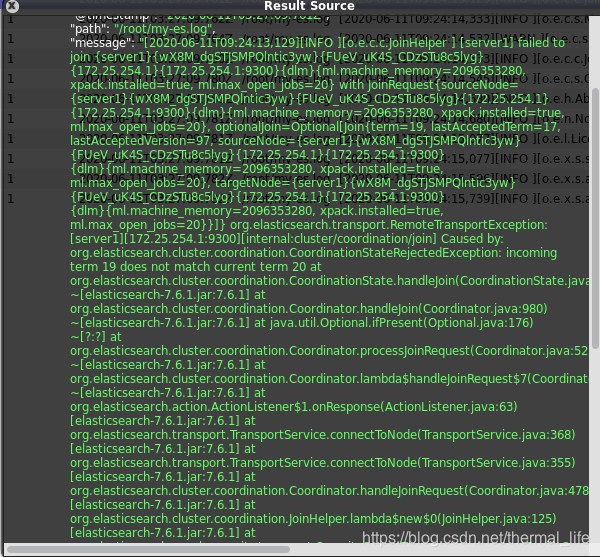

查看这些日志我们发现;

这些本该在一个消息里面的,在运行的时候传到ES,会拆分成一行一行的:

[root@server3 conf.d]# vim log.conf

input {

file {

path => "/root/my-es.log"

start_position => "beginning"

}

}

output {

stdout {}

elasticsearch {

hosts => "172.25.254.4:9200"

index => "log-%{+YYYY.MM.dd}"

}

}

[root@server3 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/log.conf

我们进行配置;

每个日志的开头都有时间戳,我们可以根据这个再结合多行过滤进行设置。

[root@server3 conf.d]# vim log.conf

input {

file {

path => "/root/my-es.log"

start_position => "beginning"

codec => multiline {

pattern => "^\[" # 时间戳的开头以顶格的[开始,\转义

negate => true

what => previous

}

}

下面不变,这就说明,每个时间戳到下一个时间戳的内容作为一个消息。

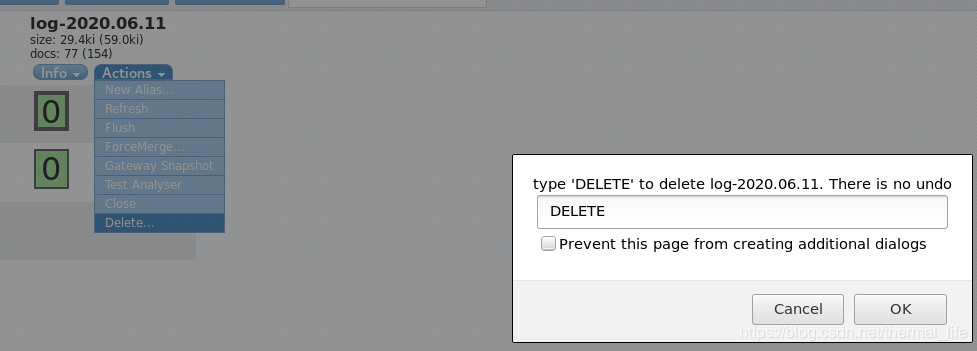

我们在web界面删除原先的索引。

在删除sincedb。

运行:

[root@server3 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/log.conf

。

。

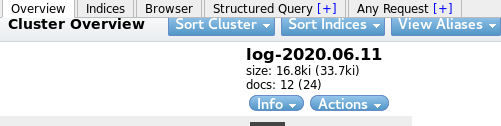

原来的几百条数据就只剩了12条了,

每条内容都有完整的消息了.

grok过滤插件

我们可以通过grok插件,对消息进行拆分,步入我们想要提取IP地址,就可以使用相应的语句。当然在企业中grok不一定时最好的,我们可以在数据output 到redis ,然后通过python语言进行处理,然后再放到ES中,也是一个很不错的选择。

[root@server3 file]# vim grok.conf

input {

stdin {}

}

filter {

grok {

match => { "message" => "%{IP:client} %{WORD:method} %{URIPATHPARAM:request} %{NUMBER:bytes} %{NUMBER:duration}" }

}

}

output {

stdout {}

}

[root@server3 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/grok.conf

55.3.244.1 GET /index.html 15824 0.043 # 输入

/usr/share/logstash/vendor/bundle/jruby/2.5.0/gems/awesome_print-1.7.0/lib/awesome_print/formatters/base_formatter.rb:31: warning: constant ::Fixnum is deprecated

{

"client" => "55.3.244.1",

"method" => "GET",

"@timestamp" => 2020-06-11T03:52:50.104Z,

"request" => "/index.html",

"host" => "server3",

"@version" => "1",

"message" => "55.3.244.1 GET /index.html 15824 0.043",

"duration" => "0.043",

"bytes" => "15824"

}

# 就切分开了

apache服务日志过滤实战:

我们可以去这里查看帮助:

[root@server3 patterns]# pwd

/usr/share/logstash/vendor/bundle/jruby/2.5.0/gems/logstash-patterns-core-4.1.2/patterns

[root@server3 patterns]# ls

aws bacula bind bro exim firewalls grok-patterns haproxy httpd java junos linux-syslog maven mcollective mcollective-patterns mongodb nagios postgresql rails redis ruby squid

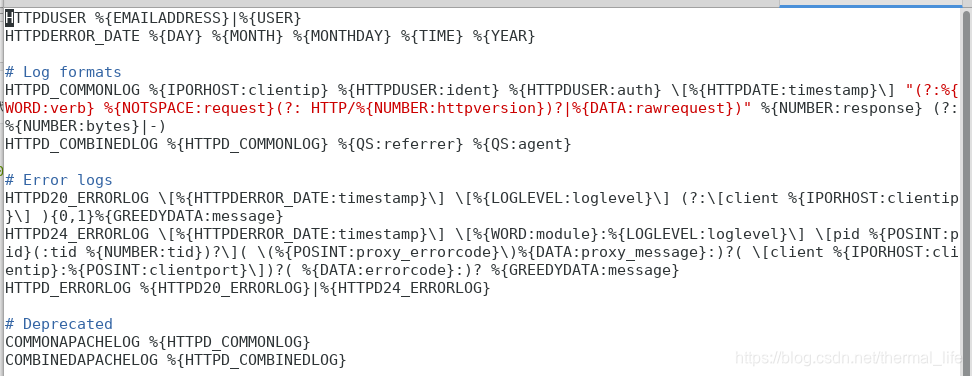

[root@server3 patterns]# vim httpd

这里面已经帮我们定义好了俩种格式:

HTTPD_COMMONLOG

HTTPD_COMBINEDLOG

我们直接在文件中引用就可以

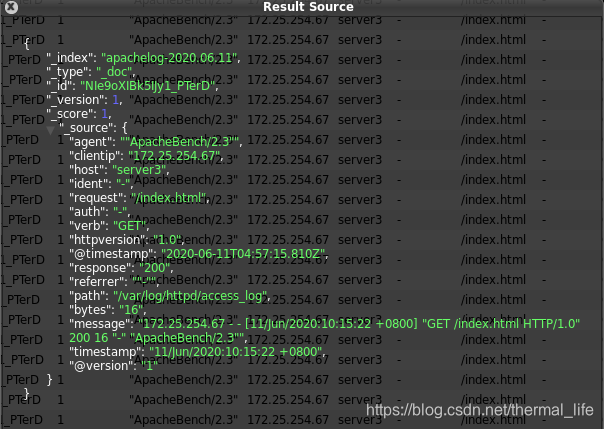

[root@server3 conf.d]# vim apache.conf

input {

file {

path => "/var/log/httpd/access_log"

start_position => "beginning"

}

}

filter{

grok {

match => { "message" => "%{HTTPD_COMBINEDLOG}" } #在这里引用

}

}

output {

elasticsearch {

hosts => "172.25.254.4:9200"

index => "apachelog-%{+YYYY.MM.dd}"

}

}

我们再次删除sincedb文件和head上面的日志,重新运行;

[root@server3 conf.d]# rm -fr /usr/share/logstash/data/plugins/inputs/file/.sincedb_9a85c763ba08cfe0808c1649ef0e65a9

[root@server3 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/apache.conf

传过来的数据就变成了这样子,就很方便我们日后对其中的数据进行采集分析。

2405

2405

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?