BERT等预训练模型的提出,简化了我们对NLP任务精心设计特定体系结构的需求,我们只需在BERT等预训练模型之后下接一些网络结构,即可出色地完成特定任务。

原因也非常简单,BERT等预训练模型通过大量语料的无监督学习,已经将 语料中的知识迁移进了预训练模型的Eembedding 中,为此我们只需在 针对特定任务增加结构来进行微调,即可适应当前任务,这也是迁移学习的魔力所在。

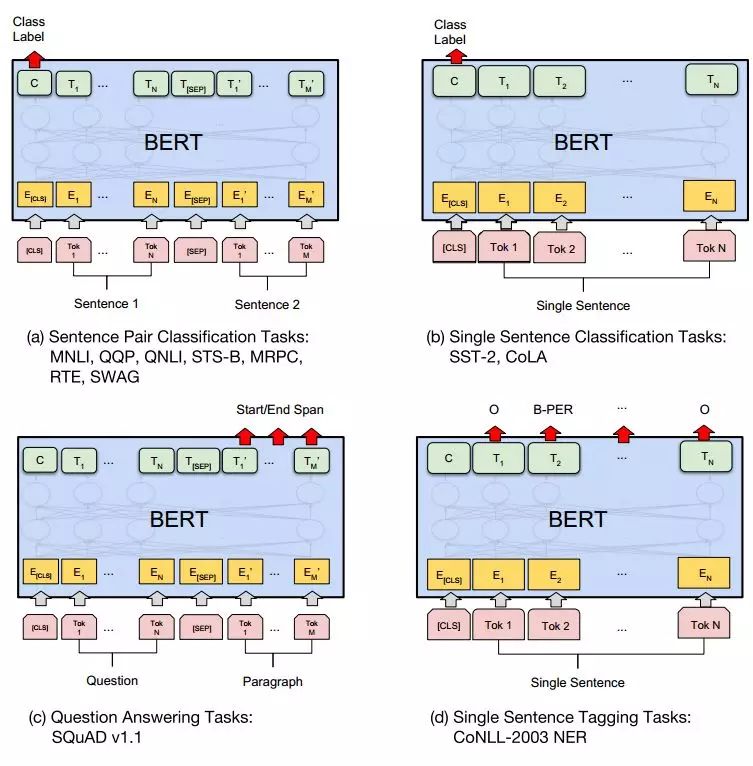

BERT在概念上很简单,在经验上也很强大。它推动了11项自然语言处理任务的最新技术成果,而这11项NLP任务可分类为四大自然语言处理下游任务。为此,笔者将以BERT预训练模型为例子,对自然语言处理的四大下游任务进行介绍。

下游任务比如 句子对分类、单句分类、问答任务、单句标注任务(NER)。

句

BERT预训练模型简化了NLP任务的处理,通过添加特定结构进行微调即可应用于句子对分类、单句分类、问答任务和单句标注任务(如NER)。句子对分类包括自然语言推理,单句分类涉及情感分析和语言可接受性判断,问答任务涵盖抽取式和生成式摘要,NER则用于识别序列中的命名实体。通过在BERT模型后添加分类层和CRF层,模型能更好地处理这些任务。

BERT预训练模型简化了NLP任务的处理,通过添加特定结构进行微调即可应用于句子对分类、单句分类、问答任务和单句标注任务(如NER)。句子对分类包括自然语言推理,单句分类涉及情感分析和语言可接受性判断,问答任务涵盖抽取式和生成式摘要,NER则用于识别序列中的命名实体。通过在BERT模型后添加分类层和CRF层,模型能更好地处理这些任务。

订阅专栏 解锁全文

订阅专栏 解锁全文

8470

8470

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?