多模态情感分析是自然语言处理领域的一个重要研究方向,它通过分析和融合文本、语音、图像等多种模态的数据来识别和分析情感信息。这种分析方法能够更全面地理解人类情感,因为不同模态信息可以捕捉到不同层面的情感信息。随着深度学习技术的发展,多模态情感分析在情感预测和情绪识别方面显示出巨大的潜力和应用价值。

一、背景

多模态情感分析的背景意义在于,人类的情感状态对于认知过程具有调节作用,能够影响学习效果,对于学生情感的分析具有重要意义。对于情感分析来说, 情感表达可以来源于文字、音频、图像, 结合两种及以上模态建模情感分析, 就是多模态情感分析方法。 由于不同模态的信息在数据形式和处理方式上有很大差别, 在统一模型中多增加一种模态信息虽然可能带来潜在的建模效果提升, 但同时也增加了建模的复杂度和难度。 例如, 通过一句话的文字和对应的录音建模时, 需要先将字符串和音频分别用两种截然不同的处理方式量化为模型可接受的表征。

多模态模型策略在情感分析任务中是十分必要的。首先, 很多时候仅通过文本或者语音很难判准确判断出情感状态, 一个极端例子是反讽。 反讽往往结合中性或者积极的文本内容和与内容不匹配的音频表达来完成一个消极(负向)的情感表达。 这种情形仅靠单模态很难从根本上解决。其次,单模态模型容易受噪声影响而导致效果问题, 例如由ASR转写的文本, 上游ASR出现的错误很多时候会对下游分类任务产生较大影响。因此,在实际应用中有一个稳定强大的模型就要求我们采用多模态的建模方法。

二、技术原理

多模态模型的核心任务是最大化发挥模态融合的优势完成建模。 例如通过构建语音+文本的双模态模型, 我们希望这样一个双模态模型效果至少不比同量级的单模态模型差, 达到1 + 1 > 1的效果。

1、多模态融合的架构

提前融合(early fusion)

Early fusion方法是将不同模态的输入在模型浅层完成融合, 相当于将不同单模态的特征统一到同一个模型输入参数空间。 融合后的特征再输入到单个模型当中完成特征提取和预测。 提前融合的出发点是想要模型在对特征建模初期就同时考虑多个模态的输入信息, 这一点是合理的。 但是由于不同模态本身参数空间的差异性,在输入层统一多个不同参数空间的方法并不能达到预期效果, 在实际中往往很少被使用。

推迟融合(late fusion)

Late fusion方法尝试通过模型来解决参数空间不同统一的问题, 首先对不同模态的输入数据分别用不同的网络结构进行建模和特征提取, 最终在分类层前将不同模态提取到的特征进行融合, 并依赖梯度反向传播统一化不同模态的特征到同一特征空间, 最后在这个新的空间上做简单的分类预测。推迟融合由于其简单的实现方式和不错的效果往往应用较普遍。 多阶段融合(multi-stage fusion)

推迟融合虽然通过网络本身在分类层前将不同模态特征映射到统一参数空间 ,但是仅仅在高级特征层面对不同的模态特征进行了融合, 却去了在特征提取阶段不同特征之间的相互关联信息。 Multi-stage fusion为了解决以上问题, 在多个阶段对特征进行融合操作。 通常先通过简单的的网络结构将不同模态参数空间统一化, 在这个统一化的参数空间上完成初级模态信息融合。 融合后的特征再继续经过后续深度特征提取网络进行进一步模态相关的深层特征提取并融合, 不同模型结构分支提取到的特征在分类层之前做最终的融合后进行分类预测。 多阶段融合依靠网络和梯度传播来完成特征空间的统一和特征深层相互作用的功能,既保留了用不同模型结构处理不同模态分支的能力, 又自然地完成了不同模态信息融合的目的, 对提取到强大特征更有优势。 缺点是模型结构相对复杂, 往往会设置多个损失函数,分阶段调优复杂。

2. 多模态特征融合方法

提取到不同模态特征后,如何合并它们也是一个需要在建模时解决的问题。 常用的特征融合方法大致有一 基于拼接的特征融合 简单的融合可以通过特征拼接来实现, 其假设为输入的不同模态特征已经被统一在了同一参数空间上。 此假设由梯度反向传播来实现。简单的特征融合并没有考虑特征之间的相互作用增益, 依赖下游分类网络来融合模态信息。 基于注意力的特征融合

由于输出层网络参数有限, 简单模态特征拼接可能不足以达到很好的融合效果。 于是通过引入注意力机制, 在模型融合时显式地增加模型相互作用,将经过注意力的打分后融合的特征输入到分类网络中, 以达到充分利用模态间信息增益的目的。 注意力机制又有多种实现方法, 比如带有指向性的注意力(如音频-->文本), 交叉注意力(音频-->文本 + 文本-->音频), 自注意力([音频+文本] --> [音频+文本])等等, 在此不再赘述其细节。

更多理论推荐看这个博主:路无鱼:多模态情感分析简介

三、应用和挑战

多模态情感分析的应用包括产品评论、意见调查、YouTube上的电影评论分析、新闻视频分析和医疗保健应用等。挑战方面,需要建立多语言的稳健多模态数据集,这些数据集应被良好注释和细粒度分级。同时,需要关注共指消解问题,隐藏情感、讽刺和挖苦检测仍然是使用多模态的开放研究问题。此外,数据集的准备和分析应符合伦理,并且广泛可用,以便更好地服务于公共领域。

未来发展:

多模态情感分析的未来发展可以探索更多教育场景中的应用、探索多模态数据的最佳组合方式、优化情感分析模型和系统以及纳入更多情感状态。未来的研究还应该解决多模态数据集的构建问题,解决领域转移问题,构建具有优秀泛化性能的统一、大规模多模态情感分析模型,减少模型参数,优化算法,降低算法复杂度

接下来让我们一起看一下多模态情感分析的数据集:

12-02:添加

数据集:imdb_dataset_offical|情感分析数据集

- 创建时间:2024-11-30

- 数据集介绍:该数据集用于文本分类任务,包含三个数据集:训练集、测试集和无监督学习集。每个数据集包含文本和标签,文本为字符串类型,标签为类别标签,包含两个类别:'neg'(负面)和'pos'(正面)。训练集和测试集各有25000个样本,无监督学习集有50000个样本。数据集的总下载大小为76731910字节,总数据集大小为131198287字节。

- 链接地址:imdb_dataset_offical

11-24 :添加

数据集:CLARIN-Emo|情感分析数据集|消费者评论数据集

- 创建时间:2024-11-23

- 数据集介绍:该数据集由波兰语的消费者评论组成,涵盖酒店、医药、产品和大学四个领域。数据集不仅包含评论,还包括属于同一领域的非观点性信息文本(主要是中性的)。每个句子和整个评论都被标注了普鲁特奇克的情感轮中的情感(如喜悦、信任、期待、惊讶、恐惧、悲伤、厌恶、愤怒)以及感知到的情感(正面、负面、中性),其中矛盾的情感使用正面和负面标签同时标注。数据集由六个人独立标注,最终标签由至少两人标注的结果决定,这意味着存在争议的文本和句子可能被标注为对立的情感。每个句子都有自己的标注,但这些标注是在整个评论的背景下创建的。数据集分为训练集、验证集和测试集,每个集合包含完整的评论,没有评论被分割在不同的集合中。

- 数据集地址:CLARIN-Emo

数据集:PanoSent|情感分析数据集|多模态对话数据集

-

创建时间:2024-08-18

-

数据集介绍:PanoSent数据集由新加坡国立大学等机构创建,是一个用于多模态对话情感分析的大型高质量数据集。该数据集包含超过10,000条对话,涵盖100多个常见领域和场景,支持多语言(英语、中文、西班牙语)和多模态(文本、图像、音频、视频)。数据集的创建过程结合了人工标注和自动合成,确保了数据的高质量和多样性。PanoSent数据集主要应用于情感分析领域,旨在解决多模态对话中情感元素的全面提取和动态变化分析问题。

数据集:IVLLab/MultiDialog|多模态对话数据集|情感分析数据集

-

创建时间:2024-07-11

-

数据集介绍:该数据集包含手动注释的元数据,将音频文件与转录、情感和其他属性关联起来。数据集支持多模态对话生成、自动语音识别和文本到语音转换等任务。此外,还提供了一个金情感对话子集,用于研究对话中的情感动态。所有音频和转录数据均为英语。

数据集:cairocode/MSPI_008|情感分析数据集|多模态数据数据集

-

创建时间:2024-07-05

-

数据集介绍:该数据集包含图像、说话者名称、说话者ID、标签、数据集来源、情感维度(如愉悦度、唤醒度等)以及文件路径等特征。数据集分为训练、验证和测试三个部分,每个部分都有详细的数据大小和样本数量。

数据集:SMILE Dataset|情感分析数据集|多模态学习数据集

-

创建时间:2024-03-31

-

数据集介绍:我们人类沉浸在笑声中。笑声是一种独特的非语言社交信号,与纽带、协议、感情和情绪调节有关。它经常被有目的地引出来建立亲密关系,吸引注意力,或建立信仰。作为一种强大的媒介来表达超越单纯文字能力的广泛社会和情感含义。因此,理解笑声是人工智能中具有巨大潜力的关键问题。然而,理解和建模笑声反应是具有挑战性的。即使是一个简单的笑话也与语言技能、上下文知识、心智理论、抽象思维和社会感知有关,这些的复杂纠缠使笑反应可以说是人类可能具有的最复杂的认知属性。

数据集:array/socratis_image_text_emotion|情感分析数据集|多模态

-

创建时间:2023-12-01

-

数据集介绍:SOCRATIS数据集包含18,000多种情感反应和原因,基于2,000个图像-标题对。数据集展示了人类更偏好人类编写的情感反应而非机器生成,且现有评估指标与人类偏好不相关。数据格式包括唯一ID、图像路径、标题、情感、解释和匿名化人口统计信息。图像文件可通过链接获取。

-

链接地址:array/socratis_image_text_emotion|情感分析数据集|多模态数据数据集

数据集:CREMA-D Video|情感分析数据集|多模态数据数据集

-

创建时间:2023-07-03

-

数据集介绍:CREMA-D 是一个包含来自 91 位演员的 7,442 个原始剪辑的数据集。这些剪辑来自 48 名男性演员和 43 名女性演员,年龄在 20 至 74 岁之间,来自不同种族和民族(非裔美国人、亚洲人、高加索人、西班牙裔和未指定人)。演员们从精选的 12 句话中发言。这些句子使用六种不同的情绪(愤怒、厌恶、恐惧、快乐、中立和悲伤)中的一种和四种不同的情绪级别(低、中、高和未指定)来呈现。

数据集:MGEED database|情感分析数据集|多模态数据数据集

-

创建时间:2023-06-20

-

数据集介绍:多模态真实情绪和表情检测数据库

数据集:阿拉伯多模态情感分析数据集

-

创建时间:2023-06-10

-

数据集介绍:阿拉伯多模态情感分析数据集是由阿马尔·特利吉大学拉格瓦特计算机与数学实验室创建,旨在解决阿拉伯语情感分析领域数据集稀缺的问题。该数据集包含540个视频片段,总计2485个独特词汇,涵盖文本、音频和视频三种模态。数据集的创建过程涉及从YouTube和其他社交媒体平台收集视频,进行手动筛选和标注,使用先进的技术如AraBERT进行文本处理,以及利用OpenFace和OpenSmile工具提取视觉和音频特征。该数据集主要应用于阿拉伯语情感分析,通过多模态学习提高情感识别的准确性和效率。

数据集:CH-SIMS|情感分析数据集|多模态学习数据集

-

创建时间:2022-05-30

-

数据介绍:CH-SIMS 是一个中国单模态和多模态情感分析数据集,其中包含 2,281 个具有多模态和独立单模态注释的野外精炼视频片段。它允许研究人员研究模态之间的相互作用或使用独立的单模态注释进行单模态情感分析。

数据集:UR-FUNNY|情感分析数据集|多模态交互数据集

-

创建时间:2022-05-23

-

数据集介绍:用于理解用于表达幽默的多模态语言。

数据集:ETRI KEMDy19|情感分析数据集|多模态数据集

-

创建时间:2022-05-06

-

数据集介绍:ETRI KEMDy19数据集用于多模态情感分析任务,支持音频和文本模态的训练和测试。

数据集:MSCTD|多模态翻译数据集|情感分析数据集

-

创建时间:2022-02-28

-

数据集介绍:多模态情感聊天翻译数据集(MSCTD)由北京交通大学和腾讯微信AI模式识别中心共同创建,包含17,841个多模态双语对话,总计173,240个<英语语句, 中文/德语语句, 图像, 情感>四元组。数据集通过自动和人工标注两个步骤构建,确保了数据的质量和多样性。每个语句对都与反映当前对话场景的视觉上下文相对应,并标注有情感标签。MSCTD不仅用于多模态聊天翻译研究,还为多模态对话情感分析提供了新的基准,旨在通过整合对话历史和视觉上下文,生成更准确的翻译,并解决多模态机器翻译在对话中的挑战。

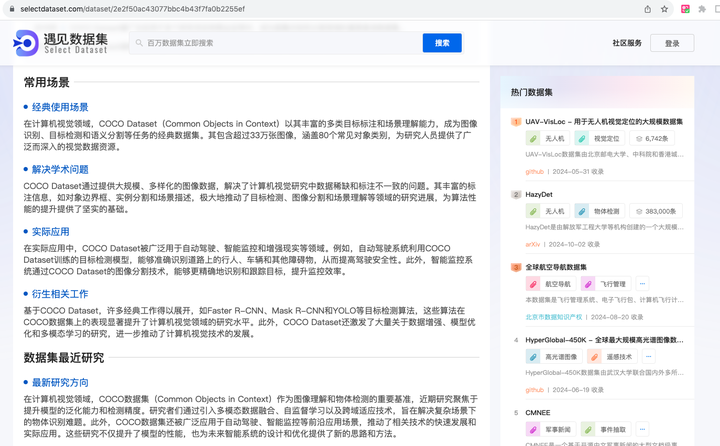

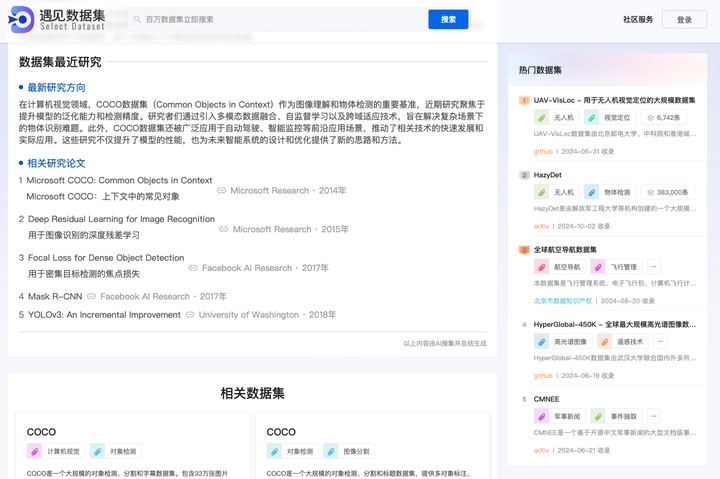

免费数据集网站:遇见数据集

遇见数据集是一个平台,致力于让每个数据集都被发现,让每一次遇见都有价值,

1、数据获取的便利性:遇见数据集通过集中整合全球数据资源,提供了一个一站式平台,使得用户能够轻松搜索和访问各种数据集,无需在多个来源之间进行切换,从而提高了数据获取的效率。

2、数据的可发现性:通过详细的数据标签和分类系统,遇见数据集增强了数据集的可发现性,帮助用户快速找到特定领域的数据集,尤其是对于特定研究领域或应用场景的数据,极大地方便了数据的检索和使用。

3、数据更新的及时性:遇见数据集频繁更新数据集内容,确保用户能够获取最新的数据资源,这对于需要最新数据进行分析和研究的用户来说尤为重要,保证了数据的时效性和相关性。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?