一、DeepSeek 概述

DeepSeek 是一个基于人工智能的智能问答和知识检索系统,专注于提供高效、精准的自然语言处理(NLP)解决方案。它结合了深度学习、知识图谱和向量检索技术,能够处理复杂的语言任务,如问答、对话生成、信息检索等。

想要在本地体验强大的 DeepSeek 大模型?零刻 SER9 Pro 是你的理想选择!通过 LM Studio 和 Ollama 的本地部署,你可以轻松运行 DeepSeek,享受更快速、更安全、更私密的 AI 体验。

为什么选择零刻 SER9 Pro?

- 强劲性能: 搭载高性能处理器和显卡,轻松应对 DeepSeek 大模型的运算需求。

- 超大内存: 支持扩展至 64GB 内存,为模型运行提供充足空间。

- 高速存储: 配备 PCIe 4.0 SSD,实现快速数据读写,提升模型加载和运行速度。

- 安静散热: 采用高效散热系统,即使长时间运行也能保持安静凉爽。

核心功能

-

智能问答

-

支持基于自然语言的问题回答。

-

能够理解上下文,提供连贯的对话体验。

-

-

知识检索

-

支持从本地知识库或互联网中检索信息。

-

通过向量数据库(如FAISS)实现高效检索。

-

-

联网搜索

- 集成搜索引擎API,实时获取互联网信息。

-

多任务并发

- 支持高并发请求处理,适用于大规模应用场景。

-

本地化部署

- 支持本地部署,保护数据隐私。

应用场景

-

企业知识库:用于企业内部文档检索和问答。

-

智能客服:提供自动化的客户支持服务。

-

教育辅助:帮助学生和教师快速获取知识。

-

科研支持:加速文献检索和数据分析。

技术特点

-

深度学习模型

-

基于Transformer架构,支持大规模预训练模型(如GPT、BERT等)。

-

支持模型微调和定制化训练。

-

-

向量检索

- 使用FAISS、Annoy等向量数据库,实现高效相似度检索。

-

多语言支持

- 支持多种语言的问答和检索。

-

高性能计算

- 支持GPU加速,优化计算性能。

-

可扩展性

- 支持插件化扩展,轻松集成第三方工具和服务。

二、安装与配置

1. 安装 DeepSeek

DeepSeek 可以通过 LM Studio 和Ollama 来部署和运行 DeepSeek 模型

LM Studio部署安装教程:

1.访问 LM Studio官网,https://lmstudio.ai/,根据自己的操作系统下载合适的版本,这里以Windows系统为例,点击Download LM

Download LM Studio for Windows进行下载

2.软件下载完成后,双击打开进行安装,点击下一步

3.选择要安装的位置,然后点击安装

4.安装完成后,点击完成,运行LM Studio

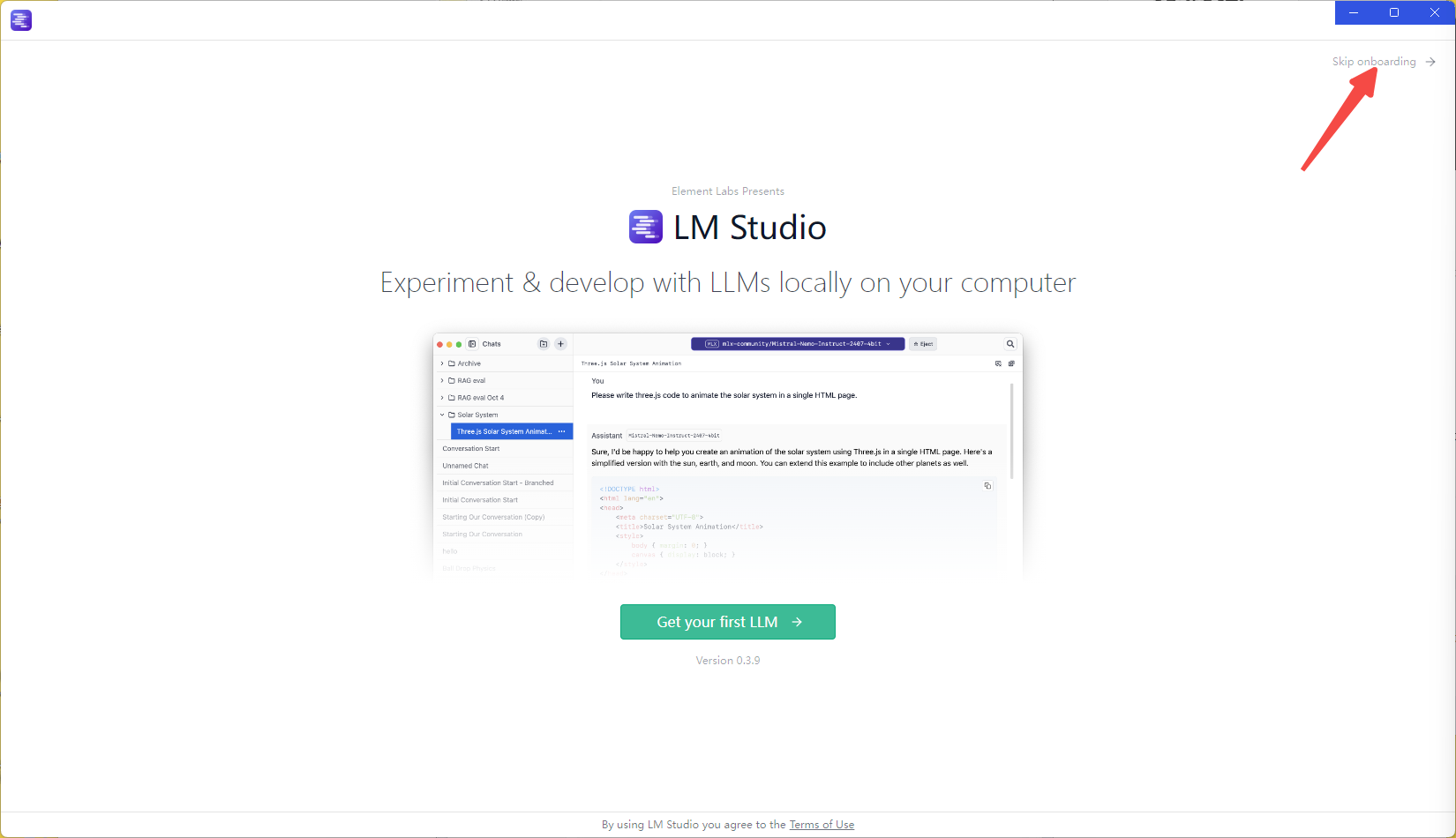

5.打开软件后,点击右上角 Skip omboarding 进入软件

6.点击右下角设置按钮,切换中文语言

7.点击搜索,选择合适的deepseek版本下载,作为示例,这里我选择Qwen 7B的小模型

点击“Download”进行下载

8.下载完成后,点击顶部加载模型,然后点击加载

9.选择你下载的模型,根据电脑配置调整GPU和GCPU的参数

!

10.加载完成后就可以进行对话了

注意事项:

如果Lm Studio无法下载大模型,可在魔塔社区进行下载,链接地址:https://www.modelscope.cn/models

下载完成后,创建Models文件夹,以大模型文件名创建文件夹存放。

Ollama部署安装教程:

1.访问Ollama官网:https://ollama.com/,点击Download下载按钮,跳转到下载页面

2.根据自己的操作系统下载合适的版本,这里以Windows系统为例,点击Download for Windows进行下载

3.下载完成后,双击打开下载的文件,点击Install进行安装

4.安装完成后,按Win+R打开运行窗口,输入CMD打开命令提示符工具

5.输入命令:ollama -v 即可查看安装版本,出现版本号说明安装成功

6.接下来安装大模型,输入命令:ollama run deepseek-r1:8b,进行下载deepseek模型

Ollama模型查询网站:https://ollama.com/search

deepseek-r1目前主要有:1.5b、7b、8b、14b、32b、70b、671b、这几种不同的开源模型,

B→billion→十亿 数字后面b是英文billion,整体代表的诗模型的参数量,1.5B就是15亿参数,7b就是70亿参数

参数越多模型越强,你得到的回答质量也就越高,但是参数越大,所需要消耗的资源也就越高,现存在4G或者是8G左右的可以选择7b或者是8b的模型版本

7.下载完成后,就可以直接进行对话使用了,关闭窗口后,按Win+R打开运行窗口,输入CMD打开命令提示符工具,输入名命令:ollama run deepseek-r1:8b即可再次对话

三、设置自定义模型下载路径

默认情况下,ollama模型存目录路径如下:

-

macOS:

~/.ollama/models -

linux:

/user/share/ollama/.ollam/models -

Windows:

C:\Users\<username>\.ollama\models

Windows更改Ollama模型存放位置

在Windows系统下,若要修改模型的存放的位置,可以根据以下步骤操作;

1.打开系统设置界面,进入系统-系统信息,打开高级系统设置

2.在系统属性窗口内点击环境变量

3.在环境变量窗口中,点击"新建"创建一个新的系统变量或用户变量

-

变量名:

OLLAM_MODELS -

变量值:模型存放的路径,例如:

D:\Ollam\Models点击“确定”进行保存

4.重启已经打开的Ollama的相关应用,使新路径生效,如果不生效也可以重启系统

1052

1052

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?