论文题目:Identity Mappings in Deep Residual Networks

--Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun

Abstract

文章分析了 ResNet 中 Identity mapping 为什么比较好,为何能让梯度在网络中顺畅的传递而不会爆炸或消失,实验方面 1001层的 ResNet 在CIFAR10上4.62%的错误率,在CIFAR100和ImageNet上也做了实验。

Introduction

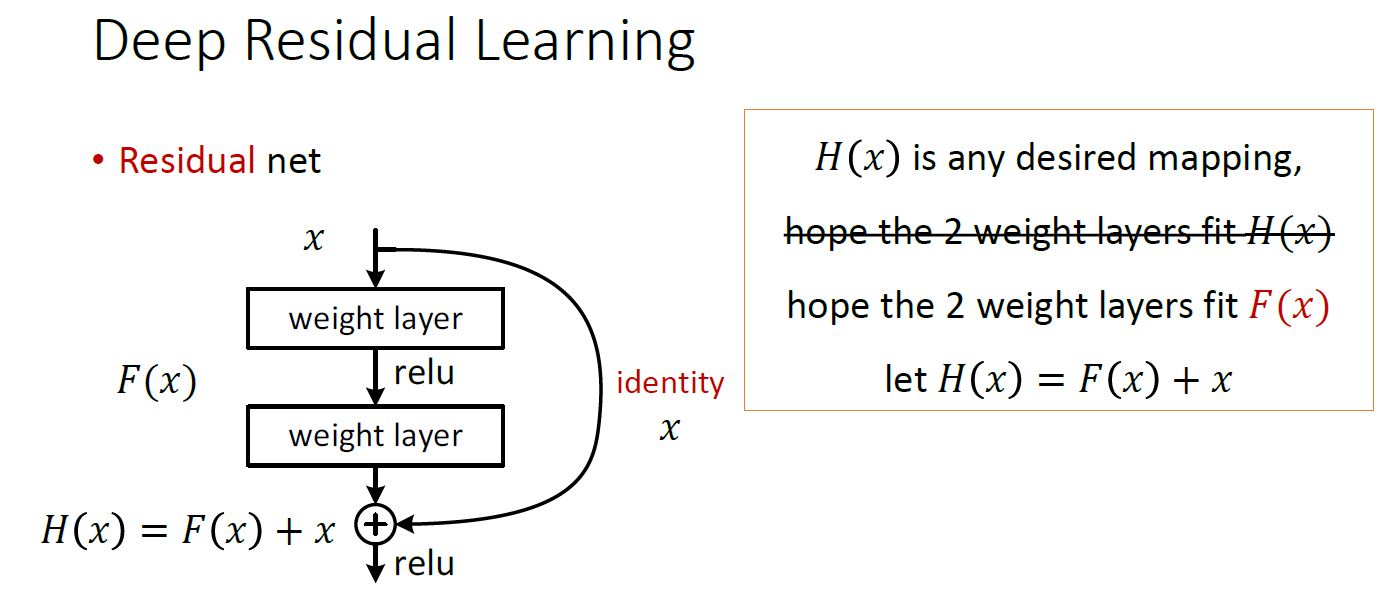

先回顾下ResNet中的 Residual Units:

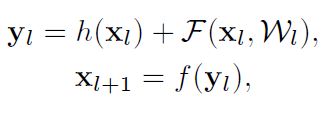

Residual Units可以如下表示:上图中的H与下面的h不是一个东西,别管上图了,从两篇文章截的图,有点不一样。

上面公式中:h 表示 shortcut 使用什么形式的变换(Resdual Net论文[1]中给出了A,B,C3种,最后用的 Identity map,也就是 h(x)= x,这篇文章进一步分析了 Identity map 为什么好)

F 是 residual function。F= y-h(x)

f 为Residual Units输出处使用的函数,[1] 中用的ReLU,即上图中最下面那个relu。

本文提出 f 也该用 Identi

本文深入探讨了深度残差网络(Residual Networks)中身份映射(Identity Mapping)的重要性,揭示了它如何确保梯度在前向和反向传播中畅通无阻,从而简化训练过程。实验表明,身份映射是最佳选择,能实现最快误差减少和最低训练损失。分析还比较了不同类型的skip connections,证明了非身份映射可能导致优化难题。

本文深入探讨了深度残差网络(Residual Networks)中身份映射(Identity Mapping)的重要性,揭示了它如何确保梯度在前向和反向传播中畅通无阻,从而简化训练过程。实验表明,身份映射是最佳选择,能实现最快误差减少和最低训练损失。分析还比较了不同类型的skip connections,证明了非身份映射可能导致优化难题。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1859

1859

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?