【2024最全最细Langchain教程-1 】调用openai实现人工智能时代的hello_world-CSDN博客

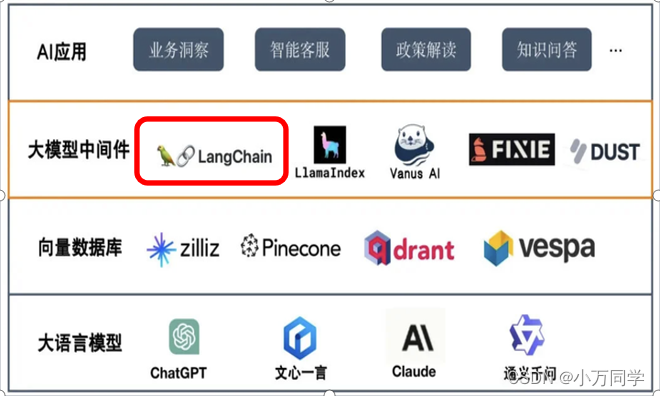

中我们介绍了如何使用openai内置的方法进行调用,但是在实际业务中,我们不太可能直接去直接调用openai的接口,我们需要使用更简单和便利的工具来操纵大模型、向量数据库、本地文件等等,这个就是Langchain的重要意义,它基本就类似于JAVA后端开发时代的Spring、Structs等开发工具,会大大提高我们开发基于大模型的应用的效率:

1. 进入虚拟环境,启动jupyter

安装langchain相关包(-q的意思是quiet,安装时不显示细节信息)

pip install -q langchain2. 使用LLM模型包装器进行调用

这里从langchain.llms中引入OpenAI,这里引入的是LLM模型

设置秘钥

import langchain

import os

from langchain.llms import OpenAI

api_key = os.getenv("OPENAI_API_KEY")创建OpenAI的实例,temperature的值越高,openai的回答越发散、越有创造力(当然也有可能越不准确),调用OpenAI的 invoke()方法,输入问题,得到回答:

llm = OpenAI(

openai_api_key = api_key,

temperature=0.5,

base_url="https://wdapi7.61798.cn/v1"

)

response = llm.invoke('谁是中国改革开放的总设计师?')

print(response,type(response))

这里是结果显示,注意这里response的类型是string,使用LLM模型包装器调用返回的结果是字符串类型:

3. 使用聊天模型包装器进行调用

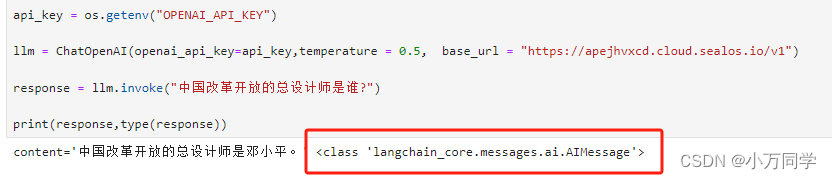

从langchain_openai中引入的ChatOpenAI是聊天模型包装器,用法和上文提到的OpenAI基本一致,只是返回的消息是AIMessage类型:

import langchain

import os

from langchain_openai import ChatOpenAI

api_key = os.getenv("OPENAI_API_KEY")

llm = ChatOpenAI(

openai_api_key=api_key,

temperature = 0.5,

base_url = "https://apejhvxcd.cloud.sealos.io/v1"

)

response = llm.invoke("中国改革开放的总设计师是谁?")

print(response,type(response))注意类型是不一样的:

一般来说,两种模型包装器都是可以使用的,但是后面等我们开始构建比较复杂的应用的时候,我们还是推荐使用聊天模型包装器。

4. GITHUB和视频教学地址

B站视频地址:【2024最全最细】langchain之模型包装器_哔哩哔哩_bilibili

github地址:https://github.com/jerry1900/jupyter

如需openai国内节点账号请与我联系:15652965525(微信)

2019

2019

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?