《Andrew Ng 机器学习笔记》这一系列文章文章是我再观看Andrew Ng的Stanford公开课之后自己整理的一些笔记,除了整理出课件中的主要知识点,另外还有一些自己对课件内容的理解。同时也参考了很多优秀博文,希望大家共同讨论,共同进步。

网易公开课地址:http://open.163.com/special/opencourse/machinelearning.html

逻辑回归

在之前的学习中,我们一直使用的是线性回归,因为我们将目标函数看作是连续变化的。即便当问题不能用线性模型解决,我们也可以使用局部加权回归的方法。

对于目标值是离散变量的分类问题来说,线性模型就不是很适用,虽然也有一些分类可以通过线性模型解决,但并不是最好的方法。对于目标值是离散变量的分类问题,我们假设目标值为{0,1},构造一个新的预测函数,这种方法就叫逻辑回归。

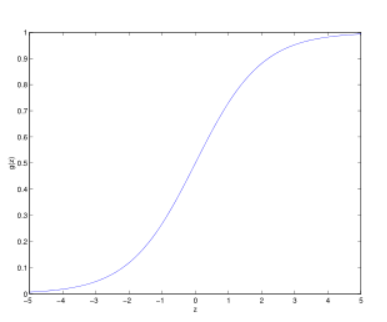

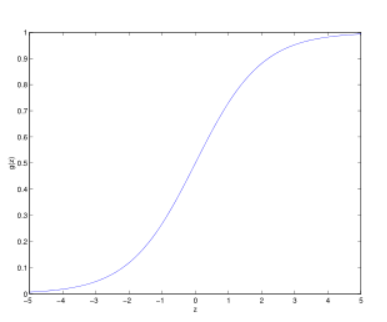

改变模型使其预测值在[0,1]之间,我们选择这样一个函数(其中函数g被称为logistic函数或sigmoid函数。):

g(z)的函数图如下:

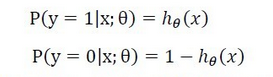

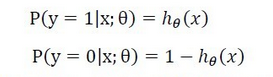

有了这个函数,对于一个样例,我们就可以得到它分类的概率值:

将两式组合起来,可以简化得到:

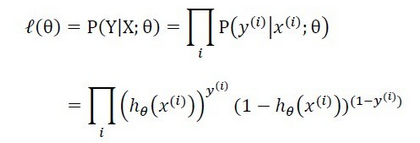

这样,我们得到了函数h在整个数据集上的似然函数为:

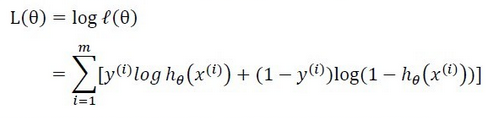

同样的,为了计算方便,对似然函数取对数:

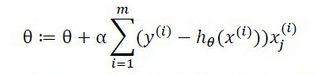

因为要求最大似然函数,可应用梯度上升算法,更新参数值:

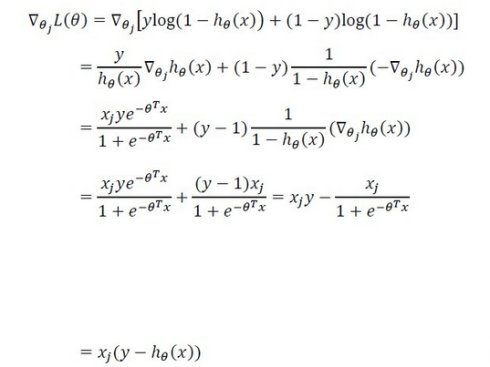

当有一个样本(m==1)时,对L(θ)求导可得:

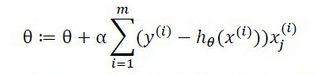

当有多个样例时,θ更新为:

上式与最小二乘的形式一样,实际上,这并不是巧合,这几乎是一种通用的规则。

你可以选择不同的假设,但如果使用梯度下降(上升)算法的话,得到的更新规则都是这种形式。

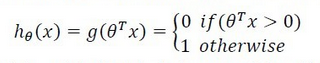

感知器算法

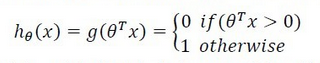

感知器算法强迫函数输出为{0,1}离散值而不是概率。其预测函数为:

参数θ的更新规则为:

参数θ的更新规则为:

这样,就得到了感知器算法。

227

227

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?