paper: 《GLM: General Language Model Pretraining with Autoregressive Blank Infilling》

摘要:

我们提出了一个基于自回归空白填充的通用语言模型(GLM)来解决这一挑战。GLM通过添加2D位置编码和允许任意顺序预测跨度来改进空白填充预训练,这导致在NLU任务上的性能优于BERT和T5。同时,GLM可以通过改变空白格的数量和长度来对不同类型的任务进行预训练。在NLU、条件和无条件生成的广泛任务中,GLM优于BERT、T5和GPT,并在1.25×参数的预训练模型中获得最佳性能,证明了其对不同下游任务的通用性。

模型架构:

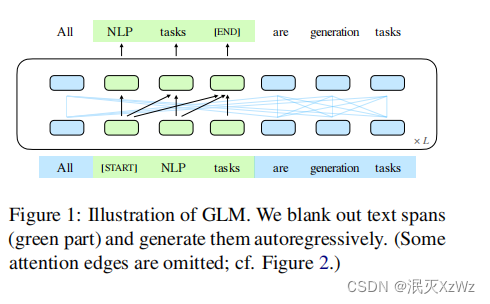

1. 设计独特的mask atten 来实现NLU和NLG(类似unilm的思想)

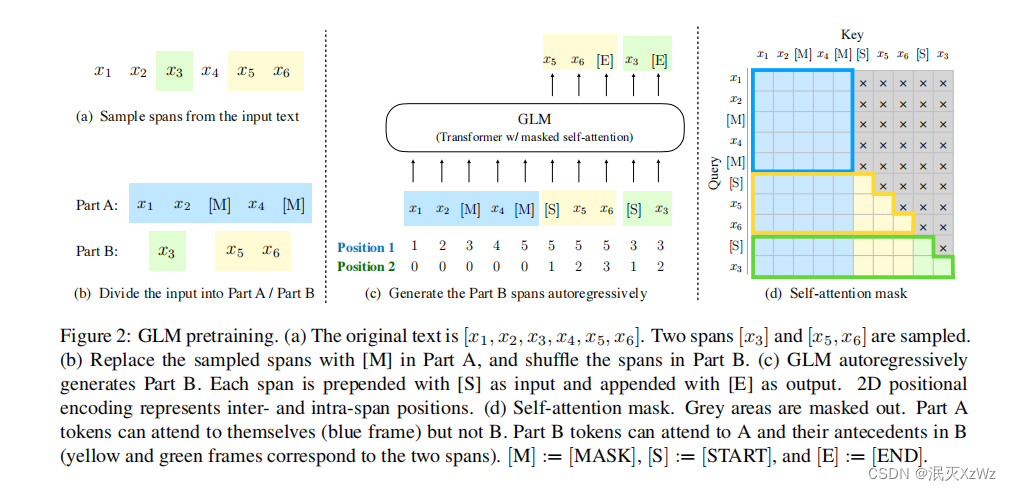

2. 2D编码,分别标注span在整个句子的位置,和span内部每个token的相对位置

数据构造:从文随机抽取出span,用【mask】替代,然后把span随机排列,拼接到输入序列的后面,每个span input 开始位置插入【start】,span的输出结束位置插入【end】

训练目标:

自回归方式的span预测(片段预测)

short mask: 有利于NLU

Document-level mask、 Sentence-level mask: 为了使NLG效果更好

819

819

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?