GPT3

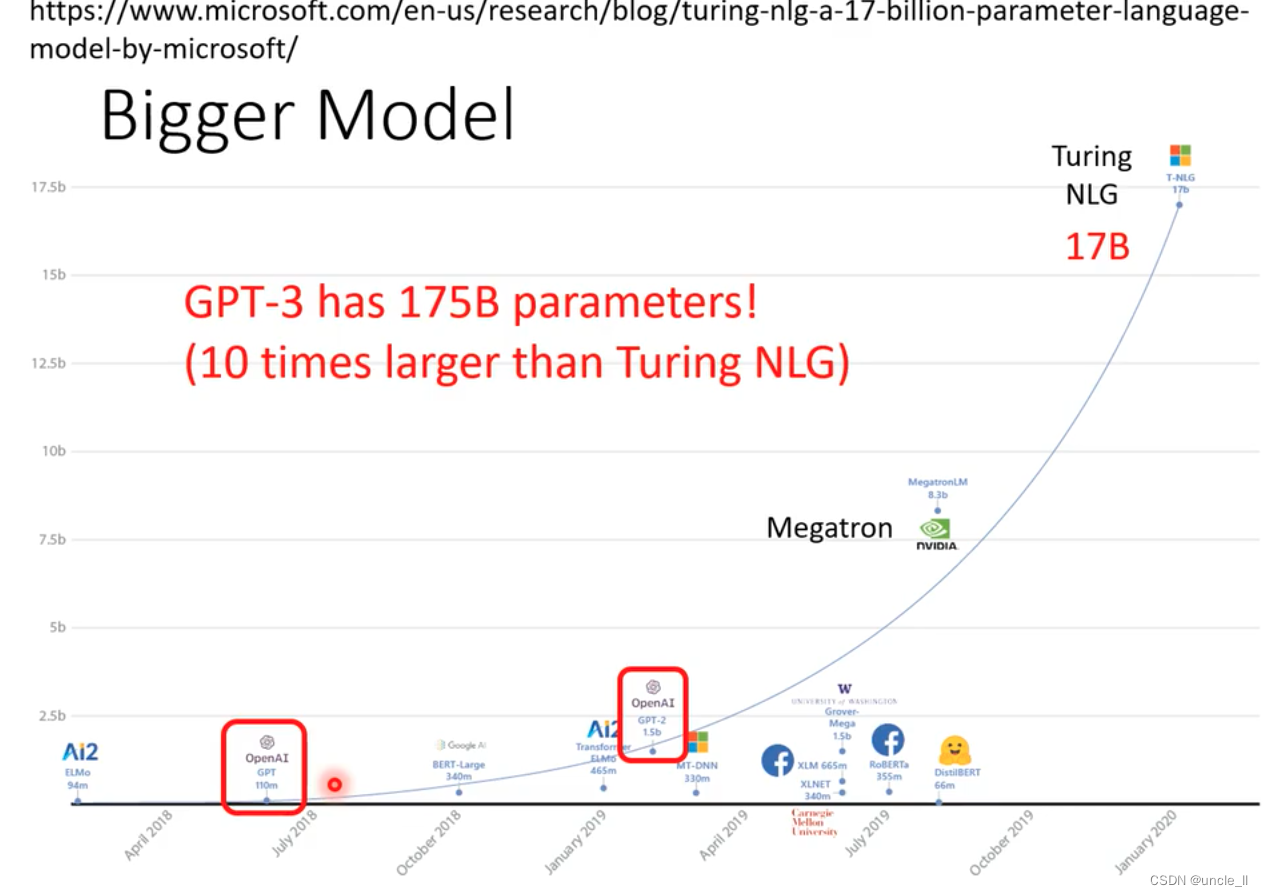

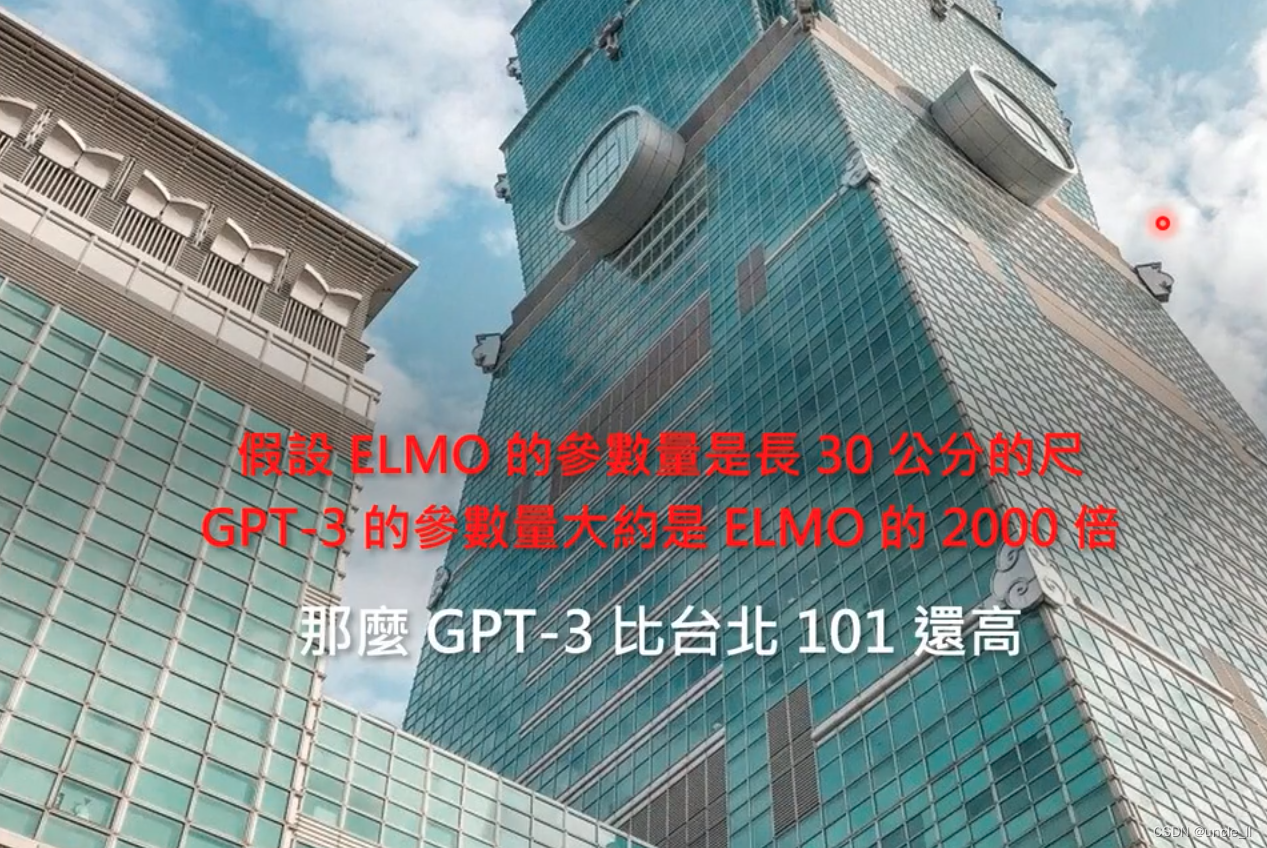

模型过于巨大

GPT3是T5参数量的10倍!

训练GPT3的代价是$12百万美元

Zero-shot Ability

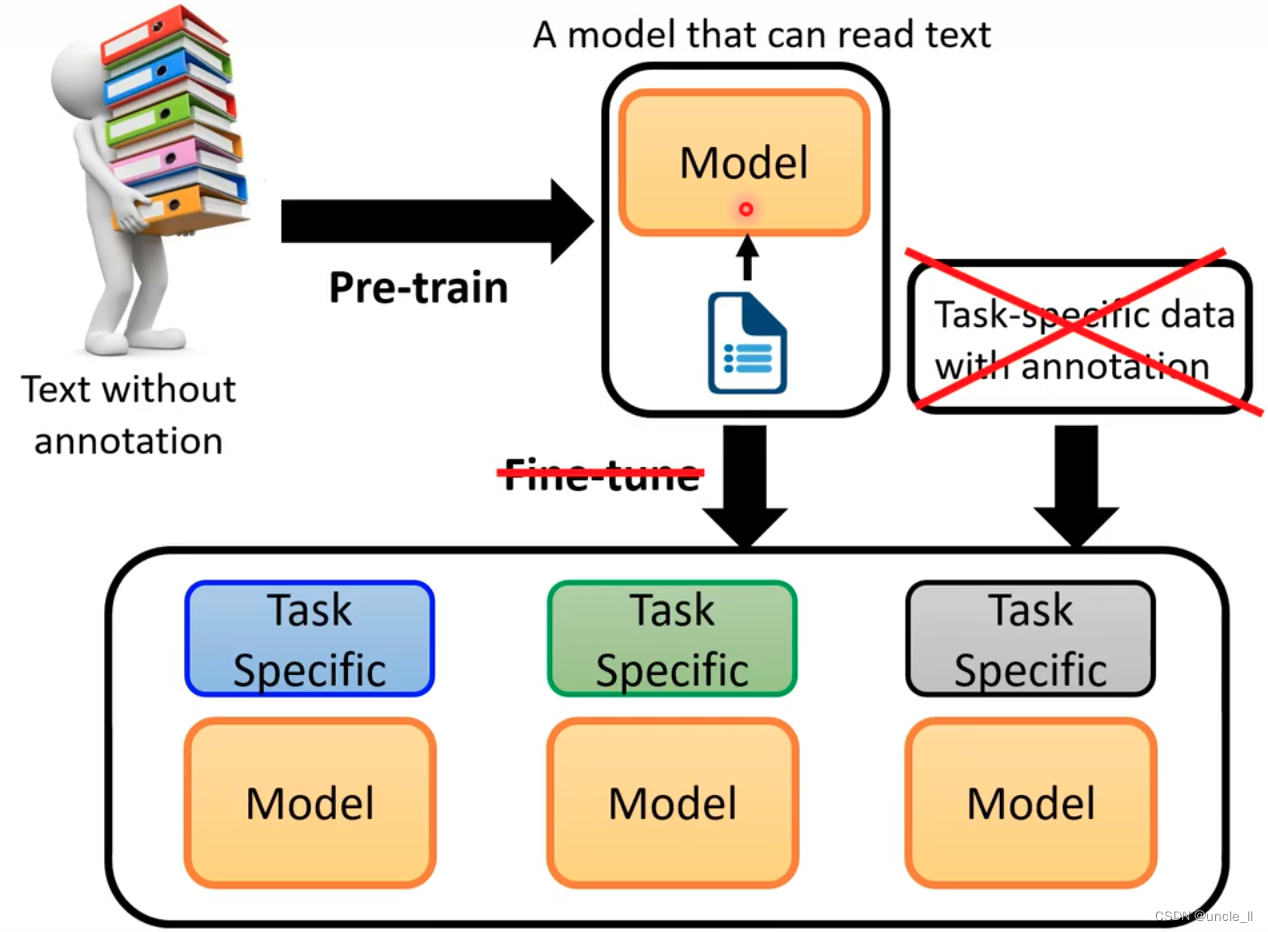

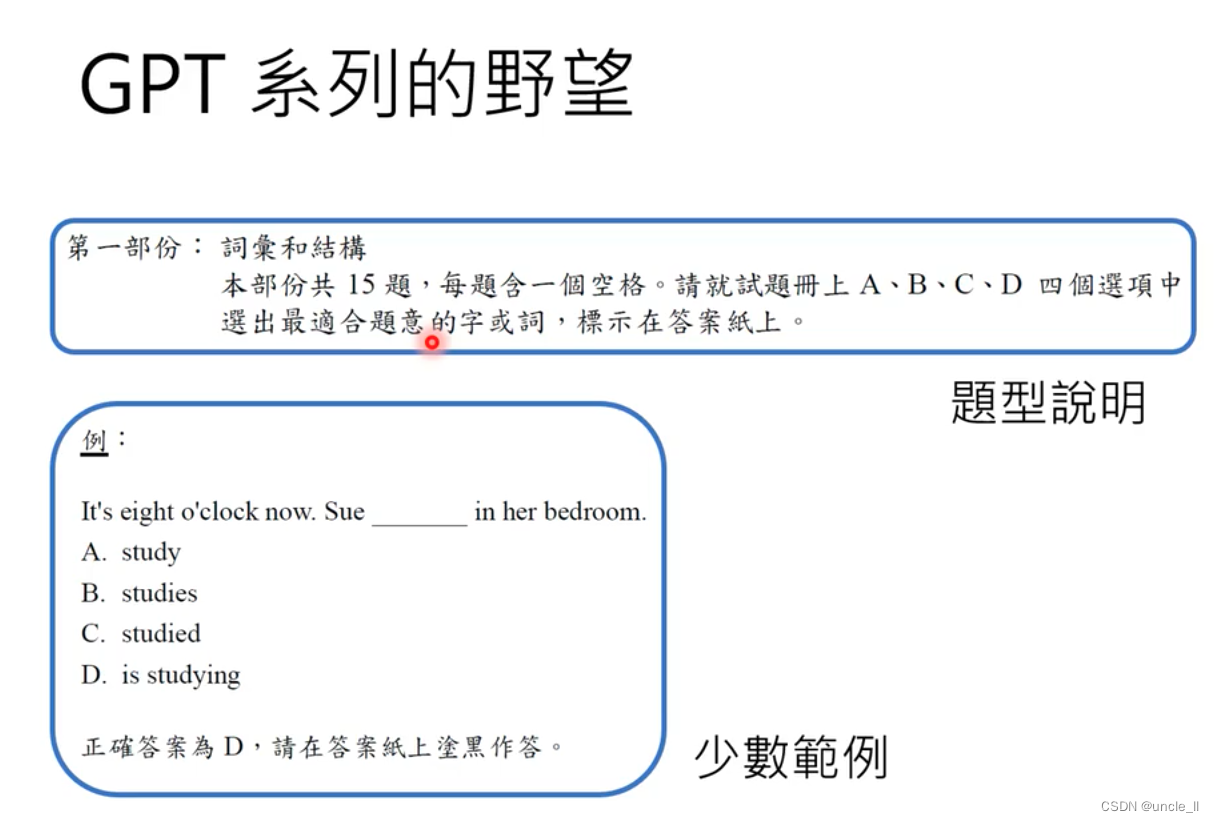

GPT3的思想是不是能拿掉Fine-tune

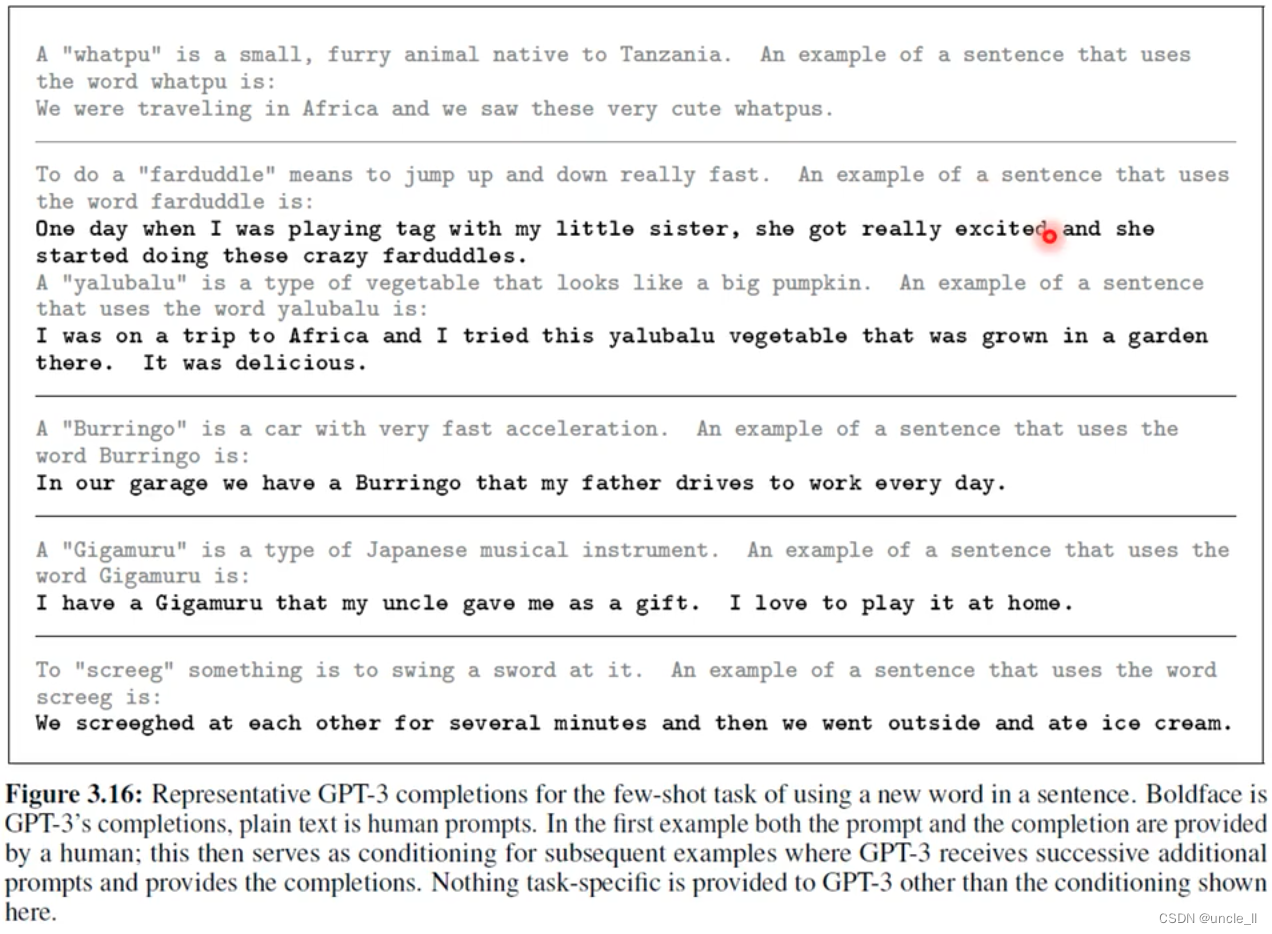

只需要给定few-shot或者zero-shot就能干相应的任务了。

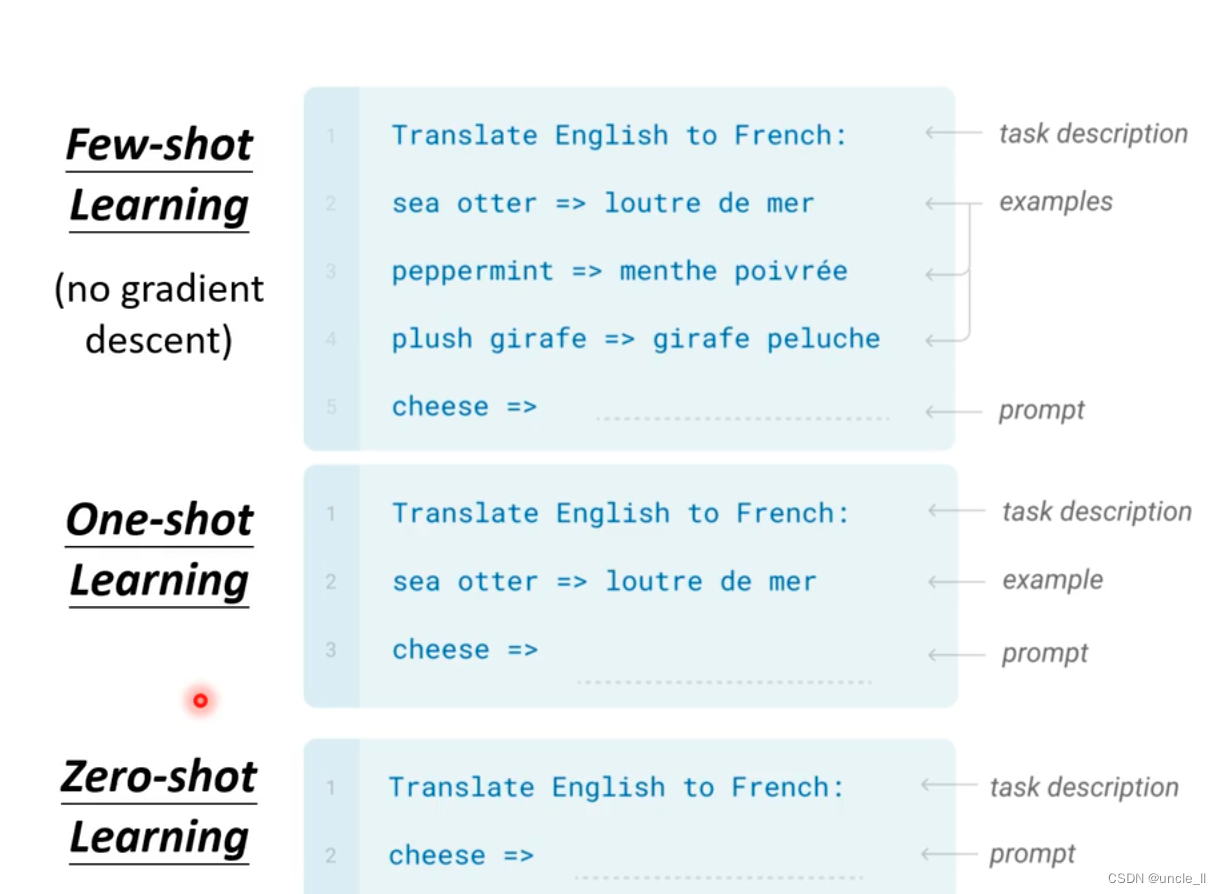

- few-shot learning(no gradient descent): 给一点点的prompt

- one-shot learning: 给一个prompt

- zero-shot leaning:什么都不给

few-shot 是没有微调模型的,没有梯度下降,这些文字是让模型知道做什么。

将这种能力叫做”In-context Learning“

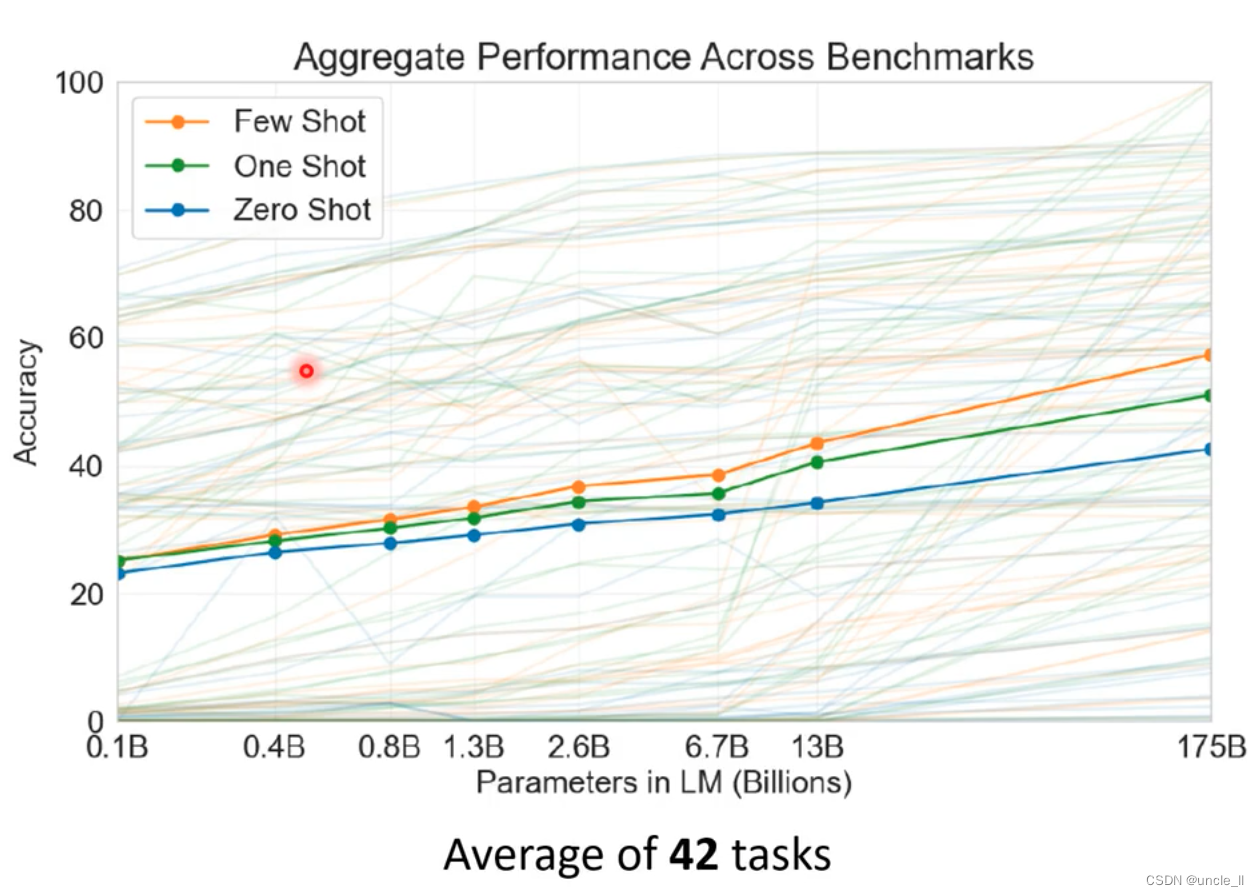

GPT3在42个任务上的表现,随着模型参数越来越大,模型性能越来越好。

相关能力

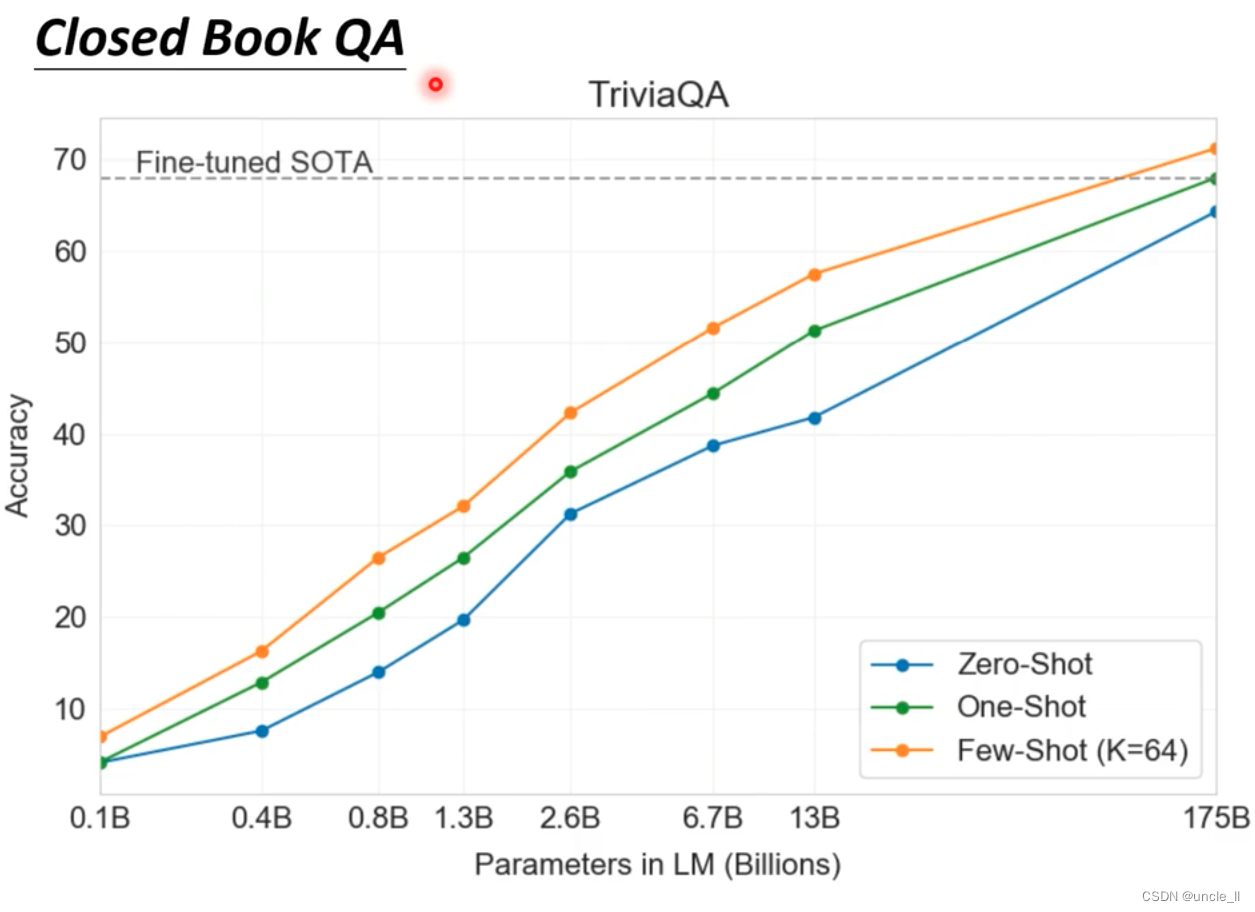

Closed Book QA

闭卷直接问,比如说喜马拉雅山的高度是多少,few-shot learning 超过了fine-tuned sota。

随着few-shot给的数量越多,性能越来越好。

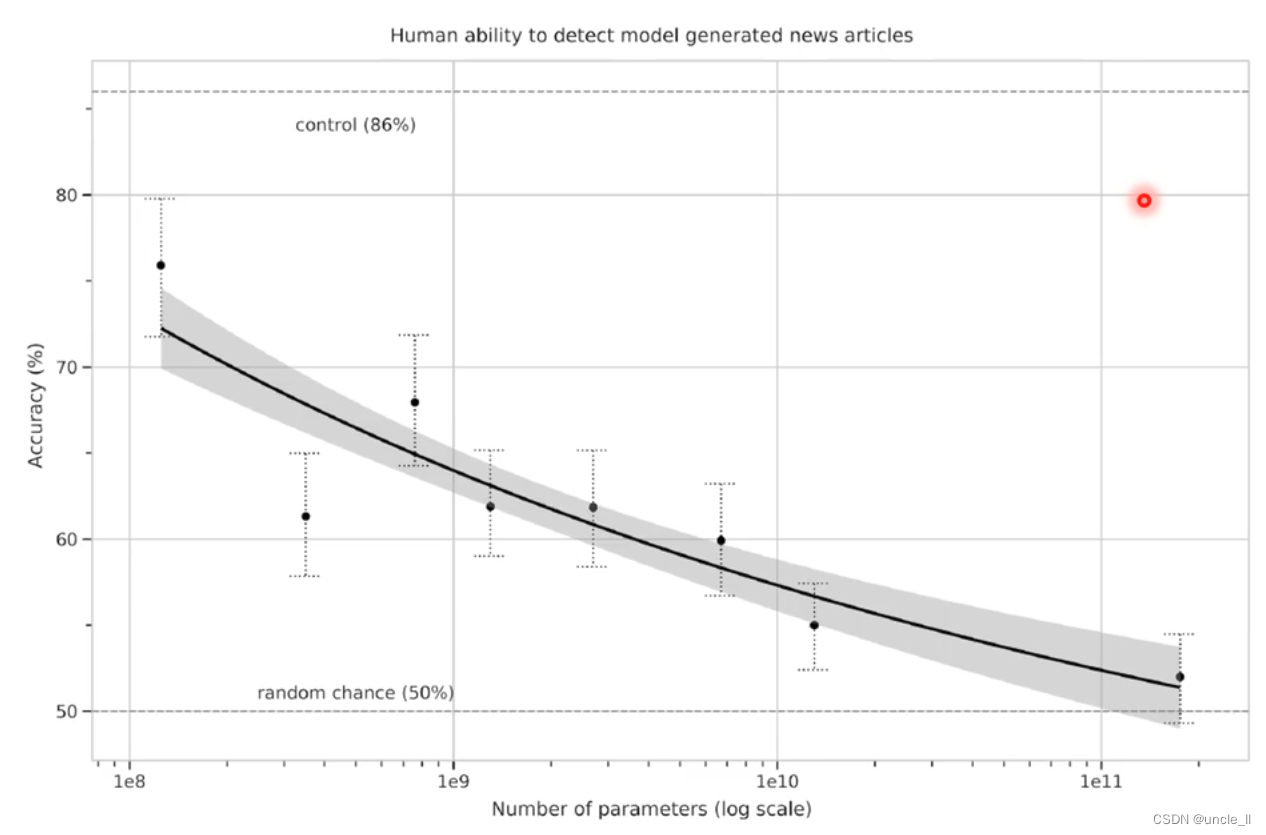

GPT3也可以做生成相关的任务,比如生成文章。产生的新闻可以骗过人类。

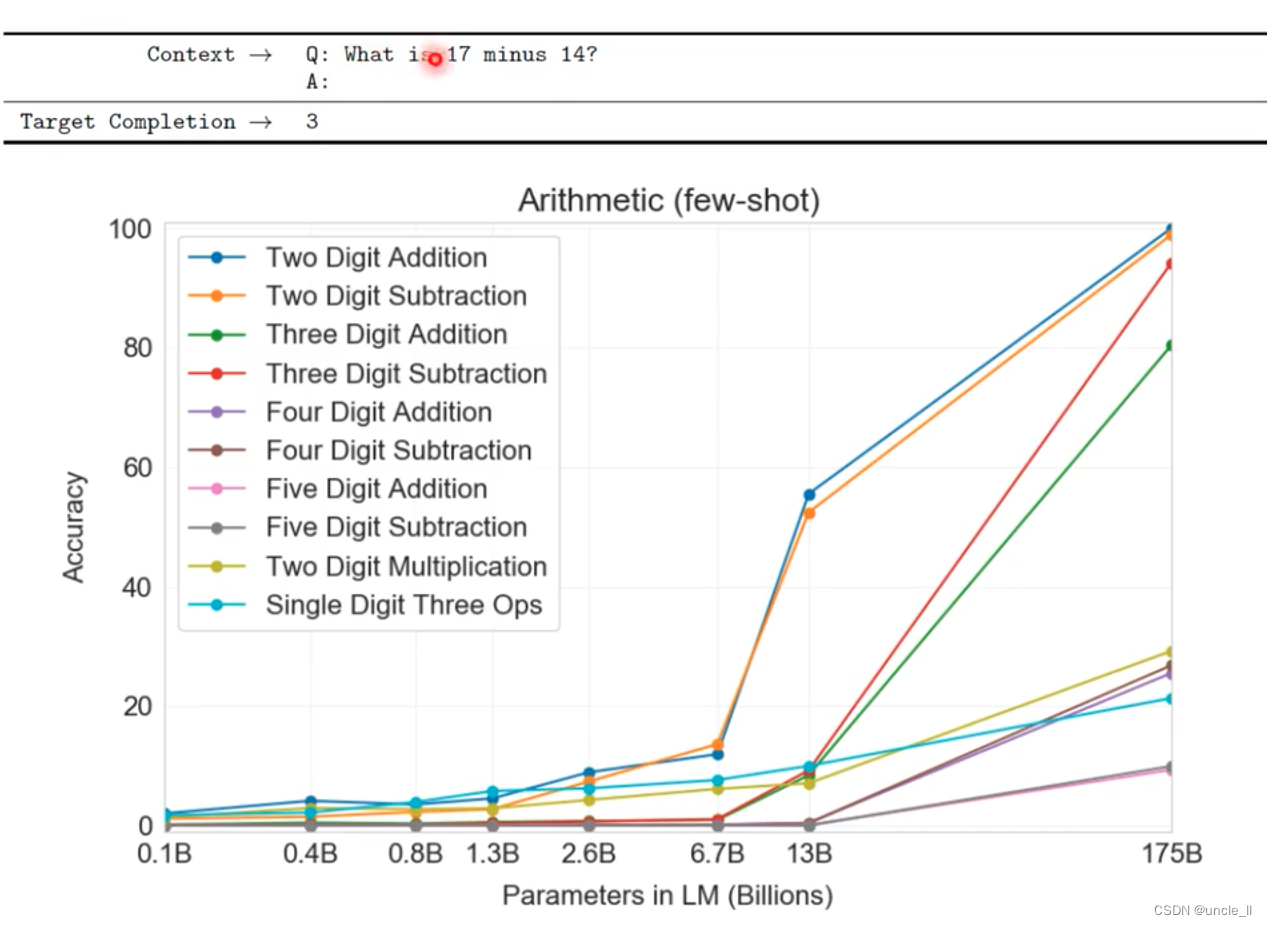

gpt3能做数学相关的任务,使用模型的参数越大,正确率也越高,两位数的加法和两位数的减法上表现非常好,三位数的减法也不错,加法效果要差一点,更困难的就效果比较差了。

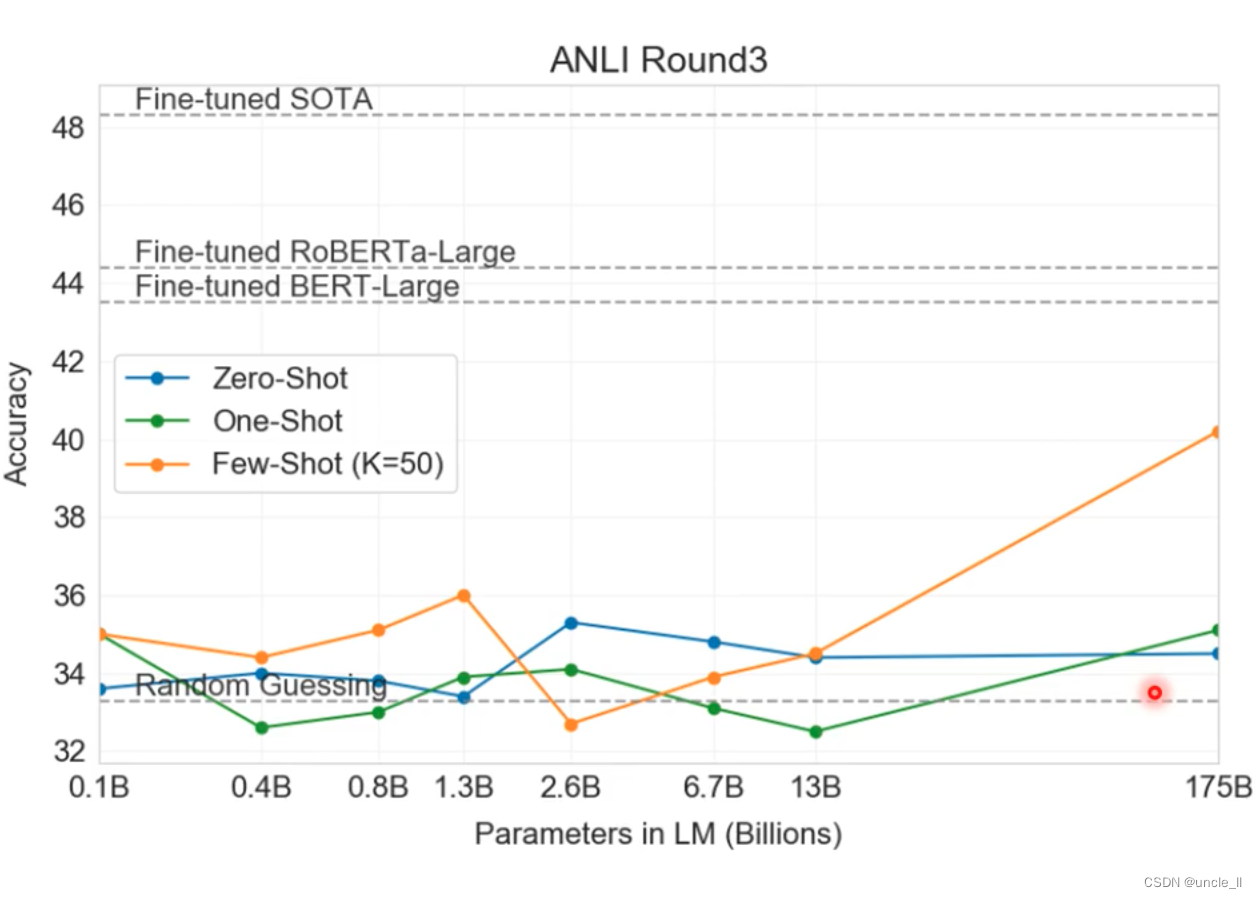

在zero-shot和one-shot效果不行,在few-shot上效果要好一点,在ANLI的任务上效果不好,即给定两个矛盾的句子,判断两个句子是否矛盾。

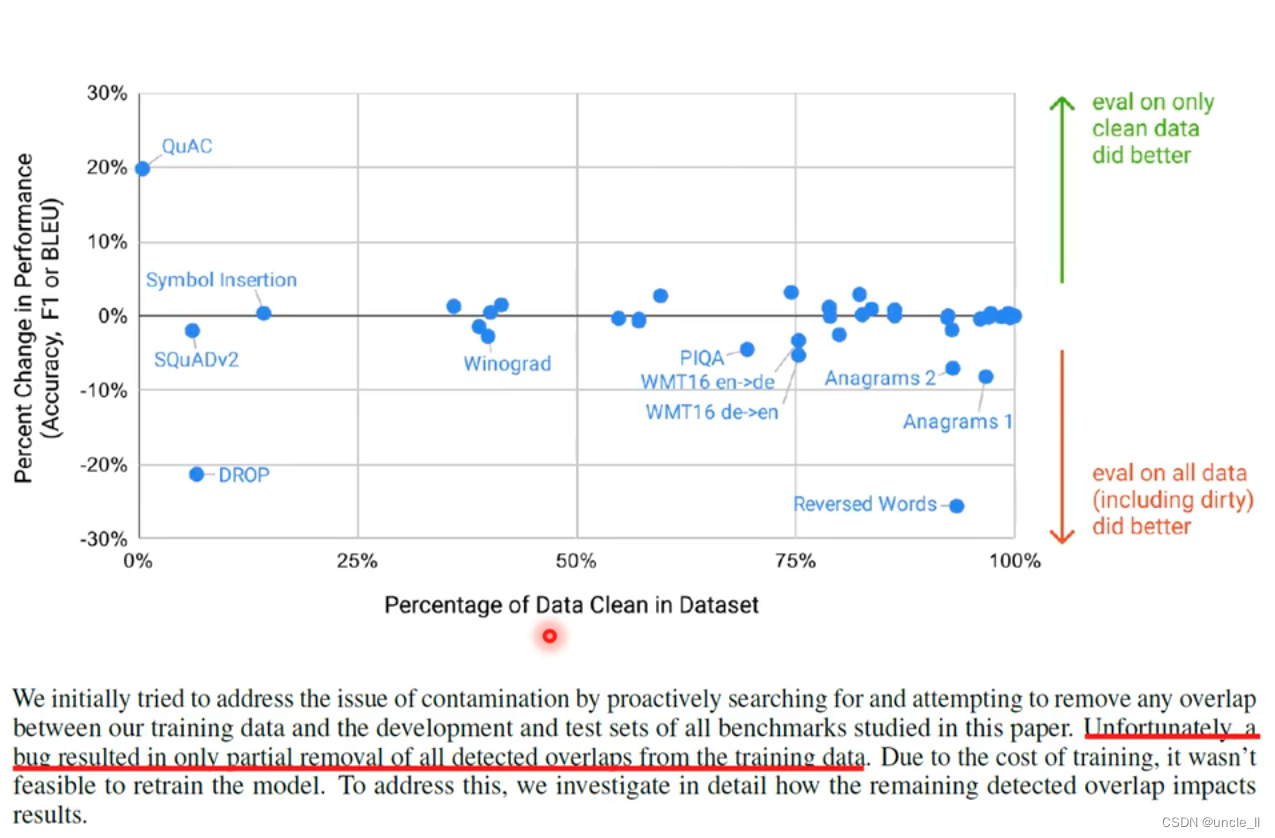

训练数据是从网上爬取的数据,但是无法避免爬取的内容中是否含有任务的数据,相当于拿问题的数据进行训练再来回答任务的数据。

- clean data:gpt3没有看过这些数据

- dirty data:gpt3有看过这些数据

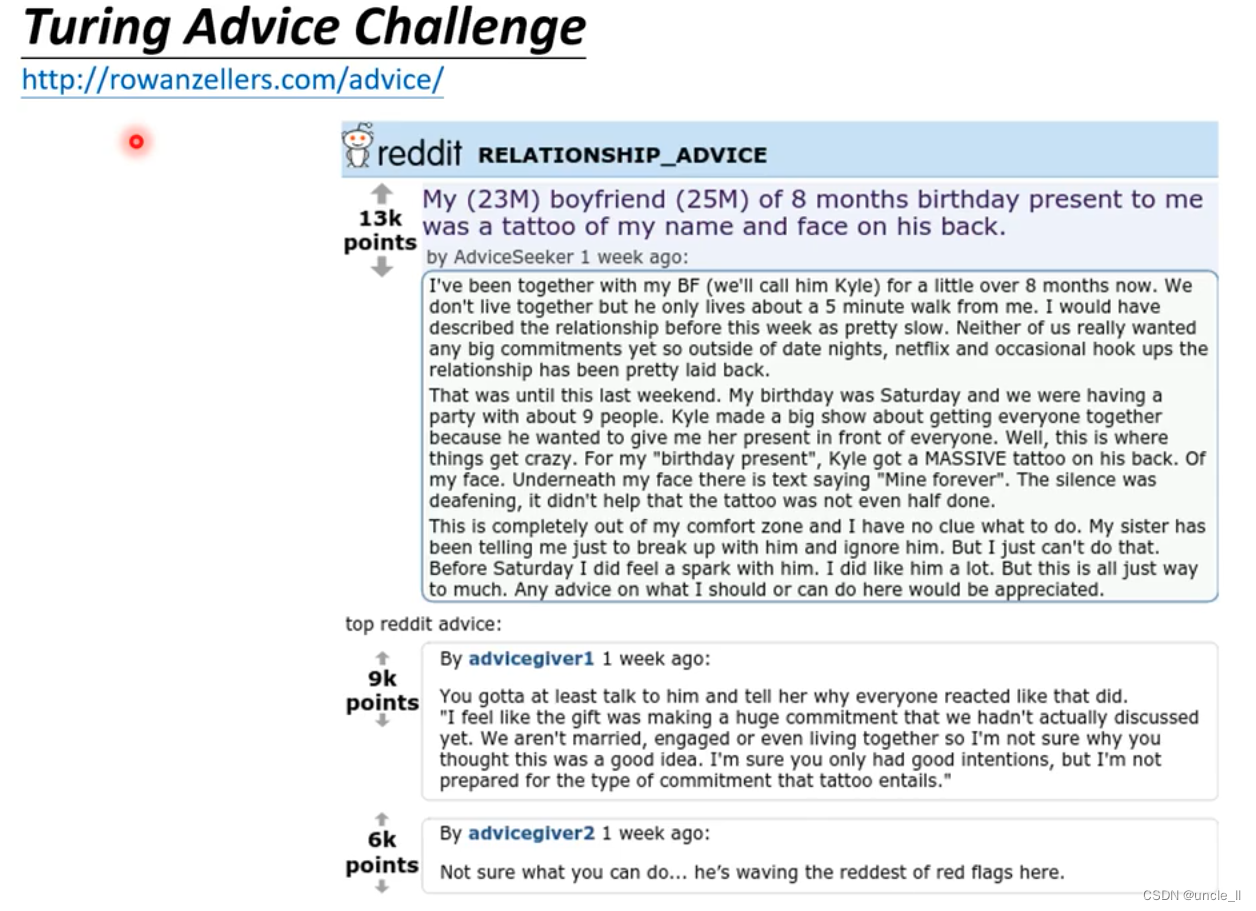

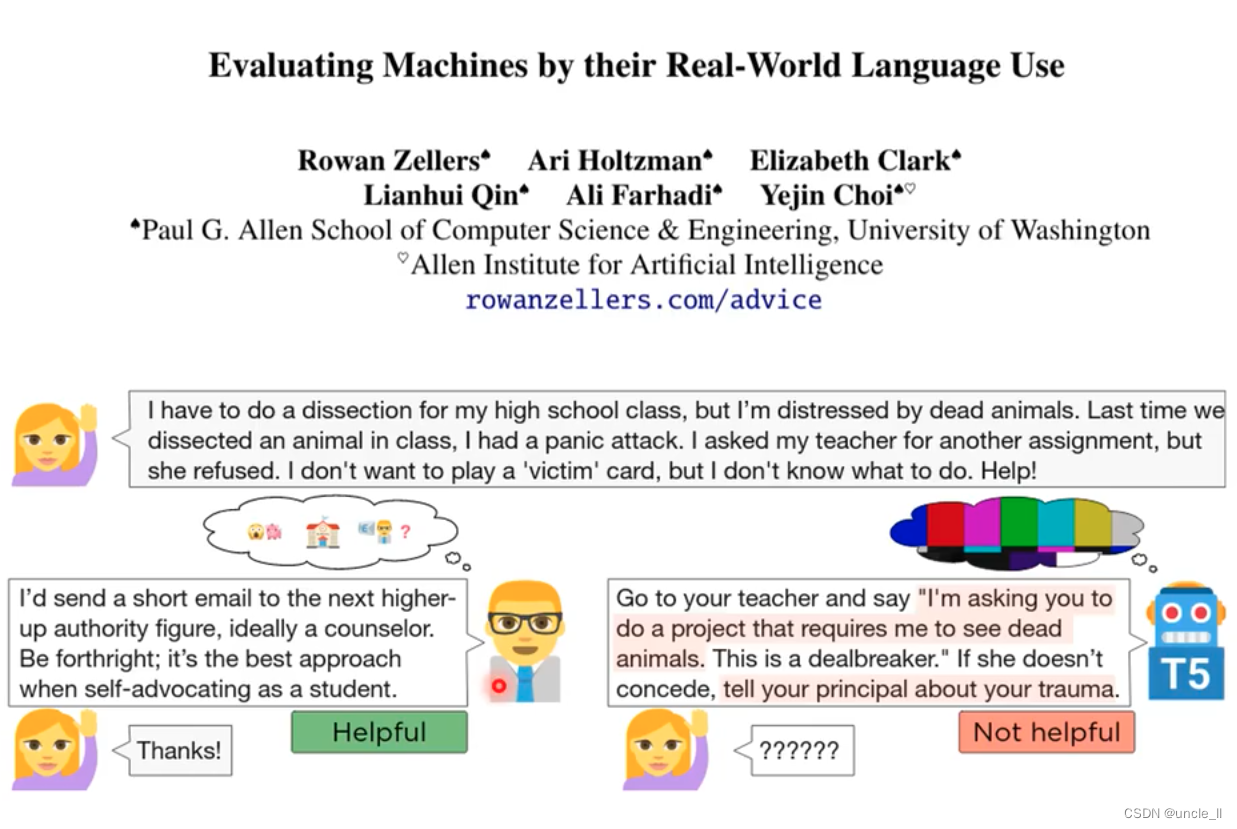

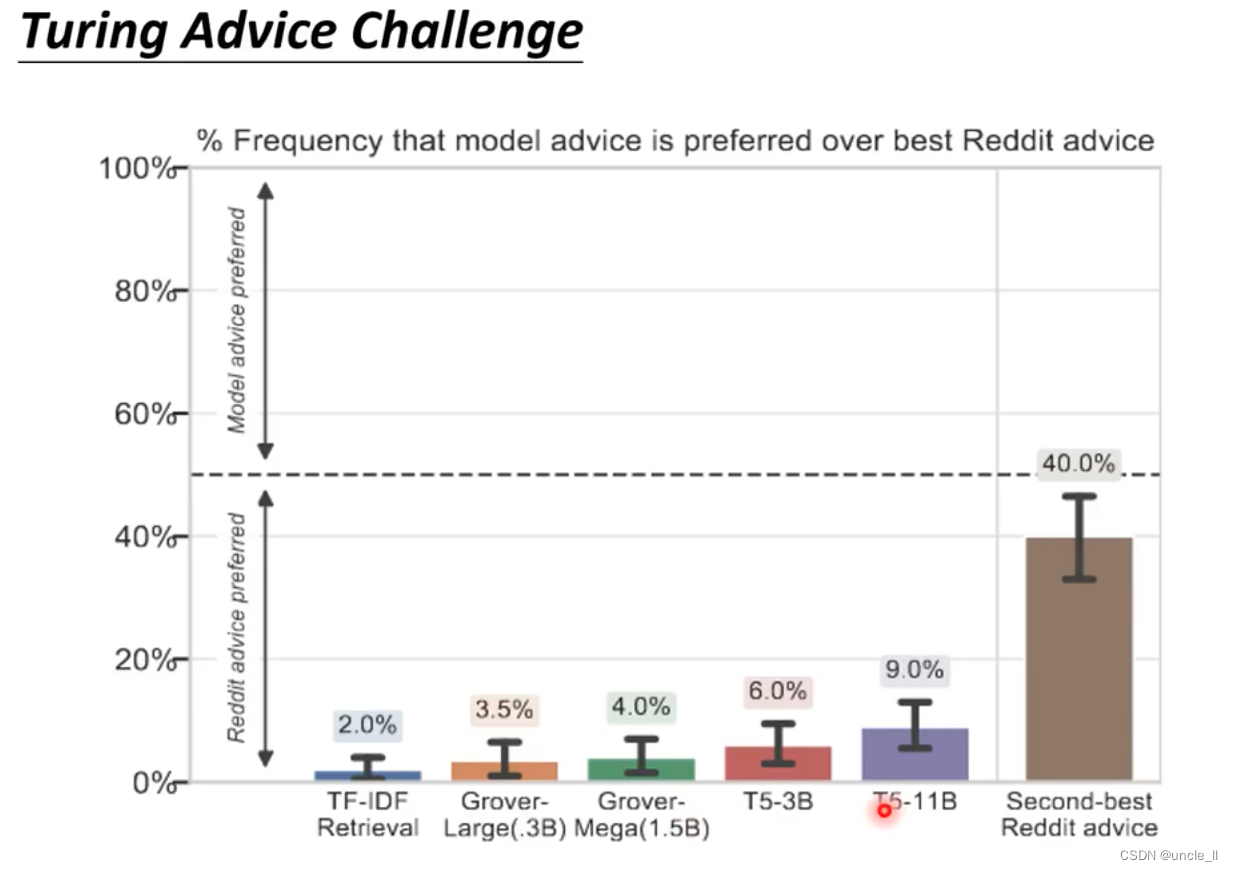

Turing Advice Challenge

gpt3给建议。

与人类的建议做一些比较,效果还一般。

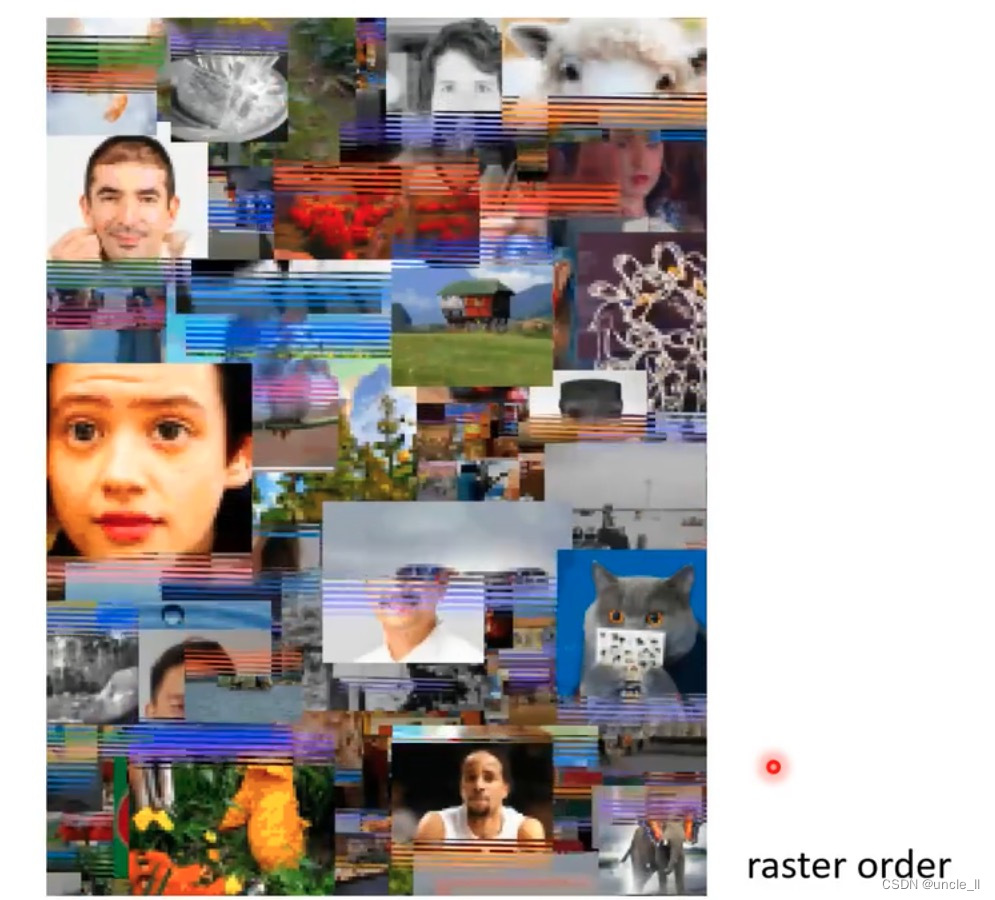

GPT产生图像,一行一行的产生图像。

1788

1788

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?