准备写一个完整教程:

- 手动卸载原先驱动和cuda(英伟达自带的驱动升级程序闪退崩溃)

- 官网下载驱动、cuda、cudnn

- 逐一安装(系统装驱动,cuda与cudnn。然后anaconda虚拟环境装pytorch)

- 安装llama factory

- 微调

(一)卸载

https://www.wagnardsoft.com/blog

Display Driver Uninstaller (DDU) 的官网

进入安全模式的步骤:开始菜单的重启键(按住shift)

进入安全模式以后,双击运行ddu.exe,

选择 显卡–英伟达,并且选中“清理并重启”

重启后进入 控制面板–程序,把英伟达相关的统统卸载掉。

(二)下载

https://www.nvidia.cn/Download/index.aspx?lang=cn#

英伟达驱动下载的官网

https://developer.nvidia.com/cuda-toolkit-archive

cuda下载的官网

https://developer.nvidia.com/rdp/cudnn-archive

cudnn下载的官网

https://pytorch.org/get-started/previous-versions/

pytorch与cuda python cudnn对应版本的网站(鸡肋)(可略过)

https://pytorch.org/get-started/locally/

(三)安装

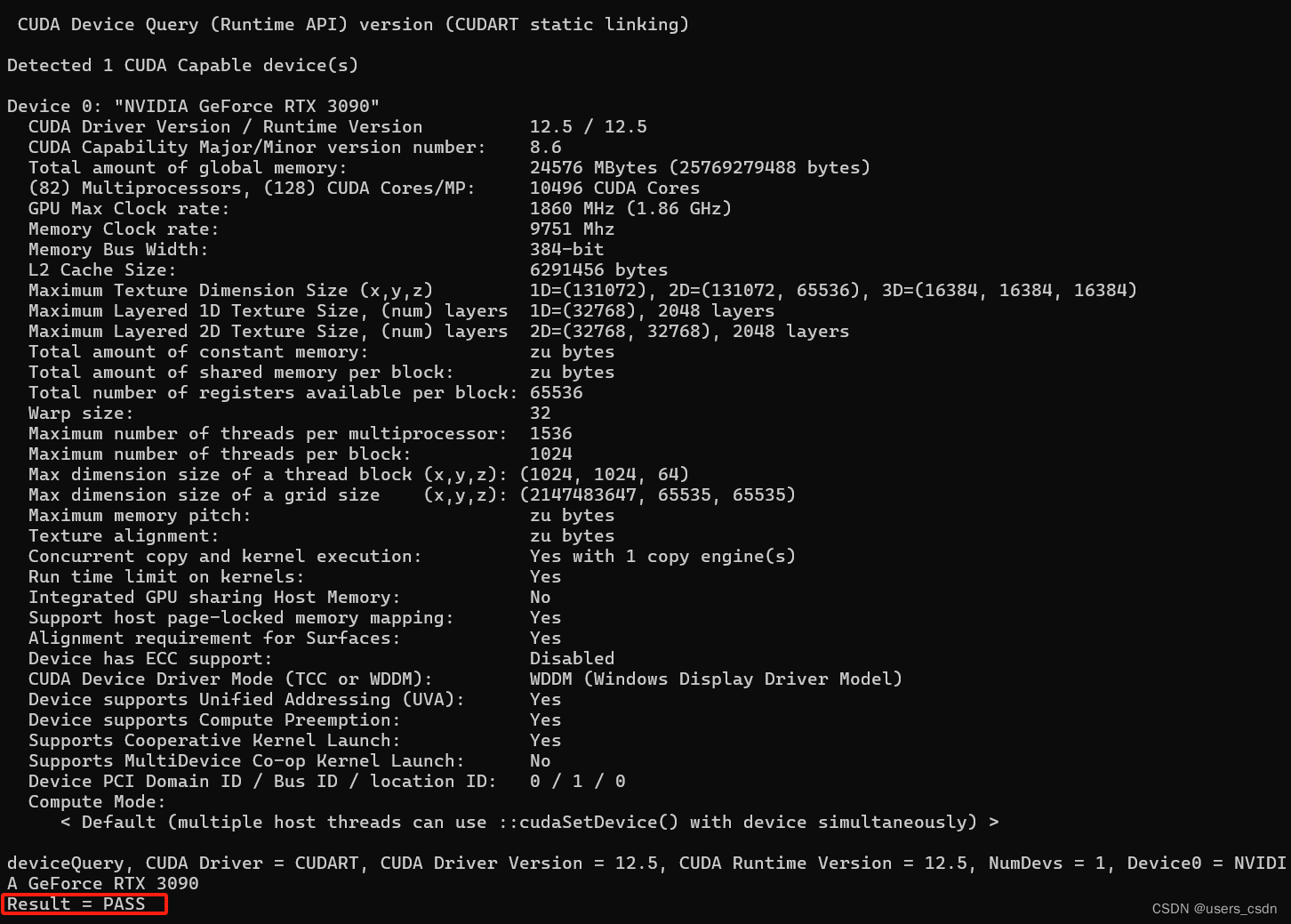

1.先是安装驱动,没什么好说的一路默认安装。安装完毕后在设备管理器查看:显示适配器—你的显卡型号—双击—该设备正常使用(驱动版本对应的上)

2.接着装cuda

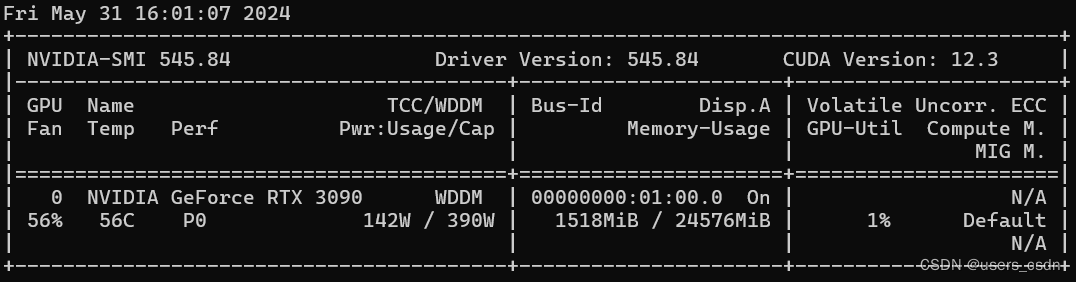

也是一路无脑默认安装,安装完毕后在cmd输入nvcc -V,要出现一下信息:

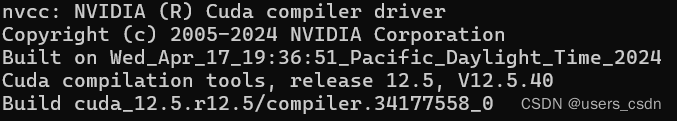

接着在默认cuda安装目录C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.5\extras\demo_suite里,把busGrind.exe拖入cmd运行,要求出现一下画面:

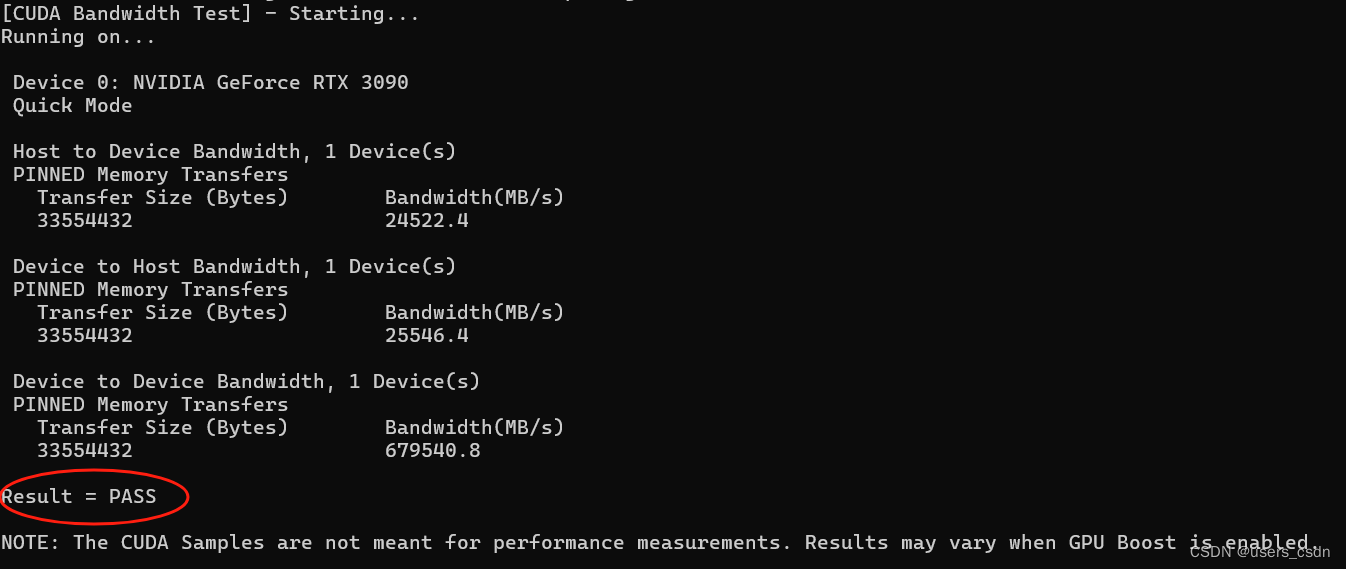

接着把deviceQuery.exe拖入cmd运行:

至此,cuda安装完毕。

3.下面是安装cudnn:

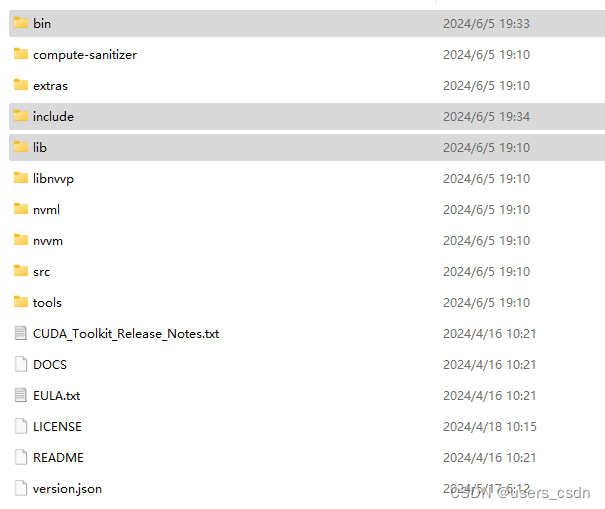

打开C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.5目录,可看到以下文件夹:

官网下载的cudnn解压后,可看到以下文件夹:

注意:重点来了!

把cudnn的这三个文件夹各自里面的内容复制到C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.5目录下对应的三个文件夹里面

上面这句话很绕,我就是想强调千万别搞成“替换掉”,而是“复制到”。(我猛然想起以前我安装cudnn就是直接替换掉…无语了)

至此,所有跟英伟达打交道的环节全部结束。(虽然理论上可以把cuda和cudnn安装在虚拟环境conda里,但不管是pip还是conda安装,不管怎么换源,速度奇慢无比,懒得折腾了。故统统装在操作系统层面,反正上文也阐述了彻底清除驱动的方法,问题不大。)

4.安装anaconda。无脑装就行了,完事后在anaconda navigator创建一个新的环境(下文内容别在base环境里操作…)

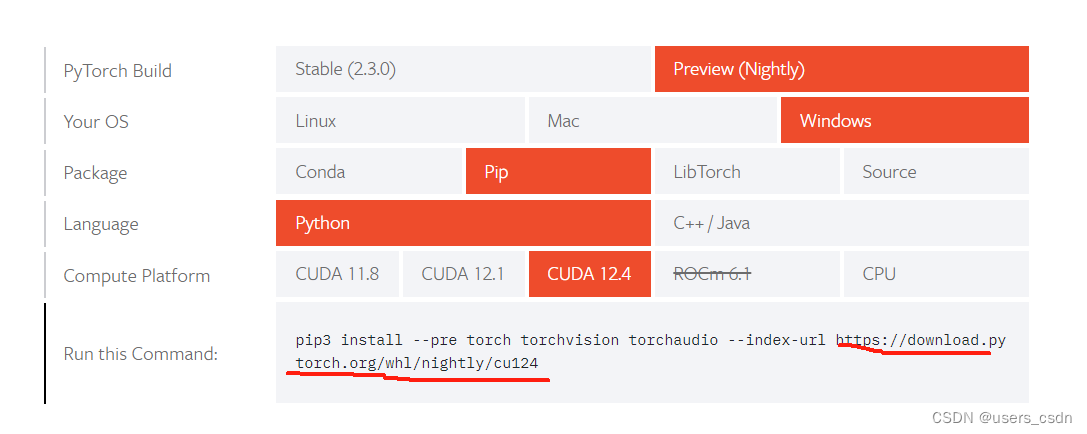

打开链接 https://pytorch.org/get-started/locally/

到这里的话,有两条路线:路线一: 手动一个个下载,一个个安装在操作系统,然后把目录一个个从操作系统复制到虚拟环境里

路线二:直接把pip3 install…这一整串命令复制到虚拟环境的终端执行。

为什么会有两种做法,因为之前的路线二是有bug,所以有一段时间只能走路线一。现在亲测可以使用路线二。

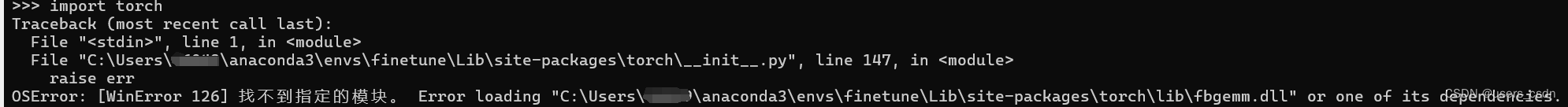

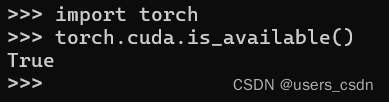

完事后在虚拟终端里输入

python

import torch

torch.cuda.is_available()

然而报错:

解决方案:

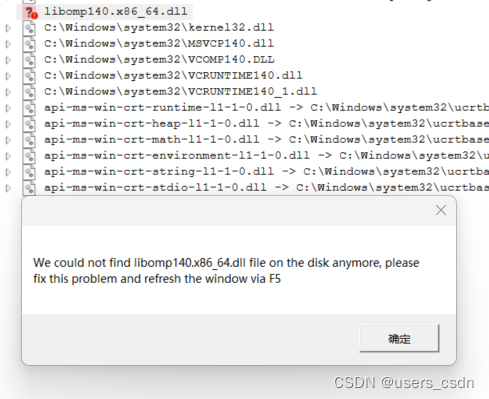

下载报错分析软件https://github.com/lucasg/Dependencies/releases/tag/v1.11.1

解压直接运行,然后把fbgem.dll拖入诊断软件内分析:

报错软件给出的诊断结果。

下载缺失的libomp140.x86_64.dll

网址如下https://www.dllme.com/dll/files/libomp140_x86_64/037e19ea9ef9df624ddd817c6801014e/download

下载后把libomp140.x86_64.dll丢入lib文件夹里(与fbgem.dll同一个文件夹)

问题解决。

接下来安装llama-factory

下载https://github.com/hiyouga/LLaMA-Factory?tab=readme-ov-file

cd LLaMA-Factory

pip install -r requirements.txt

启动llama-factory

cd进入LLaMA-Factory-main\src目录

python webui.py

5692

5692

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?