本地配置

系统:win10

**硬件:**i5-12490f+RTX4060

安装原因:

最近尝试在本地对开源LLM进行Fine-tune的时候,用到了LLaMA-Factory,在运行的时候,弹出未检测到GPU,后来才发现,是忘记安装cuda等环境导致的

LLaMA-Factory: https://github.com/hiyouga/LLaMA-Factory

本地测试方法:

GPU:

import torch

print(torch.cuda.is_available()) # 是否可以用gpu False不能,True可以

print(torch.cuda.device_count()) # gpu数量, 0就是没有,1就是检测到了

Cuda:

nvcc -V

出现以下内容,说明你本机安装过cuda了

安装过程:

安装前先简单了解下什么是cuda

CUDA(ComputeUnified Device Architecture),是显卡厂商NVIDIA推出的运算平台。CUDA是一种由NVIDIA推出的通用并行计算架构,该架构使GPU能够解决复杂的计算问题。

安装前先安装VS Community,因为不安装的话,直接安装Cuda会报错

下载链接: https://my.visualstudio.com/Downloads?PId=8228

下载前需要注册登陆账号,目前可以下载的版本可能只有2022版的,不过问题不大,也可以用

安装过程是傻瓜式操作,在选择工作负荷的时候,选C++桌面端开发

安装完成后,登录自己的账号(下载前注册的账号),然后关闭即可

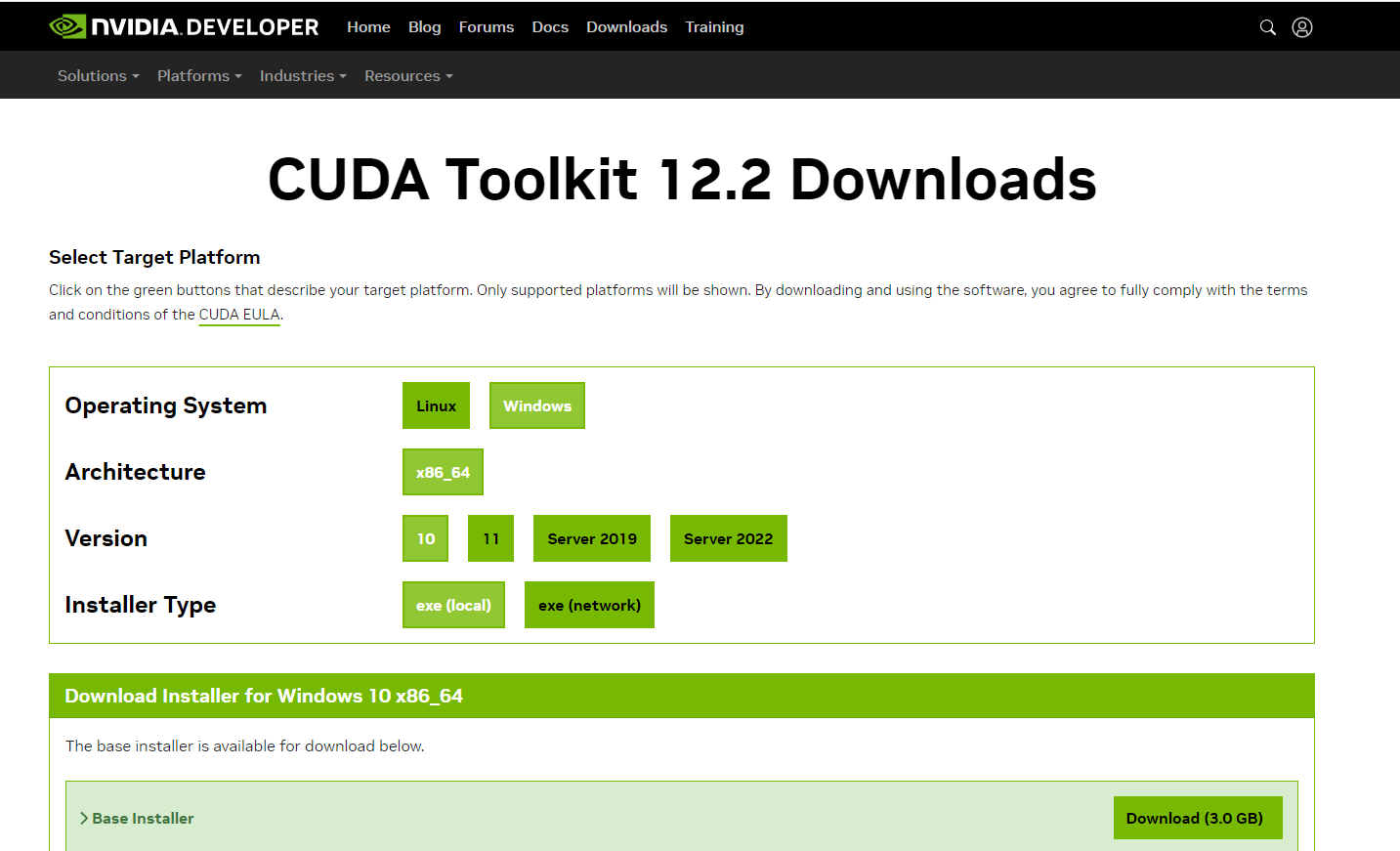

去Nvidia 官网,下载CUDA:

https://developer.nvidia.com/cuda-12-2-0-download-archive?target_os=Windows&target_arch=x86_64&target_version=10&target_type=exe_local

因为llama-factory要求的版本是11.8-12.2的,索性就下载安装一个12.2的版本

下载的文件大约3G左右

整个安装过程,也是傻瓜式操作,自定义安装中,可以看到安装CUDA的选项

后面一只下一步就好,安装完成后需要设置环境变量,一般默认安装路径都是一样的

设置好后,测试安装是否成功,如果出现下图,看到Build cuda_12.2表示安装成功了

这里大家可能有疑问,nvidia-smi执行后,右上角也会出现一个CUDA Version: 12.5, 这两个cuda版本有什么区别,其实CUDA有runtime api 和 driver api, nvcc -V显示的是runtime api, nvidia-smi显示的是 driver api, runtime api 是CUDA Toolkit install 安装的, driver api是GPU driver installer安装的, 所以这两个东西安装上并没有什么太大的关系

唯一需要注意的是,一般nvidia-smi的版本需要大于 nvcc -V显示的版本,像我安装的12.5>12.2,使用起来没有什么大问题

2955

2955

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?