【2020论文阅读12月】

Which Tasks Should Be Learned Together in Multi-task Learning (v)

Multi-Task Learning 的目的:

- 减少训练时间

- decreased inference time

- More compact models

- 提高准确率

- Better learned representations

ImageNet Classification with Deep Convolutional Neural Networks

摘要

神经网络:60 million (6千万)个参数,65万个神经元,由5个卷积层,max-pooling layers, 3个完全连接层(fully-connected layers),a final 1000-way softmax组成。

为了训练更快,使用非饱和神经元(non-saturating neurons)和一个高效的卷积操作的GPU实现

正文

模型应该具有许多先验知识来弥补缺失的数据。

卷积神经网络:可以通过改变网络的深度和广度来控制它们的能力,可以对图像本质(即stationarity of statistics and locality of pixel dependencies)做出strong and correct的假设。因此,与具有类似大小层的标准前馈神经网络相比,cnn的连接和参数要少得多,因此更容易训练。

Bag of Tricks for Image Classification with Convolutional Neural Networks

Bag of Tricks for 图像分类和CNN

摘要

图像分类研究最近取得的大部分进展都属于训练过程的改进,比如数据扩增和方法优化。但是,在文献中,大多数改进被简要地提到,有些只能在源代码中可见。在本文,我们将检查这些改进,并通过abalation study来实际评估它们对最终模型准确度的影响。

将这些改进结合在一起,能够显著改进各种CNN模型。

我们还指出,图像分类准确率的提高会在其他应用领域(如目标检测和语义分割)带来更好的迁移学习性能。

正文

从2012年深度卷积神经网络的提出至今,ImageNet伤的top-1 validation accuracy已经从62.5%(AlexNet)提高到了82.7%(NASNet-A)。这些进步不仅来自于改进的模型结构,这些改进包括训练过程的改进,损失函数、数据预处理、优化方法。

但这些改进没有被很多人注意到,论文中也只是简单提及,甚至只有在源码中才能看到。本文将总结这些改进。这些改进很多都是小技巧(minor tricks),比如修改一个特定卷积层的步长大小或者调整学习速率进度。但总的来说,它们带来了很大的不同,我们将在多个网络架构和数据集上评估他们,并报告他们对最终模型准确性的影响。

实验:把技巧应用在ResNet-50上,top-1:75.3——>79.29%。也可以推广到其他模型和数据集。

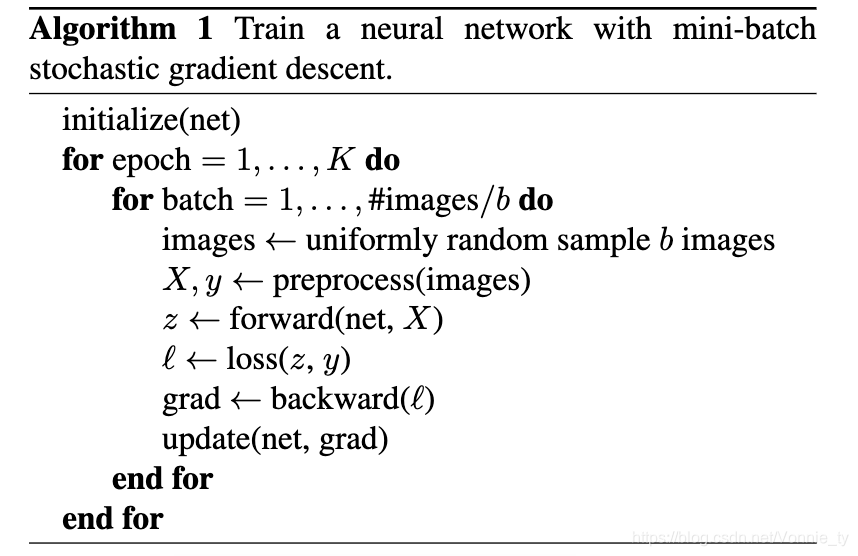

小批量随机梯度下降神经网络的训练

在每次迭代中,随机采样图像来计算梯度,然后更新网络参数。在经过K passes through the dataset后停止。

Baseline: 一个广泛被使用的ResNet。training和validation的preprocessing pipelines不同。

训练过程的步骤如下:

1.对图像随机采样,并将其解码为32位浮点数原始像素值[0,255]

2. 随机采样,在[8%,100%]的区域里,随机剪裁长宽比以[3/4,4/3]的长方形,然后将剪裁区域的尺寸调整为224x224的正方形图像

3. 以0.5的概率水平翻转 (为什么要做以下三步)

4. 得出hue, saturation, brightness?

5. add PCA noise with a coefficient sampled from a normal distribution 正态分布N(0,1)

6. 归一化RGB通道:Normalize RGB channels by subtracting 123.68,116.779, 103.939 and dividing by 58.393, 57.12,57.375, respectively

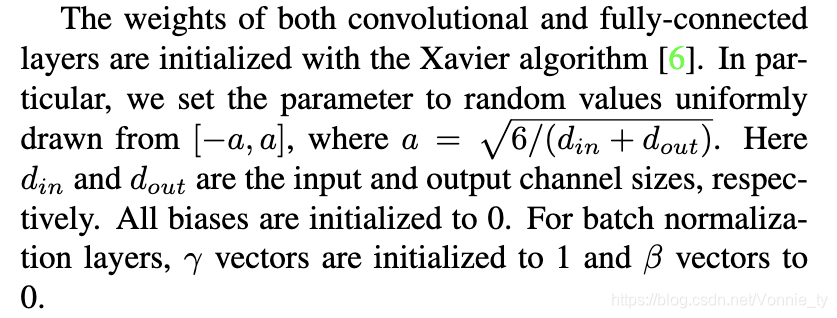

卷积层和全连接层的权重都用Xavier算法初始化。(然后还有一些参数设置)

实验结果:

评估了三个CNNs(ResNet-50、Inception-V3、MobileNet),使用ISLVRC2012数据机(有1.3 million张图,有1000个类)

Efficient Training:

As a result, the optimal choices for manyperformance related trade-offs have changed. For example,it is now more efficient to use lower numerical precision andlarger batch sizes during training.

许多与性能相关的权衡的optimal choice已经改变。例如,现在训练中使用较低的数值精度numerical precision和较大的batch sizes会更有效率。

能搞保证低精度和大batch size又不牺牲模型精度的技术:

- Large-batch training 大batch训练:Mini-batch SGD(小型批处理器SGD)将多个样本分组到一个mini-batch里,从而提高并行性和降低通信成本。使用大批量可能会减慢训练进度。对于凸问题,收敛量会随batchsize的增大而降低。In other words,对于相同数量的epoch,大批量训练会导致模型的验证准确性下降(degraded validation accuracy)(对比小batch size)

- Linear scaling learning rate线性缩放学习率,在小批SGD中,梯度下降是一个随机过程,因为每个批次的样本都是随机选择的。增加批容量不会改变随机样本的期望,但会降低其方差。(期望和方差分别代表什么) In other words, 较大的batchsize减小了梯度中的噪声(梯度噪声是什么)=> 所以我们可以提高learning rate,从而在在梯度反向取得更大的进展。

例子:

initial learning rate:0.1——batahsize 256 ==> batchsize b,learning rate=0.1 x b/256 - Learning rate warmup :在训练开始时,所有参数通常都是随机值(往往与最终方案很不同),使用太大的学习率可能会导致数值不稳定。In the warmup heuristic, 我们在一开始使用小的学习率,然后在训练过程稳定后将学习率调整回初始值。

- Zero r:一个残差网络又多个残差块组成,每一个块由数个卷积层组成。输入x,block(x)是这个快中最后一层的输出,这个残差块会输出 x+block(x)。注意这个块的最后一层可以是一个BN层(batch normalization)。BN层会首先对输入进行标准化,然后执行scale transformation,rx+ß,r和ß都是learnable parameters, 它们初始值是1或0

- No bias decay:权重衰减通常应用于包括权重和偏差在内的所有可学习参数。为了避免过拟合,建议仅对权重进行正则化处理。no bias decay heuristic遵循这一建议,它只将权值衰减应用于卷积层和全连接层的权值,其他参数,(BN层的r和ß都是不正则的)

Model Tweaks

模型调整是对网络结构的微小调整,比如改变特定的传输层的步长。这样的调整通常很少改变计算的复杂性,但可能对模型的准确性有不可忽视的影响。在本节中,我们将以ResNetas为例来研究模型调整的效果。

Imitating Interactive Intelligence

研究如何利用虚拟环境的简化来设计能够与人类自然互动的人工智能。这涉及一系列人工智能的核心挑战:complex visual perception复杂视觉感知,goal-directed physical control目标导向的物理控制,grounded language comprehension and production有基础的语言理解和产生,multi-agent social interaction多主体的社会互动。

因此,我们用另一种习得agent来近似人的角色,并利用反向强化学习的思想来缩小人与agent交互行为之间的差异。

严格评估我们的agent是一项巨大的挑战,因此我们开发了各种行为测试,包括由观看agent视频或直接与他们互动的人进行评估。这些评估令人信服地证明,交互训练和辅助损失(interactive training & auxiliary losses)改善代理行为的效果,超过了仅通过监督学习行为所达到的效果

综上所述,我们在这个虚拟环境中的结果提供了证据,证明大规模的人类行为模仿是创建智能、交互式代理的一个有前途的工具,而且可靠地评估此类代理的挑战是可能克服的。为手稿、训练延时和人机交互的概述见视频。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?