A ConvNet for the 2020s

2020年代的ConvNet

https://openaccess.thecvf.com/content/CVPR2022/papers/Liu_A_ConvNet_for_the_2020s_CVPR_2022_paper.pdf

Zhuang Liu 1 , 2 ∗ ^{1,2*} 1,2∗ Hanzi Mao 1 ^1 1 Chao-Yuan Wu 1 ^1 1 Christoph Feichtenhofer 1 ^1 1 Trevor Darrell 2 ^2 2 Saining Xie 1 † ^{1†} 1†

1 ^1 1Facebook AI Research (FAIR) 2 ^2 2UC Berkeley

Code: https://github.com/facebookresearch/ConvNeXt

摘要

“视觉识别的繁荣20年代”始于引入Vision Transformers(ViTs),这一模型很快超越了ConvNets成为最先进的图像分类模型。然而,普通的ViT在应用于诸如目标检测和语义分割等通用计算机视觉任务时遇到了困难。层次化的Transformers(例如Swin Transformers)重新引入了几个ConvNet的先验知识,使得Transformers在实践中可行作为通用视觉骨干,并在各种视觉任务中展现出卓越的表现。然而,这种混合方法的有效性仍然主要归因于Transformers的内在优越性,而不是卷积的内在归纳偏见。在本研究中,我们重新审视设计空间并测试了纯ConvNet可以实现的极限。我们逐步将标准ResNet“现代化”成为一个视觉Transformer的设计,并在过程中发现了几个关键组成部分,它们对性能差异做出了贡献。这种探索的结果是一系列被称为ConvNeXt的纯ConvNet模型。ConvNeXt完全由标准ConvNet模块构建,以准确性和可扩展性方面与Transformers竞争,实现了87.8%的ImageNet top-1准确度,并在COCO检测和ADE20K分割方面胜过Swin Transformers,同时保持标准ConvNets的简单和效率。

代码:https://github.com/facebookresearch/ConvNeXt

引言

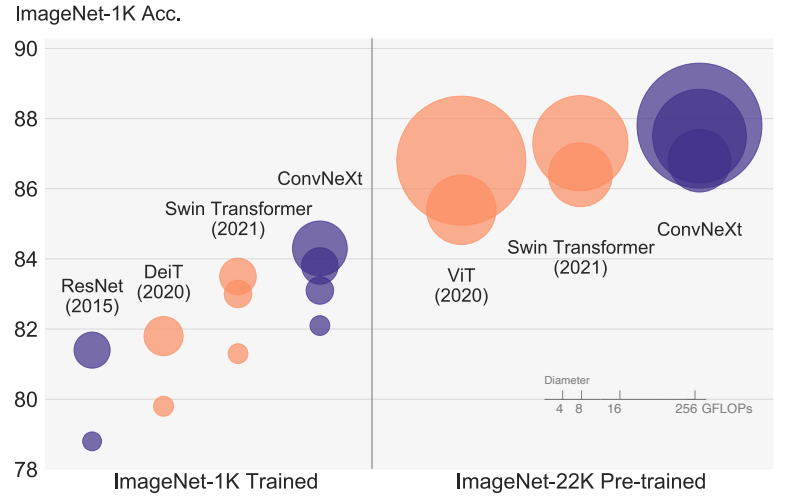

图1。ConvNets和视觉Transformer的ImageNet-1K分类结果,每个气泡的面积与模型家族中变体的FLOPs成比例。这里的ImageNet-1K/22K模型分别采用2242/3842张图像。ResNet和ViT的结果是在原始论文的改进训练程序上获得的。我们证明了标准ConvNet模型可以实现与分层视觉Transformer相同的可扩展性,同时设计更加简单。

回顾2010年代,这个十年以深度学习的巨大进展和影响为标志。主要推动力是神经网络的复兴,特别是卷积神经网络(ConvNets)的复兴。在整个十年中,视觉识别领域成功地从工程特征转变为设计(ConvNet)架构。虽然反向传播训练的ConvNets的发明可以追溯到20世纪80年代[42],但直到2012年末我们才看到它在视觉特征学习方面的真正潜力。AlexNet的引入[40]引发了“ImageNet时刻”[59],开启了计算机视觉的新时代。该领域自此以来发展迅速。像VGGNet[64]、Inceptions[68]、ResNe(X)t[28, 87]、DenseNet[36]、MobileNet[34]、EfficientNet[71]和RegNet[54]这样的代表性ConvNets专注于准确性、效率和可伸缩性的不同方面,并普及了许多有用的设计原则。

卷积神经网络在计算机视觉中的全面优势并非偶然:在许多应用场景中,“滑动窗口”策略在视觉处理中是固有的,特别是在处理高分辨率图像时。卷积神经网络具有几个内置的归纳偏差,使它们非常适合各种计算机视觉应用。最重要的一个是平移等变性,这是目标检测等任务所需的理想属性。由于在滑动窗口方式下使用时,卷积神经网络的计算是共享的[62],因此它们本质上是高效的。几十年来,这一直是卷积神经网络的默认用法,通常用于有限的对象类别,如数字[43]、人脸[58, 76]和行人[19, 63]。进入2010年代,基于区域的检测器[23, 24, 27, 57]进一步将ConvNets提升为视觉识别系统中的基本构建模块。

与此同时,用于自然语言处理(NLP)的神经网络设计走上了一条非常不同的道路,Transformer取代循环神经网络成为主导的骨干架构。尽管语言和视觉领域的任务存在差异,但令人惊讶的是,这两个领域在2020年相遇,Vision Transformers (ViT)的引入完全改变了网络架构设计的格局。除了最初的“patchify”层将图像分割为一系列补丁之外,ViT没有引入任何特定于图像的归纳偏差,并且对原始的NLP Transformers进行了最小的修改。ViT的一个主要关注点是其扩展性行为:通过使用更大的模型和数据集大小,Transformers可以在很大程度上超越标准的ResNets。这些在图像分类任务上的结果令人鼓舞,但计算机视觉不仅限于图像分类。正如前面讨论的那样,过去十年中许多计算机视觉任务的解决方案在很大程度上依赖于滑动窗口和完全卷积的范式。如果缺乏ConvNet的归纳偏差,纯粹的ViT模型在作为通用视觉骨干时面临许多挑战。最大的挑战是ViT的全局注意力设计,它与输入尺寸的平方复杂度成正比。这对于ImageNet分类可能还可以接受,但对于更高分辨率的输入,快速变得难以处理。

分层Transformer采用混合方法来弥合这一差距。例如,将“滑动窗口”策略(例如在局部窗口内使用注意力)重新引入到Transformers中,使其行为更类似于ConvNets。Swin Transformer [45]是在这个方向上的里程碑式工作,首次证明了Transformers可以作为通用视觉骨干,并在图像分类之外的一系列计算机视觉任务中实现了最先进的性能。Swin Transformer的成功和迅速应用也揭示了一件事:卷积的本质并没有变得无关,而是仍然非常受欢迎,从未衰退。

从这个角度来看,对于计算机视觉中的Transformers的许多进展旨在重新引入卷积。然而,这些尝试是有代价的:一种简单的滑动窗口自注意力的实现可能非常昂贵[55];通过使用先进的方法(例如循环移位)可以优化速度,但系统的设计变得更复杂。另一方面,几乎具有讽刺意味的是,卷积神经网络已经满足了许多期望的属性,尽管方式简单、无装饰。卷积神经网络似乎正在失去流行的原因仅仅是(hierarchical) Transformers在许多视觉任务上超过了它们,而性能差异通常归因于Transformers的卓越扩展性行为,其中多头自注意力是关键组成部分。

与过去十年逐步改进的ConvNets不同,Vision Transformers的采用是一个飞跃。在最近的文献中,通常使用系统级比较(例如Swin Transformer vs. ResNet)来对比这两者。ConvNets和分层视觉Transformers在某种程度上变得不同又相似:它们都具备类似的归纳偏差,但在训练过程和宏观/微观级别的架构设计上存在显著差异。在这项工作中,我们研究了ConvNets和Transformers之间的架构区别,并试图确定在比较网络性能时的混淆变量。我们的研究旨在弥合ViT之前和之后的ConvNets之间的差距,并测试纯粹ConvNet的潜力。

为此,我们从标准的ResNet(例如ResNet-50)开始,采用改进的方法进行训练。我们逐步“现代化”架构,构建了一个分层视觉Transformer(例如Swin-T)。我们的探索受到一个关键问题的指导:Transformer中的设计决策如何影响ConvNets的性能?在这个过程中,我们发现了几个对性能差异起作用的关键组件。因此,我们提出了一个名为ConvNeXt的纯粹ConvNets家族。我们在各种视觉任务上对ConvNeXt进行评估,如ImageNet分类[17]、COCO上的目标检测/分割[44]和ADE20K上的语义分割[92]。令人惊讶的是,完全由标准的ConvNet模块构建的ConvNeXt,在准确性、可扩展性和稳健性方面与Transformers相比,竞争力优势明显,并且完全卷积的性质使其在训练和测试中非常简单易用。

我们希望这些新的观察和讨论能够挑战一些常见的观点,并鼓励人们重新思考卷积在计算机视觉中的重要性。

2. 现代化的ConvNet:一条路线图

在本节中,我们提供了一条从ResNet到类似Transformers的ConvNet的轨迹。我们考虑了两种FLOPs模型大小,一种是具有约

4.5

×

1

0

9

4.5×10^9

4.5×109 FLOPs的ResNet-50 / Swin-T模式,另一种是具有约

15.0

×

1

0

9

15.0×10^9

15.0×109 FLOPs的ResNet-200 / Swin-B模式。为简单起见,我们将以ResNet-50 / Swin-T复杂度模型呈现结果。更高容量模型的结论是一致的,并且结果可以在附录C中找到。

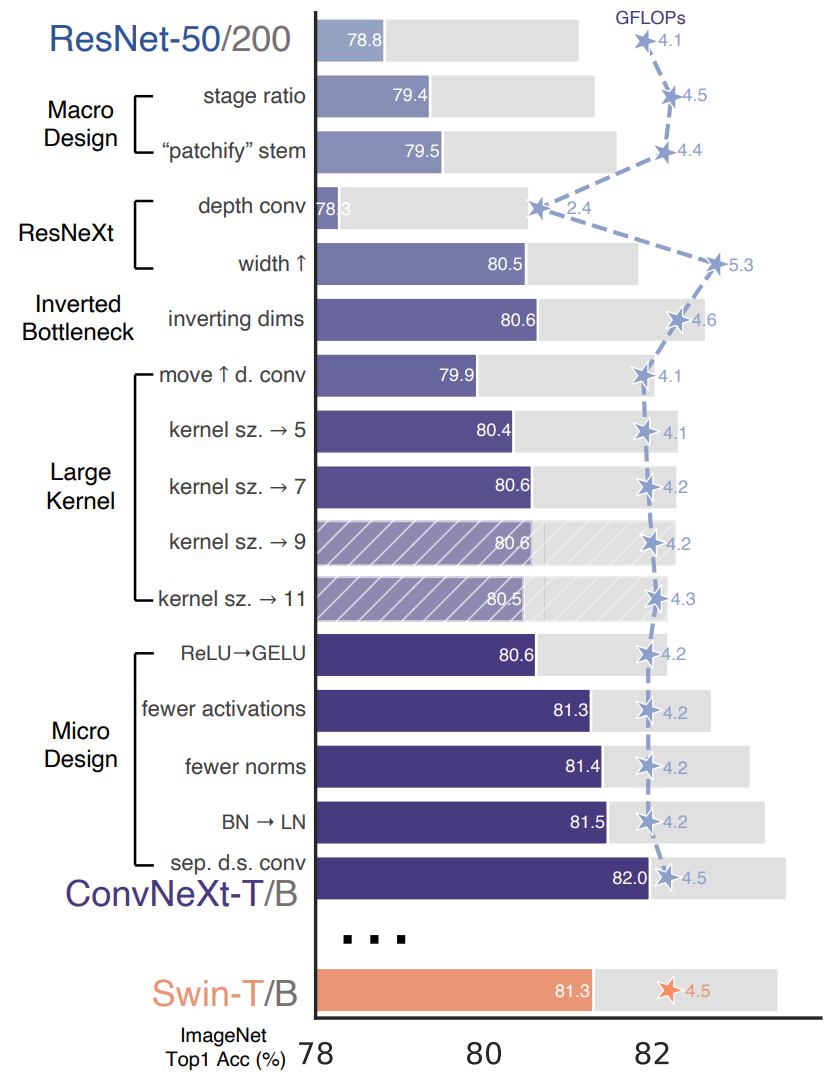

图2。我们将标准ConvNet (ResNet) 现代化为分层视觉Transformer (Swin)的设计,而不引入任何基于注意力的模块。前景条显示了ResNet-50/Swin-T FLOP模型精度;灰色条显示的是ResNet-200/Swin-B模式下的结果。斜杠的条形表示没有采用修改。两种模式的详细结果在附录中。许多Transformer架构选择可以被纳入ConvNet中,并且它们导致越来越好的性能表现。最终,我们的纯ConvNet模型,名为ConvNeXt,在性能上可以胜过Swin Transformer。

在较高层次上,我们的探索旨在研究并跟随Swin Transformer的不同设计层次,同时保持网络作为标准ConvNet的简单性。我们的探索路线如下所示。我们的起点是一个ResNet-50模型。我们首先使用类似于训练视觉Transformers的训练技术对其进行训练,并相对于原始的ResNet-50获得了大幅改进的结果。这将成为我们的基准线。然后,我们研究一系列设计决策,我们将其总结为1)宏观设计,2)ResNeXt,3)反向瓶颈,4)大内核尺寸和5)各种层面的微观设计。在图2中,我们展示了“网络现代化”的每个步骤中我们能够实现的过程和结果。

由于网络复杂性与最终性能密切相关,FLOPs在探索过程中大致上得到控制,尽管在中间步骤中,FLOPs可能高于或低于参考模型。所有模型均在ImageNet-1K上进行训练和评估。

2.1. 训练技术

除了网络架构的设计外,训练过程还会影响最终的性能。视觉Transformer不仅带来了一套新的模块和架构设计决策,还引入了不同的训练技术(例如AdamW优化器)来应用于视觉任务。这主要涉及优化策略和相关的超参数设置。因此,我们探索的第一步是使用视觉Transformer的训练过程来训练一个基准模型,即ResNet-50/200。最近的研究表明,一系列现代化的训练技术可以显著提升简单的ResNet-50模型的性能。在我们的研究中,我们使用了接近DeiT [73]和Swin Transformer [45]的训练方法。我们将训练的轮数从ResNet的原始90轮延长到300轮。我们使用AdamW优化器[46],数据增强技术如Mixup [90],Cutmix [89],RandAugment [14],Random Erasing [91],以及正则化方法包括Stochastic Depth [36]和Label Smoothing [69]。我们使用的完整超参数集合可以在附录A.1中找到。这种增强的训练方法使ResNet-50模型的性能从76.1% [1]提高到78.8%(+2.7%),这意味着传统的卷积神经网络和视觉Transformer之间的性能差异的很大一部分可能是由于训练技术的不同。在整个“现代化”过程中,我们将使用这个固定的训练方法和相同的超参数。ResNet-50模型的每个报告的准确率都是通过使用三个不同的随机种子训练得到的平均值。

2.2. 宏观设计

我们现在分析Swin Transformers的宏观网络设计。Swin Transformers采用ConvNets [28, 65] 的多阶段设计,每个阶段具有不同的特征图分辨率。设计考虑了两个有趣的因素:阶段计算比例和“干细胞”结构。

改变阶段计算比例。ResNet中阶段之间计算分布的原始设计主要是经验性的。沉重的“res4”阶段旨在与目标检测等下游任务兼容,其中检测器头部操作在14x14的特征平面上。而Swin-T遵循相同的原则,但略微不同的阶段计算比例为1:1:3:1。对于更大的Swin Transformers,比例为1:1:9:1。根据设计,我们将ResNet-50中每个阶段的块数从(3, 4, 6, 3)调整为(3, 3, 9, 3),这也使得FLOPs与Swin-T对齐。这将模型的准确性从78.8%提高到79.4%。值得注意的是,研究人员已经对计算分布进行了全面的研究 [53, 54],可能存在更优的设计。

从现在开始,我们将采用这种阶段计算比例。

将stem改为“Patchify”。通常,stem单元设计关注的是如何在网络起始处处理输入图像。由于自然图像固有的冗余性,标准ConvNets和视觉Transformer中的共同stem单元将强烈下采样输入图像以获得适当的特征映射大小。标准ResNet的stem单元包括一个7x7步幅为2的卷积层,后跟一个最大池化,导致输入图像的4倍下采样。在视觉Transformers中,采用了更加激进的“patchify”策略作为stem单元,对应于较大的内核大小(例如,内核大小=14或16)和非重叠卷积。Swin Transformer使用类似的“patchify”层,但使用较小的块大小4来适应该架构的多阶段设计。我们使用一个4x4、步幅为4的卷积层实现patchify层替换ResNet风格的stem单元。准确度从79.4%提高到79.5%。这表明ResNet的stem单元可以被类似ViT的更简单的“patchify”层所替代,从而实现类似的性能。

我们将在网络中使用“patchify stem” (4x4非重叠卷积)。

2.3. ResNeXt-ify

在这部分中,我们尝试采用ResNeXt的思想[87],它在FLOPs/准确性权衡方面比普通的ResNet更好。其核心组件是分组卷积,其中卷积滤波器被分成不同的组。从高层次上讲,ResNeXt的指导原则是“使用更多的组,扩展宽度”。更具体地说,ResNeXt在瓶颈块的3×3卷积层中采用了分组卷积。由于这显著减少了FLOPs,网络宽度扩展以补偿容量损失。

在我们的情况下,我们使用深度卷积,这是分组卷积的一种特殊情况,其中组数等于通道数。深度卷积已经被MobileNet [34]和Xception [11]广泛使用。我们注意到深度卷积类似于自注意力中的加权求和操作,它在每个通道上操作,即只在空间维度中混合信息。深度卷积和1×1卷积的组合导致了空间和通道混合的分离,这是视觉Transformer的一个共享属性,其中每个操作都在空间或通道维度上混合信息,但不会同时混合。深度卷积的使用有效地减少了网络的FLOPs,并且如预期的那样降低了准确性。根据ResNeXt提出的策略,我们将网络宽度增加到与Swin-T相同的通道数(从64增加到96)。这使得网络性能达到了80.5%,但FLOPs也增加了(5.3G)。

现在我们将采用ResNeXt设计。

2.4. 倒置瓶颈

在每个Transformer块中,一个重要的设计是创建一个倒置的瓶颈,即MLP块的隐藏维度比输入维度宽4倍(参见图4)。有趣的是,这种Transformer设计与卷积神经网络中使用的扩张比例为4的倒置瓶颈设计有关。这个想法由MobileNetV2 [61]提出,并在几种先进的卷积神经网络架构 [70, 71]中得到了广泛应用。

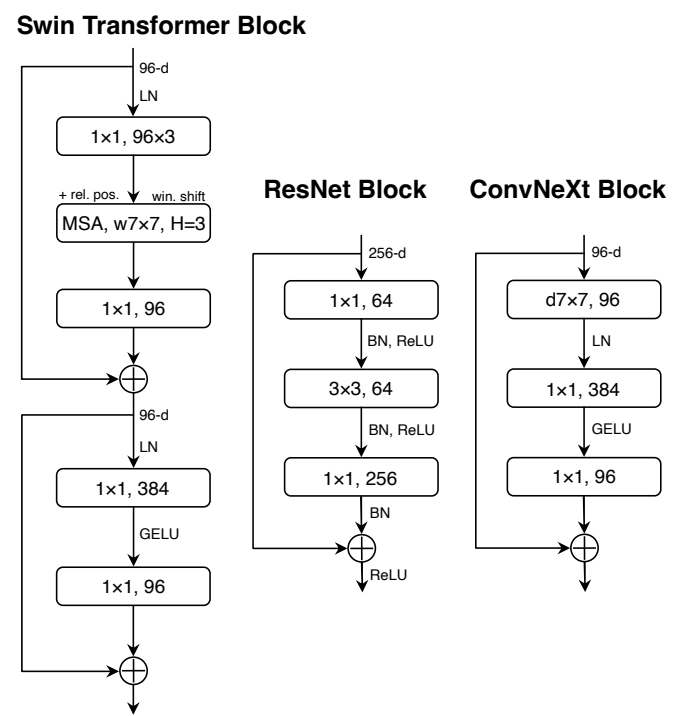

图3。块的修改和结果规格。(a) 是一个ResNeXt block;在(b)中,我们创建了一个倒置瓶颈块,©中空间深度卷积层的位置上移

图3。块的修改和结果规格。(a) 是一个ResNeXt block;在(b)中,我们创建了一个倒置瓶颈块,©中空间深度卷积层的位置上移

在这里,我们探索倒置瓶颈设计。图3 (a) 到 (b)展示了配置。尽管深度卷积层的FLOPs增加了,但由于下采样残差块的快捷方式1⇥1卷积层的显著FLOPs减少,整个网络的FLOPs减少到了4.6G。有趣的是,这导致了轻微的性能提升(从80.5%到80.6%)。在ResNet-200 / Swin-B模式下,这一步带来了更大的收益(从81.9%到82.6%),同时降低了FLOPs。

我们现在将使用倒置瓶颈。

2.5. 大内核尺寸

在这一部分的探索中,我们关注大型卷积核的行为。视觉Transformer最显著的特点之一是它们的非局部自注意力机制,使得每一层都具有全局感受野。虽然在过去的卷积神经网络中使用过大的卷积核尺寸 [40, 68],但VGGNet [65]所普及的黄金标准是堆叠小尺寸(3⇥3)的卷积层,这在现代GPU上有高效的硬件实现 [41]。尽管Swin Transformer重新引入了自注意块的局部窗口,但窗口大小至少是7⇥7,远大于ResNe(X)t的3⇥3内核尺寸。在这里,我们重新审视在卷积神经网络中使用大内核尺寸的问题。

向上移动深度卷积层。为了探索大内核,首先要求将深度卷积层的位置向上移动(从图3 (b) 到 ©)。这也是Transformer中明显的设计决策:在MLP层之前放置MSA块。由于我们有一个倒置的瓶颈块,这是一个自然的设计选择——复杂/低效的模块(MSA,大内核卷积)将具

增加卷积核大小。通过所有这些准备措施,采用更大的核大小卷积的好处是显着的。我们尝试了几种核大小,包括3、5、7、9和11。网络的性能从79.9%(3x3)提高到80.6%(7x7),而网络的FLOPs保持大致不变。此外,我们观察到更大的核大小的好处在7×7处达到饱和点。我们还在大容量模型中验证了这种行为:当我们将核大小增加到7x7之外时,ResNet-200架构模型不会出现进一步的改进。

我们将在每个块中使用7x7深度可分离卷积。

目前,我们已经完成了对网络架构的宏观考察。有趣的是,视觉Transformer中采取的许多设计选择可以映射到ConvNet实例化中。

2.6. 微观设计

在本节中,我们将在微观尺度上调查几种其他的架构差异,大多数探索都是在层级上进行的,重点是激活函数和归一化层的具体选择。

用GELU替代ReLU 在NLP和视觉架构之间的一个差异是使用哪种激活函数的具体细节。随着时间的推移,已经开发出许多激活函数,但由于其简单性和高效性,修正线性单元(ReLU)[49]仍然广泛应用于卷积神经网络中。ReLU也在原始Transformer论文[77]中作为激活函数使用。高斯误差线性单元(GELU)[32]可以看作是ReLU的平滑变体,它在最先进的Transformer模型中使用,包括Google的BERT[18]、OpenAI的GPT-2[52]和最近的ViTs。我们发现在我们的卷积网络中可以用GELU替代ReLU,尽管准确性保持不变(80.6%)。

图4。ResNet、Swin Transformer和ConvNeXt的块设计。由于存在多个专门的模块和两个残差连接,Swin Transformer的块更为复杂。为了简单起见,我们将Transformer MLP块中的线性层也作为“1x1卷积”进行记录,因为它们是等效的。

更少的激活函数。 Transformer和ResNet块之间的一个小区别是Transformer具有较少的激活函数。考虑一个带有键/查询/值线性嵌入层、投影层和MLP块中的两个线性层的Transformer块。在MLP块中只有一个激活函数。相比之下,通常的做法是在每个卷积层(包括1⇥1卷积层)之后添加激活函数。在这里,我们研究了当我们坚持相同策略时性能的变化。如图4所示,我们在残差块中消除了除两个1⇥1层之间的一个之外的所有GELU层,模仿了Transformer块的风格。这个过程将结果提高了0.7%,达到81.3%,实际上与Swin-T的性能相匹配。我们将在每个块中使用一个GELU激活函数。

减少归一化层

Transformer块通常也具有较少的归一化层。在这里,我们删除了两个批归一化(BN)层,只保留一个BN层在卷积的1⇥1层之前。这进一步提升了性能,达到81.4%,已经超过Swin-T的结果。请注意,我们每个块的归一化层数比Transformer还要少,因为根据经验,我们发现在块的开头再添加一个BN层不会提高性能。

用LN替换BN

批归一化(BN)在ConvNet中是一个基本组件,它改善了收敛性并减少了过拟合。然而,BN也有许多细微之处,可能对模型的性能产生不利影响。已经有许多尝试开发替代归一化技术的方法,但在大多数视觉任务中,BN仍然是首选选项。另一方面,简单的层归一化(LN)在Transformer中被广泛使用,在不同的应用场景中都有良好的性能。直接将LN替换BN在原始的ResNet中会导致性能下降。通过对网络架构和训练技术进行修改,我们重新评估了在BN的位置使用LN的影响。我们观察到我们的ConvNet模型使用LN没有任何困难;实际上,性能稍微更好,准确率达到81.5%。从现在开始,我们将在每个残差块中使用一个LayerNorm作为归一化的选择。

分离下采样层

在ResNet中,通过每个阶段开始的残差块使用3⇥3卷积和步幅为2来实现空间下采样(在快捷连接处使用1⇥1卷积和步幅为2)。在Swin Transformer中,在每个阶段之间添加了一个单独的下采样层。我们尝试了类似的策略,使用2⇥2卷积层和步幅2来实现空间下采样。这一修改意外地导致训练发散。进一步的研究表明,在空间分辨率发生变化的地方添加归一化层可以帮助稳定训练。这些归一化层包括在Swin Transformer中使用的几个LN层:一个在每个下采样层之前,一个在主干网络之后,一个在最终的全局平均池化之后。我们可以将准确率提高到82.0%,显著超过Swin-T的81.3%。我们将使用单独的下采样层。这带我们来到我们的最终模型,我们将其称为ConvNeXt。ResNet、Swin和ConvNeXt块结构的比较可以在图4中找到。ResNet-50、Swin-T和ConvNeXt-T的详细架构规格比较可以在表9中找到。

总结与展望。我们已经完成了第一轮的研究,并发现了ConvNeXt,一个纯粹的ConvNet,在ImageNet-1K分类任务中能够超越Swin Transformer。值得注意的是,迄今为止讨论的所有设计选择都是从视觉Transformer中改编而来的。此外,即使在ConvNet的文献中,这些设计并不是新颖的,它们在过去的十年中已经分别进行了研究,但没有被综合起来。我们的ConvNeXt模型在计算量、参数数量、吞吐量和内存使用方面与Swin Transformer大致相同,但不需要像移位窗口注意力或相对位置偏差这样的专用模块。

这些发现是令人鼓舞的,但尚未完全令人信服——我们迄今为止的探索仅限于小规模,而视觉Transformer的扩展行为才是真正区别它们的因素。此外,ConvNet是否能够在目标检测和语义分割等下游任务中与Swin Transformer竞争,是计算机视觉从业者的一个核心关注点。在下一节中,我们将在数据规模和模型大小方面扩展我们的ConvNeXt模型,并在各种视觉识别任务上进行评估。

3. ImageNet的经验评估

我们构建了不同的ConvNeXt变量,ConvNeXt-T/S/B/L,以与Swin-T/S/B/L [45]具有相似的复杂度。

ConvNeXt-T/B是对ResNet-50/200体制进行“现代化”处理的终端产品。此外,我们构建了一个更大的ConvNeXt-XL来进一步测试ConvNeXt的可伸缩性。这些变体仅在每个阶段的通道数量C和块数量B方面有所不同。与ResNets和Swin Transformers一样,通道数量在每个新阶段都会翻倍。我们以下面的配置总结:

- ConvNeXt-T: C = (96, 192, 384, 768), B = (3, 3, 9, 3)

- ConvNeXt-S: C = (96, 192, 384, 768), B = (3, 3, 27, 3)

- ConvNeXt-B: C = (128, 256, 512, 1024), B = (3, 3, 27, 3)

- ConvNeXt-L: C = (192, 384, 768, 1536), B = (3, 3, 27, 3)

- ConvNeXt-XL: C = (256, 512, 1024, 2048), B = (3, 3, 27, 3)

我们在验证集上报告了ImageNet-1K的top-1准确率。我们还对ImageNet-22K进行了预训练,这是一个包含21841个类别(1000个ImageNet-1K类别的超集)和约14M张图像的更大数据集,然后在ImageNet-1K上微调预训练模型进行评估。我们使用2242分辨率进行预训练,并使用2242和3842分辨率进行微调。详细的训练设置可以在附录A中找到。

3.1. 结果

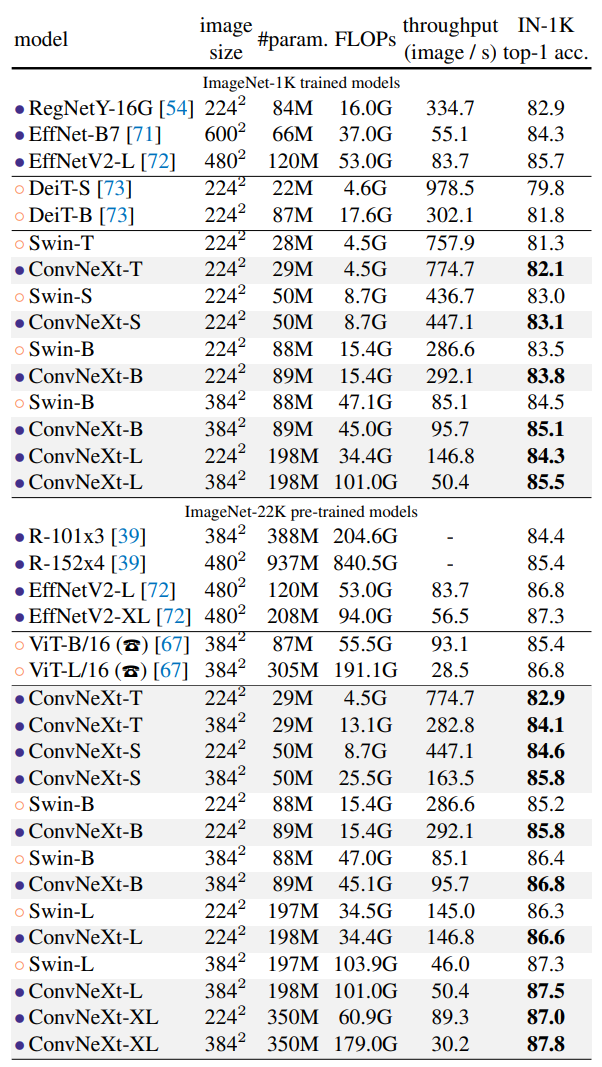

ImageNet-1K。表1(上部分)显示了与最近两个Transformer变体DeiT [73] 和Swin Transformers [45]以及来自网络结构搜索的两个ConvNets-RegNets [54]、EfficientNets [71]和EfficientNetsV2 [72]的结果比较。在准确度-计算量的权衡和推理速度方面,ConvNeXt与两个强大的ConvNet基线(RegNet [54]和EfficientNet [71])相比具有竞争力,同时也优于具有类似复杂性的 Swin Transformer,在一些方面甚至表现更好(例如,对于ConvNeXt-T, 0.8%以上)。与Swin Transformers相比,ConvNeXts并未使用专用模块,例如移位窗口或相对位置偏差,其推理速度也有所提升。结果的一个亮点是3842的ConvNeXt-B模型:它优于Swin-B 0.6%(85.1% vs. 84.5%),但其推理吞吐量高出12.5%(95.7 vs. 85.1 image/s)。我们注意到,当分辨率从2242提高到3842时,ConvNeXt-B相比Swin-B在FLOPs/吞吐量方面的优势变得更加明显。此外,我们还观察到将ConvNeXt进一步扩展到ConvNeXt-L时有85.5%的改善。

ImageNet-22K。我们在表1(下部分)展示了由ImageNet-22K预训练微调的模型的结果。这些实验很重要,因为普遍认为视觉Transfomers具有较少的归纳偏差,因此在大规模预训练的情况下性能可能会优于ConvNets。我们的结果证明,经过适当设计的ConvNets在使用大型数据集进行预训练时并不逊于视觉Transformers,ConvNeXts仍然与大小相似的Swin Transformers表现相当甚至更好,同时取得稍微更高的吞吐率。此外,我们的ConvNeXt-XL模型在达到87.8%的准确率时,比3842的ConvNeXt-L有了不错的改进,证明ConvNeXts是可扩展的架构。

表1。ImageNet-1K上的分类准确率。类似于Transformer,ConvNeXt也显示出具有更高容量模型和更大(预训练)数据集的有前途的扩展行为。 推断吞吐量在V100 GPU上进行测量,遵循[45]。 在A100 GPU上, ConvNeXt的吞吐量可以比Swin Transformer高得多。 详见附录E。(T)ViT结果采用90轮AugReg [67] 训练,作者通过个人交流提供。

在ImageNet-1K上,使用高级模块(例如Squeeze-and-Excitation [35])和渐进训练过程配备搜索后得到的EfficientNetV2-L获得最佳表现。但使用ImageNet-22K进行预训练后,ConvNeXt能够胜过EfficientNetV2 ,进一步证明大规模训练的重要性。

在附录B中,我们还讨论了ConvNeXt的鲁棒性和域外泛化结果。

3.2. 同质性的 ConvNeXt 与 ViT

在这个剖析中,我们将研究我们的 ConvNeXt 块设计是否适用于没有下采样层并在所有深度上保持相同特征分辨率(例如 14x14)的 ViT 风格[20] 同质性架构。我们构建了与 ViT-S/B/L(384/768/1024)具有相同特征维度的同质性 ConvNeXt-S/B/L。深度设置为 18/18/36,以匹配参数数量和 FLOPs。块结构保持不变(图 4)。我们使用 DeiT[73] 对 ViT-S/B 进行有监督训练,并使用 MAE[26] 对 ViT-L 进行有监督训练,因为它们采用了改进的训练流程,优于原始的 ViT[20]。ConvNeXt 模型的训练设置与之前相同,但是增加了更长的预热周期。ImageNet-1K 在 2242 分辨率下的结果如表 2 所示。我们观察到 ConvNeXt 在与 ViT 相当的性能上表现良好,表明我们的 ConvNeXt 块设计在非层次化模型中具有竞争力。

表2。比较各向同性的ConvNeXt和ViT。训练内存在每个GPU批次大小为32的V100 GPU上进行测量。

表3。使用Mask-RCNN和Cascade Mask-RCNN进行的COCO目标检测和分割结果。 ‡表示该模型已在ImageNet-22K上预训练。 ImageNet-1K预训练的Swin的结果来自其Github存储库[3]。 ResNet-50和X101模型的AP数为[45]。我们在A100 GPU上测量FPS。使用图像大小(1280, 800)计算FLOPs。

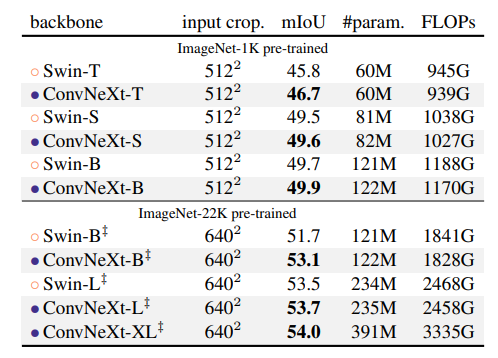

表4。使用UperNet [85]进行的ADE20K验证结果。‡表示IN-22K预训练。Swins的结果来自其GitHub存储库[2]。与Swin一样,我们报告具有多尺度测试的mIoU结果。基于输入尺寸(2048,512)和(2560,640),分别计算IN-1K和IN-22K预训练模型的FLOPs。

4. 下游任务的经验性评估

在 COCO 数据集上进行目标检测和语义分割。我们使用 ConvNeXt 骨干网络对 Mask R-CNN[27] 和级联 Mask R-CNN[9] 进行微调。遵循 Swin Transformer[45] 的做法,我们使用多尺度训练、AdamW 优化器和 3x 学习率衰减策略。更多细节和超参数设置可以在附录 A.3 中找到。

表格 3 展示了 Swin Transformer、ConvNeXt 和传统的 ConvNet(如 ResNeXt)在目标检测和实例分割方面的结果对比。在不同的模型复杂度下,ConvNeXt 在性能上与 Swin Transformer 相当或更好。当扩展到在 ImageNet-22K 上预训练的更大模型(ConvNeXt-B/L/XL)时,在盒子和掩膜的 AP 方面,ConvNeXt 在很多情况下明显优于 Swin Transformer(例如 +1.0 AP)。

ADE20K 上的语义分割。我们还使用 UperNet[85] 在 ADE20K 语义分割任务上评估了 ConvNeXt 骨干网络。所有模型变体在批量大小为 16 的情况下进行了 160K 次迭代的训练。其他实验设置遵循[6](更多细节请参见附录 A.3)。在表格 4 中,我们报告了多尺度测试下的验证 mIoU。ConvNeXt 模型在不同的模型容量下都可以达到竞争性的性能,进一步验证了我们的架构设计的有效性。

关于模型效率的备注。在相似的 FLOPs 情况下,深度可分卷积模型已知比仅包含密集卷积的 ConvNet 更慢且消耗更多内存。自然而然地会问 ConvNeXt 的设计是否会使其在实际中变得低效。正如本文中所展示的,ConvNeXt 的推理吞吐量与 Swin Transformers 相当或超过它们。这对于分类和需要更高分辨率输入的其他任务都是如此(请参见表格 1、3 以获取吞吐量/帧速率的比较)。此外,我们注意到训练 ConvNeXt 模型所需的内存比训练 Swin Transformers 更少。例如,使用 ConvNeXt-B 骨干训练级联 Mask-RCNN 时,每个 GPU 批量大小为 2,峰值内存消耗为 17.4GB,而 Swin-B 的参考值为 18.5GB。

5. 相关工作

混合模型。在 ViT 时代之前和之后,结合卷积和自注意力的混合模型一直受到研究者的关注。在 ViT 之前,重点是通过引入自注意力/非本地模块 [8, 55, 66, 79] 来增强 ConvNet 的能力以捕捉长距离的依赖关系。原始的 ViT [20] 首先研究了混合配置,并且大量的后续工作集中于重新引入卷积先验到 ViT 中,无论是显式的 [15, 16, 21, 82, 86, 88] 还是隐式的 [45] 方式。

最近的基于卷积的方法。韩等人[25]表明,局部Transformer自注意力等价于不匀深度卷积。Swin中的MSA块被动态或规则深度卷积所取代,从而实现了与Swin相当的性能。同时进行的ConvMixer [4]演示了,在小规模情况下,深度卷积可以用作一种有前途的混合策略。ConvMixer使用更小的补丁尺寸来达到最佳结果,使吞吐量比其他基线要低得多。GFNet [56]采用快速傅里叶变换(FFT)进行令牌混合。FFT也是一种卷积形式,但其具有全局核大小和环形填充。与许多最近的Transformer或ConvNet设计不同,我们研究的一个主要目标是深入了解现代化标准ResNet的过程,并实现最先进的性能。

6. 结论

在2020年代,特别是分层的视觉Transformer(如Swin Transformer),开始取代ConvNets成为通用视觉骨干网络首选。广泛认为,相较于ConvNets, 视觉Transformers更加准确、高效且可扩展。我们提出 ConvNeXts,这是一个纯ConvNet模型,在多个计算机视觉基准测试中可以与最先进的分层视觉Transformers竞争,并保持标准ConvNets的简单性和高效性。某些方面上,我们的观察结果是令人惊讶的,而我们的ConvNeXt模型本身并不是完全新颖的——过去十年中已经分别考虑了许多设计选择,但没有全部综合起来。我们希望在本研究中获得的新结果将挑战几个普遍存在的观点,并激发人们重新思考卷积在计算机视觉中的重要性。

致谢

我们感谢Kaiming He, Eric Mintun, Xingyi Zhou, Ross Girshick和Yann LeCun对有价值的讨论与反馈。本工作得到DoD的部分支持,包括DARPA 's XAI, LwLL和/或SemaFor计划,以及BAIR’s的工业联盟计划。

References

[1] PyTorch Vision Models. https://pytorch.org/

vision/stable/models.html. Accessed: 2021-10-

01.

[2] GitHub repository: Swin transformer. https://github.

com/microsoft/Swin-Transformer, 2021.

[3] GitHub repository: Swin transformer for object detection.

https://github.com/SwinTransformer/SwinTransformer-Object-Detection, 2021.

[4] Anonymous. Patches are all you need? Openreview, 2021.

[5] Jimmy Lei Ba, Jamie Ryan Kiros, and Geoffrey E Hinton.

Layer normalization. arXiv:1607.06450, 2016.

[6] Hangbo Bao, Li Dong, and Furu Wei. BEiT: BERT pretraining of image transformers. arXiv:2106.08254, 2021.

[7] Irwan Bello, William Fedus, Xianzhi Du, Ekin Dogus Cubuk,

Aravind Srinivas, Tsung-Yi Lin, Jonathon Shlens, and Barret

Zoph. Revisiting resnets: Improved training and scaling

strategies. NeurIPS, 2021.

[8] Irwan Bello, Barret Zoph, Ashish Vaswani, Jonathon Shlens,

and Quoc V Le. Attention augmented convolutional networks.

In ICCV, 2019.

[9] Zhaowei Cai and Nuno Vasconcelos. Cascade R-CNN: Delving into high quality object detection. In CVPR, 2018.

[10] Kai Chen, Jiaqi Wang, Jiangmiao Pang, Yuhang Cao, Yu

Xiong, Xiaoxiao Li, Shuyang Sun, Wansen Feng, Ziwei Liu,

Jiarui Xu, Zheng Zhang, Dazhi Cheng, Chenchen Zhu, Tianheng Cheng, Qijie Zhao, Buyu Li, Xin Lu, Rui Zhu, Yue

Wu, Jifeng Dai, Jingdong Wang, Jianping Shi, Wanli Ouyang,

Chen Change Loy, and Dahua Lin. MMDetection: Open

mmlab detection toolbox and benchmark. arXiv:1906.07155,

2019.

[11] François Chollet. Xception: Deep learning with depthwise

separable convolutions. In CVPR, 2017.

[12] Kevin Clark, Minh-Thang Luong, Quoc V Le, and Christopher D Manning. ELECTRA: Pre-training text encoders as

discriminators rather than generators. In ICLR, 2020.

[13] MMSegmentation contributors. MMSegmentation: Openmmlab semantic segmentation toolbox and benchmark. https:

/ / github . com / open - mmlab / mmsegmentation,

2020.

[14] Ekin D Cubuk, Barret Zoph, Jonathon Shlens, and Quoc V

Le. Randaugment: Practical automated data augmentation

with a reduced search space. In CVPR Workshops, 2020.

[15] Zihang Dai, Hanxiao Liu, Quoc V Le, and Mingxing Tan.

Coatnet: Marrying convolution and attention for all data sizes.

NeurIPS, 2021.

[16] Stéphane d’Ascoli, Hugo Touvron, Matthew Leavitt, Ari Morcos, Giulio Biroli, and Levent Sagun. ConViT: Improving

vision transformers with soft convolutional inductive biases.

ICML, 2021.

[17] Jia Deng, Wei Dong, Richard Socher, Li-Jia Li, Kai Li, and Li

Fei-Fei. ImageNet: A large-scale hierarchical image database.

In CVPR, 2009.

[18] Jacob Devlin, Ming-Wei Chang, Kenton Lee, and Kristina

Toutanova. BERT: Pre-training of deep bidirectional transformers for language understanding. In NAACL, 2019.

[19] Piotr Dollár, Serge Belongie, and Pietro Perona. The fastest

pedestrian detector in the west. In BMVC, 2010.

[20] Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov,

Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner,

Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit, and Neil Houlsby. An image is

worth 16x16 words: Transformers for image recognition at

scale. In ICLR, 2021.

[21] Haoqi Fan, Bo Xiong, Karttikeya Mangalam, Yanghao Li,

Zhicheng Yan, Jitendra Malik, and Christoph Feichtenhofer.

Multiscale vision transformers. ICCV, 2021.

[22] Vitaly Fedyunin. Tutorial: Channel last memory format

in PyTorch. https://pytorch.org/tutorials/

intermediate/memory_format_tutorial.html,

2021. Accessed: 2021-10-01.

[23] Ross Girshick. Fast R-CNN. In ICCV, 2015.

[24] Ross Girshick, Jeff Donahue, Trevor Darrell, and Jitendra

Malik. Rich feature hierarchies for accurate object detection

and semantic segmentation. In CVPR, 2014.

[25] Qi Han, Zejia Fan, Qi Dai, Lei Sun, Ming-Ming Cheng, Jiaying Liu, and Jingdong Wang. Demystifying local vision

transformer: Sparse connectivity, weight sharing, and dynamic weight. arXiv:2106.04263, 2021.

[26] Kaiming He, Xinlei Chen, Saining Xie, Yanghao Li, Piotr

Dollár, and Ross Girshick. Masked autoencoders are scalable

vision learners. arXiv:2111.06377, 2021.

[27] Kaiming He, Georgia Gkioxari, Piotr Dollár, and Ross Girshick. Mask R-CNN. In ICCV, 2017.

[28] Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun.

Deep residual learning for image recognition. In CVPR, 2016.

[29] Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun.

Identity mappings in deep residual networks. In ECCV, 2016.

[30] Dan Hendrycks, Steven Basart, Norman Mu, Saurav Kadavath, Frank Wang, Evan Dorundo, Rahul Desai, Tyler Zhu,

Samyak Parajuli, Mike Guo, et al. The many faces of robustness: A critical analysis of out-of-distribution generalization.

In ICCV, 2021.

[31] Dan Hendrycks and Thomas Dietterich. Benchmarking neural

network robustness to common corruptions and perturbations.

In ICLR, 2018.

[32] Dan Hendrycks and Kevin Gimpel. Gaussian error linear

units (gelus). arXiv:1606.08415, 2016.

[33] Dan Hendrycks, Kevin Zhao, Steven Basart, Jacob Steinhardt,

and Dawn Song. Natural adversarial examples. In CVPR,

2021.

[34] Andrew G Howard, Menglong Zhu, Bo Chen, Dmitry

Kalenichenko, Weijun Wang, Tobias Weyand, Marco Andreetto, and Hartwig Adam. MobileNets: Efficient convolutional neural networks for mobile vision applications.

arXiv:1704.04861, 2017.

[35] Jie Hu, Li Shen, and Gang Sun. Squeeze-and-excitation

networks. In CVPR, 2018.

[36] Gao Huang, Zhuang Liu, Laurens van der Maaten, and Kilian Q Weinberger. Densely connected convolutional networks.

In CVPR, 2017.

[37] Gao Huang, Yu Sun, Zhuang Liu, Daniel Sedra, and Kilian Q

Weinberger. Deep networks with stochastic depth. In ECCV,

2016

[38] Sergey Ioffe. Batch renormalization: Towards reducing minibatch dependence in batch-normalized models. In NeurIPS,

2017.

[39] Alexander Kolesnikov, Lucas Beyer, Xiaohua Zhai, Joan

Puigcerver, Jessica Yung, Sylvain Gelly, and Neil Houlsby.

Big Transfer (BiT): General visual representation learning. In

ECCV, 2020.

[40] Alex Krizhevsky, Ilya Sutskever, and Geoff Hinton. Imagenet

classification with deep convolutional neural networks. In

NeurIPS, 2012.

[41] Andrew Lavin and Scott Gray. Fast algorithms for convolutional neural networks. In CVPR, 2016.

[42] Yann LeCun, Bernhard Boser, John S Denker, Donnie Henderson, Richard E Howard, Wayne Hubbard, and Lawrence D

Jackel. Backpropagation applied to handwritten zip code

recognition. Neural computation, 1989.

[43] Yann LeCun, Léon Bottou, Yoshua Bengio, Patrick Haffner,

et al. Gradient-based learning applied to document recognition. Proceedings of the IEEE, 1998.

[44] Tsung-Yi Lin, Michael Maire, Serge Belongie, James Hays,

Pietro Perona, Deva Ramanan, Piotr Dollár, and C Lawrence

Zitnick. Microsoft COCO: Common objects in context. In

ECCV. 2014.

[45] Ze Liu, Yutong Lin, Yue Cao, Han Hu, Yixuan Wei, Zheng

Zhang, Stephen Lin, and Baining Guo. Swin transformer:

Hierarchical vision transformer using shifted windows. 2021.

[46] Ilya Loshchilov and Frank Hutter. Decoupled weight decay

regularization. In ICLR, 2019.

[47] Xiaofeng Mao, Gege Qi, Yuefeng Chen, Xiaodan Li, Ranjie

Duan, Shaokai Ye, Yuan He, and Hui Xue. Towards robust

vision transformer. arXiv preprint arXiv:2105.07926, 2021.

[48] Eric Mintun, Alexander Kirillov, and Saining Xie. On interaction between augmentations and corruptions in natural

corruption robustness. NeurIPS, 2021.

[49] Vinod Nair and Geoffrey E Hinton. Rectified linear units

improve restricted boltzmann machines. In ICML, 2010.

[50] Adam Paszke, Sam Gross, Francisco Massa, Adam Lerer,

James Bradbury, Gregory Chanan, Trevor Killeen, Zeming

Lin, Natalia Gimelshein, Luca Antiga, et al. PyTorch: An

imperative style, high-performance deep learning library. In

NeurIPS, 2019.

[51] Boris T Polyak and Anatoli B Juditsky. Acceleration of

stochastic approximation by averaging. SIAM Journal on

Control and Optimization, 1992.

[52] Alec Radford, Jeffrey Wu, Rewon Child, David Luan, Dario

Amodei, and Ilya Sutskever. Language models are unsupervised multitask learners. 2019.

[53] Ilija Radosavovic, Justin Johnson, Saining Xie, Wan-Yen

Lo, and Piotr Dollár. On network design spaces for visual

recognition. In ICCV, 2019.

[54] Ilija Radosavovic, Raj Prateek Kosaraju, Ross Girshick, Kaiming He, and Piotr Dollár. Designing network design spaces.

In CVPR, 2020.

[55] Prajit Ramachandran, Niki Parmar, Ashish Vaswani, Irwan

Bello, Anselm Levskaya, and Jonathon Shlens. Stand-alone

self-attention in vision models. NeurIPS, 2019.

[56] Yongming Rao, Wenliang Zhao, Zheng Zhu, Jiwen Lu, and

Jie Zhou. Global filter networks for image classification.

NeurIPS, 2021.

[57] Shaoqing Ren, Kaiming He, Ross Girshick, and Jian Sun.

Faster R-CNN: Towards real-time object detection with region

proposal networks. In NeurIPS, 2015.

[58] Henry A Rowley, Shumeet Baluja, and Takeo Kanade. Neural

network-based face detection. TPAMI, 1998.

[59] Olga Russakovsky, Jia Deng, Hao Su, Jonathan Krause, Sanjeev Satheesh, Sean Ma, Zhiheng Huang, Andrej Karpathy,

Aditya Khosla, Michael Bernstein, Alexander C. Berg, and Li

Fei-Fei. ImageNet Large Scale Visual Recognition Challenge.

IJCV, 2015.

[60] Tim Salimans and Diederik P Kingma. Weight normalization:

A simple reparameterization to accelerate training of deep

neural networks. In NeurIPS, 2016.

[61] Mark Sandler, Andrew Howard, Menglong Zhu, Andrey Zhmoginov, and Liang-Chieh Chen. Mobilenetv2: Inverted

residuals and linear bottlenecks. In CVPR, 2018.

[62] Pierre Sermanet, David Eigen, Xiang Zhang, Michael Mathieu, Rob Fergus, and Yann LeCun. Overfeat: Integrated

recognition, localization and detection using convolutional

networks. In ICLR, 2014.

[63] Pierre Sermanet, Koray Kavukcuoglu, Soumith Chintala, and

Yann LeCun. Pedestrian detection with unsupervised multistage feature learning. In CVPR, 2013.

[64] Karen Simonyan and Andrew Zisserman. Two-stream convolutional networks for action recognition in videos. In NeurIPS,

2014.

[65] Karen Simonyan and Andrew Zisserman. Very deep convolutional networks for large-scale image recognition. In ICLR,

2015.

[66] Aravind Srinivas, Tsung-Yi Lin, Niki Parmar, Jonathon

Shlens, Pieter Abbeel, and Ashish Vaswani. Bottleneck transformers for visual recognition. In CVPR, 2021.

[67] Andreas Steiner, Alexander Kolesnikov, Xiaohua Zhai, Ross

Wightman, Jakob Uszkoreit, and Lucas Beyer. How to train

your vit? data, augmentation, and regularization in vision

transformers. arXiv preprint arXiv:2106.10270, 2021.

[68] Christian Szegedy, Wei Liu, Yangqing Jia, Pierre Sermanet,

Scott Reed, Dragomir Anguelov, Dumitru Erhan, Vincent

Vanhoucke, and Andrew Rabinovich. Going deeper with

convolutions. In CVPR, 2015.

[69] Christian Szegedy, Vincent Vanhoucke, Sergey Ioffe,

Jonathon Shlens, and Zbigniew Wojna. Rethinking the inception architecture for computer vision. In CVPR, 2016.

[70] Mingxing Tan, Bo Chen, Ruoming Pang, Vijay Vasudevan,

Mark Sandler, Andrew Howard, and Quoc V Le. Mnasnet:

Platform-aware neural architecture search for mobile. In

CVPR, 2019.

[71] Mingxing Tan and Quoc Le. Efficientnet: Rethinking model

scaling for convolutional neural networks. In ICML, 2019.

[72] Mingxing Tan and Quoc Le. Efficientnetv2: Smaller models

and faster training. In ICML, 2021.

[73] Hugo Touvron, Matthieu Cord, Matthijs Douze, Francisco

Massa, Alexandre Sablayrolles, and Hervé Jégou. Training

data-efficient image transformers & distillation through attention. arXiv:2012.12877, 2020.

[74] Hugo Touvron, Matthieu Cord, Alexandre Sablayrolles,

Gabriel Synnaeve, and Hervé Jégou. Going deeper with

image transformers. ICCV, 2021.

[75] Dmitry Ulyanov, Andrea Vedaldi, and Victor Lempitsky. Instance normalization: The missing ingredient for fast stylization. arXiv:1607.08022, 2016.

[76] Régis Vaillant, Christophe Monrocq, and Yann Le Cun. Original approach for the localisation of objects in images. Vision,

Image and Signal Processing, 1994.

[77] Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, Lukasz Kaiser, and Illia

Polosukhin. Attention is all you need. In NeurIPS, 2017.

[78] Haohan Wang, Songwei Ge, Eric P Xing, and Zachary C

Lipton. Learning robust global representations by penalizing

local predictive power. NeurIPS, 2019.

[79] Xiaolong Wang, Ross Girshick, Abhinav Gupta, and Kaiming

He. Non-local neural networks. In CVPR, 2018.

[80] Ross Wightman. GitHub repository: Pytorch image models. https://github.com/rwightman/pytorchimage-models, 2019.

[81] Ross Wightman, Hugo Touvron, and Hervé Jégou. Resnet

strikes back: An improved training procedure in timm.

arXiv:2110.00476, 2021.

[82] Haiping Wu, Bin Xiao, Noel Codella, Mengchen Liu, Xiyang

Dai, Lu Yuan, and Lei Zhang. Cvt: Introducing convolutions

to vision transformers. ICCV, 2021.

[83] Yuxin Wu and Kaiming He. Group normalization. In ECCV,

2018.

[84] Yuxin Wu and Justin Johnson. Rethinking “batch” in batchnorm. arXiv:2105.07576, 2021.

[85] Tete Xiao, Yingcheng Liu, Bolei Zhou, Yuning Jiang, and

Jian Sun. Unified perceptual parsing for scene understanding.

In ECCV, 2018.

[86] Tete Xiao, Mannat Singh, Eric Mintun, Trevor Darrell, Piotr

Dollár, and Ross Girshick. Early convolutions help transformers see better. In NeurIPS, 2021.

[87] Saining Xie, Ross Girshick, Piotr Dollár, Zhuowen Tu, and

Kaiming He. Aggregated residual transformations for deep

neural networks. In CVPR, 2017.

[88] Weijian Xu, Yifan Xu, Tyler Chang, and Zhuowen Tu. Coscale conv-attentional image transformers. ICCV, 2021.

[89] Sangdoo Yun, Dongyoon Han, Seong Joon Oh, Sanghyuk

Chun, Junsuk Choe, and Youngjoon Yoo. Cutmix: Regularization strategy to train strong classifiers with localizable

features. In ICCV, 2019.

[90] Hongyi Zhang, Moustapha Cisse, Yann N Dauphin, and David

Lopez-Paz. mixup: Beyond empirical risk minimization. In

ICLR, 2018.

[91] Zhun Zhong, Liang Zheng, Guoliang Kang, Shaozi Li, and

Yi Yang. Random erasing data augmentation. In AAAI, 2020.

[92] Bolei Zhou, Hang Zhao, Xavier Puig, Tete Xiao, Sanja Fidler,

Adela Barriuso, and Antonio Torralba. Semantic understanding of scenes through the ADE20K dataset. IJCV, 2019

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?