目录

一、Libtorch下载

针对自己的pytorch+cuda版本,可从下面的文章中获取Debug或Release版本下对应的libtorch文件。

下载后的libtorch可按如下目录放置,分别为release和debug版本:

我个人对libtorch的配置总结了两种方式,下面分别对每种配置方式进行介绍,每种方式亲测有效。

二、LibTorch配置

2.1 通过VSIXTorch来配置

2.1.1.安装VSIXTorch

VSIXTorch下载:VSIXTorch.vsix

下载安装完成后下图:

2.2.2 VS 2019直接创建TorchProject

如下图所示:

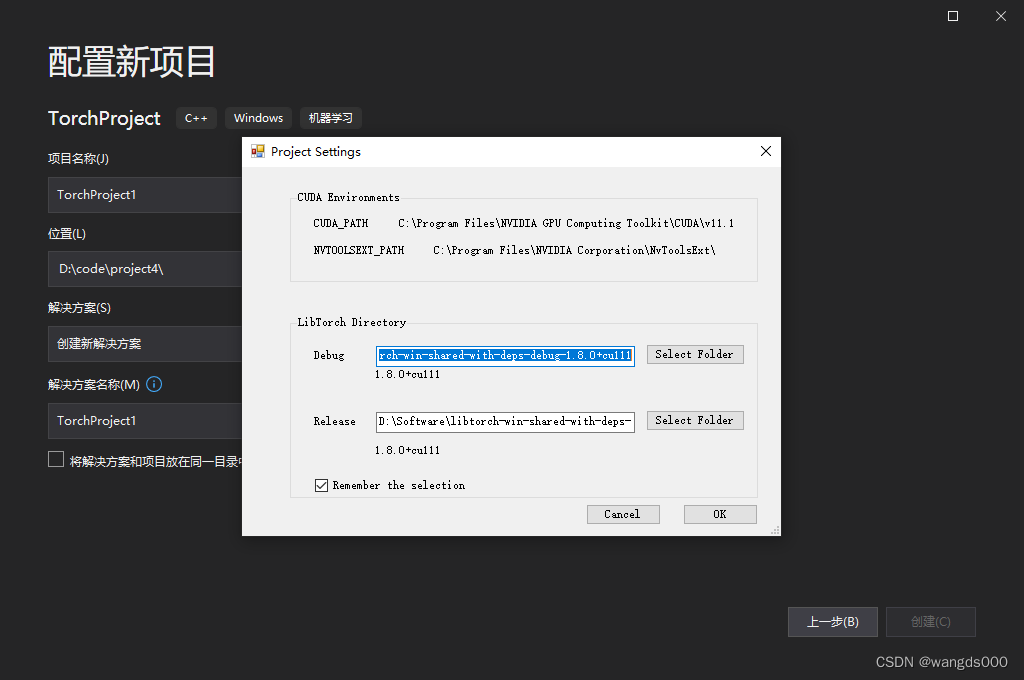

点击创建工程后,会跳出项目配置窗口,将之前下载的debug和release版本的libtorch文件分别填入。

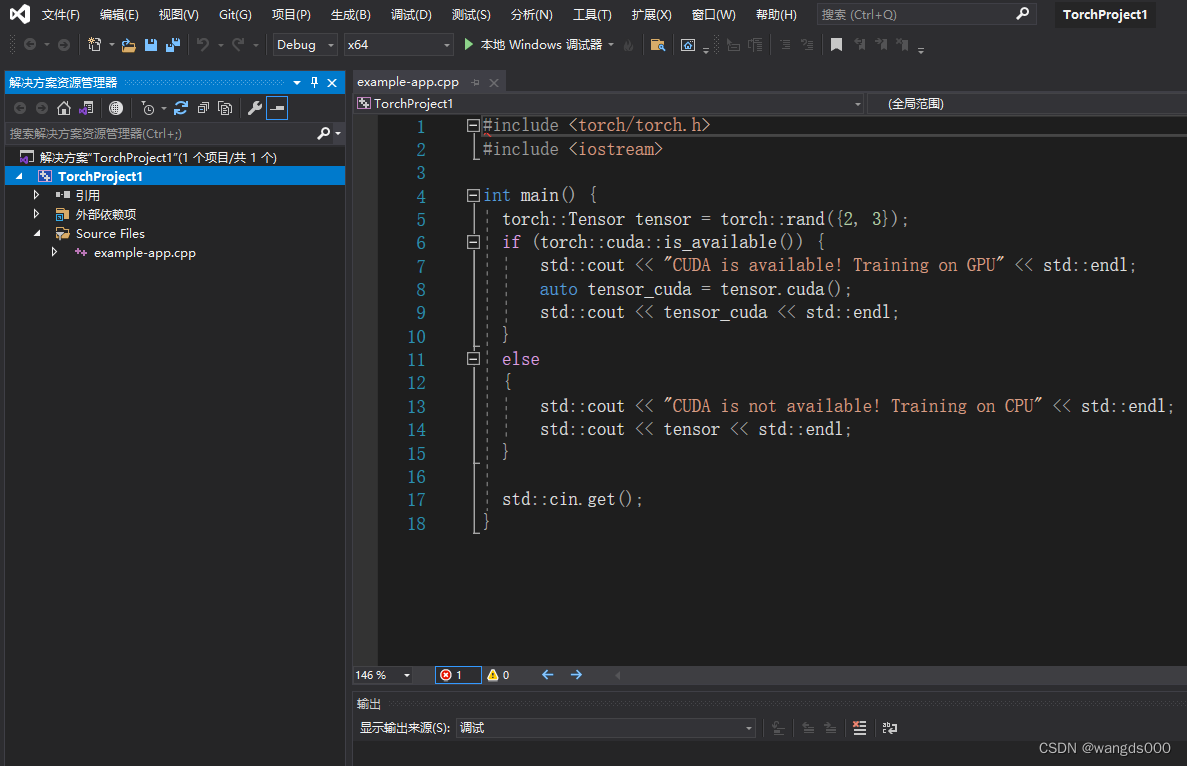

点击OK,创建的TorchProject默认加载了example-app.cpp示例源文件。

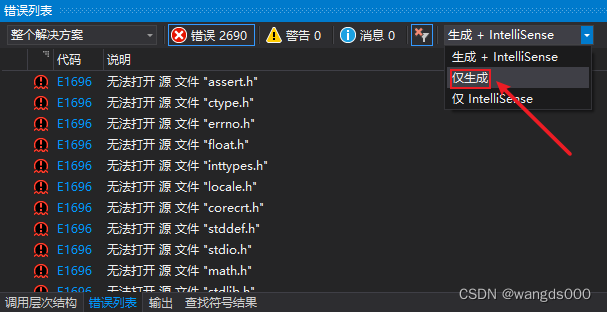

在debug或release下点击运行时会出现如下错误信息:

这是由VS 2019智能感知引擎进行代码语法判断时引起的,它会尽可能做到和编译器相同的判断,但是因为资源所限,也会存在误判的情况。此处脚本内容语法上并无错误,所以头文件抛出的异常信息为:

“C++ 错误过多,导致 IntelliSense 引擎无法正常工作。其中一些错误可能在编辑器中不可见。”

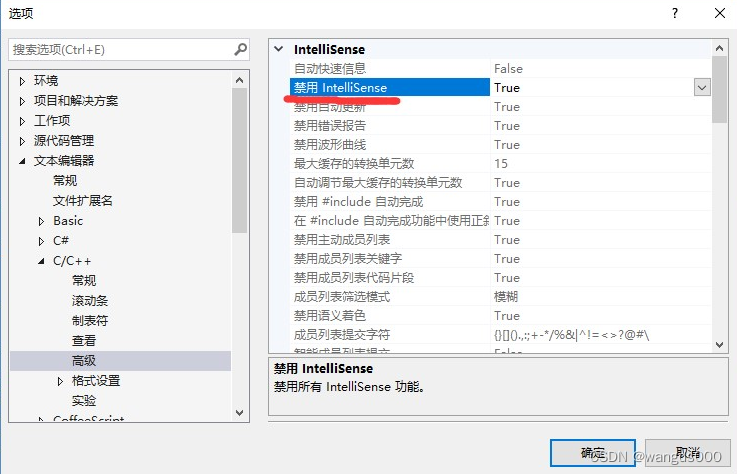

有的文章指出直接将工程项目属性的IntelliSense禁用 (如下图),但带来的一个问题时,下次创建一个新工程时,在编写代码时不会出现代码智能引导,所以不推荐使用这种方法。

还有文章指出在【项目->属性->配置属性->C/C+±>预处理器->预处理器定义】中加“_XKEYCHECK_H”来解决,但我在尝试添加后并没有解决。

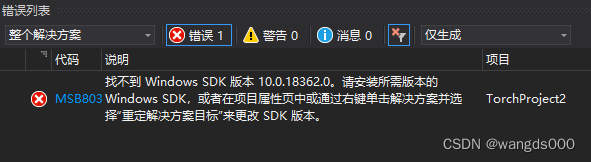

最终,我是将上图中所示的原来的【生成IntelliSense】修改为【仅生成】便可解决此问题。如果还有错误显示,如下所示:(没有的可忽略)

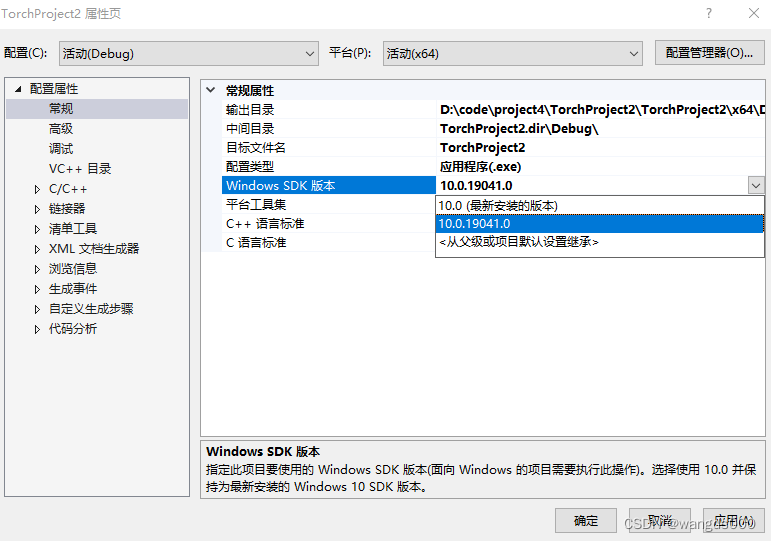

将Windows SDK版本修改为本机现有的版本,如下所示

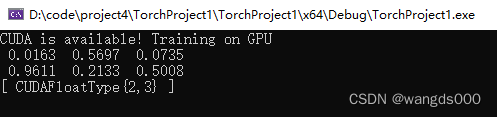

此时编译运行文件成功,终端显示如下:

如果想利用libtorch C++来加载DL模型验证输出结果,可以直接修改示例源文件example-app.cpp为:

#include <torch/script.h>

#include <iostream>

#include <memory>

int main() {

torch::jit::script::Module module;

try {

module = torch::jit::load("/path/to/resnet18_ts.pt"); //加载自己的torchscript模型

}

catch (const c10::Error& e) {

std::cerr << "error loading the module\n";

return -1;

}

std::cout << "ok\n";

std::vector<torch::jit::IValue> inputs;

inputs.push_back(torch::ones({ 1, 3, 224, 224 }));

at::Tensor output = module.forward(inputs).toTensor();

std::cout << output.slice(/*dim=*/1, /*start=*/0, /*end=*/5) << std::endl;

}

运行结果:

这种配置方式下,还带来一个问题,就是debug或release模式下编译完成的项目工程文件夹中会生成大量的链接库文件,它们均来自libtorch,这势必导致占用很大空间容量。

因此依据opencv的配置方式,我尝试将libtorch也进行了类似的配置,发现同样有效,即下面的配置方式。

2.2 直接在VS 2019中配置

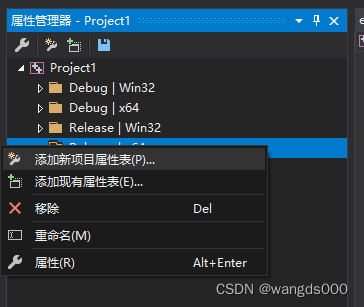

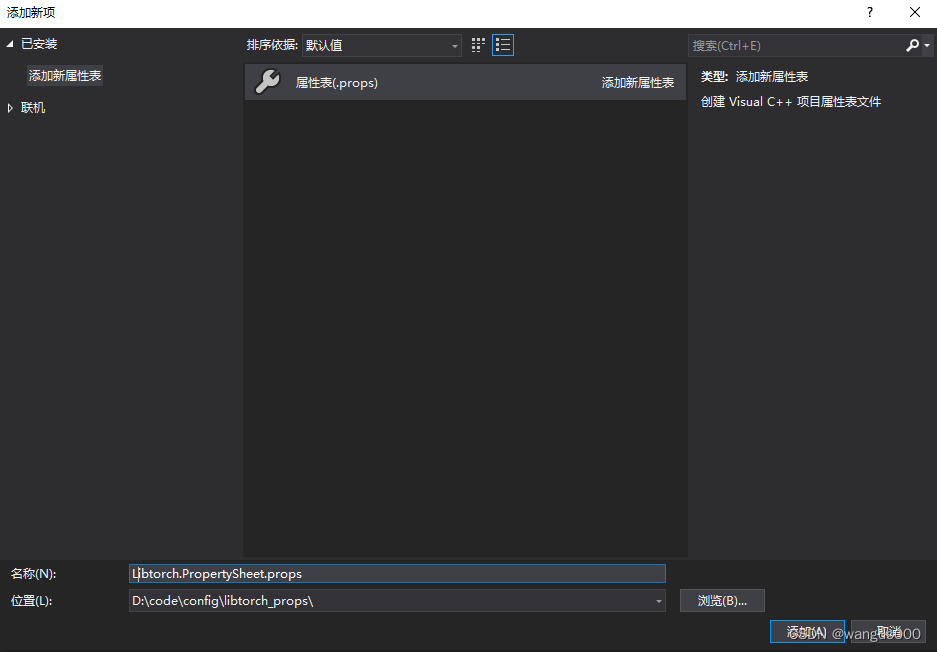

创建“空项目”工程,在属性管理器中【添加新项目属性表】

此处配置libtorch-release(x64)版本。为了避免后续创建工程频繁配置,可将配置的属性表文件Libtorch.PropertySheet.props存储在一个config文件夹下。如果下次创建新的工程,在属性管理器中直接【添加现有属性表】,选择在config文件夹下已经配置好的属性表。

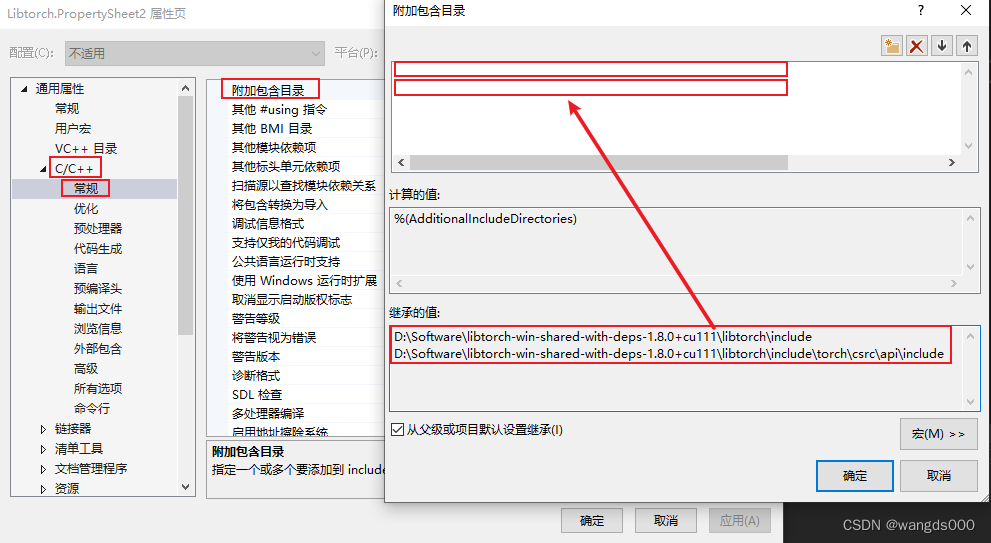

打开项目属性表文件,在【附加包含目录】中添加

D:\libtorch-win-shared-with-deps-1.8.0+cu111\libtorch\include

D:\libtorch-win-shared-with-deps-1.8.0+cu111\libtorch\include\torch\csrc\api\include

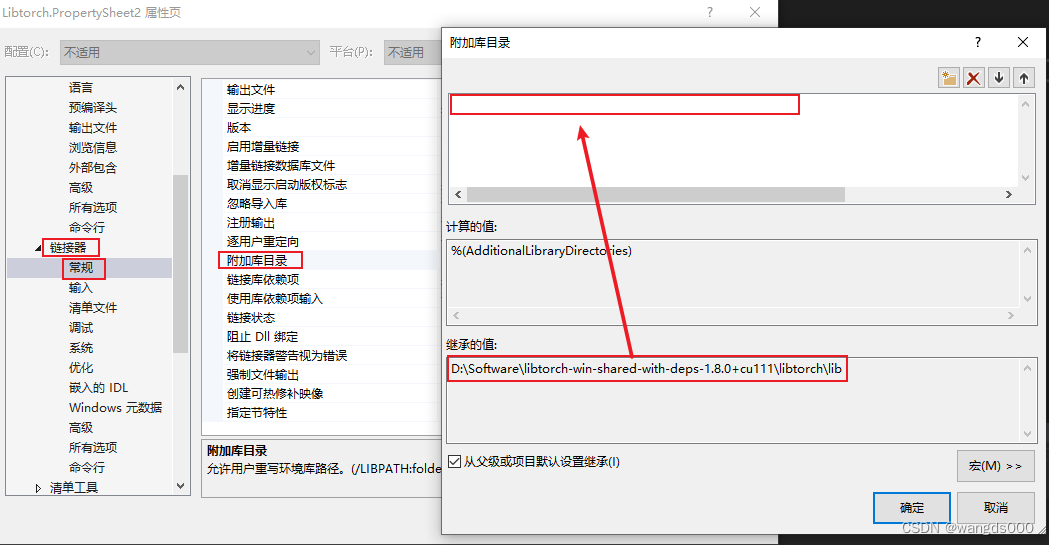

在【附加库目录】中添加

D:\libtorch-win-shared-with-deps-1.8.0+cu111\libtorch\lib

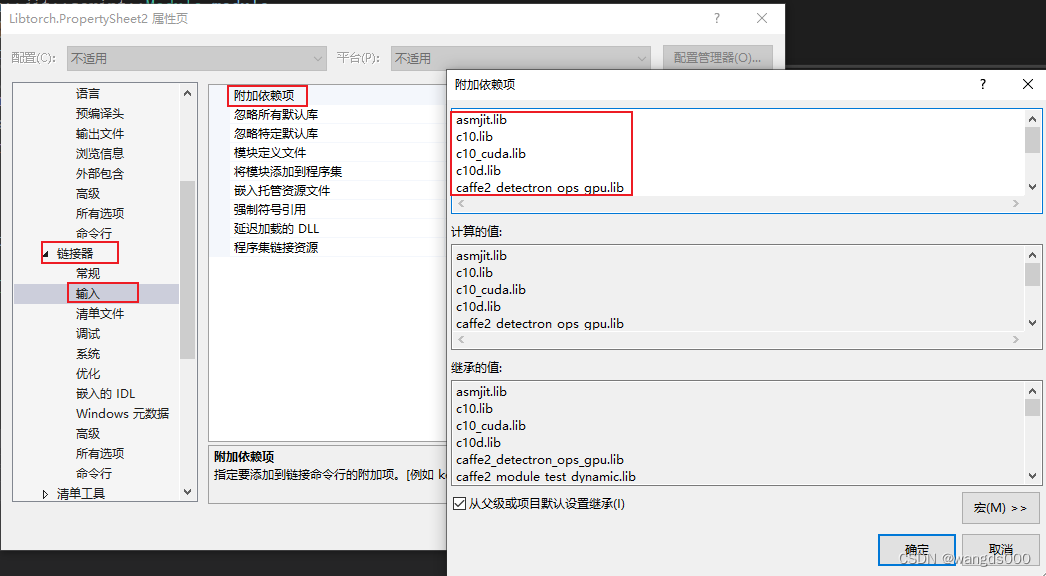

在【附加依赖项】中添加D:\libtorch-win-shared-with-deps-1.8.0+cu111\libtorch\lib文件夹下所有的 *.lib文件。

完成上述配置后,在计算机【环境变量–系统变量】中添加

D:\libtorch-win-shared-with-deps-1.8.0+cu111\libtorch\bin

D:\libtorch-win-shared-with-deps-1.8.0+cu111\libtorch\lib

到Path中。

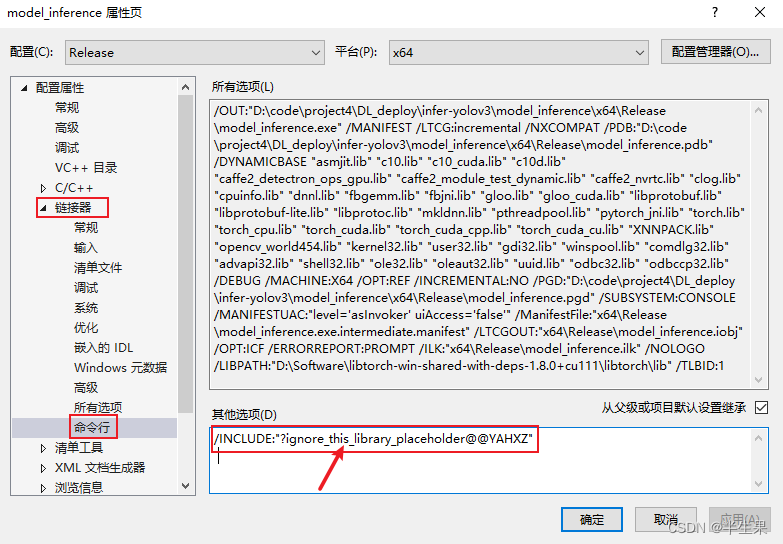

此外,libtorc加载GPU模型时,还需在打开工程项目属性页配置CUDA命令行:

/INCLUDE:"?ignore_this_library_placeholder@@YAHXZ"

此时完成所有配置,运行example-app.cpp成功编译。

4404

4404

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?