2020年3月22-26日,第27届IEEE VR国际学术会议(The IEEE Conference on Virtual Reality and 3D User Interfaces)召开。该会议是虚拟现实/增强现实领域的最高学术会议(CCF-A会议)。北京大学图形与交互技术实验室的研究成果《DGaze: CNN-Based Gaze Prediction in Dynamic Scenes》被IEEE VR收录为长文并直接发表在IEEE TVCG期刊(CCF-A期刊)。2020年IEEE VR共收到会议论文投稿489篇,收录104篇,录取率为21.4%。会议报告论文中发表在IEEE TVCG期刊上论文共29篇(投稿164篇,录取率为17.7%),其中中国仅3篇入选。

在虚拟/混合现实领域中,用户的注视信息具有广泛的应用价值,用户的注视行为分析和计算是其中一个关键问题。目前虚拟现实眼镜中眼动追踪的解决方案主要是依赖于眼动仪。眼动仪有价格昂贵、使用受限、无法预测用户在未来时刻的注视等缺点,该实验室团队一直致力于研究眼动仪的智能化软件方案。

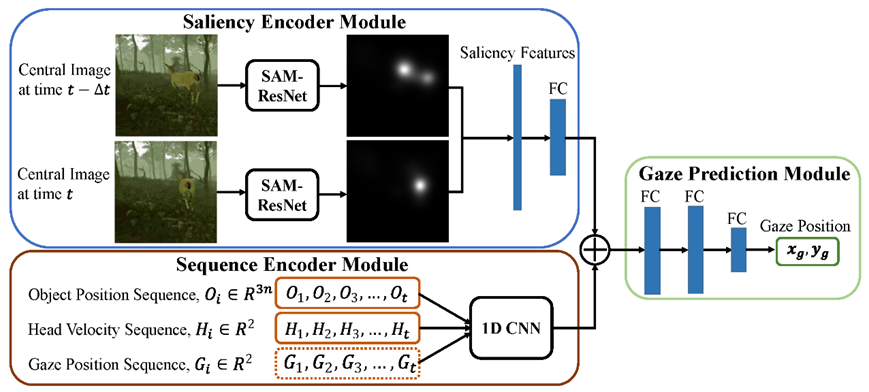

该成果提出了一个新颖的基于CNN神经网络的注视预测模型DGaze,该模型可以用于虚拟现实眼镜中的注视预测,首次实现了虚拟现实头盔/眼镜上的未来注视点的准确预测。DGaze模型结合了动态物体位置序列、用户头动速度序列、以及场景内容的显著性特征来预测用户的注视位置,预测的精度比以往方法有显著地提升。方法同时提出了该模型的一个变体DGaze_ET,DGaze_ET可以通过结合眼动仪提供的用户在过去时刻的眼动数据,以更高的精度预测用户在未来时刻的注视位置。

该项成果由北京大学、香港大学和美国马里兰大学合作取得。实验室博士生胡志明为第一作者,李胜和汪国平为共同通讯作者。该工作得到国家重点研发计划项目和国家自然科学基金的支持。

原文链接:

由汪国平教授领导的图形与交互技术实验室团队一直专注于虚拟现实系统的研发以及理论、方法的研究。该团队在注视点分析与预测方面持续开展工作并取得系列成果,关于实时注视点预测的方法《SGaze: A Data-Driven Eye-Head Coordination Model for Realtime Gaze Prediction》发表在2019年的IEEE VR会议的IEEE TVCG期刊上。

420

420

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?