还是先道歉 在说搬运的事 业没亲测啊 反正看见了 感觉好厉害

目标检测是现在最热门的研究课题,现在的框架越来越多,但是技术的新颖性到了瓶颈,目前开始流行Transformer机制,而且在目标检测领域也能获得较大的提升,也是目前研究的一个热点。

本文 iphone-ipad-Yolo 一个大佬修改过的yolo

开源代码:https://github.com/ultralytics/yolov5/releases

暂时命名为:Pad-YoloV5,在IPad上可以实时检测!基于YoloV5框架,熟悉的同学应该都不用多加解释。

YoloV4在YoloV3的基础上增加了近两年的研究成果,如下:

- 输入端采用mosaic数据增强

- Backbone上采用了CSPDarknet53、Mish激活函数、Dropblock等方式。(cspnet减少了计算量的同时可以保证准确率)

- Mish函数为:

- Neck中采用了SPP、FPN+PAN的结构,

- 输出端则采用CIOU_Loss、DIOU_nms操作

YoloV5主要的改变,如下:

- 输入端:Mosaic数据增强、自适应锚框计算

- Backbone:Focus结构,CSP结构

- Neck:FPN+PAN结构

- Prediction:GIOU_Loss

正好在看这个综艺,就随手测试下效果

这次主要优化,是YoloV5在数据增强的时候,用随机缩放、随机裁剪、随机排布的方式进行拼接,这个对于小目标的检测效果还是很友好的。通过实验发现,这个随机拼接和有规律的拼接,最终的结果还是有一点差别的。

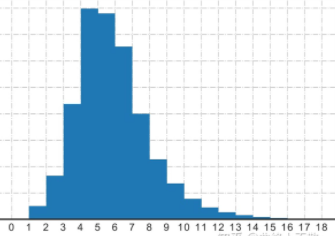

首先我通过修改数据增强的策略,开始对整体数据集进行统计(也就是数据预处理分析),我大致分成三个范围。将最大的与最小的进行随机拼接,最终结果确实比整体随机的效果好!

其次,稍微修改了下自适应图片缩放策略,Yolov5代码中datasets.py的letterbox函数中进行了修改,对原始图像自适应的添加最少的黑边。我是在自适应缩放后的图片,我在右下角位置填边,其实大多数数据没有什么变化,只是随便改改,因为在线都是在Yolo的基础上增加最近几年新出的策略,确实在最后的检查有一定效果的增加。

蹭个热度,由于训练epoch较少,效果在ipad上测试不够理想

最后的修改,就是辛苦的把Transformer机制加进了YoloV5的基础框架中,训练确实加快了,但是对于用笔记本训练的成果物,还是不够明显。

虽然实际不是多... 但还是好厉害吧

670

670

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?