变频器接线端子概述

变频器接线端子隶属于连接器的一种,种类分单孔,双孔,插口,挂钩等,从材料分,铜镀银,铜镀锌,铜,铝,铁等。它们的作用主要传递电信号或导电用,在工程中,它是站前工程为站后工程预留的接口,是站后接口工程的预埋设施。

变频器从功率分成:强电端子和弱电端子两大类;

(1)强电端子是指高电压高功率的接线端子,通常包括RST供电电源端子、UVW电机端子、P+和N-直流母线端子、PB制动电阻端子、E散热铝片接地端子等。变频器的能量通过这些端子传递进来,处理后传递出去给电机。

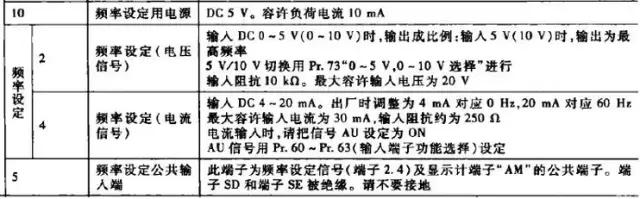

(2)弱电端子包括+24V、com、+10V、GND这类弱电电源端子,FWD正转、REV反转、X1~X7多功能定义端子、RA、RB、RC内部继电器输出端子、AO模拟量输出端子、VI、AI模拟量输出端子、RS485通讯端子等等,这类也叫控制端子。

变频器的怎样转、转多少速度、它现在的状态怎样、和外围设备怎样联手运作等都通过这些端子的电平高低来实现。通常FWD、REV、X1~X7通过外部接触器的触点信号的开闭,送入指令给变频器。一般采用常开触点控制较多,某些变频器还可以自行定义逻辑信号的正反逻辑。

应用说明:富士变频器选用的端子有插拔式端子、直焊式端子和栅栏式端子

应用说明:变频器选用的是双层栅栏式端子

应用说明:变频器选用的是双层栅栏式端子

应用说明:变频器选用的是直焊式接线端子(LG127)

应用说明:变频器选用的是直焊式接线端子(LG127HB)

应用说明:变频器选用的是栅栏式端子

应用说明:变频器选用的是插拔式式端子

应用说明:变频器选用的是插拔式端子(LZ1系列)

变频器接线端子功能使用解析

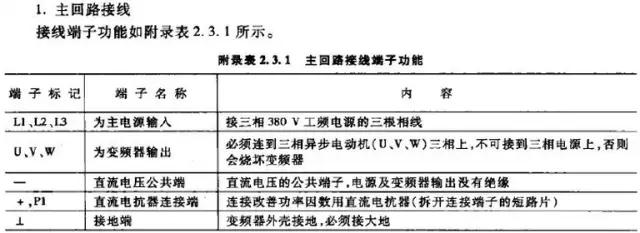

1、变频器的接线端子使用说明

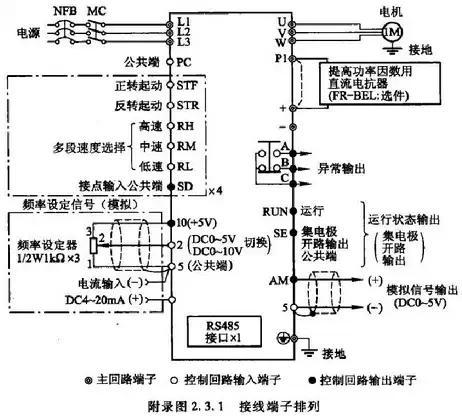

变频器的接线端子分为主回路和控制回路两大部分,把变频器后上盖打开,即可看到主回路端子和控制回路端子,使用时务必依照附录图2.3.1所示进行接线。由于附录图2.3.1为变频器的标准接线图,在具体使用时,有些功能并不需要,应根据具体的使用要求进行必要的配线,不需要的控制端可以空开不用。

2、接线端子排列图

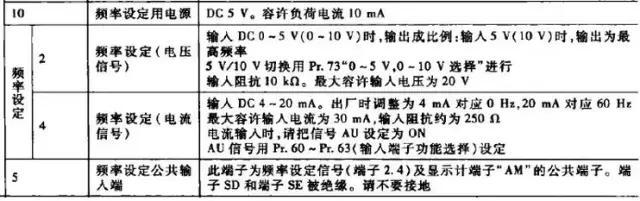

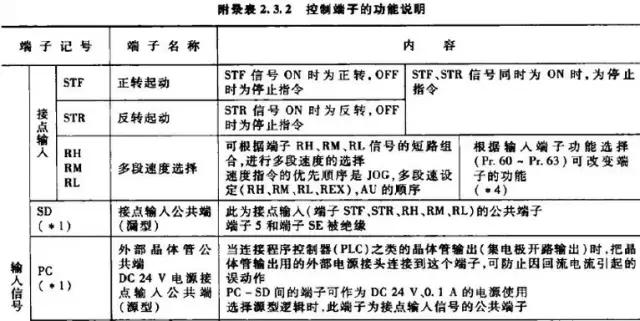

3.控制回路接线

控制回路接线必须与主回路分开,否则会引起干扰,使控制功能失灵,根据使用要求,设计控制回路接线.不需要的端子可以空开不用,控制端子功能如附录表2.3.2

4、控制端子功能

本文详细介绍了变频器接线端子的种类、功能及其在工程中的作用。变频器接线端子分为强电端子和弱电端子,分别用于传递电力和控制指令。强电端子包括供电电源、电机、直流母线等端子,而弱电端子涉及控制信号、模拟量输出和通讯端子等。接线端子的选择和布局对于变频器的正常工作和与外围设备的配合至关重要。文章还提供了不同类型的端子应用实例,如插拔式、直焊式和栅栏式端子。

本文详细介绍了变频器接线端子的种类、功能及其在工程中的作用。变频器接线端子分为强电端子和弱电端子,分别用于传递电力和控制指令。强电端子包括供电电源、电机、直流母线等端子,而弱电端子涉及控制信号、模拟量输出和通讯端子等。接线端子的选择和布局对于变频器的正常工作和与外围设备的配合至关重要。文章还提供了不同类型的端子应用实例,如插拔式、直焊式和栅栏式端子。

1930

1930

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?