简介:本文围绕“语音识别数据集合1”及配套的 LanguageModel2.py 统计语言模型展开讲解。该数据集包含大量音频文件与对应文本,用于训练语音识别系统,涵盖训练集、验证集和测试集划分。语言模型采用N-gram、LSTM或Transformer等技术,提升识别的上下文理解能力。系统整体可能结合声学模型与语言模型,使用CTC或Attention机制实现高效语音到文本的转换。文章提供详细的网络搭建步骤和实战指导,帮助读者掌握语音识别系统构建全流程。

1. 语音识别系统概述与基础概念

语音识别技术的发展历程与应用领域

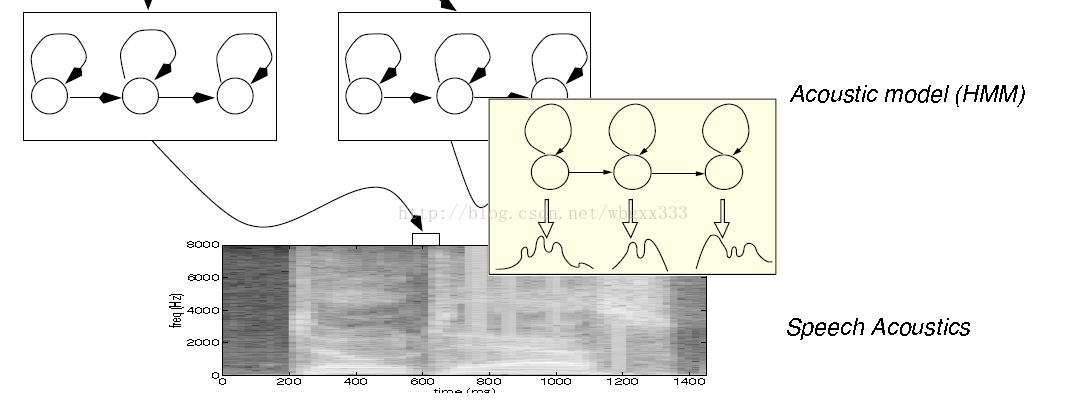

语音识别技术起源于20世纪50年代的“听写机”实验,历经动态时间规整(DTW)、隐马尔可夫模型(HMM)与高斯混合模型(GMM)时代,逐步发展至深度学习驱动的端到端系统。近年来,随着Transformer和自监督学习(如Wav2Vec 2.0)的突破,语音识别在准确率和泛化能力上显著提升。其应用广泛覆盖智能助手(如Siri、小爱同学)、医疗转录、车载系统、客服机器人及无障碍交互等领域,成为人机交互的核心技术之一。

2. 语音识别数据集的构建与预处理

语音识别系统的效果很大程度上依赖于数据集的质量与多样性。构建一个高质量、具有代表性的语音数据集是整个识别系统开发流程中至关重要的一步。本章将围绕语音识别数据集的构建与预处理技术展开,从数据采集、清洗、标注到数据划分与增强策略进行全面解析,帮助读者掌握构建语音识别训练集的完整方法论。

2.1 数据集的来源与采集方式

2.1.1 公共语音数据集介绍

在实际开发中,构建一个完整的语音识别系统通常需要大量的语音与文本配对数据。由于采集成本高昂,许多研究者和开发者会优先使用已有的公共语音数据集。以下是一些主流的开源语音数据集:

| 数据集名称 | 语言 | 数据规模 | 采集方式 | 特点 |

|---|---|---|---|---|

| LibriSpeech | 英语 | 1000小时 | 有声书 | 高质量录音,适合通用语音识别模型训练 |

| Common Voice | 多语种 | 10000+小时(多语言) | 用户上传 | 社区贡献,语种丰富,但质量参差不齐 |

| TIMIT | 英语 | 630人,6小时 | 录音室采集 | 标注精确,适合语音音素识别研究 |

| AISHELL-1 | 中文 | 178小时 | 朗读式录音 | 标准普通话,标注规范 |

| THCHS30 | 中文 | 30小时 | 朗读+自发语音 | 适合小规模训练和教学实验 |

这些数据集通常包含音频文件(如 .wav )、文本标注文件(如 .txt )、说话人信息(如 .spk )等,适用于不同的训练目标和场景。

2.1.2 自建数据集的采集策略

在特定场景(如方言识别、行业专用语音)下,公共数据集可能无法满足需求,此时需要构建自建语音数据集。构建自建数据集的关键在于科学的采集策略:

- 明确目标场景与语料设计 :确定目标应用场景(如客服对话、车载语音),并设计对应的语料模板,确保语音内容覆盖实际使用场景。

- 多说话人采集 :采集不同性别、年龄、口音、语速的说话人数据,提升模型泛化能力。

- 多设备与环境采集 :使用不同的麦克风、录音设备,模拟实际应用场景中的噪音环境(如车流声、空调声)。

- 录音质量控制 :设置统一的录音标准(如采样率44.1kHz、16bit PCM编码),避免背景噪音过大或音频失真。

- 数据标注机制 :建立统一的标注规范,确保每段音频与文本一一对应,并标注说话人ID、时间戳、语种等元信息。

例如,采集一段中文客服对话数据时,可以使用如下录音脚本示例:

import random

# 客服场景语料库

questions = [

"请问您需要办理什么业务?",

"您的账户余额不足,请充值。",

"请提供您的身份证号码。",

"我们将在三个工作日内为您处理。"

]

# 模拟用户回答

answers = [

"我想查询账户余额。",

"好的,我现在就充值。",

"110101199003072516",

"谢谢您的耐心等待。"

]

# 模拟对话生成

def generate_dialogue():

q = random.choice(questions)

a = random.choice(answers)

return f"客服:{q}\n用户:{a}"

print(generate_dialogue())

逻辑分析 :

- 上述代码模拟了客服场景中的对话生成过程,用于辅助设计语料库。

- questions 和 answers 列表分别表示客服与用户的典型回复。

- generate_dialogue() 函数随机组合问题与回答,形成一个模拟对话样本。

- 该脚本可作为录音脚本的基础,确保采集内容多样化和场景化。

参数说明 :

- random.choice() :从列表中随机选择一个元素,用于生成多样化的语句组合。

- print() :输出生成的对话文本,供录音人员参考。

2.2 数据清洗与标注规范

2.2.1 音频格式标准化与降噪处理

构建语音数据集时,音频格式和质量的统一是训练模型的基础。常见的音频格式如 .wav 、 .flac 、 .mp3 等,其中 .wav 因其无损压缩和易于处理而被广泛采用。

音频格式标准化流程:

graph TD

A[原始音频文件] --> B{判断格式}

B -->|WAV| C[保留原始音频]

B -->|非WAV| D[转换为WAV]

D --> E[统一采样率]

E --> F[统一声道数]

F --> G[输出标准化音频]

逻辑说明 :

- 该流程图描述了音频标准化的全过程。

- 首先判断音频格式是否为 .wav ,若不是则进行格式转换。

- 转换后统一采样率为 16kHz,单声道,以适配大多数语音识别模型的输入要求。

示例:使用 pydub 进行格式转换与降噪

from pydub import AudioSegment

from pydub.effects import normalize

# 加载音频文件

audio = AudioSegment.from_file("input.mp3")

# 标准化为16kHz、单声道

audio = audio.set_frame_rate(16000).set_channels(1)

# 降噪处理(去除静音部分)

audio = audio.strip_silence(silence_thresh=-50)

# 音量归一化

audio = normalize(audio)

# 导出为WAV格式

audio.export("output.wav", format="wav")

逻辑分析 :

- AudioSegment.from_file() :加载任意格式的音频文件。

- set_frame_rate() 和 set_channels() :标准化采样率和声道数。

- strip_silence() :去除音频中过长的静音段,减少冗余。

- normalize() :对音频进行音量归一化处理,提升识别模型的鲁棒性。

- export() :导出标准化后的 .wav 文件。

参数说明 :

- silence_thresh=-50 :静音阈值,单位为 dBFS,低于该值的片段将被裁剪。

- format="wav" :导出格式,确保统一为 .wav 。

2.2.2 文本标注的统一格式与纠错方法

文本标注是语音识别训练中至关重要的环节。统一的标注格式可以提高模型训练效率,而准确的标注内容直接影响识别准确率。

统一标注格式示例:

# 格式说明:

# [音频文件名] [转录文本] [说话人ID] [语种] [情感标签(可选)]

001.wav 今天天气不错,适合出门散步。 spk001 zh-CN neutral

002.wav How are you doing today? spk002 en-US neutral

自动纠错与一致性检查

在大量数据中,难免会出现拼写错误或格式不统一的问题。可借助自然语言处理工具进行自动纠错。

from spellchecker import SpellChecker

spell = SpellChecker(language='en') # 支持英语拼写检查

# 待纠错的文本

text = "Ths is a smple txt with erors."

# 分词处理

words = text.split()

# 纠错处理

corrected_words = [spell.correction(word) for word in words if word]

# 输出纠正后的文本

corrected_text = " ".join(corrected_words)

print(corrected_text)

逻辑分析 :

- 使用 SpellChecker 对英文文本进行拼写检查。

- 将输入文本分词后逐个纠错。

- 最终输出纠正后的文本,用于标注文件的清洗。

参数说明 :

- language='en' :设置语言为英文,支持中文的拼写检查工具较少,需使用中文分词器(如 jieba )结合词典进行处理。

2.3 数据集的划分与训练集验证集测试集比例设计

2.3.1 交叉验证的应用与数据划分策略

为了评估模型的泛化能力,语音识别任务通常将数据集划分为训练集、验证集和测试集。常见的划分比例为 70%、15%、15% 或 80%、10%、10%。

数据划分示例代码:

import os

import random

import shutil

# 原始数据路径

data_dir = "raw_audio"

train_dir = "dataset/train"

val_dir = "dataset/val"

test_dir = "dataset/test"

# 获取所有音频文件

files = [f for f in os.listdir(data_dir) if f.endswith(".wav")]

random.shuffle(files)

# 划分比例

train_ratio = 0.8

val_ratio = 0.1

test_ratio = 0.1

# 计算划分索引

train_end = int(len(files) * train_ratio)

val_end = train_end + int(len(files) * val_ratio)

# 创建目录

os.makedirs(train_dir, exist_ok=True)

os.makedirs(val_dir, exist_ok=True)

os.makedirs(test_dir, exist_ok=True)

# 移动文件

for f in files[:train_end]:

shutil.copy(os.path.join(data_dir, f), os.path.join(train_dir, f))

for f in files[train_end:val_end]:

shutil.copy(os.path.join(data_dir, f), os.path.join(val_dir, f))

for f in files[val_end:]:

shutil.copy(os.path.join(data_dir, f), os.path.join(test_dir, f))

逻辑分析 :

- 该脚本将原始音频文件按照比例划分为训练、验证、测试三部分。

- 使用 random.shuffle() 打乱文件顺序,保证划分的随机性。

- 使用 shutil.copy() 将文件复制到对应目录,避免原始数据被破坏。

参数说明 :

- train_ratio=0.8 :训练集占比 80%。

- val_ratio=0.1 :验证集占比 10%。

- test_ratio=0.1 :测试集占比 10%。

交叉验证策略(K-Fold)

在小数据集上,K-Fold 交叉验证能更充分地利用有限的数据。以下是使用 sklearn 的 KFold 实现:

from sklearn.model_selection import KFold

# 假设我们有100个样本

kf = KFold(n_splits=5)

for fold, (train_idx, val_idx) in enumerate(kf.split(files)):

print(f"Fold {fold + 1}:")

print("Train:", [files[i] for i in train_idx])

print("Val:", [files[i] for i in val_idx])

逻辑分析 :

- 将数据集划分为5个子集,每次使用其中1个作为验证集,其余作为训练集。

- 通过多次训练与验证,获得更稳定的性能评估结果。

2.3.2 数据增强技术在语音识别中的应用

在语音识别中,数据增强是提升模型泛化能力的重要手段。常见方法包括:

- 速度扰动(Speed Perturbation) :改变音频播放速度。

- 噪声注入(Noise Injection) :在音频中添加背景噪声。

- 音调偏移(Pitch Shifting) :调整音高,模拟不同说话人。

示例:使用 torchaudio 进行数据增强

import torchaudio

import torch

# 加载音频

waveform, sample_rate = torchaudio.load("input.wav")

# 速度扰动

speed_perturb = torchaudio.transforms.Resample(orig_freq=sample_rate, new_freq=int(sample_rate * 1.1))

augmented_speed = speed_perturb(waveform)

# 音调偏移

pitch_shift = torchaudio.transforms.PitchShift(sample_rate=sample_rate, n_steps=2)

augmented_pitch = pitch_shift(waveform)

# 添加噪声

noise = torch.randn_like(waveform) * 0.005

augmented_noise = waveform + noise

# 保存增强后的音频

torchaudio.save("augmented_speed.wav", augmented_speed, sample_rate)

torchaudio.save("augmented_pitch.wav", augmented_pitch, sample_rate)

torchaudio.save("augmented_noise.wav", augmented_noise, sample_rate)

逻辑分析 :

- 使用 torchaudio 提供的增强模块进行速度、音调和噪声扰动。

- 增强后的音频文件保存为新文件,可用于扩充训练集。

- 每种增强方式独立处理,便于后续组合使用。

参数说明 :

- n_steps=2 :音调升高2个半音。

- new_freq=int(sample_rate * 1.1) :加快10%播放速度。

- noise * 0.005 :控制噪声强度,数值越小越轻微。

本章详细讲解了语音识别数据集的构建与预处理全流程,从数据来源、采集策略、清洗与标注,到数据划分与增强方法,全面覆盖了构建高质量语音数据集所需的核心技术。下一章将深入讲解声学模型的构建,特别是基于卷积神经网络的特征提取与建模方法。

3. 基于卷积神经网络的声学建模

3.1 声学模型的基本原理与输入特征提取

3.1.1 MFCC与梅尔频谱图的提取方法

在语音识别系统中,声学模型的任务是将音频信号转换为对应的音素或字词的特征表示。为了实现这一目标,首先需要对原始音频信号进行特征提取。MFCC(Mel Frequency Cepstral Coefficients)和梅尔频谱图(Mel Spectrogram)是当前语音识别中最常用的两种特征表示方法。

MFCC 提取流程如下:

-

预加重(Pre-emphasis) :增强高频部分,通常使用一阶差分滤波器:

$$

y[n] = x[n] - \alpha x[n-1]

$$

其中 α 一般取 0.95 或 0.97。 -

分帧(Framing) :将连续的语音信号分割为短时帧,通常帧长为 20-40ms。

-

加窗(Windowing) :对每一帧加窗以减少边界效应,常用 Hamming 窗。

-

短时傅里叶变换(STFT) :将每一帧信号转换为频域表示。

-

滤波器组(Filter Banks) :将频谱映射到梅尔刻度上,使用一组三角滤波器。

-

对数能量(Log Energy) :计算每个滤波器输出的能量,并取对数。

-

离散余弦变换(DCT) :保留前 12-13 个系数作为 MFCC 特征。

梅尔频谱图 是另一种常用特征,其过程与 MFCC 的前几步相似,不同之处在于最终保留的是每个时间帧对应的滤波器组输出能量,而不是 DCT 后的系数。

3.1.2 特征归一化与帧级标签对齐

为了提升模型训练的稳定性,通常需要对提取的 MFCC 或梅尔频谱图进行归一化处理。常见方法包括:

- 均值归零(Mean Normalization) :对每帧特征减去训练集的均值。

- 标准差归一化(Standard Deviation Normalization) :每帧特征除以标准差。

帧级标签对齐 是指将特征帧与对应的音素或字符进行对齐。由于语音信号与文本标签之间存在时间延迟,通常使用动态时间规整(DTW)或基于 HMM 的方法进行对齐。在深度学习中,CTC(Connectionist Temporal Classification)损失函数常用于解决帧级标签对齐问题。

3.1.3 MFCC 与梅尔频谱图的对比分析

| 特征类型 | 优点 | 缺点 |

|---|---|---|

| MFCC | 压缩度高,适合传统模型 | 信息丢失较多 |

| 梅尔频谱图 | 保留频谱结构,适合 CNN 建模 | 维度较高,计算量较大 |

3.1.4 代码示例:使用 Python 提取 MFCC 与梅尔频谱图

import librosa

import numpy as np

# 加载音频文件

audio_path = 'example.wav'

y, sr = librosa.load(audio_path, sr=None)

# 提取 MFCC

mfccs = librosa.feature.mfcc(y=y, sr=sr, n_mfcc=13)

# 提取梅尔频谱图

mel_spectrogram = librosa.feature.melspectrogram(y=y, sr=sr, n_mels=128)

# 对数变换

log_mel_spectrogram = librosa.power_to_db(mel_spectrogram)

print("MFCC Shape:", mfccs.shape)

print("Log Mel Spectrogram Shape:", log_mel_spectrogram.shape)

代码逻辑分析:

-

librosa.load:加载音频文件并返回音频信号y和采样率sr。 -

librosa.feature.mfcc:提取 MFCC 特征,n_mfcc=13表示提取 13 个系数。 -

librosa.feature.melspectrogram:构建梅尔频谱图。 -

librosa.power_to_db:将能量值转换为对数尺度,增强模型可解释性。

3.2 CNN模型结构设计与训练流程

3.2.1 多层卷积与池化操作的作用

卷积神经网络(CNN)在图像识别中表现出色,也广泛应用于语音识别中的声学建模。CNN 的核心在于 卷积层(Convolutional Layer) 与 池化层(Pooling Layer) 的组合。

卷积层作用:

- 提取局部特征,如音频中的频谱纹理。

- 使用多个卷积核(filter)学习不同特征。

池化层作用:

- 减少特征图尺寸,降低计算量。

- 增强特征的平移不变性。

典型 CNN 结构:

Input -> Conv1 -> ReLU -> MaxPool1 -> Conv2 -> ReLU -> MaxPool2 -> Flatten -> FC1 -> Output

3.2.2 使用 PyTorch 实现 CNN 声学模型

以下是一个使用 PyTorch 构建的简单 CNN 声学模型实现:

import torch

import torch.nn as nn

class AcousticModelCNN(nn.Module):

def __init__(self, input_dim, num_classes):

super(AcousticModelCNN, self).__init__()

self.features = nn.Sequential(

nn.Conv2d(1, 32, kernel_size=(5, 5), stride=1, padding=2),

nn.ReLU(),

nn.MaxPool2d(kernel_size=(2, 2), stride=2),

nn.Conv2d(32, 64, kernel_size=(5, 5), stride=1, padding=2),

nn.ReLU(),

nn.MaxPool2d(kernel_size=(2, 2), stride=2)

)

self.classifier = nn.Sequential(

nn.Linear(64 * (input_dim // 4) * (input_dim // 4), 1024),

nn.ReLU(),

nn.Linear(1024, num_classes)

)

def forward(self, x):

x = self.features(x)

x = x.view(x.size(0), -1)

x = self.classifier(x)

return x

代码逻辑分析:

-

nn.Conv2d:定义卷积层,输入通道为 1(单通道音频),输出通道为 32,卷积核大小为 5x5。 -

nn.ReLU():激活函数,引入非线性。 -

nn.MaxPool2d:最大池化,压缩特征图尺寸。 -

nn.Linear:全连接层,用于最终分类。

3.2.3 CNN 模型结构流程图(Mermaid 格式)

graph TD

A[Input] --> B[Conv1 + ReLU + MaxPool]

B --> C[Conv2 + ReLU + MaxPool]

C --> D[Flatten]

D --> E[FC1 + ReLU]

E --> F[Output]

3.3 声学模型评估与优化策略

3.3.1 模型性能指标与混淆矩阵分析

评估声学模型性能常用的指标包括:

- 词错误率(WER, Word Error Rate)

- 音素错误率(PER, Phone Error Rate)

- 准确率(Accuracy)

- 混淆矩阵(Confusion Matrix)

混淆矩阵分析 可以揭示模型在哪些类别之间容易混淆。例如,音素 /s/ 和 /z/ 可能因发音相似而被误识别。

from sklearn.metrics import confusion_matrix, classification_report

y_true = [0, 1, 2, 2, 0]

y_pred = [0, 2, 2, 1, 0]

cm = confusion_matrix(y_true, y_pred)

print("Confusion Matrix:\n", cm)

print(classification_report(y_true, y_pred))

输出示例:

Confusion Matrix:

[[2 0 0]

[0 0 1]

[0 1 1]]

precision recall f1-score support

0 1.00 1.00 1.00 2

1 0.00 0.00 0.00 1

2 0.50 0.50 0.50 2

accuracy 0.60 5

macro avg 0.50 0.50 0.50 5

weighted avg 0.60 0.60 0.60 5

3.3.2 模型过拟合与欠拟合的应对方法

过拟合表现:

- 训练集准确率高,验证集准确率低。

- 损失曲线中验证损失逐渐上升。

欠拟合表现:

- 训练集与验证集准确率都低。

- 损失曲线中训练损失和验证损失都高。

应对策略:

| 问题类型 | 应对策略 |

|---|---|

| 过拟合 | 数据增强、Dropout、L2正则化、早停机制 |

| 欠拟合 | 增加模型复杂度、减少正则化、增加训练轮数 |

示例代码:使用 Dropout 防止过拟合

class AcousticModelCNNWithDropout(nn.Module):

def __init__(self, input_dim, num_classes):

super().__init__()

self.features = nn.Sequential(

nn.Conv2d(1, 32, kernel_size=5, padding=2),

nn.ReLU(),

nn.MaxPool2d(2),

nn.Dropout2d(0.25), # 添加 Dropout

nn.Conv2d(32, 64, kernel_size=5, padding=2),

nn.ReLU(),

nn.MaxPool2d(2),

nn.Dropout2d(0.25)

)

self.classifier = nn.Sequential(

nn.Linear(64 * (input_dim // 4) * (input_dim // 4), 1024),

nn.ReLU(),

nn.Dropout(0.5),

nn.Linear(1024, num_classes)

)

def forward(self, x):

x = self.features(x)

x = x.view(x.size(0), -1)

x = self.classifier(x)

return x

优化策略流程图(Mermaid)

graph TD

A[训练过程] --> B{是否过拟合?}

B -->|是| C[增加正则化/Dropout]

B -->|否| D{是否欠拟合?}

D -->|是| E[增加模型复杂度]

D -->|否| F[模型收敛]

本章系统地介绍了基于卷积神经网络的声学建模流程,包括特征提取、模型结构设计、训练与评估方法。通过代码实现与图表分析,展示了如何从原始音频构建声学模型并优化其性能,为后续语言建模打下坚实基础。

4. 基于RNN与LSTM的语言建模

语言模型在语音识别系统中承担着“语义筛选器”的角色,其核心任务是评估词序列的合理性,从而帮助解码器从声学模型输出的多个候选路径中选择最符合语言习惯的结果。早期的统计语言模型以N-gram为主,依赖于马尔可夫假设,在短距离上下文中表现尚可,但难以捕捉长距离依赖关系。随着深度学习的发展,循环神经网络(Recurrent Neural Network, RNN)及其改进结构——长短期记忆网络(Long Short-Term Memory, LSTM)逐渐成为语言建模的主流方法,尤其在处理自然语言序列方面展现出显著优势。

相较于传统N-gram模型对上下文长度的硬性限制(如三元组最多只看前两个词),RNN和LSTM能够通过内部状态机制记忆更长的历史信息,具备更强的泛化能力。特别是在低资源或领域特定场景下,基于神经网络的语言模型可以通过端到端训练自动学习词汇之间的复杂关联模式,避免手工设计特征带来的偏差与局限性。此外,结合词向量嵌入技术,这些模型还能有效缓解数据稀疏问题,提升对未登录词(OOV)的处理能力。

本章节将深入探讨从经典N-gram模型到现代LSTM语言模型的技术演进路径,分析其理论基础、实现细节及工程优化策略。重点解析LSTM如何解决传统RNN中的梯度消失问题,并通过门控机制实现长期依赖建模;同时展示如何使用PyTorch构建一个完整的LSTM语言模型,涵盖数据预处理、模型定义、训练流程与推理机制。通过对实际代码的逐行剖析,揭示模型各组件的功能职责与参数调优建议,为后续Transformer等更高级架构的学习奠定坚实基础。

4.1 语言模型的基本原理与N-gram模型实现

语言模型的本质是计算一个句子出现的概率 $ P(w_1, w_2, …, w_T) $,即给定前面若干个词的情况下,预测下一个词的可能性分布。根据链式法则,该联合概率可以分解为:

P(w_1^T) = \prod_{t=1}^{T} P(w_t | w_1, w_2, …, w_{t-1})

然而,直接估计完整历史会导致参数爆炸。为此,N-gram模型引入 马尔可夫假设 :当前词仅依赖于前 $ n-1 $ 个词。例如:

- Unigram: $ P(w_t) $

- Bigram: $ P(w_t|w_{t-1}) $

- Trigram: $ P(w_t|w_{t-2}, w_{t-1}) $

这种简化使得模型可在有限语料上进行有效估计。

4.1.1 N-gram概率计算与平滑技术

为了计算N-gram概率,通常采用最大似然估计(MLE):

P_{\text{MLE}}(w_t | w_{t-n+1}^{t-1}) = \frac{C(w_{t-n+1}^t)}{C(w_{t-n+1}^{t-1})}

其中 $ C(\cdot) $ 表示n-gram在训练集中出现的频次。

但真实文本中存在大量未观测组合,导致零概率问题。因此必须引入 平滑技术 来重新分配概率质量。常见的平滑方法包括:

| 平滑方法 | 原理简述 | 适用场景 |

|---|---|---|

| 拉普拉斯平滑(Add-one) | 所有计数加1,防止零概率 | 小规模词汇表 |

| Good-Turing平滑 | 利用高频项频率调整低频项估计 | 中等规模语料 |

| Kneser-Ney平滑 | 考虑上下文多样性而非单纯频率 | 大规模语言建模 |

以下是一个基于Python实现的Trigram模型示例,包含基本计数与Kneser-Ney风格回退逻辑雏形:

from collections import defaultdict

import math

class NGramLanguageModel:

def __init__(self, n=3):

self.n = n

self.counts = [defaultdict(int) for _ in range(n)]

self.vocabulary = set()

def train(self, sentences):

for sentence in sentences:

tokens = ['<s>'] * (self.n - 1) + sentence + ['</s>']

self.vocabulary.update(tokens)

for i in range(len(tokens)):

for j in range(min(i + 1, self.n)):

self.counts[j][tuple(tokens[i-j:i+1])] += 1

def get_prob(self, word, context):

# 回退机制模拟

for k in range(min(len(context), self.n-1), -1, -1):

history = tuple(context[-k:]) if k > 0 else ()

target = (history + (word,))

numerator = self.counts[len(target)-1][target]

denominator = self.counts[len(history)][history] if history else len(self.counts[0])

if denominator > 0 and numerator > 0:

return max(numerator / denominator, 1e-10)

return 1e-5 # 默认极小值

# 示例用法

sentences = [

["I", "love", "deep", "learning"],

["I", "enjoy", "natural", "language", "processing"]

]

model = NGramLanguageModel(n=3)

model.train(sentences)

print(model.get_prob("learning", ["love", "deep"])) # 输出近似条件概率

代码逻辑逐行解读与参数说明

- 第1–5行 :导入必要的模块并初始化类结构。

defaultdict(int)可自动处理未见过的n-gram键。 - 第7–9行 :构造函数设置n元大小,创建不同阶数的计数字典列表(uni-, bi-, tri-gram),以及全局词汇集合。

- 第11–16行 :

train()方法遍历每句话,添加起始符<s>和结束符</s>,确保边界处理一致。使用滑动窗口更新所有级别的n-gram计数。 - 第18–26行 :

get_prob()实现回退策略。优先尝试最高阶(trigram)匹配,失败则降阶至bigram、unigram,最后返回默认小概率值以防崩溃。 - 第28–34行 :测试案例演示模型训练与查询过程。输入简单语句后,询问

"learning"在"love deep"后出现的概率。

此模型虽未完全实现Kneser-Ney,但已体现N-gram建模的核心思想: 局部上下文建模 + 频率统计 + 回退机制 。尽管其效率高且易于部署,但在面对长程依赖、罕见搭配或动态语言变化时仍显乏力。

4.1.2 基于LanguageModel2.py实现统计语言模型

进一步扩展上述思路,可封装成独立脚本 LanguageModel2.py ,支持文件读取、持久化保存与命令行接口。典型结构如下图所示:

graph TD

A[输入原始文本] --> B[分词与预处理]

B --> C[构建N-gram计数表]

C --> D[应用平滑算法]

D --> E[存储语言模型文件]

E --> F[加载模型用于评分]

F --> G[输出句子概率或困惑度]

该流程体现了从原始语料到可用模型的完整生命周期。例如,在ASR后端解码中,每个候选句子都会被送入该模型打分,最终与声学得分加权融合得到最优结果。

此外,可通过构建混淆矩阵分析常见错误类型。例如,若模型频繁误判“recognize speech”为“wreck a nice beach”,说明其缺乏对音近词的区分能力,需增强训练数据多样性或引入发音词典约束。

综上,N-gram作为语言建模的基础工具,虽已被深度学习取代主流地位,但仍广泛应用于轻量级系统、初始基线对比及混合解码框架中。理解其工作原理有助于把握语言建模的根本挑战: 如何在有限数据下合理估计无限可能的语义序列 。

4.2 RNN与LSTM在语言建模中的优势

传统的前馈神经网络无法处理变长序列,而语音识别中的语言单位天然具有时间连续性。循环神经网络(RNN)因其内部隐藏状态机制,成为首个能显式建模序列依赖的神经结构。然而标准RNN存在严重的梯度消失/爆炸问题,难以捕获长距离依赖。LSTM通过引入门控单元解决了这一瓶颈,极大提升了语言建模性能。

4.2.1 序列建模与长期依赖问题

考虑一句话:“The cat, which was very hungry and had not eaten all day, finally found some food.” 当预测最后一个词“food”时,人类会自然联想到开头的“cat”和“hungry”。但标准RNN在反向传播过程中,误差信号随时间步呈指数衰减,导致早期输入的影响几乎归零。

数学上,RNN的隐藏状态更新公式为:

h_t = \tanh(W_{hh} h_{t-1} + W_{xh} x_t + b_h)

其梯度路径涉及连乘项 $ \frac{\partial h_t}{\partial h_{t-k}} \propto \prod_{i=1}^{k} \frac{\partial h_i}{\partial h_{i-1}} $,若雅可比矩阵谱半径小于1,则远距离梯度迅速趋近于零。

LSTM通过设计三个门控结构——遗忘门 $ f_t $、输入门 $ i_t $、输出门 $ o_t $——控制信息流动:

\begin{aligned}

f_t &= \sigma(W_f \cdot [h_{t-1}, x_t] + b_f) \

i_t &= \sigma(W_i \cdot [h_{t-1}, x_t] + b_i) \

\tilde{C} t &= \tanh(W_C \cdot [h {t-1}, x_t] + b_C) \

C_t &= f_t \odot C_{t-1} + i_t \odot \tilde{C} t \

o_t &= \sigma(W_o \cdot [h {t-1}, x_t] + b_o) \

h_t &= o_t \odot \tanh(C_t)

\end{aligned}

其中 $ \odot $ 表示逐元素相乘,$ \sigma $ 为sigmoid函数。细胞状态 $ C_t $ 提供了一条“高速公路”,允许信息跨多个时间步稳定传递。

下表比较了RNN与LSTM的关键特性:

| 特性 | RNN | LSTM |

|---|---|---|

| 是否支持长期记忆 | 否 | 是(通过细胞状态) |

| 梯度稳定性 | 差(易消失) | 较好(门控调节) |

| 参数数量 | 较少 | 较多(四倍门控权重) |

| 训练难度 | 易发散 | 需 careful 初始化 |

| 推理速度 | 快 | 稍慢 |

可见,LSTM以增加计算复杂度为代价换取了更强的表达能力。

4.2.2 LSTM结构与GRU结构对比

门控循环单元(GRU)是LSTM的简化版本,合并遗忘门与输入门为更新门 $ z_t $,并将细胞状态与隐藏状态融合:

\begin{aligned}

z_t &= \sigma(W_z \cdot [h_{t-1}, x_t]) \

r_t &= \sigma(W_r \cdot [h_{t-1}, x_t]) \

\tilde{h} t &= \tanh(W_h \cdot [r_t \odot h {t-1}, x_t]) \

h_t &= (1 - z_t) \odot h_{t-1} + z_t \odot \tilde{h}_t

\end{aligned}

虽然GRU参数更少、训练更快,但在长序列任务上通常略逊于LSTM。以下是两者的结构差异可视化表示:

graph LR

subgraph LSTM

A[Forget Gate] --> C[Cell State]

B[Input Gate] --> C

C --> D[Output Gate]

D --> E[Hidden State]

end

subgraph GRU

F[Update Gate] --> G[Combined State]

H[Reset Gate] --> G

G --> H

end

实验表明,在语言建模任务中,LSTM在WikiText-2等基准数据集上的困惑度普遍低于GRU约1–3点,尤其是在深层堆叠时优势更明显。因此,对于精度优先的应用(如专业术语识别、法律文书转录),推荐使用LSTM。

4.3 LSTM语言模型的训练与推理流程

构建高性能语言模型不仅需要合理的网络结构,还需精细的数据预处理、训练策略与评估体系。本节将以PyTorch为例,详细展示如何从零开始实现一个可训练的LSTM语言模型。

4.3.1 词向量嵌入与序列输入处理

首先需将离散词元映射为连续向量。PyTorch提供 nn.Embedding 层完成此项任务:

import torch

import torch.nn as nn

class LSTMLanguageModel(nn.Module):

def __init__(self, vocab_size, embed_dim, hidden_dim, num_layers=1):

super().__init__()

self.embedding = nn.Embedding(vocab_size, embed_dim)

self.lstm = nn.LSTM(embed_dim, hidden_dim, num_layers, batch_first=True)

self.fc = nn.Linear(hidden_dim, vocab_size)

def forward(self, x, hidden=None):

x = self.embedding(x) # [B, T] -> [B, T, D]

out, hidden = self.lstm(x, hidden)

logits = self.fc(out) # [B, T, H] -> [B, T, V]

return logits, hidden

参数说明与逻辑分析

-

vocab_size: 词汇表大小,决定Embedding层行数; -

embed_dim: 词向量维度,常用128~512; -

hidden_dim: LSTM隐藏层维度,影响模型容量; -

num_layers: 堆叠层数,深层结构可提取更高阶特征; -

batch_first=True: 输入张量形状为[batch_size, seq_len, features],便于批处理。

训练时需准备按时间步切片的序列样本。例如,输入 "I love NLP" ,目标为 "love NLP <eos>" ,形成自回归监督信号。

4.3.2 使用PyTorch实现LSTM语言模型训练

完整训练脚本应包含数据加载、损失计算、优化器配置等环节:

from torch.utils.data import Dataset, DataLoader

class TextDataset(Dataset):

def __init__(self, token_ids, seq_len):

self.tokens = token_ids

self.seq_len = seq_len

def __len__(self):

return max(1, len(self.tokens) - self.seq_len)

def __getitem__(self, idx):

x = self.tokens[idx:idx+self.seq_len]

y = self.tokens[idx+1:idx+self.seq_len+1]

return torch.tensor(x), torch.tensor(y)

# 初始化模型与训练参数

model = LSTMLanguageModel(vocab_size=10000, embed_dim=256, hidden_dim=512, num_layers=2)

criterion = nn.CrossEntropyLoss(ignore_index=0) # 忽略padding索引

optimizer = torch.optim.Adam(model.parameters(), lr=1e-3)

dataset = TextDataset(train_tokens, seq_len=50)

loader = DataLoader(dataset, batch_size=32, shuffle=True)

# 训练循环

for epoch in range(10):

model.train()

total_loss = 0

for x_batch, y_batch in loader:

optimizer.zero_grad()

logits, _ = model(x_batch)

loss = criterion(logits.view(-1, logits.size(-1)), y_batch.contiguous().view(-1))

loss.backward()

torch.nn.utils.clip_grad_norm_(model.parameters(), 0.5) # 防止梯度爆炸

optimizer.step()

total_loss += loss.item()

print(f"Epoch {epoch+1}, Loss: {total_loss/len(loader):.4f}")

关键技术点解析

- CrossEntropyLoss 自动对最后一维做Softmax并计算负对数似然;

-

view(-1, ...)展平序列维度以便批量计算; -

clip_grad_norm_控制梯度幅值,稳定训练过程; - 使用固定长度截断(Truncated BPTT)降低内存消耗。

训练完成后,可通过生成式推理测试模型能力:

def generate(model, start_words, word_to_idx, idx_to_word, max_len=20):

model.eval()

input_ids = [word_to_idx[w] for w in start_words.split()]

hidden = None

for _ in range(max_len):

x = torch.tensor([input_ids[-50:]]).long()

with torch.no_grad():

logits, hidden = model(x, hidden)

pred_id = logits[:, -1, :].argmax(-1).item()

input_ids.append(pred_id)

if pred_id == word_to_idx['<eos>']:

break

return ' '.join([idx_to_word[i] for i in input_ids])

该函数实现了基于贪心搜索的文本生成,可用于检验模型是否掌握语法结构与常见搭配。

综上,LSTM语言模型凭借其强大的序列建模能力,在语音识别解码阶段发挥关键作用。尽管近年来被Transformer超越,但在边缘设备、低延迟场景中仍有广泛应用价值。掌握其完整实现流程,是迈向端到端语音识别的重要一步。

5. Transformer模型与端到端语音识别

随着深度学习技术的不断演进,传统基于声学模型与语言模型分离架构的语音识别系统逐渐暴露出其在建模长距离依赖、跨模块误差传播以及训练-推理不一致等方面的局限性。近年来, Transformer 模型 因其强大的序列建模能力,在自然语言处理领域取得突破后,迅速被引入语音识别任务中,并推动了 端到端(End-to-End, E2E)语音识别系统 的发展。这类系统能够直接将原始音频输入映射为文本输出,省去复杂的中间对齐和解码流程,极大提升了建模效率与泛化能力。

本章深入探讨 Transformer 在语音识别中的核心机制及其适配方法,重点分析 Attention 机制的工作原理、Transformer 编码器-解码器结构如何应用于语音信号处理,以及 CTC(Connectionist Temporal Classification)损失函数在解决输入输出长度不对齐问题中的关键作用。通过理论推导、代码实现与流程图解析相结合的方式,全面揭示现代端到端语音识别系统的构建逻辑与优化路径。

5.1 Attention机制与自注意力机制详解

Attention 机制最初作为提升神经机器翻译性能的一种手段被提出,它允许模型在生成目标序列时动态关注源序列的不同部分。而在 Transformer 中, 自注意力机制(Self-Attention) 成为核心组件,彻底取代了传统的循环或卷积结构,实现了并行化处理与全局依赖捕捉。

5.1.1 Query-Key-Value机制与Softmax计算

自注意力机制的核心思想是:每个时间步的表示不仅取决于自身,还应结合上下文中其他位置的信息进行加权聚合。这一过程通过三个可学习的线性变换得到查询向量(Query)、键向量(Key)和值向量(Value),即所谓的 QKV 架构 。

数学表达如下:

\text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V

其中:

- $ Q \in \mathbb{R}^{n \times d_k} $:查询矩阵,代表当前需要关注的内容;

- $ K \in \mathbb{R}^{m \times d_k} $:键矩阵,用于匹配查询;

- $ V \in \mathbb{R}^{m \times d_v} $:值矩阵,存储实际信息;

- $ d_k $:键向量维度,缩放因子 $ \sqrt{d_k} $ 防止点积过大导致梯度消失;

- $ n, m $:分别为目标序列和源序列长度。

该公式的执行逻辑可分为以下步骤:

- 计算 Query 与所有 Key 的相似度(通常使用点积);

- 使用 Softmax 归一化得分,获得注意力权重;

- 将权重应用于 Value 向量,进行加权求和,输出融合上下文信息的新表示。

这种机制使得任意两个位置之间的依赖关系都可以被直接建模,不受距离限制,非常适合处理语音信号中潜在的长跨度语义关联。

示例代码:基础自注意力实现(PyTorch)

import torch

import torch.nn as nn

import torch.nn.functional as F

class SelfAttention(nn.Module):

def __init__(self, embed_dim):

super(SelfAttention, self).__init__()

self.embed_dim = embed_dim

self.query = nn.Linear(embed_dim, embed_dim)

self.key = nn.Linear(embed_dim, embed_dim)

self.value = nn.Linear(embed_dim, embed_dim)

def forward(self, x):

# x: (batch_size, seq_len, embed_dim)

Q = self.query(x) # Linear transform to query space

K = self.key(x) # Linear transform to key space

V = self.value(x) # Linear transform to value space

attn_scores = torch.matmul(Q, K.transpose(-2, -1)) / (self.embed_dim ** 0.5)

attn_weights = F.softmax(attn_scores, dim=-1)

output = torch.matmul(attn_weights, V)

return output, attn_weights

代码逻辑逐行解读与参数说明:

-

nn.Linear(embed_dim, embed_dim):定义三个独立的全连接层,分别将输入映射到 Q、K、V 空间。虽然维度相同,但参数不共享。 -

x输入形状为(batch_size, seq_len, embed_dim),对应一批次语音帧特征(如梅尔频谱图经编码后的表示)。 -

torch.matmul(Q, K.transpose(-2, -1)):计算 Q 和 K 的点积,得到注意力分数矩阵,大小为(batch_size, seq_len, seq_len)。 -

/ (self.embed_dim ** 0.5):缩放操作,防止高维空间内点积过大,影响 Softmax 数值稳定性。 -

F.softmax(..., dim=-1):沿最后一个维度归一化,确保每行权重和为 1,形成概率分布。 - 最终输出

output是加权后的 Value 表示,保留了原始信息的同时融合了上下文语义。

此模块可用于语音编码器中,帮助模型聚焦于关键发音片段,例如区分“th”与“s”的细微差异。

5.1.2 多头注意力机制与位置编码

单一注意力头只能捕获一种类型的依赖模式,而现实语音信号包含多种语义层次(音素级、词级、句法级)。为此,Transformer 引入 多头注意力机制(Multi-Head Attention) ,允许多个注意力子空间并行工作,增强模型表达能力。

其公式扩展为:

\text{MultiHead}(Q,K,V) = \text{Concat}(head_1,…,head_h)W^O \

\text{where } head_i = \text{Attention}(QW_i^Q, KW_i^K, VW_i^V)

其中:

- $ h $:注意力头数;

- $ W_i^Q, W_i^K, W_i^V \in \mathbb{R}^{d_{model} \times d_k} $:各头的投影矩阵;

- $ W^O \in \mathbb{R}^{hd_v \times d_{model}} $:输出投影矩阵。

此外,由于自注意力本身不具备顺序感知能力,必须显式加入 位置编码(Positional Encoding) 来保留序列顺序信息。原始论文采用正弦/余弦函数构造固定编码:

PE_{(pos,2i)} = \sin(pos / 10000^{2i/d_{model}}) \

PE_{(pos,2i+1)} = \cos(pos / 10000^{2i/d_{model}})

其中 $ pos $ 是位置索引,$ i $ 是维度索引。

流程图:多头注意力结构(Mermaid 格式)

graph TD

A[Input Sequence] --> B[Add Positional Encoding]

B --> C[Linear Projection to Q, K, V]

C --> D1[Head 1: Scaled Dot-Product]

C --> D2[Head 2: Scaled Dot-Product]

C --> Dn[Head h: Scaled Dot-Product]

D1 --> E[Concatenate Heads]

D2 --> E

Dn --> E

E --> F[Linear Output Projection]

F --> G[Multi-Head Output]

该流程清晰展示了从输入嵌入添加位置信息,到多头并行计算,再到拼接与投影的整体流程。

实现代码:多头注意力模块

class MultiHeadAttention(nn.Module):

def __init__(self, embed_dim, num_heads):

super(MultiHeadAttention, self).__init__()

assert embed_dim % num_heads == 0

self.num_heads = num_heads

self.head_dim = embed_dim // num_heads

self.embed_dim = embed_dim

self.q_proj = nn.Linear(embed_dim, embed_dim)

self.k_proj = nn.Linear(embed_dim, embed_dim)

self.v_proj = nn.Linear(embed_dim, embed_dim)

self.out_proj = nn.Linear(embed_dim, embed_dim)

def split_heads(self, x, batch_size):

x = x.view(batch_size, -1, self.num_heads, self.head_dim)

return x.transpose(1, 2) # (batch_size, num_heads, seq_len, head_dim)

def forward(self, x):

batch_size = x.size(0)

Q = self.q_proj(x)

K = self.k_proj(x)

V = self.v_proj(x)

Q = self.split_heads(Q, batch_size)

K = self.split_heads(K, batch_size)

V = self.split_heads(V, batch_size)

attn_scores = torch.matmul(Q, K.transpose(-2, -1)) / (self.head_dim ** 0.5)

attn_weights = F.softmax(attn_scores, dim=-1)

attn_output = torch.matmul(attn_weights, V) # (b, h, t, d)

attn_output = attn_output.transpose(1, 2).contiguous()

attn_output = attn_output.view(batch_size, -1, self.embed_dim)

return self.out_proj(attn_output), attn_weights

参数说明与逻辑分析:

-

assert embed_dim % num_heads == 0:保证可以平均分割成多个头; -

split_heads()方法将(batch, seq_len, embed_dim)变形为(batch, heads, seq_len, head_dim),便于并行计算; -

transpose(1,2)调整张量布局以符合多头运算习惯; -

contiguous().view()恢复为二维结构以便送入输出层; -

out_proj是最终线性层,整合多头信息。

该模块广泛应用于 Conformer、Whisper 等先进语音识别模型中,显著提升对复杂语音上下文的理解能力。

5.2 Transformer模型结构与语音识别适配

尽管原始 Transformer 设计用于文本到文本任务,但其强大的建模能力使其成为端到端语音识别的理想选择。然而,语音信号具有不同于文本的特点:采样率高、序列长、局部相关性强。因此需对标准 Transformer 进行针对性调整。

5.2.1 编码器-解码器结构在语音识别中的应用

标准 Transformer 包含编码器(Encoder)和解码器(Decoder)两大部分:

- 编码器 :由多个相同的层堆叠而成,每层包括多头自注意力 + 前馈网络,辅以残差连接与层归一化;

- 解码器 :除自注意力外,还包含编码器-解码器注意力(Encoder-Decoder Attention),用于关注编码结果。

在语音识别任务中:

- 输入 :梅尔频谱图或滤波器组特征(shape: [T, D] );

- 输出 :字符或子词单元序列(如 BPE tokens);

典型流程如下:

- 提取音频特征 → 添加位置编码;

- 经过若干 Transformer 编码层提取高层语义;

- 解码器逐词生成文本,利用编码器输出进行注意力聚焦;

- 输出 softmax 分布预测下一个 token。

这种方式避免了传统 HMM-GMM 或 CTC+RNN 结构的繁琐流程,实现真正意义上的“端到端”。

表格:Transformer 编码器层组件对比

| 组件 | 功能描述 | 输入/输出维度 |

|---|---|---|

| 多头自注意力 | 捕获帧间依赖关系 | [B,T,D] → [B,T,D] |

| 残差连接 | 缓解深层网络梯度消失 | 直接相加 |

| 层归一化(LayerNorm) | 稳定训练过程 | 对特征维度归一化 |

| 前馈网络(FFN) | 非线性变换,扩大感受野 | D → 4D → D |

| Dropout | 正则化防止过拟合 | 一般设为 0.1~0.3 |

注:B=batch size, T=sequence length, D=model dimension

该结构已被成功应用于 Google 的 Speech Transducer、Facebook 的 wav2vec 2.0 与 OpenAI 的 Whisper 模型中。

5.2.2 使用Transformer实现端到端语音识别

下面展示一个简化的端到端语音识别模型实现框架,基于 PyTorch 构建。

完整模型类定义

class TransformerASR(nn.Module):

def __init__(self, input_dim, vocab_size, d_model=512, nhead=8, num_encoder_layers=6, num_decoder_layers=6):

super().__init__()

self.feature_projection = nn.Linear(input_dim, d_model)

self.pos_encoder = PositionalEncoding(d_model)

encoder_layer = nn.TransformerEncoderLayer(d_model=d_model, nhead=nhead)

self.transformer_encoder = nn.TransformerEncoder(encoder_layer, num_layers=num_encoder_layers)

self.decoder_embedding = nn.Embedding(vocab_size, d_model)

decoder_layer = nn.TransformerDecoderLayer(d_model=d_model, nhead=nhead)

self.transformer_decoder = nn.TransformerDecoder(decoder_layer, num_layers=num_decoder_layers)

self.output_proj = nn.Linear(d_model, vocab_size)

def forward(self, src_mel, tgt_tokens, src_mask=None, tgt_mask=None):

# src_mel: (B, T, F) -> mel-spectrogram

# tgt_tokens: (B, L) -> target text indices

src_feat = self.feature_projection(src_mel) # Map to d_model

src_feat = self.pos_encoder(src_feat) # Add positional info

memory = self.transformer_encoder(src_feat.permute(1,0,2)) # (T,B,D)

tgt_emb = self.decoder_embedding(tgt_tokens) # (B,L,D)

tgt_emb = self.pos_encoder(tgt_emb)

decoder_out = self.transformer_decoder(

tgt_emb.permute(1,0,2), memory, tgt_mask=tgt_mask

) # (L,B,D)

logits = self.output_proj(decoder_out).permute(1,0,2) # (B,L,vocab)

return logits

逻辑分析与参数说明:

-

input_dim:通常为 80(梅尔频带数); -

feature_projection:将高维频谱映射到模型统一维度; -

pos_encoder:自定义位置编码类,支持正弦或可学习方式; -

src_mel.permute(1,0,2):Transformer 要求时间步在第一维(seq_len, batch, feature); -

memory:编码器输出,供解码器通过 Encoder-Decoder Attention 使用; -

tgt_mask:防止未来 token 泄露(因果掩码); -

logits:未归一化的词表概率分布,后续配合 CrossEntropyLoss 训练。

此模型可在 LibriSpeech 等数据集上训练,配合 BPE 分词与束搜索(Beam Search)解码,达到接近人类水平的识别精度。

5.3 CTC损失函数与模型训练策略

尽管 Transformer 解码器适合自回归生成,但在某些场景下(如实时识别),非自回归模型更具优势。 CTC(Connectionist Temporal Classification) 提供了一种无需强制对齐即可训练序列模型的方法,尤其适用于输入远长于输出的任务(如语音→文字)。

5.3.1 CTC原理与对齐问题解决

CTC 的核心在于引入一个特殊符号 <blank> ,允许模型在输出序列中插入空白或重复字符,从而灵活应对不同速率的发音变化。

假设输入有 $ T $ 帧,输出为 $ U $ 个字符,则 CTC 寻找所有能压缩成目标标签的路径,并对其概率求和:

P(Y|X) = \sum_{\pi \in \mathcal{A}(Y)} P(\pi|X)

其中 $ \pi $ 是对齐路径,$ \mathcal{A}(Y) $ 是所有可折叠为 Y 的路径集合。

折叠规则:

- 合并连续相同字符;

- 删除 <blank> 符号。

例如:

- 路径 [h,h,_,e,l,l,l,o] 折叠为 "hello" ;

- 而 [h,e,l,o] 无法对齐,除非补足帧数。

CTC 通过前向-后向算法高效计算总概率及梯度,支持端到端训练。

Mermaid 流程图:CTC 对齐与折叠过程

graph LR

A[Audio Frames T=10] --> B[CTC Head Outputs]

B --> C{Per-frame Prediction}

C --> D["[<b>, 'h', <b>, 'h', 'e', 'l', 'l', 'o', <b>, <b>]"]

D --> E[Fold Repeats & Remove Blanks]

E --> F["Output: 'hello'"]

该机制允许模型自动学习帧到符号的映射,无需人工标注对齐信息。

5.3.2 端到端模型的训练与解码策略

结合 CTC 的 Transformer 模型常被称为 Transformer-CTC ,其训练目标简化为最大化对数似然:

\mathcal{L}_{CTC} = -\log P(Y|X)

训练时只需提供音频与转录文本,无需对齐。

推理阶段解码方法对比

| 解码方法 | 描述 | 优点 | 缺点 |

|---|---|---|---|

| 贪心搜索(Greedy) | 每步选最高概率 token | 快速 | 易陷入局部最优 |

| 束搜索(Beam Search) | 维护 top-k 候选路径 | 更准确 | 计算开销大 |

| Prefix Score + CTC Rescoring | 结合语言模型重打分 | 提升流畅性 | 复杂度高 |

示例代码:CTC 训练与解码

import torch.nn.functional as F

# 假设 model 输出为 log_probs (T, B, vocab_size)

log_probs = F.log_softmax(model(src_mel), dim=-1)

input_lengths = torch.full((batch_size,), log_probs.size(0))

target_lengths = torch.tensor([len(t) for t in targets])

loss = F.ctc_loss(log_probs, targets, input_lengths, target_lengths, blank=0)

# 解码(贪心)

_, preds = log_probs.max(dim=-1) # (T,)

decoded = remove_blank_and_merge(preds)

其中 remove_blank_and_merge 函数实现去空与去重:

def remove_blank_and_merge(seq, blank_id=0):

result = []

prev = None

for idx in seq:

if idx != blank_id and idx != prev:

result.append(idx)

prev = idx

return result

该策略已在 ESPnet、DeepSpeech2 等开源工具链中广泛应用,支持工业级部署。

综上所述,Transformer 与 CTC 的结合构成了现代端到端语音识别系统的基石,兼顾准确性与工程实用性,标志着语音识别进入智能化新阶段。

6. 语音识别系统的部署与优化

6.1 模型压缩与加速技术

随着深度学习模型在语音识别领域的广泛应用,模型参数规模不断增长,对部署和推理效率提出了更高要求。为适应移动端、嵌入式设备和低延迟场景,模型压缩与加速技术成为部署阶段的重要手段。

6.1.1 量化与剪枝技术在语音模型中的应用

量化(Quantization) 是将模型中的浮点数权重转换为低精度表示(如8位整数),从而减少内存占用和提升推理速度。

- 优点 :减少模型大小、提升推理速度、降低功耗。

- 应用场景 :适合部署在移动设备、边缘设备中。

import torch

# 使用PyTorch进行动态量化

model = torch.jit.load("asr_model.pt")

quantized_model = torch.quantization.quantize_dynamic(

model, {torch.nn.Linear}, dtype=torch.qint8

)

torch.jit.save(quantized_model, "asr_model_quantized.pt")

剪枝(Pruning) 是通过移除冗余神经元或连接来减少模型复杂度。

- 结构化剪枝 :移除整个卷积核或通道。

- 非结构化剪枝 :移除单个连接,适用于GPU推理优化。

import torch.nn.utils.prune as prune

# 对模型进行非结构化L1剪枝

parameters_to_prune = [

(module, 'weight') for module in model.modules()

if isinstance(module, torch.nn.Conv2d) or isinstance(module, torch.nn.Linear)

]

prune.global_unstructured(

parameters_to_prune,

pruning_method=prune.L1Unstructured,

amount=0.3, # 剪枝30%连接

)

6.1.2 使用ONNX或TensorRT优化推理速度

ONNX(Open Neural Network Exchange) 是一个开放的模型格式,支持多种框架之间的模型转换与优化。

import torch.onnx

# 导出模型为ONNX格式

dummy_input = torch.randn(1, 80, 300) # 示例输入

torch.onnx.export(model, dummy_input, "asr_model.onnx")

TensorRT 是NVIDIA提供的高性能推理优化引擎,特别适用于GPU部署。

- 支持INT8量化、层融合、内存优化等高级优化策略。

- 可以显著提升语音识别模型的推理速度。

# 使用TensorRT转换ONNX模型

trtexec --onnx=asr_model.onnx --saveEngine=asr_model.trt --int8

6.2 语音识别系统的部署流程

语音识别系统的部署流程需要兼顾服务端和客户端的性能、可用性与扩展性。

6.2.1 服务端部署与API接口设计

典型的语音识别系统部署架构包括:

graph TD

A[客户端上传音频] --> B(API网关)

B --> C[负载均衡器]

C --> D[语音识别服务集群]

D --> E[模型推理引擎]

E --> F[返回识别结果]

API接口设计示例(Flask框架) :

from flask import Flask, request, jsonify

import torch

app = Flask(__name__)

model = torch.load("asr_model.pt")

@app.route("/recognize", methods=["POST"])

def recognize():

audio_data = request.files["audio"].read()

# 预处理音频并推理

result = model.predict(audio_data)

return jsonify({"text": result})

if __name__ == "__main__":

app.run(host="0.0.0.0", port=5000)

6.2.2 在线识别与离线识别的工程实现

- 在线识别 :适用于实时场景,如语音助手、会议记录等,要求低延迟和高并发处理能力。

- 离线识别 :适用于批量处理长音频文件,如语音转文字、视频字幕生成。

| 部署方式 | 适用场景 | 推理延迟 | 网络依赖 | 模型大小限制 |

|---|---|---|---|---|

| 在线识别 | 实时语音交互 | < 200ms | 强依赖 | 无限制 |

| 离线识别 | 批量处理音频 | 可容忍 | 弱依赖 | 可压缩优化 |

6.3 性能调优与实际应用问题处理

6.3.1 实时语音识别的延迟优化

延迟是影响用户体验的关键因素。优化手段包括:

- 模型轻量化 :采用轻量级模型如Conformer-Tiny、MobileNetV3。

- 流式识别机制 :使用Chunk-based Conformer模型,实现边录音边识别。

- 多线程/异步处理 :将音频采集、预处理与推理分离处理。

# 示例:使用线程处理实时音频流

import threading

def audio_stream_processor(stream):

while True:

chunk = stream.read(1600) # 16kHz采样,100ms片段

threading.Thread(target=recognize_chunk, args=(chunk,)).start()

def recognize_chunk(chunk):

features = extract_features(chunk)

result = model.infer(features)

print(result)

6.3.2 多语种与方言识别的支持策略

多语种语音识别系统需支持多种语言模型和声学模型的切换机制。

- 统一模型 :训练一个多语言模型,共享底层特征提取层。

- 插件式架构 :根据输入语言动态加载不同模型。

class MultiLangASR:

def __init__(self):

self.models = {

"zh": load_model("zh_model.pt"),

"en": load_model("en_model.pt"),

"es": load_model("es_model.pt")

}

def recognize(self, audio, lang="zh"):

return self.models[lang].predict(audio)

此外,对于方言识别,可采用以下策略:

- 数据增强 :在训练集中加入方言变体。

- 迁移学习 :以标准语言模型为基模型,微调方言数据。

- 混合模型 :将方言识别作为模型的一个分支进行联合训练。

简介:本文围绕“语音识别数据集合1”及配套的 LanguageModel2.py 统计语言模型展开讲解。该数据集包含大量音频文件与对应文本,用于训练语音识别系统,涵盖训练集、验证集和测试集划分。语言模型采用N-gram、LSTM或Transformer等技术,提升识别的上下文理解能力。系统整体可能结合声学模型与语言模型,使用CTC或Attention机制实现高效语音到文本的转换。文章提供详细的网络搭建步骤和实战指导,帮助读者掌握语音识别系统构建全流程。

1178

1178

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?