简介:在Spark编程中,RDD是处理大规模数据集的关键组件,对于特定需求,如优化数据倾斜,可能需要自定义RDD来提高效率。本文提供了示例代码"自定义RDD-从HDFS读取数据代码.zip",深入探讨了如何通过实现自定义迭代器和RDD,从HDFS高效读取数据。文章详细描述了自定义RDD的创建、分区定义、迭代器设计、计算逻辑、持久化优化和测试验证过程,为解决数据处理问题提供了实际解决方案。

1. Spark RDD核心概念

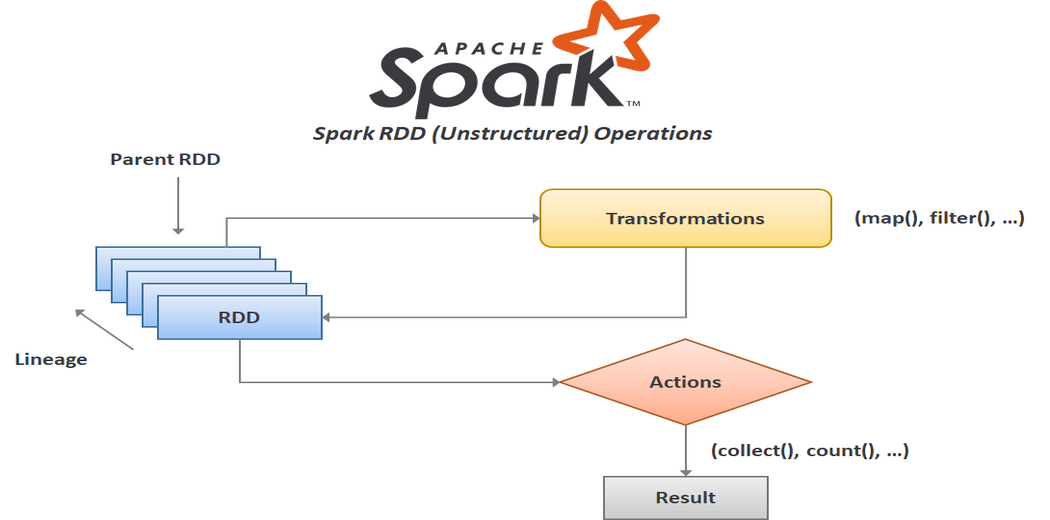

在大数据处理框架中,Apache Spark 是一个广受欢迎的选择,它提供了快速的集群计算能力。RDD(弹性分布式数据集)是 Spark 中的一个核心抽象,代表一个不可变、分布式的数据集合,能够并行操作。了解 RDD 的核心概念对于掌握 Spark 的工作方式至关重要。

1.1 RDD的定义与特点

RDD 本质上是一系列不可变对象的分区集合。为了提高容错性和并行操作的效率,它能够被自动分区到多个节点上。每个节点对分区中的数据执行操作,并且操作都是确定性的。这些特点使得 RDD 在数据处理时,既可靠又高效。

1.2 RDD的操作类型

RDD 支持两种类型的操作:转换(transformations)和动作(actions)。转换操作生成新的 RDD,例如 map、filter 和 reduceByKey。动作操作则触发计算并返回结果,如 count、collect 和 saveAsTextFile。转换和动作共同构成了 RDD 的操作管道。

1.3 RDD的依赖关系与惰性求值

RDD 的每个分区都维护着对于父分区的依赖关系。这种依赖关系是实现容错的关键,因为 Spark 只需要重新计算丢失的分区。RDD 的惰性求值模型意味着它不会立即执行计算,而是在遇到动作操作时才计算。

通过这些核心概念,我们可以看到 RDD 如何为大规模数据处理提供强大的抽象模型,从而成为 Spark 体系结构中的基石。在接下来的章节中,我们将探索如何优化 Spark 的数据处理性能,并深入了解更高级的 RDD 操作和自定义实现。

2. 数据倾斜问题及解决方案

数据倾斜是分布式计算中常见的问题,其特征是数据分布不均匀,导致部分计算节点任务繁重,而其他节点则空闲,造成系统性能下降。在本章节中,我们将深入了解数据倾斜的原理、识别方法和解决方案。

2.1 数据倾斜的产生原理

2.1.1 数据倾斜的概念

数据倾斜是指在分布式计算任务中,由于数据分布不均匀,导致部分任务处理的数据量远超过其他任务,造成计算资源的浪费和性能瓶颈。数据倾斜通常发生在map端和reduce端。Map端数据倾斜通常发生在数据读取和初步处理阶段,而Reduce端数据倾斜发生在数据汇总和处理阶段。

2.1.2 数据倾斜的影响分析

数据倾斜可能导致部分执行节点过载,而其他节点资源利用不足,从而降低整个集群的处理能力和效率。在极端情况下,倾斜的数据量可能会超出节点内存限制,导致内存溢出错误和任务失败。此外,数据倾斜还会延长作业的整体执行时间,增加作业处理成本。

2.2 数据倾斜的识别方法

2.2.1 直观识别数据倾斜

直观识别数据倾斜可以通过观察执行计划和作业监控来完成。查看各个任务处理的数据量,如果出现某些任务处理的数据量明显高于平均水平,即可初步判断存在数据倾斜现象。

2.2.2 通过日志和监控工具定位数据倾斜

更精确地定位数据倾斜,可以通过查看分布式计算框架的执行日志、监控指标和性能报告。例如,在Spark作业中,可以通过查看每个任务的执行时间、数据处理量和Shuffle读写量等指标来判断数据是否倾斜。具体可以通过 /driver/log 获取任务执行日志,或使用 Spark UI 的 SQL 、 Stage 和 Storage 标签页来进行分析。

2.3 数据倾斜的解决方案

2.3.1 优化数据分布策略

解决数据倾斜的一个有效方法是优化数据分布策略。首先,可以通过合理选择分区器来实现。例如,使用 HashPartitioner 或自定义分区器确保数据均匀分布到各个任务。其次,可以通过添加随机前缀或后缀来打乱数据分布,从而避免某一类数据过于集中。

2.3.2 调整并行度和任务划分

调整作业的并行度和任务划分也可以缓解数据倾斜问题。增加并行度可以增加作业的并发处理能力,从而缩短作业的整体执行时间。同时,通过合理划分任务,可以减少单个任务处理的数据量,避免部分任务处理量过大而导致倾斜。

接下来,我们通过具体案例来深入探讨数据倾斜问题的解决方案,以及如何在实际操作中应用这些策略来优化Spark作业的性能。

3. 自定义迭代器实现细节

3.1 迭代器的基本原理

3.1.1 迭代器的设计思想

迭代器设计思想是用于顺序访问集合对象的接口,它使得我们可以从集合的开头到结尾逐个访问集合中的每个元素而不需要了解集合对象内部结构。这种设计允许使用者以一种统一的方式对各种不同的数据结构进行迭代访问。

迭代器通常包括以下核心功能:

- 初始化 :迭代器的初始化往往需要一个数据集合或者指向数据集合开始的地方。

- 遍历 :迭代器会按照某种顺序来访问集合中的元素。

- 状态管理 :迭代器通常需要跟踪当前访问的位置,以便下一次访问能从上次停止的地方继续。

- 结束条件 :迭代器需要知道何时到达集合的末尾,以终止遍历过程。

迭代器模式常应用于那些需要控制集合元素访问顺序的场景,例如处理大量数据时,我们会希望逐个处理集合中的元素,而不是一次性加载整个集合到内存中。

3.1.2 迭代器的工作流程

迭代器的工作流程通常涉及以下几个步骤:

- 创建迭代器实例,这个实例会包含一个指向数据集的引用。

- 调用

hasNext()方法检查是否还有元素可以访问。如果有,返回true;否则返回false。 - 当

hasNext()返回true时,使用next()方法来获取下一个元素。 - 重复步骤2和3直到

hasNext()返回false。

迭代器模式使得集合的使用者与集合的内部实现解耦,从而可以应对数据结构变化而不影响使用它们的代码。

3.2 自定义迭代器的关键要素

3.2.1 迭代器的接口实现

自定义迭代器需要实现特定的接口,例如在Java中,这通常意味着实现 Iterator 接口。以下是实现 Iterator 接口的基本要求:

public interface Iterator<T> {

boolean hasNext(); // 返回是否有下一个元素

T next(); // 返回下一个元素并前进迭代器位置

void remove(); // 删除当前迭代器返回的最后一个元素

}

实现时,需要定义这些方法的具体行为:

public class CustomIterator<T> implements Iterator<T> {

private List<T> elements; // 存储元素的数据结构

private int position; // 迭代器当前的位置

public CustomIterator(List<T> elements) {

this.elements = elements;

this.position = 0;

}

@Override

public boolean hasNext() {

return position < elements.size();

}

@Override

public T next() {

if (hasNext()) {

return elements.get(position++);

}

throw new NoSuchElementException("No more elements to iterate");

}

@Override

public void remove() {

// 实现删除逻辑,注意需要维护元素的顺序和完整性

elements.remove(position - 1);

}

}

3.2.2 迭代器的状态管理和生命周期控制

迭代器的状态管理主要涉及到当前迭代的位置和是否已经访问完所有元素。生命周期控制则是指迭代器对象从创建到被销毁的整个过程。下面详细讲解这两部分:

状态管理

迭代器的状态通常包含迭代的位置以及是否完成迭代的标志。例如,可以有一个内部变量来跟踪当前元素的索引:

private int cursor; // 当前元素的位置

每次调用 next() 方法时, cursor 会增加,直到集合的末尾。当 cursor 等于集合的大小时,可以认为迭代结束。

生命周期控制

迭代器的生命周期与它所迭代的集合紧密相关。为了正确管理生命周期,需要在集合数据变化时更新迭代器状态,或者在迭代器使用完毕后进行清理工作,确保资源得到释放。如果是在自动垃圾回收的语言中,可能需要实现 finalize() 方法来处理资源清理;而在像Java这样的语言中,通常需要正确实现 close() 或 closeResource() 方法,避免资源泄露。

3.3 自定义迭代器的性能优化

3.3.1 减少迭代器的内存占用

迭代器应当尽量减少内存的使用。优化内存占用的关键在于减少迭代器内部存储的数据,以下是一些常用的技巧:

- 延迟加载 :不在迭代器初始化时加载所有数据,而是在访问每个元素时按需加载。

- 数据引用 :如果可能,使用引用而非数据的完整副本,减少内存占用。

- 内存优化的数据结构 :使用更节省内存的数据结构,如

ArrayList比LinkedList在遍历时更节省内存。

3.3.2 提高迭代器的执行效率

要提高迭代器的执行效率,可以考虑以下方法:

- 减少重复操作 :例如,预先计算好迭代过程中需要频繁使用的数据,避免在每次迭代中重复计算。

- 并行迭代 :如果数据集允许,可以将迭代过程拆分成多个部分,在多线程中并行执行。

- 避免不必要的对象创建 :对象创建和销毁本身是有开销的,应当尽量减少在迭代过程中创建临时对象。

举例来说,迭代器在遍历大数据集时可能会频繁调用 hasNext() 和 next() 方法,此时,优化这两个方法的性能至关重要。

public class EfficientIterator<T> implements Iterator<T> {

private Iterator<T> iterator; // 假设这是某集合的迭代器

public EfficientIterator(Iterable<T> collection) {

this.iterator = collection.iterator();

}

@Override

public boolean hasNext() {

return iterator.hasNext();

}

@Override

public T next() {

return iterator.next();

}

// 其他方法的优化

}

迭代器在性能优化时,应当根据实际应用场景来决定采取哪些措施,例如对内存敏感的场景更适合使用延迟加载和数据引用等技术。在需要高并发处理的场景,则可以考虑并行迭代等方案。

4. 自定义RDD继承与compute方法覆盖

4.1 自定义RDD的创建步骤

4.1.1 继承RDD类

Apache Spark RDD(弹性分布式数据集)是Spark的核心抽象,它是分布式内存中一个不可变、分区的集合对象。为了创建一个自定义的RDD,开发者需要继承RDD类,并为特定的数据处理逻辑实现它的子类。在继承RDD类时,你需要指定RDD元素的类型,这是通过泛型参数来完成的。

下面是一个简单的自定义RDD类的例子,它扩展了Spark的RDD类,并指定了元素类型为String:

import org.apache.spark.rdd.RDD

class CustomRDD(data: RDD[String]) extends RDD[String](data.context, Nil) {

override def compute(split: Partition, context: TaskContext): Iterator[String] = {

// 这里实现数据的分区处理逻辑

// 默认实现为空,需要根据具体的业务逻辑进行覆盖

???

}

}

在上述代码中, CustomRDD 类继承了 RDD[String] ,表示它将处理字符串类型的数据。 compute 方法是必须要覆盖的,因为它是执行实际分区计算的地方。这个方法接收一个 Partition 对象和 TaskContext ,并返回一个 Iterator ,该迭代器包含对应分区的数据。

4.1.2 覆盖compute方法

覆盖 compute 方法是实现自定义RDD核心逻辑的步骤之一。这个方法负责处理单个分区的数据。在自定义的 compute 方法中,开发者可以根据自己的需求编写分区数据处理的逻辑。

下面是一个具体的例子,展示如何覆盖 compute 方法来处理特定的分区数据:

override def compute(split: Partition, context: TaskContext): Iterator[String] = {

val sparkContext = context.sparkContext

// 假设分区数据以某种格式存储,例如CSV,我们需要解析它

val dataLines = dataLinesFromCSV(split, sparkContext)

// 解析后的数据行迭代器

dataLines.map(line => {

// 对每行数据执行特定的处理逻辑

processLine(line)

}).iterator

}

// 一个假设的辅助方法,用于从CSV格式的分区数据中获取数据行

def dataLinesFromCSV(split: Partition, sparkContext: SparkContext): Array[String] = {

// 这里实现从数据源中读取和解析数据的逻辑

???

}

// 一个假设的辅助方法,用于处理单行数据

def processLine(line: String): String = {

// 实现对单行数据的解析和转换逻辑

???

}

在该示例中, dataLinesFromCSV 方法负责读取和解析分区中的数据。例如,如果数据以CSV格式存储,则该方法将解析CSV文件并将每一行作为字符串返回。之后, processLine 方法处理每一行数据,完成实际的业务逻辑。

自定义RDD的实现依赖于对 compute 方法的覆盖,这使得开发者能够实现复杂的转换和动作操作。一旦数据被正确处理,它就可以通过转换操作链传递给其他RDD操作,或者直接作为动作操作的结果返回给驱动程序。

4.2 自定义RDD的并行计算原理

4.2.1 分区和任务的对应关系

在Spark中,每个RDD都划分为多个分区,每个分区代表数据的一个子集。这种分区机制允许Spark并行处理数据,提高处理大数据集时的效率。自定义RDD的并行计算原理遵循着相同的机制:Spark会根据用户定义的分区数量和数据所在位置,将任务分配给集群中的不同节点。

当自定义RDD通过 compute 方法处理数据时,每个分区都会被单独的处理任务所处理。这些任务在不同的执行器(Executor)上并行执行,从而达到分布式计算的效果。

// 假设一个自定义RDD的分区逻辑

override def getPartitions: Array[Partition] = {

val partitionCount = desiredPartitionCount() // 由用户定义的分区数量

(0 until partitionCount).map(i => new CustomPartition(i)).toArray

}

class CustomPartition(id: Int) extends Partition {

override def index: Int = id

}

在上面的代码片段中,自定义RDD定义了 getPartitions 方法,用于创建分区列表。这些分区随后会被并行地分配给不同的任务,每个任务负责一个分区的处理。在实际操作中,需要覆盖 getPartitions 方法以适应自定义RDD的具体需求。

4.2.2 并行计算的调度策略

Spark中的并行计算调度策略非常关键,它决定了任务如何在集群中分配。调度器主要负责将分区分配给执行器,以及根据任务的需要和集群资源的可用性来执行任务。自定义RDD在并行计算时也遵循这一策略。

// 一个假设的自定义调度逻辑

override def getPreferredLocations(split: Partition): Seq[String] = {

// 定义分区数据的偏好位置

// 例如,可能希望将分区数据尽可能放在与数据本地存储最近的节点上执行

Seq("***", "***")

}

上述示例中, getPreferredLocations 方法定义了分区数据的“偏好位置”。这意味着Spark调度器会尽可能将任务调度到这些节点上,以减少数据传输的开销,提高计算效率。自定义RDD可以实现这个方法以优化任务的分配策略,以便更好地利用硬件资源。

4.3 自定义RDD的高级特性实现

4.3.1 累加器和广播变量的使用

累加器和广播变量是Spark提供的两种高级特性,它们在自定义RDD中可以被充分利用来优化数据处理流程。累加器允许在并行操作中执行只写的更新操作,非常适合于实现计数器和求和等操作。广播变量则用于在集群中的所有节点之间共享数据,从而避免了数据的重复传输。

下面是一个使用累加器和广播变量的例子:

import org.apache.spark.Accumulator

// 定义一个累加器用于计数

val counter = sparkContext.longAccumulator("CounterAccumulator")

// 定义一个广播变量用于共享大型数据集

val sharedData = sparkContext.broadcast(SomeLargeDataSet)

// 在自定义RDD的compute方法中使用累加器和广播变量

override def compute(split: Partition, context: TaskContext): Iterator[String] = {

// 使用广播变量获取共享数据

val data = sharedData.value

// 使用累加器进行计数操作

data.foreach(x => counter.add(1))

// 其他处理逻辑...

}

在这个例子中, counter 累加器用于计算处理的数据项总数,而 sharedData 广播变量用于在集群中的每个节点上共享一个大型数据集,以避免重复加载数据的开销。

4.3.2 自定义分区器的应用

分区器是Spark用来决定数据如何在RDD中分区的组件。自定义RDD可以实现一个自定义分区器来控制数据在不同分区中的分配。这在对数据分布有特殊要求时非常有用,例如,根据数据键值来将相关数据分配到同一个分区。

下面是一个自定义分区器的例子:

import org.apache.spark.Partitioner

class CustomPartitioner(numPartitions: Int) extends Partitioner {

override def numPartitions: Int = numPartitions

override def getPartition(key: Any): Int = {

// 根据数据键值计算分区索引

// 例如,简单的取模操作将键映射到不同的分区

key.hashCode % numPartitions

}

}

// 使用自定义分区器

val rddWithCustomPartitioner = rdd分区(CustomPartitioner(4))

在这个例子中, CustomPartitioner 类继承了 Partitioner 并覆盖了 numPartitions 和 getPartition 方法。 getPartition 方法根据数据键值的哈希值将数据项分配到不同的分区。然后可以使用 partitionBy 方法将自定义分区器应用于RDD,从而实现定制的数据分布。

自定义RDD的实现提供了一个强大的方式来扩展和优化Spark的数据处理流程。通过理解并行计算原理和高级特性,开发者可以更好地利用Spark框架的能力,实现高效和可定制的大数据处理解决方案。

5. RDD数据分区策略

5.1 分区策略的基本概念

5.1.1 分区的目的和作用

在分布式计算框架中,分区是数据处理的关键概念之一。分区的核心目的在于通过将数据分布到多个节点上,实现数据处理的并行化,提高数据处理的速度和效率。在Apache Spark中,RDD(弹性分布式数据集)作为其核心的数据抽象,利用分区策略对数据进行物理划分,从而在计算时可以在不同节点上并行执行。分区策略的好坏直接影响到计算任务的负载均衡、内存使用效率以及数据传输开销等多个方面。

5.1.2 常见的分区策略类型

Spark支持多种分区策略,每种策略根据其应用场景和优化目标各有特点:

- Hash分区 :根据数据的key通过哈希函数计算得到分区索引。适用于数据需要基于key进行聚合操作的场景,保证了相同key的数据落在同一个分区。

- Range分区 :基于数据key的范围进行分区,需要定义范围边界。适用于对连续的数据进行分段处理,比如时间序列数据。

- Round-Robin分区 :轮流将数据分配到不同分区中。适用于数据无明显分布规律,需要均匀分配数据负载的场景。

- 自定义分区 :用户可以基于具体需求编写分区逻辑。为更复杂的数据分布场景提供了灵活性。

5.2 自定义分区策略的设计

5.2.1 分区策略的选择依据

选择合适的分区策略对于性能优化至关重要。选择依据包括:

- 数据处理需求:是否需要基于key的聚合,或者数据读取模式。

- 数据分布特征:数据是如何分布的,是否存在热点问题。

- 资源使用情况:如何有效利用内存和CPU资源。

- 性能指标:如减少数据倾斜、降低网络传输开销等。

5.2.2 分区策略的设计模式

设计自定义分区策略时,需要遵循一定的设计模式,如:

- 继承与覆盖 :继承Spark的

Partitioner类并覆盖getPartition方法。 - 可配置性 :支持通过配置参数调整分区逻辑,以适应不同的数据和负载场景。

- 扩展性 :分区策略设计应考虑未来可能的扩展,如支持更多种类的数据划分。

5.3 分区策略对性能的影响

5.3.1 分区数量对性能的影响

分区数量的选择是分区策略设计的一个重要方面,对性能有重要影响:

- 分区过少 :无法充分利用集群的计算能力,增加任务执行时间。

- 分区过多 :过多的分区会导致任务调度和管理开销增加,每个分区内的数据量减少可能引发更多的网络传输。

5.3.2 分区与数据倾斜的关系

数据倾斜是分布式计算中常见的问题,分区策略对数据倾斜有直接的影响:

- 合理的分区 :通过合适的分区策略可以减少数据倾斜的发生,例如在数据倾斜严重的场景下使用自定义分区将热点数据均匀分散到多个分区。

- 自定义分区策略 :通过复杂的逻辑来平衡不同分区的数据量,以实现负载均衡。

6. 迭代器控制数据读取

6.1 数据读取过程分析

6.1.1 数据读取的阶段划分

在分布式计算环境中,数据读取是整个处理流程中的第一步,也是影响整体性能的关键因素。数据读取过程可以划分为以下阶段:

- 预处理阶段 :在此阶段,系统会进行必要的数据预处理,例如数据格式转换、编码解码操作等,确保数据符合后续处理流程的要求。

- 数据分片阶段 :将数据集分割为多个数据分片,以适应集群中的多个节点并行处理。

- 数据传输阶段 :数据分片被分发到各个计算节点,这一过程中可能伴随着网络传输和数据序列化操作。

- 数据读取和缓存阶段 :节点接收数据分片后,将数据读入内存,并根据需要进行缓存,以减少后续重复读取的开销。

- 数据处理阶段 :数据在内存中被进一步处理,如转换、过滤或聚合等。

6.1.2 数据读取的性能考量

在迭代器控制数据读取时,性能考量至关重要,主要包括:

- 读取速度 :数据读取的速度直接影响处理的时效性,应尽可能减少读取延迟。

- 内存占用 :内存是宝贵的资源,数据读取应合理控制内存占用,避免内存溢出。

- CPU占用 :读取数据时可能涉及CPU密集型的操作,如解码、反序列化等,需要优化算法以减少CPU使用率。

- 网络I/O :尤其是在分布式环境中,网络传输效率的高低对整体性能有较大影响,应减少不必要的网络数据传输。

6.2 迭代器控制数据读取的策略

6.2.1 迭代器数据缓存机制

迭代器在控制数据读取时,数据缓存机制是关键。数据缓存可以分为:

- 缓存策略选择 :根据数据访问模式选择合适的缓存策略,如全量缓存、部分缓存或无缓存。

- 缓存失效时机 :合理确定数据缓存失效时机,以避免过时的数据影响处理结果。

- 缓存容量管理 :设置合理的缓存容量,避免因缓存溢出导致的数据重复读取,从而降低性能。

示例代码展示如何使用迭代器进行数据缓存:

// 定义迭代器缓存数据结构

val iteratorCache = new mutable.LinkedHashMap[SomeKey, SomeData]()

// 添加数据到缓存

def addToCache(key: SomeKey, data: SomeData): Unit = {

iteratorCache.synchronized {

iteratorCache.put(key, data)

}

}

// 从缓存读取数据

def readFromCache(key: SomeKey): Option[SomeData] = {

iteratorCache.synchronized {

iteratorCache.get(key)

}

}

6.2.2 数据读取的优化技术

数据读取优化技术包括但不限于:

- 预取技术 :根据数据访问模式预先读取可能被需要的数据,减少等待时间。

- 数据压缩 :对存储在磁盘上的数据进行压缩,以减少I/O传输量。

- 数据布局优化 :优化数据在存储介质上的布局,以提升读取效率。

- 异步I/O操作 :利用异步I/O操作,避免阻塞主线程,提高整体处理速度。

代码示例说明异步I/O操作:

import scala.concurrent.Future

import scala.concurrent.ExecutionContext.Implicits.global

// 异步读取数据

def asyncReadData(path: String): Future[Data] = {

Future {

val data = // 读取操作

data

}

}

6.3 数据读取与任务调度的协调

6.3.1 任务调度对数据读取的影响

任务调度对数据读取的影响体现在任务分配和执行时机上:

- 任务分配策略 :不同的任务分配策略会影响数据读取的顺序和并发度。合理的任务分配可以优化数据读取和处理的效率。

- 任务执行时机 :根据系统的负载情况以及数据的分布特性,合理安排任务的执行时机,可以提升数据读取与处理的协调性。

6.3.2 协调数据读取与任务执行

为了协调数据读取与任务执行,需要:

- 任务依赖分析 :识别并分析任务之间的依赖关系,合理安排依赖任务的读取顺序。

- 数据局部性优化 :利用数据局部性原理,尽可能使任务在数据所在的节点上执行,降低数据传输开销。

- 资源调度协调 :动态协调计算资源与存储资源,实现数据读取与任务执行的最优匹配。

通过上述分析和策略应用,我们可以更深入地理解迭代器如何有效控制数据读取,从而优化整个数据处理流程。

7. 持久化优化方法

7.1 持久化机制的基本原理

7.1.1 持久化的作用和意义

在大规模数据处理中,数据往往需要被多次计算和访问。RDD的持久化机制能够将中间计算结果存储在内存中,避免了重复计算的成本。这一机制对提高数据处理的效率和响应速度有着至关重要的作用,尤其是在迭代计算(如机器学习算法)和需要重复访问数据的场景中。

7.1.2 持久化级别的选择

Spark提供了不同的持久化级别,以满足不同的存储需求和优化内存使用。常见的持久化级别包括:

-

MEMORY_ONLY: 将RDD作为反序列化的对象存储在JVM中,如果内存不足,部分分区不会被持久化。 -

MEMORY_AND_DISK: 将RDD存储在内存中,如果内存空间不足,则存储在磁盘上。 -

DISK_ONLY: 将RDD完全存储在磁盘上,不占用内存空间。

选择合适的持久化级别,可以在避免内存溢出的同时,保证性能的最优。

7.2 持久化的性能优化技术

7.2.1 避免内存溢出的策略

内存溢出是使用内存存储数据时常见的问题。为了避免内存溢出,可以采取以下策略:

- 了解数据特性 :分析数据的大小和序列化后的体积,选择合适的持久化级别。

- 数据序列化 :使用更高效的序列化框架,比如Kryo序列化。

- 内存管理 :合理配置executor的内存大小,避免内存资源过度竞争导致的溢出。

7.2.2 数据序列化和反序列化的优化

数据在存储和传输过程中,需要进行序列化和反序列化。优化这一过程可以显著提升持久化的性能:

- 使用高效的序列化库 :比如Kryo序列化库比Java原生序列化库更加高效,使用时需要先注册自定义类。

- 调整序列化配置 :根据数据特性调整序列化参数,如是否压缩等。

7.3 持久化与容错性的关系

7.3.1 持久化在容错机制中的应用

由于持久化的数据存储在内存或磁盘中,当节点故障时,无需重新计算,可以从持久化存储中恢复数据。这样,持久化机制也是Spark容错机制的一部分。

7.3.2 持久化策略对容错性的影响

不同的持久化策略对容错性有不同的影响:

-

DISK_ONLY级别的持久化,即使节点故障,由于数据完全存储在磁盘上,容错能力最强。 -

MEMORY_ONLY级别的持久化,则依赖于RDD的血统(lineage)进行重新计算,虽然在内存中的读取速度最快,但容错能力较弱。

根据应用的具体需求,合理选择持久化级别可以平衡性能和容错性。

通过这些详细的解释和分析,可见在持久化机制的运用中,如何平衡效率和容错性,以及如何避免内存溢出等问题,都是提升Spark应用性能的关键所在。在后续章节中,我们还会深入探讨如何进行有效的性能测试以及如何验证功能的正确性。

简介:在Spark编程中,RDD是处理大规模数据集的关键组件,对于特定需求,如优化数据倾斜,可能需要自定义RDD来提高效率。本文提供了示例代码"自定义RDD-从HDFS读取数据代码.zip",深入探讨了如何通过实现自定义迭代器和RDD,从HDFS高效读取数据。文章详细描述了自定义RDD的创建、分区定义、迭代器设计、计算逻辑、持久化优化和测试验证过程,为解决数据处理问题提供了实际解决方案。

395

395

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?