目标检测对抗攻击

赛题:1000张图,在图上贴补丁,最多不超过10个,导致检测框失效就算得分。

比赛链接:https://tianchi.aliyun.com/competition/entrance/531806/information

数据描述:从MSCOCO 2017测试数据集中有条件的筛选了1000张图像,这些图像不会包含过多或者过少的检测框(至少会有一个检测框),并且检测框的面积相对于整图不会太小。每张图都被resize到500 * 500的大小,并以.png的格式存储。

攻击的检测器:Faster RCNN, YOLOv4,另外三个是黑盒

最近做了一段时间,分享一下思路,我做的分数不高,只是做个入门介绍。

首先介绍一下相关的论文:

- Adversarial Patch

- DPatch

- On Physical Adversarial Patches for Object Detection

- Fooling automated surveillance cameras: adversarial patches to attack person detection

Adversarial Patch

简要思路

没有接触过对抗攻击的可以从这篇入手,这是第一个在对抗攻击中提出Patch的。传统的对抗攻击就是在原图的基础上加入肉眼不可见的噪音干扰分类器,用数学的方式定义就是,给定分类器,其中 为样本, 为样本自身的类别,假设我们需要误判为的目标类别为 ,想要找到一个与 相近的 最大化 , 相近的约束表示为存在一个 误差满足 .

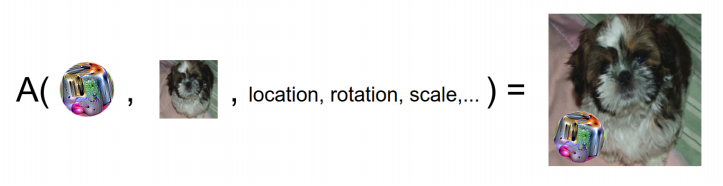

通俗点讲,就是把Patch贴在图上,跟原图相差不大并且使分类器分类失误,如下图表示了Patch粘贴的方式:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1871

1871

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?