k近邻KNN模型

懒惰学习著名代表,此类学习技术在训练阶段仅仅是把样本保存起来,训练时间开销为零,待收到测试样本后再进行处理

工作机制:给定测试样本,基于某种距离度量找出训练集中与其最靠近的K个训练样本,然后基于这 个"邻居 “的信息来进行预测 ,在分类任务中可使用"投票法” 即选择这 个样本中出现最多的类别标记作为预测结果;在回归任务中时使用"平均法" ,即将 个样本的实值输出标记平均值作为预测结果;还可基于距离远近进行加权平均或加权投票,距离越近的样本权重越大.

示意图:

低维嵌入

分类、聚类都需要计算距离,所以高维情形下出现样本稀疏、 距离计算困 难等问

是所有机器学习方法共同面 的严重障碍, 被称为“维数灾难”

缓解维数灾难的一个重要途径是降维(dimension red uction) 亦称" 维数约简” ,即通过某种数学变换将原始高维属 性空间转变为 一个低维"子空间"(subspace) ,在这子空间中样本密密度大幅提高,距离计算 变得更为容易。

为什么能进行降维?这在很多时候,人们观测或收集到的数据样本虽是高维的,但与学习任务密切相关的也许仅是某个低维分布,即高维空间中一个低维"嵌入"

算法过程

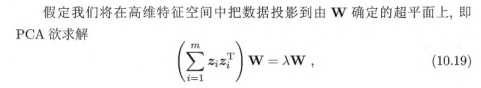

基于线性变换来进行降维的方法称为线性降维方法,它们都符合(10.13) 的基本形式,不同之处是对低维子空间的性质有不同的要求,相当于对 施加了不同的约束.若要求低维子空间对样本具有最大可分性,则将得到一种极为常用的线性降维方法.

对降维效果的评估,通常是比较降维前后学习器的性能,若性能有所提高,则认为降维起到了作用.若将维数降至二维或三维,则可通过可视化技术来直观地判断降维效果.

主成分分析PAC

对于正交属性空间中的样本点,如何用一个超平面(直线的高维推广)对所有样本进行恰当的表达?

容易想到,若存在这样的超平面,那么它大概应具有这样的性质:

·最近重构性:样本点到这个超平面的距离都足够近;

·最大可分性.样本点在这个超平面上的投影能尽可能分开.

基于最近重构性和最大可分性能分别得到主成分分析的两种等价推导我们先从最近重构性来推导.

核化线性降维

线性阵维方法假设从 维空间到低维空间的函数映射是线性的,然|旬,在

不少现实任务中,可能需要非线性映射才能找到恰当的低维嵌入

例如:

非线性阵维的一种常用方法,是基于核技巧对线性降维方法进行"核化" (kernelized PCA). 下面以核主成分分析为例演示

2534

2534

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?