深度学习在很多机器学习应用中都有巨大的潜力,但深度学习算法往往经过精确调整,只适用于特定的使用场景。先学习一些简单的方法,比如用于分类和回归的多层感知机(MLP),它可以作为研究更复杂的深度学习方法的起点。MPL也被称为(普通)前馈神经网络,有时也简称为神经网络。

MLP可以被视为广义的线性模型,执行多层处理后得到的结论。

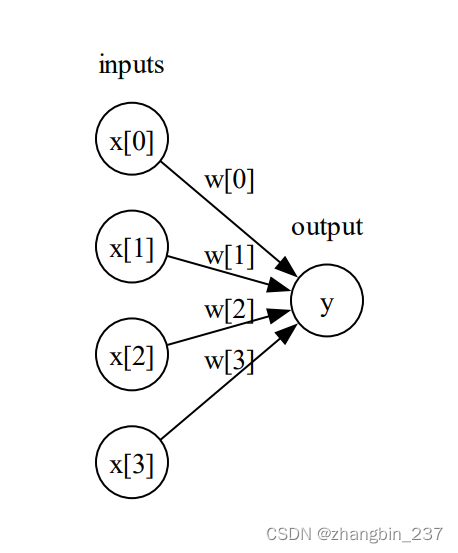

将线性模型的公式可视化:

import mglearn

import matplotlib.pyplot as plt

from IPython.display import display

from graphviz import Digraph

graph=mglearn.plots.plot_logistic_regression_graph()

display(graph)

graph.render('example',view=True)

可以看到,左边的每个结点代表输入特征,连线代表学习到的系数,右边的结点代表输出,是输入加权求和。

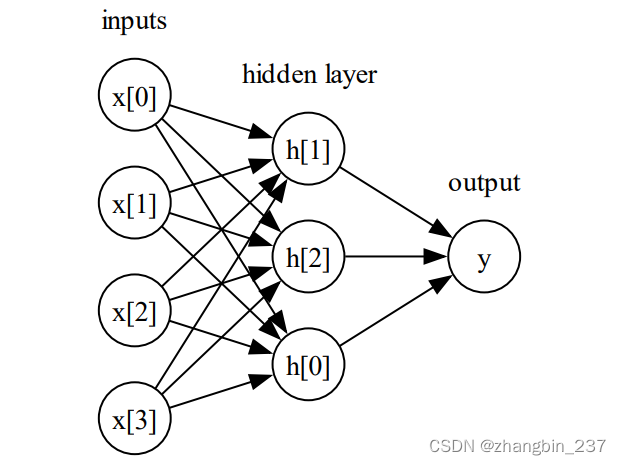

在MLP中,多次重复这个计算加权求和的过程,首先计算代表中间过程的隐单元,然后再计算这些隐单元的加权求和并得到最终结果。

这个模型需要学习更多的系数(权重):在每个输入与每个隐单元之间有一个系数,每个隐单元与输出之间也有一个系数。隐单元组成了隐层。

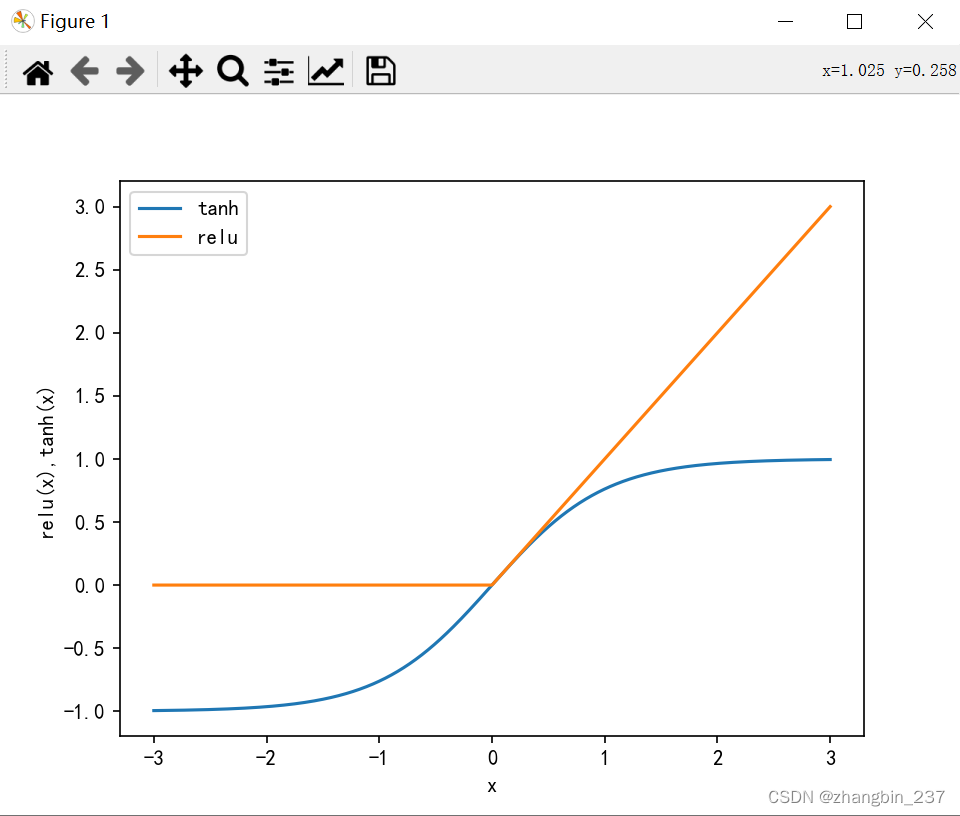

从数学角度看,计算一系列加权求和与只计算一个加权求和是完全相同的。因此,为了让模型真正比线性模型更为强大,还需要一个技巧。在计算完每个隐单元的加权求和之后,对结果再应用一个非线性函数(通常是校正非线性或正切双曲线),然后将这个函数的结果应用于加权求和,计算得出输出y。

两个函数的可视化效果:

import numpy as np

import matplotlib.pyplot as plt

plt.rcParams['font.sans-serif'] = ['SimHei']

plt.rcParams['axes.unicode_minus'] = False

line=np.linspace(-3,3,1000)

plt.plot(line,np.tanh(line),label='tanh')

plt.plot(line,np.maximum(line,0),label='relu')

plt.legend(loc='best')

plt.xlabel('x')

plt.ylabel('relu(x),tanh(x)')

plt.show()

relu截断小于0 的值,而ranh在输入值较小时接近-1,在输入值较大时接近+1。有了这两种非线性函数,神经网络可以学习比线性O型复杂得多的函数。

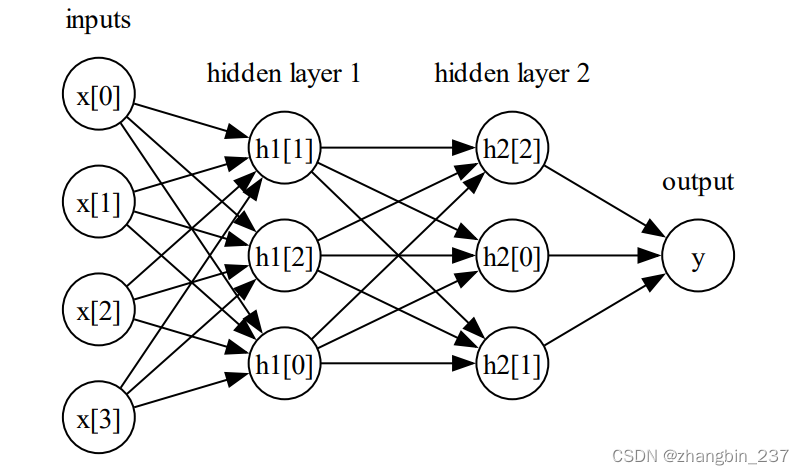

神经网络还可以添加到多个隐层:

8411

8411

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?