写在前面

这篇文章将从3个角度:加权、模版匹配与几何来理解最后一层全连接+Softmax。掌握了这3种视角,可以更好地理解深度学习中的正则项、参数可视化以及一些损失函数背后的设计思想。

全连接层与Softmax回顾

深度神经网络的最后一层往往是全连接层+Softmax(分类网络),如下图所示,图片来自StackExchange。

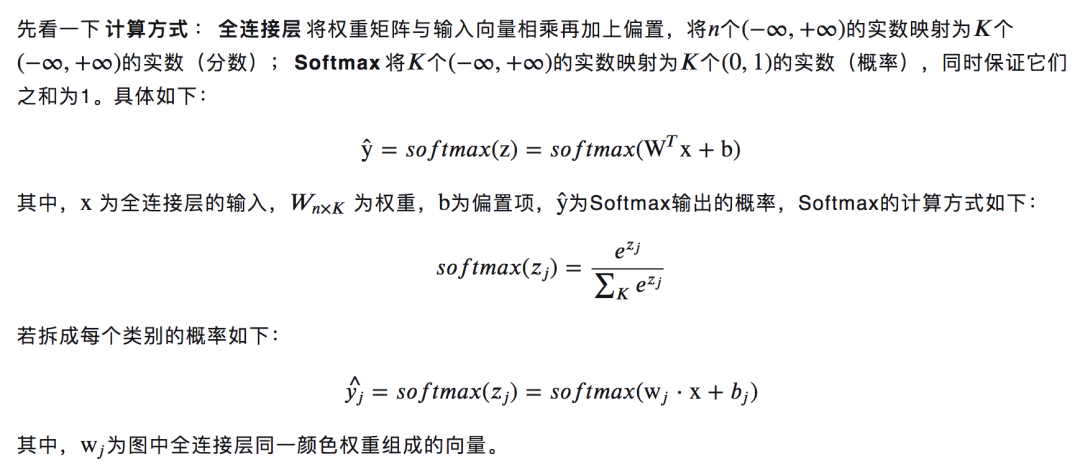

先看一下计算方式:

该如何理解?

下面提供3个理解角度:加权角度、模版匹配角度与几何角度

加权角度

加权角度可能是最直接的理解角度。

通常将网络最后一个全连接层的输入,即上面的x,视为网络从输入数据提取到的特征。

将wj视为第j类下特征的权重,即每维特征的重要程度、对最终分数的影响程度,通过对特征加权求和得到每个类别的分数,再经过Softmax映射为概率。

模板匹配

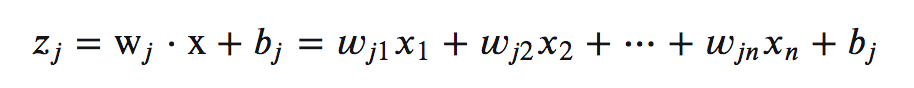

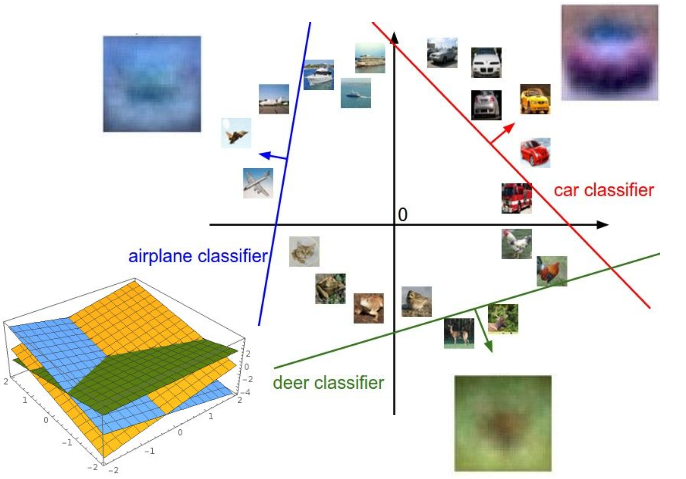

也可以将wj视为第j类的特征模板,特征与每个类别的模板进行模版匹配,得到与每个类别的相似程度,然后通过Softmax将相似程度映射为概率。如下图所示,图片素材来自CS231n。

如果是只有一个全连接层的神经网络(相当于线性分类器),将每个类别的模板可以直接可视化如下,图片素材来自CS231n。

如果是多层神经网络,最后一个全连接层的模板是特征空间的模板,可视化需要映射回输入空间。

几何角度

如下图所示:

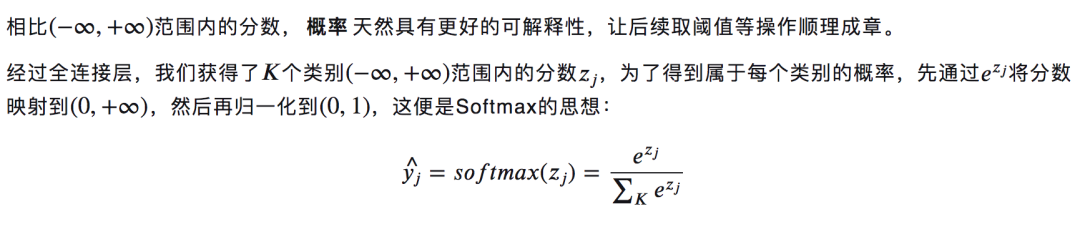

Softmax的作用

总结

本文介绍了3种角度来更直观地理解全连接层+Softmax,

加权角度,将权重视为每维特征的重要程度,可以帮助理解L1、L2等正则项

模板匹配角度,可以帮助理解参数的可视化

几何角度,将特征视为多维空间中的点,可以帮助理解一些损失函数背后的设计思想(希望不同类的点具有何种性质)

视角不同,看到的画面就不同,就会萌生不同的idea。有些时候,换换视角问题就迎刃而解了。

以上。

参考

CS231n: Convolutional Neural Networks for Visual Recognition

来源

https://www.cnblogs.com/shine-lee/p/10077961.html

2285

2285

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?