目录

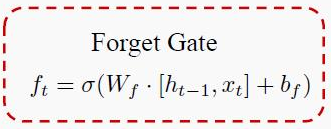

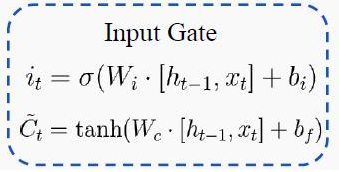

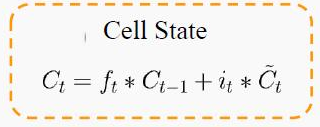

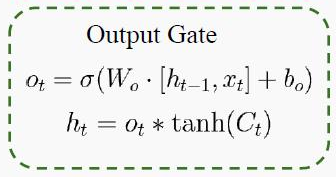

1 LSTM结构图和公式

将结构图转换为如下所示(将“用于极简”的说明反向传播),实际上当用于反向传播时,所有的箭头的方向都是需要反过来看。

图中τ 代表最后时刻。

2 反向传播 tips

2.1 本文所有向量全为列向量

以最后时刻的 ![]() 构造softmax函数。

构造softmax函数。

2.2 softmax层反向传播

公式(1)结论很简单,但实际上是 L 先对 a 求偏导然后再对 z 求偏导。

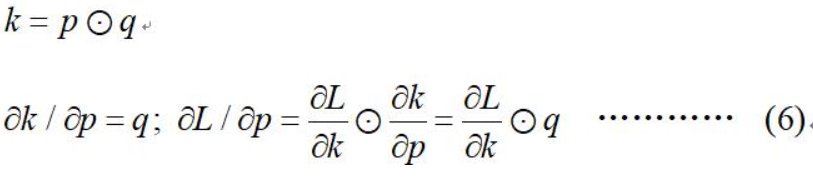

2.3 hadamard积的微分

2.4 softmax求导

![]()

2.5 tanh求导

![]()

3 对 h 和 c 反向传播

在RNN中,为了反向传播误差,我们通过隐藏状态 ![]() 的梯度

的梯度 ![]() 一步步向前传播。在LSTM这里也类似。只不过我们这里有两个隐藏状态

一步步向前传播。在LSTM这里也类似。只不过我们这里有两个隐藏状态![]() 和

和 ![]() 。

。

这里我们定义两个δ,即:

3.1 最后时刻LSTM单元内的 h , c 反向传播

3.1.1 最后时刻LSTM单元内的 h 反向传播

最后时刻 τ 相关的变量仅有![]() ,则

,则 ![]() 即公式(3):

即公式(3):

![]()

3.1.2 最后时刻LSTM单元内的 c 反向传播

因为:![]()

所以:![]()

![]()

上述步骤完成了图中(3)式、(9)式。

3.2 求得递归时刻(不是最后一刻)的反向表达式

3.2.1 求对 h t − 1 的偏导数

![]() 的梯度由本层 t 时刻的输出梯度误差和大于 t 时刻的误差两部分决定。

的梯度由本层 t 时刻的输出梯度误差和大于 t 时刻的误差两部分决定。

不绕道![]() 的表达式

的表达式 ![]() ,相当于仅从

,相当于仅从![]() 路径走,其表达式为(10),顺便把(11)(12)一起求了。

路径走,其表达式为(10),顺便把(11)(12)一起求了。

(公式10):

因为:![]()

所以: ![]()

(公式11):

因为:![]()

所以:![]()

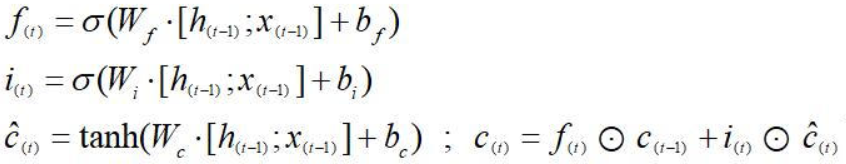

(公式12):

因为在公式![]() 中,

中,![]() 、

、![]() 、

、![]() 包含h的递推关系,且:

包含h的递推关系,且:

所以:

(10)、(11)、(12)公式其实展示的正是下图结构的反向传递。

其实(10)(12)式是可以合并的,合并后的表达式(10_12):

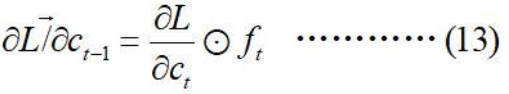

3.2.2 求对 c t − 1 的偏导数

对 ![]() 的反向传播有两条路径,路径1是直接从

的反向传播有两条路径,路径1是直接从![]() 过来的

过来的![]() ,路径2是从

,路径2是从![]() 过来的

过来的![]() :

:

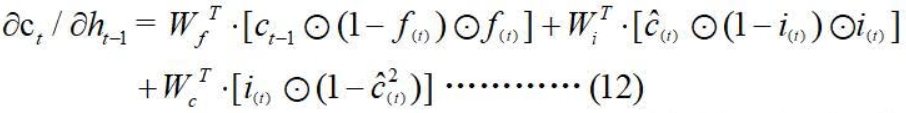

(公式13):

因为:![]()

所以:

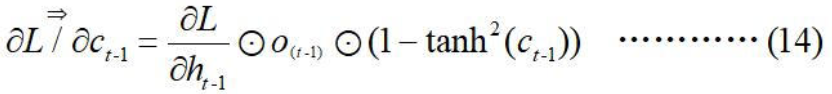

(公式14):

因为:![]()

所以:

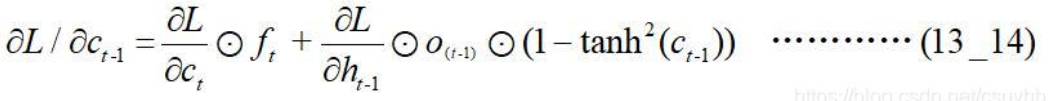

(公式13_14):

结合公式13,14:

(13_14)公式其实展示的正是下图结构的反向传递。

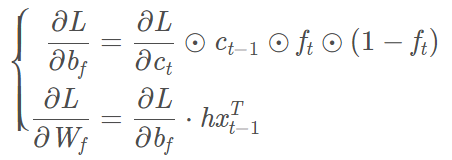

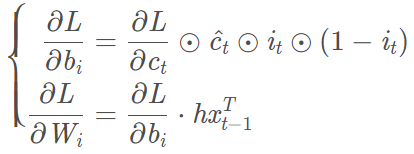

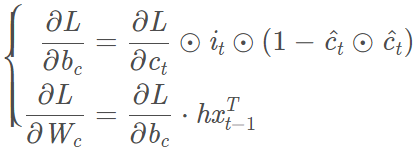

4 对参数反向求导

在第3章,得到了以下变量![]() ,

,![]() ,

,![]() ,

,![]() ,现在我们需要得到模型的参数

,现在我们需要得到模型的参数![]() 。

。

4.1 对bo求偏导

以对 ![]() 矩阵的偏导数为例,先求

矩阵的偏导数为例,先求![]() 的偏导数,根据《链式法则》:

的偏导数,根据《链式法则》:

因为:![]()

所以: ![]()

又因为:![]()

所以:![]()

4.2 对Wo求偏导

继续求对![]() 的偏导数(以

的偏导数(以![]() 简称

简称![]() 这个列向量),根据《链式法则》:

这个列向量),根据《链式法则》:

![]() =

=![]()

继续刷公式:

LSTM反向传播详解Part1:https://blog.csdn.net/csuyhb/article/details/99546576

LSTM反向传播详解Part2:https://blog.csdn.net/csuyhb/article/details/100049042

LSTM反向传播详解(完结篇)Part3/3代码实现:https://blog.csdn.net/csuyhb/article/details/100162814

LSTM模型与前向反向传播算法:https://www.cnblogs.com/pinard/p/6519110.html

5930

5930

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?