本篇文章将对以下三篇论文进行总结:

- Fully Decentralized Multi-Agent Reinforcement Learning with Networked Agents

- SBEED: Convergent Reinforcement Learning with Nonlinear Function Approximation

- Value Propagation for Decentralized Networked Deep Multi-agent Reinforcement Learning

Fully Decentralized Multi-Agent Reinforcement Learning with Networked Agents

本文提出了一种新的 MDP,称为 Networked Multi-Agent MDP,并在其上提出了两种去中心化的 Actor-Critic 算法,最后提供了在使用线性函数估计器情况下的收敛性证明。

为了引出 Networked Multi-Agent MDP,我们首先从 single agent 开始。这里之所以再对强化学习的一些基础进行回顾,是因为本篇论文采用的强化学习优化目标是平均回报(average reward),具体可参见我之前的文章:

在使用平均回报后,相应的状态-动作值函数(Q 值函数)也相应的变为差分状态-动作值函数(差分 Q 值函数):

那么对应的策略梯度定理如下:

可以看到策略梯度定理的形式不随着优化目标的改变而改变。在将

同时为了减少参数数量,我们可以用状态-动作值函数(Q 值函数)来表示状态值函数,所以有:

接下来,令

其中

在介绍完背景知识之后,下面我们给出 Networked Multi-Agent MDP 的正式定义:

(Networked Multi-Agent MDP)。令代表

个智能体之间的随着时间变化的通信网络。一个网络化的多智能体马尔可夫决策过程(Networked Multi-Agent MDP)可以由以下五元组表示:

。其中

表示所有智能体共享的全局状态空间,

表示智能体

的动作空间。另外,

表示所有智能体的联合动作空间。

表示智能体

的局部回报函数,

表示此马尔可夫决策过程的状态转移概率。此外,我们假定状态以及联合动作是可以被所有智能体观察到的,只有回报是每个智能体独有的。

因为每个智能体的回报是独立的,并且动作也是独立执行的,因而我们认为我们的模型是完全去中心化的。

在给出了网络化多智能体马尔可夫决策过程之后,我们接下来给出解决此 MDP 所定义的目标优化函数,这里值得注意的是本文主要关注于协作环境,竞争环境以及混合环境不在本论文的考虑范围之内:

对应的,我们有全局差分状态-动作值函数(Q 值函数),此函数是所有智能体共享的:

由于本文提出的是多智能体问题下的 actor-critic 算法,还特意提出了一个多智能体强化学习策略梯度定理:

(多智能体强化学习策略梯度定理)。对于任意,令

表示策略且令

代表

式代表的全局长程平均收益。另外,令

以及

分别表示

式以及

式定义的 状态-动作值函数和优势函数。对于任意

,我们定义局部优势函数

:

其中

表示除

外所有智能体的联合动作。

,那么策略梯度计算公式如下:

![]()

上述策略梯度定理表明,使用对应的局部 score function

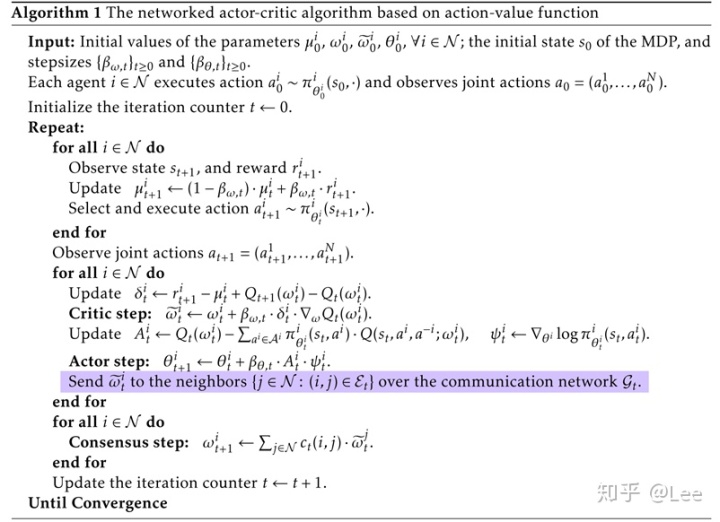

有了以上理论基础之后,我们首先提出一种基于局部优势函数

我们注意到在算法1中,在前两个 for 循环之间出现了中断,这是因为在估计

可以看到,使用贝尔曼方程替换

下一步在更新策略参数时,虽然

为了能够去中心化地优化上述目标,可以将其转化为下述等价形式:

那么参数

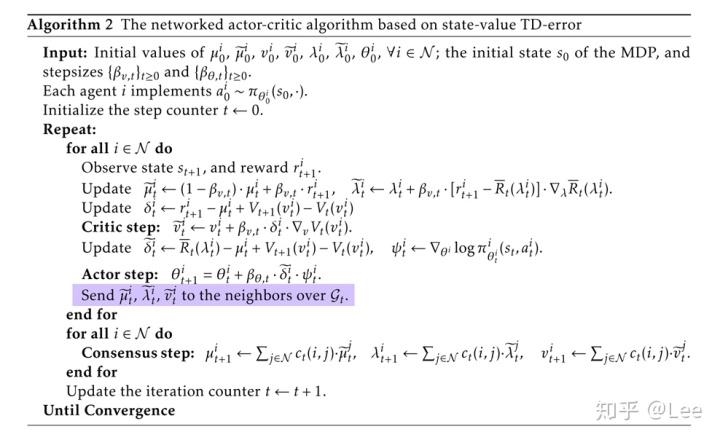

综上所述,我们一共有三部分参数需要满足一致性约束,和算法 1 相比多了两部分参数。下面是算法 2 的伪代码:

SBEED: Convergent Reinforcement Learning with Nonlinear Function Approximation

本文从贝尔曼最优方程出发,将值函数与策略的优化目标转化为一个 primal-dual 问题,并给出了非线性函数估计下的收敛性证明。

我们有如下贝尔曼最优方程:

为了能够显式地优化策略,我们可以将上式转化为如下等价形式:

接着我们遵循时序差分学习的模式,最小化差分误差(TD error):

直接优化上述优化目标存在以下两个问题:

- 优化目标中的

算子将会使得优化目标非光滑

- 二次函数中的条件期望项使得要想得到该二次函数的无偏梯度估计,需要进行两次独立采样(二次函数的导数计算需要计算两次条件期望项),这在现实场景中时很难满足的。

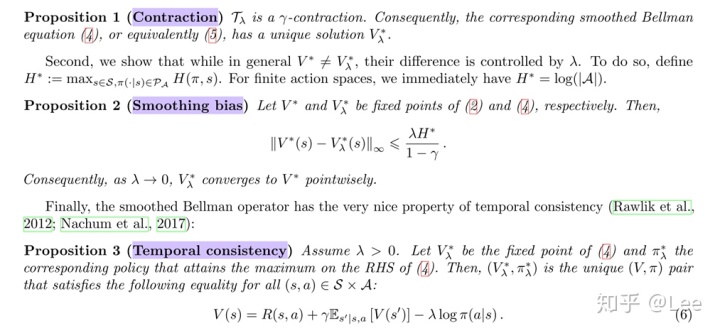

为了解决第一个问题,我们采用 Nestorov 平滑方法引入熵正则来对优化目标进行平滑:

这里故意采用熵正则而不是其他平滑函数应该是为了与目前学术界引入熵正则的形式保持一致。接下来我们可以进一步把

因而我们有了一个新的

根据第三个性质,我们就可以使用时序差分学习的方式来更新值函数的参数,具体来说,我们要优化下述目标函数:

至此,我们解决了上面提到的第一个问题。但是第二个问题还是没有得到解决,为了解决第二个问题,我们需要找到一个函数来去替换掉二次函数,而正好我们有:

因而我们的优化目标转化为:

接着通过以下代换:

最终优化目标即为:

那么为什么要转化为这种形式呢?原因是因为再 PCL(Path Consistency Learning) 算法中是通过优化

来去解决二次采样问题的,但这会引入方差,因而本文通过代换转化为

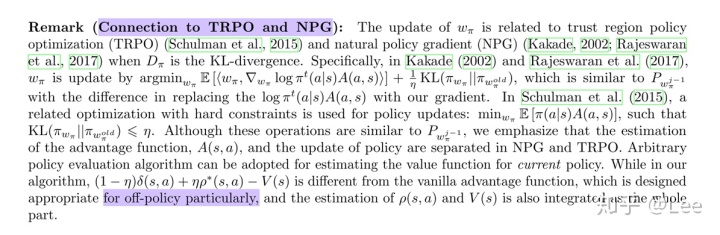

由于内部对偶问题的优化函数是个二次函数,可以直接得到闭式解,这里不过多说明。对于外部原始问题,本文采用 Stochastic Mirror Descent 算法(随机梯度下降加上 bergman divergence 惩罚项,KL散度是一个特例):

其中

这里再额外补充两点:

- 与 TRPO 以及 NPG 算法的联系

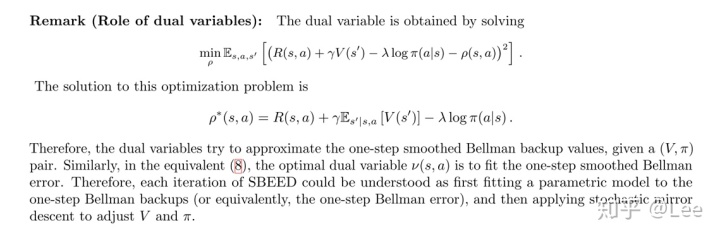

- 对偶变量的物理意义

关于收敛性证明部分这里先按下不表。可以看出 SBEED 算法更新策略以及值函数的参数更新公式与 actor-critic 算法的形式是一致的。

Value Propagation for Decentralized Networked Deep Multi-agent Reinforcement Learning

最后一篇论文可以认为是前两篇论文的结合:利用了第一篇论文对于 Networked Multi-Agent MDP 的定义,将 SBEED 算法扩展到多智能体问题上,同时为了能够去中心化实现,在优化问题上加入了一致性约束:

其中

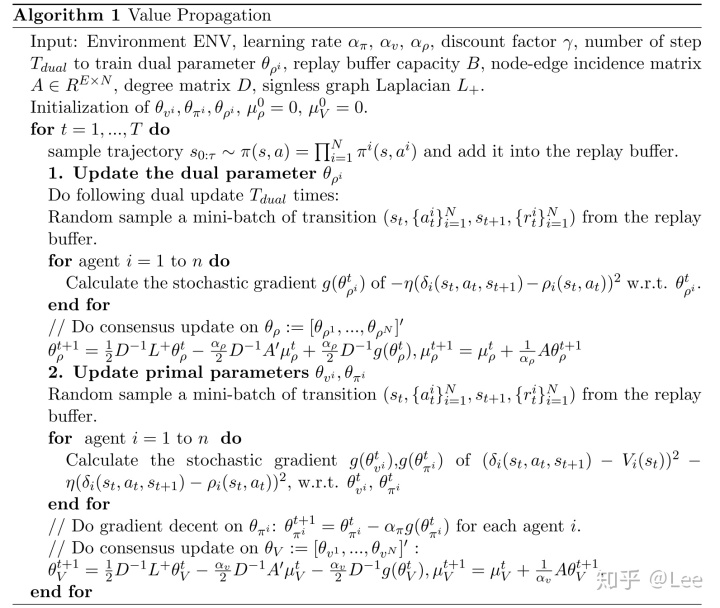

为了使得参数满足一致性约束,本文没有采用第一篇论文中简单的求平均的做法,而是采用了 Hong et al. 2017 中提出的分布式优化算法Prox-PDA(这里只以

最终算法框架如下:

还有个采用 Adam 算法代替随机梯度下降的加速版本:

最后还有个 Mutli-Step 的扩展( SBEED 论文里也已提到),我们可以将

从而使得:

8949

8949

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?