介绍

OpenMPI官方link:https://www.open-mpi.org/

我们先来看下MPI和OpenMPI的关系 :

MPI:英文全称是Message Passing Interface,这个就很明了了,信息传递接口,是独立于语言的通信协议(标准),是一个库。

OpenMPI:英文全称是open Message Passing Interface。openMPI是MPI的一种实现,一种库项目。

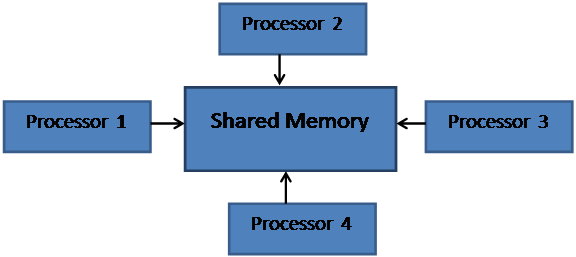

MPI是一种进程级的并行方式,它支持分布式存储。不过需要程序员显式分配数据,编程模型较为复杂。

关于OpenMPI在Linux下的安装和配置,全网有丰富的教程,这里就不赘述了,这里先来看一个最简单的hello world程序:

//hello.c

#include

#include "mpi.h"

int main(int argc, char* argv[])

{

int rank, size, len;

char version[MPI_MAX_LIBRARY_VERSION_STRING];

MPI_Init(&argc, &argv);

MPI_Comm_rank(MPI_COMM_WORLD, &rank);

MPI_Comm_size(MPI_COMM_WORLD, &size);

MPI_Get_library_version(version, &len);

printf("Hello, world, I am %d of %d, (%s, %d)\n",

rank, size, version, len);

MPI_Finalize();

return 0;

}

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

编译hello world的C程序,mpicc hello.c -o test

或者编译hello world的C++程序,mpicxx hello.c -o test

这样生成名叫test的可执行程序,然后使用mpirun执行:mpirun -np 2 ./test

这里用np来指定使用几个进程

以上程序打印输出如下:

Hello, world, I am 0 of 1, (Open MPI v3.0.0, package: Open MPI root@kerie-PC Distribution, ident: 3.0.0, repo rev: v3.0.0, Sep 12, 2017, 108)1

我们再来看一个矩阵乘的OpenMP并行实现:

//matrix_multiply.cpp

#include

#include

#include

#include

#pragma comment(lib,"mpi.lib")

#define n 1000

using namespace std;

int main(int argv, char *argc[])

{

int rank, p, a;

MPI_Init(&argv, &argc);

MPI_Comm_rank(MPI_COMM_WORLD, &rank);

MPI_Comm_size(MPI_COMM_WORLD, &p);

MPI_Status status;

if (p!=1)

a = n / (p - 1);

if (rank == 0)

{

int* A = new int[n*n];

int* B = new int[n*n];

int* C = new int[n*n];

// int * recptr = NULL;

for (int i = 0; i < n; i++)

for (int j = 0; j < n; j++)// 时间是 O nn

{

A[i*n + j] = i + j; //A[i][j]

B[i*n + j] = 1; //B[i][j]

}

if (p == 1)

{

double tb, te;

tb = MPI_Wtime();

for (int i = 0; i < n; i++)

for (int j = 0; j < n; j++)

{

C[i*n + j] = 0; //C[i][j]

for (int k = 0; k < n; k++)

{

C[i*n + j] = A[i*n + k] * B[k*n + j];

}

}

te = MPI_Wtime();

cout << "time is " << te - tb;// << "s" << endl;

}

if (p != 1)

{

double tb, te;

tb = MPI_Wtime();

for (int i = 0; i < p-1; i++){//给每个寄存器发送 数组 A,B,C

MPI_Send(&A[0+0], n*n, MPI_INT, i+1, 1, MPI_COMM_WORLD);//每个发送 a行,a*n大小的数据

MPI_Send(&B[0+0], n*n, MPI_INT, i+1,2, MPI_COMM_WORLD);

}

for (int i =0; i < p-1; i++)

MPI_Recv(&C[i*a+0], a*n, MPI_INT, i+1,3, MPI_COMM_WORLD, &status);//每个接受 a行,a*n大小的数据

te = MPI_Wtime();

cout << "time is " << te - tb;// << "s" << endl;

}

delete[] A;

delete[] B;

delete[] C;

}

if (p != 1)

if (rank != 0){

int* A = new int[n*n];

int* B = new int[n*n];

int* C = new int[n*n];

MPI_Recv(&A[0+0], n*n, MPI_INT, 0, 1, MPI_COMM_WORLD, &status);//从A[0][0]和B[0][0]开始接受

MPI_Recv(&B[0+0], n*n, MPI_INT,0, 2, MPI_COMM_WORLD, &status);

for (int i =a*(rank-1); i < (a*(rank)); i++)//按照行间隔分,每个cpu计算自己的a行

for (int j = 0; j < n; j++)

{

C[i*n + j] = 0; //C[i][j]

for (int k = 0; k < n; k++)

{

C[i*n + j] = A[i*n + k] * B[k*n + j];

}

}

{//向rank=0发送自己的那a行C,大小是a*n

//int * sendptr = &(C[a*(rank - 1)+0]);

MPI_Send(&C[a*(rank - 1) + 0], a*n, MPI_INT, 0,3, MPI_COMM_WORLD);//起始地址是C[rank-1][0],大小是a*n

}

}

MPI_Finalize();

return 0;

}

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

源码解析

MPI_Send函数用于发送一个消息到目标进程。通信域中的dest进程发送数据,数据存放在buf中,类型是datatype,个数是count,这个消息的标志是tag,用以和本进程向同一目的进程发送的其它消息区别开来。MPI_Recv函数用于从指定进程接收一个消息。它的含义是进程从comm域中source进程接收标签号为tag的数据,并保存到buf中。接收缓冲区buf的大小不能小于发送过来的消息的长度。否则会由于数组越界导致程序出错。MPI_Isend/MPI_Irecv是异步发送和接收的语句,显然比MPI_Send/MPI_Recv这样的阻塞语句更可能提高性能。另外,还可以避免循环死锁。

安装OpenMPI环境

1.下载安装包

wget https://www.open-mpi.org/software/ompi/v1.10/downloads/openmpi-1.10.2.tar.gz1

2.安装依赖插件

sudo apt-get install libibnetdisc.dev1

3.解压缩下载包,至目录/opt

cp openmpi-1.10.2.tar.gz /opt && cd /opt && tar -xvf openmpi-1.10.0.tar.gz1

4.配置安装文件

./configure --prefix="/home/$USER/.openmpi"1

5.安装openMPI

make && sudo make install1

6.配置环境变量

export PATH="$PATH:/home/$USER/.openmpi/bin"

export LD_LIBRARY_PATH="$LD_LIBRARY_PATH:/home/$USER/.openmpi/lib/"1

2

7.测试是否安装成功

635

635

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?