低配云服务器Windows2016搭建DeepSeek本地AI模型

前言:以最低的成本搭建一个属于自己的AI测试模型,不需要用到独立显卡,机器只需要2核心4G内存80G硬盘空间即可。因为DeepSeek拥堵注册不了API-key,所以用Ollama的deepseek-r1:1.5b。Anythingllm操作环境。

1. 环境准备

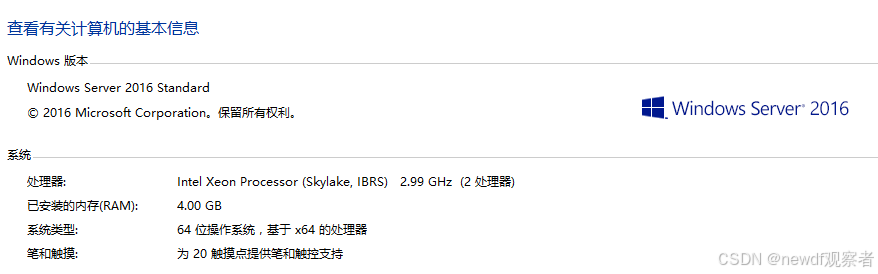

云服务器:确保已购买并配置好Windows Server 2016。

Python:安装 Python 3.8+。

远程连接工具:如RDP或SSH。

模型文件:下载所需的模型文件。

https://anythingllm.com/

https://ollama.com/

https://www.deepseek.com/

2.下载安装AnythingLLM

https://anythingllm.com/

安装后,首次访问时,系统会提示你进行初始化设置。

按照提示设置管理员账号和密码即可,其它默认就行,后面再具体设置。

3. 下载安装Ollama

https://ollama.com/

解压并安装。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

920

920

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?