循环神经网络(Recurrent Neural Network,简称RNN)是一种专门设计用于处理序列数据的人工神经网络,它在自然语言处理(NLP)、语音识别、时间序列预测、音乐生成等多个领域有着广泛的应用。与传统的前馈神经网络不同,RNN具有处理序列数据的能力,能够记住过去的信息,并利用这些信息影响当前的输出。

RNN的基本原理

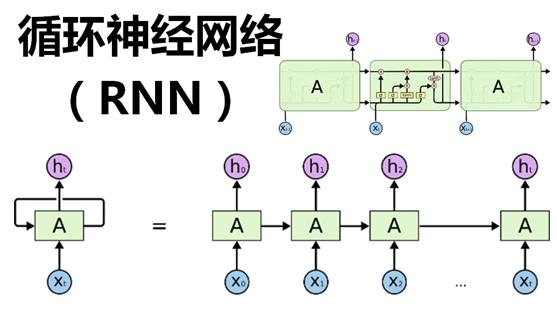

RNN的基本思想是在网络中引入循环连接,使得神经元不仅可以接收来自前一层的输入,还可以接收来自同一层的前一时刻的输出。这样,每个时间步的输出不仅取决于当前时刻的输入,还取决于上一时刻的隐藏状态(hidden state),这使得RNN能够捕捉到序列数据中的时序依赖关系。

RNN的结构

- 循环层:在RNN中,循环层包含一系列的神经元,每个神经元都有一个隐藏状态。在每个时间步,神经元接收当前的输入和前一时间步的隐藏状态,然后更新自己的隐藏状态,并产生一个输出。

- 循环权重:除了输入权重外,RNN还有循环权重,它决定了前一时刻的隐藏状态如何影响当前时刻的隐藏状态。

RNN的训练

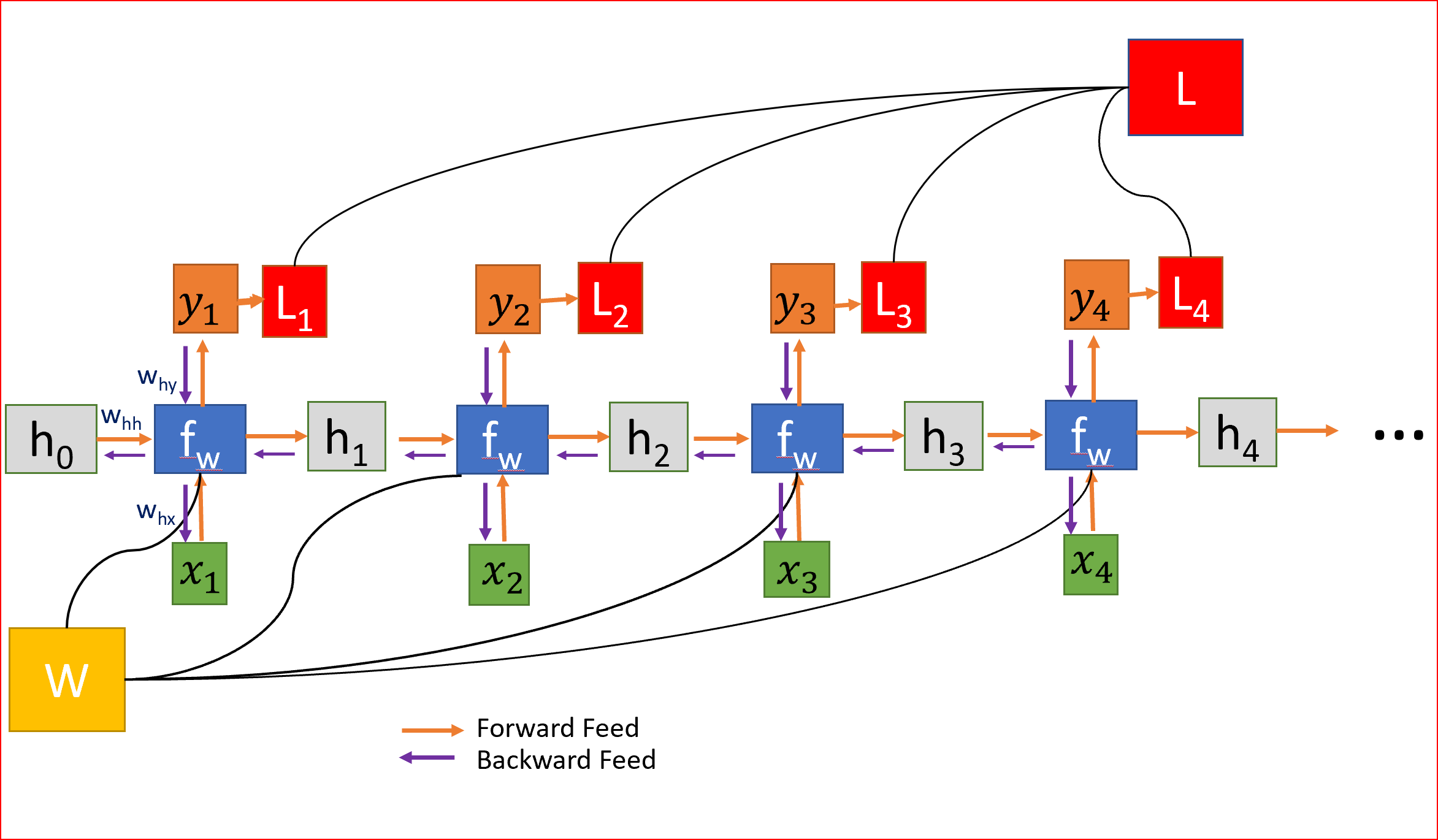

RNN的训练通常使用梯度下降法,但是由于循环结构的存在,普通的反向传播算法需要进行一些修改,这就是所谓的“反向传播通过时间”(Backpropagation Through Time,BPTT)。BPTT会将RNN在网络的不同时间步展开成一个深层的前馈网络,然后计算梯度并更新权重。

RNN的局限性

尽管RNN能够处理序列数据,但它存在一个重要的局限性,那就是梯度消失/爆炸问题。在长序列中,梯度可能会变得非常小(消失)或非常大(爆炸),这使得网络难以学习到长期依赖关系。为了解决这个问题,人们开发出了几种改进的RNN结构,比如:

- 长短期记忆网络(LSTM):通过引入门控机制,LSTM能够选择性地保留或遗忘信息,有效地解决了长期依赖问题。

- 门控循环单元(GRU):GRU是LSTM的一个简化版本,它将LSTM的三个门简化为两个,减少了参数数量,同时也具有处理长期依赖的能力。

RNN的应用

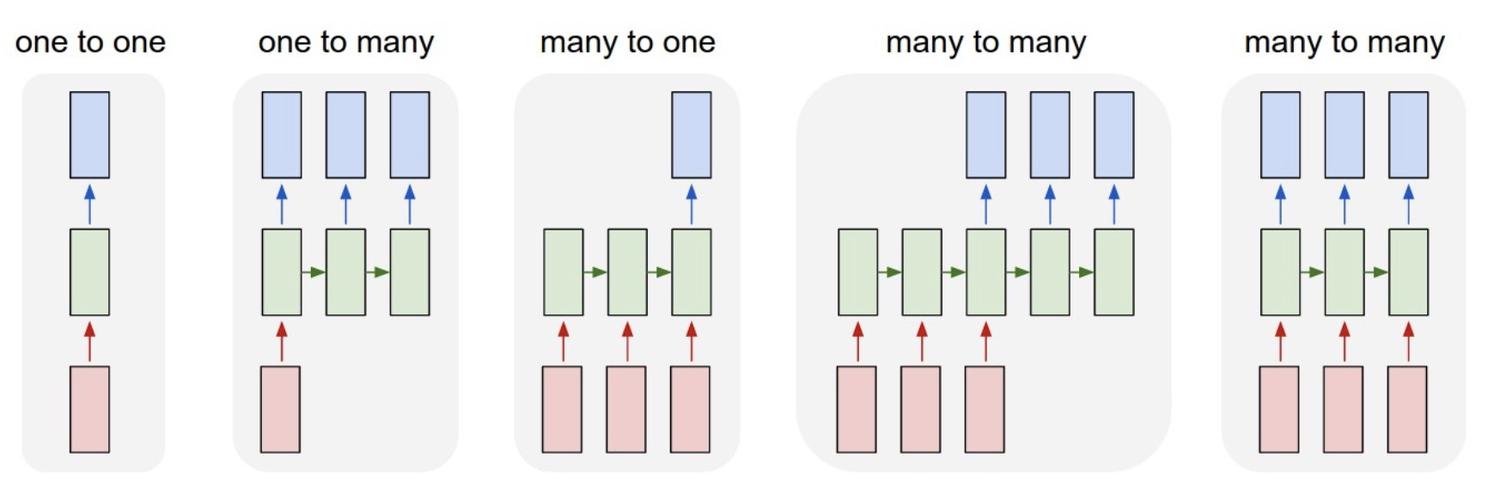

- 自然语言处理:RNN可以用于文本生成、情感分析、机器翻译等任务。

- 语音识别:RNN能够捕捉语音信号的时序特性,用于识别连续的语音流。

- 时间序列预测:在金融、气象等领域,RNN可用于预测股票价格、天气变化等。

- 音乐生成:RNN可以学习音乐的旋律和节奏,生成新的音乐片段。

循环神经网络(Recurrent Neural Networks, RNNs)在处理序列数据时非常有效,如文本、语音和音乐等。它们特别适合生成连贯的序列数据,这在AIGC(人工智能生成内容)中非常关键。

以下是一个简单的RNN案例,用于生成简单的英文文本:

- 导入必要的库

2. 准备数据 假设我们有一个简单的英文文本作为训练数据:

3. 构建RNN模型

4. 训练模型

5. 生成文本

请注意,这个例子是为了演示目的而简化的。在实际应用中,您可能需要使用更复杂的模型(如LSTM或GRU),更大量的数据,以及更细致的数据预处理和超参数调优。此外,生成文本的质量会随着训练数据质量和模型复杂度的提高而提高。

1976

1976

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?