1、第一步,安装Ubuntu

随便找个教程安装就可以了

第二步,进去之后窗口是非常小的,我们来弄一下全屏

点击虚拟机----安装VMware-tools

安装成功之后会在桌面显示VMware-tools文件

先吧这个压缩包复制一下,粘贴到其他位置,我是粘贴到这里

提取到此处就可以看见这两个,进去文件夹

进去文件之后,右键打开终端

输入命令 sudo ./vmware-install.pl 之后哪里打y,其他回车就行,之后就全屏了。

第三部:创建hadoop账户

sudo passwd hadoop添加管理员权限

sudo adduser hadoop sudo

关闭终端,之后重新开启一下。 开启快捷键ctr+alt+t

切换到Hadoop用户。

su hadoop执行更新命令

sudo apt-get update

再下载一下vim

sudo apt-get install vim

安装SSH、配置SSH无密码登陆

sudo apt-get install openssh-server

ssh localhost这里打个yes,r然后输入一下密码

执行下面的

exit # 退出刚才的 ssh localhost cd ~/.ssh/ # 若没有该目录,请先执行一次ssh localhost ssh-keygen -t rsa # 会有提示,都按回车就可以 cat ./id_rsa.pub >> ./authorized_keys # 加入授权

现在输入 ,即可以免密登录了

ssh localhost

不要结束先。先创建个文件夹来保存一下等下要用的jdk

cd /usr/lib sudo mkdir jvm #创建/usr/lib/jvm目录用来存放JDK文件

第4步,安装java jdk

下载有点慢,我们来自动选择最近服务器,下载会快一点

点开网址,https://www.oracle.com/java/technologies/javase-jdk8-downloads.html

下载对于版本的Ubuntu之后,打开所在文件夹

在文件夹里面,右键打开终端。吧文件解压到刚刚创建的jvm中

sudo tar -zxvf ./jdk-8u241-linux-x64.tar.gz -C /usr/lib/jvm #把JDK文件解压到/usr/lib/jvm目录下

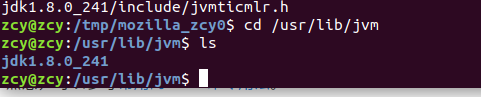

解压完看一下安装成功了不,这里是成功,解压到下面了。

cd /usr/lib/jvm ls

接下来我们来配置一下环境变量

cd ~ gedit ~/.bashr然后吧下面的粘贴到文件头部

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_241 export JRE_HOME=${JAVA_HOME}/jre export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib export PATH=${JAVA_HOME}/bin:$PATH

点击保存即可

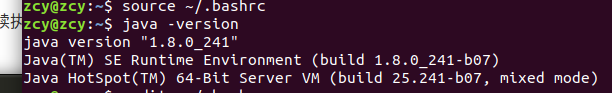

source ~/.bashrc #执行命令让配置马上生效java -version #查看jdk是否配置成功

第5步,安装hadoop3.1.3

下载官网

https://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-3.1.3/hadoop-3.1.3.tar.gz

我这里是点击http 下的 第一个gz文件下载

下载成功之后打开所在文件夹,在文件夹那边右键打开打开终端

sudo tar -zxf hadoop-3.1.3.tar.gz -C /usr/local

修改一下用户名和文件权限

cd /usr/local/ sudo mv ./hadoop-3.1.3/ ./hadoop # 将文件夹名改为hadoop sudo chown -R hadoop ./hadoop # 修改文件权限 sudo chmod -R 777 /usr/local/hadoop/logs查看一下hadoop 是否可用

cd /usr/local/hadoop ./bin/hadoop version没问题

第六步,hadoop单机配置

创建input 文件夹

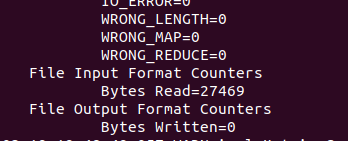

cd /usr/local/hadoop mkdir ./input cp ./etc/hadoop/*.xml ./input # 将配置文件作为输入文件./bin/hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar grep ./input ./output 'dfs[a-z.]+'

第七步,hadoop 伪分布式

cd /usr/local/hadoop/etc/hadoop/

sudo gedit core-site.xml打开之后吧原来这个替换了

原来是这样的

<configuration>

</configuration>替换之后是这样的

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

接下来还有一个文件配置一下

sudo gedit hdfs-site.xml

接下来,先配置一下

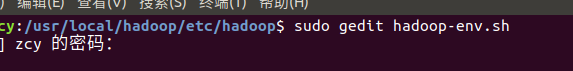

cd /usr/local/hadoop/etc/hadoop/sudo gedit hadoop-env.sh找到里面第二个JAVA_HOME ,r然后吧这个替换上去 export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_241

NameNode 的格式化:

cd /usr/local/hadoop

sudo ./bin/hdfs namenode -format

关闭,重新打开终端测试一下

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?