课程地址:(超爽中英!) 2024公认最好的【吴恩达深度学习】教程!附课件代码 Professionalization of Deep Learning_哔哩哔哩_bilibili

1.目录

2.什么是神经网络

3.用神经网络进行监督学习

4.为什么深度学习会兴起

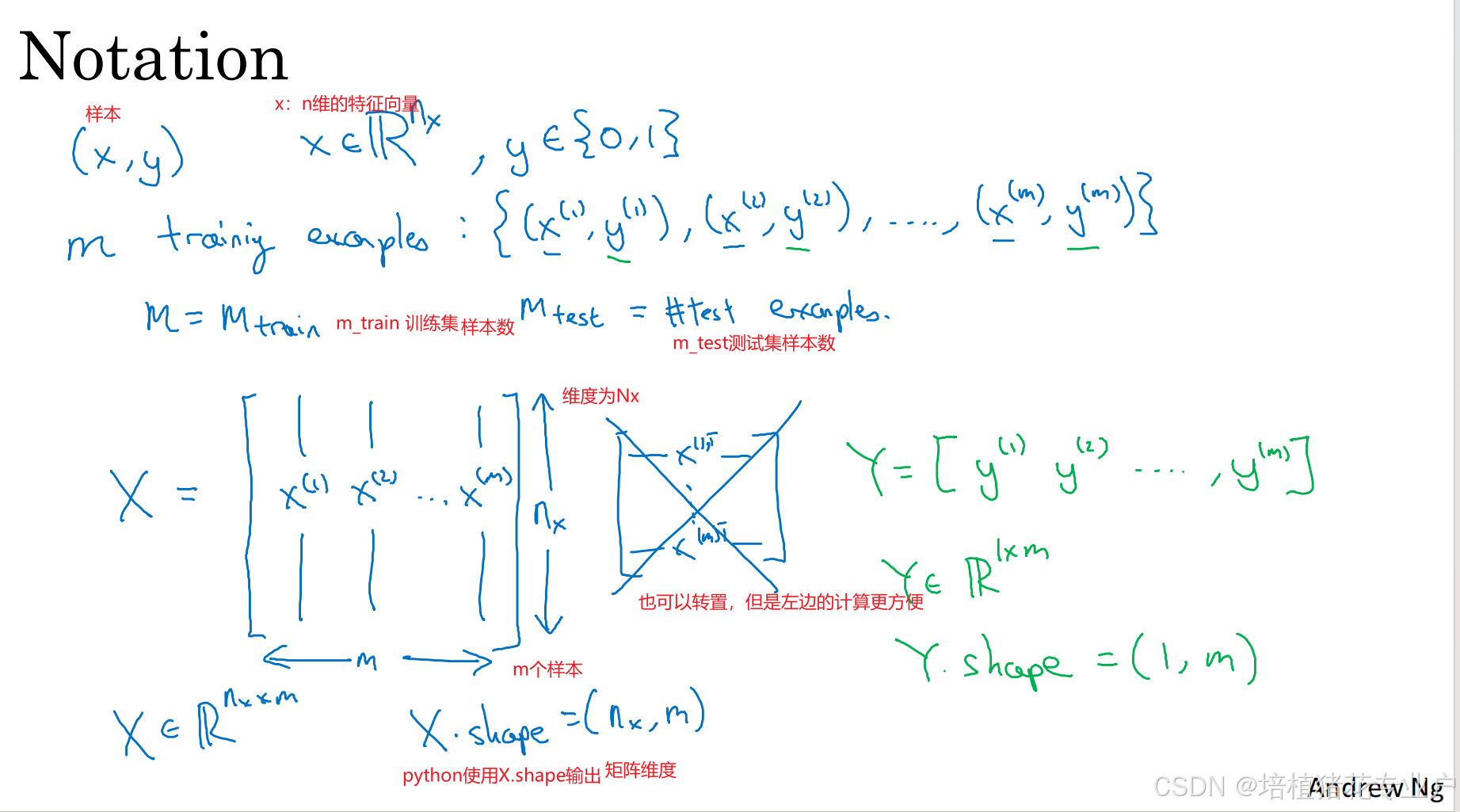

7.二分分类

适用于二元分类问题的函数:逻辑回归,输出0/1

9.logistic回归损失函数

10.梯度下降法

15.logistic回归中的梯度下降法

![]()

da/dZ=![]() =a(1-a)

=a(1-a)

所以dL/dZ=a-y

求dL/dw1=x1*dZ dL/dw2=x2*dZ dL/db=dZ

16.m个样本的梯度下降

上图就是梯度下降的一次迭代

上图就是梯度下降的一次迭代

但是在里面有两个循环,外层循环是1~m,内层循环是w1~wn

矢量化可以避免循环

17.向量化

用向量化避免loop,提高代码运行速率

18.向量化的更多例子

19.向量化logistic回归

正向传播一步迭代的向量化实现,同时处理m个训练样本

20.向量化logistic回归的梯度输出

上个视频学会了计算向量化计算整个训练集预测值a

这个视频将学会向量化计算m个训练数据的梯度

这个技术叫Broadcasting

21.Python中的广播

24.(选修)logistic损失函数的解释 未来看

25.神经网络概览

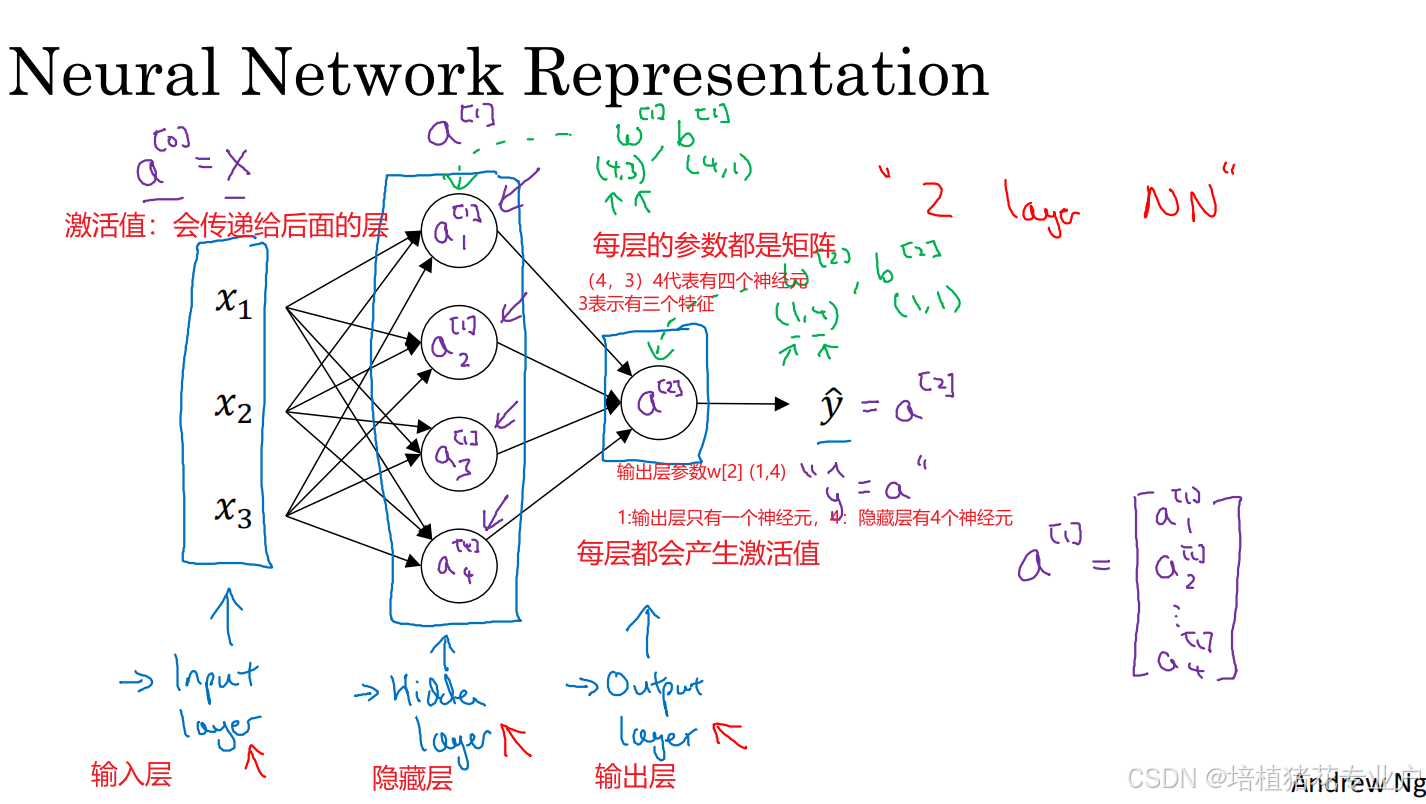

26.神经网络表示

a[0] a[n]每一层的激活值

27.计算神经网络的输出

补:a[1]=将sigmoid作用于矩阵Z[1]

向量化的经验法则:如果一层有不同的节点,就将他们纵向堆叠起来

28.多样本向量化 29向量化实现的解释 都是线代

30.激活函数

建立神经网络有很多选择,比如隐藏单元数、激活函数、如何初始化权重

对于你的项目,事实上很难预测哪种选择最有效,最好是实际上跑一跑

31.为什么需要非线性激活函数

只有一种情况可以使用线性激活函数,就是当预测房价,最高可以无穷大,那么在输出层可以使用线性激活函数,并且隐藏层必须是非线性的激活函数

只有压缩或者非常特殊的情况,在隐藏层使用线性激活函数

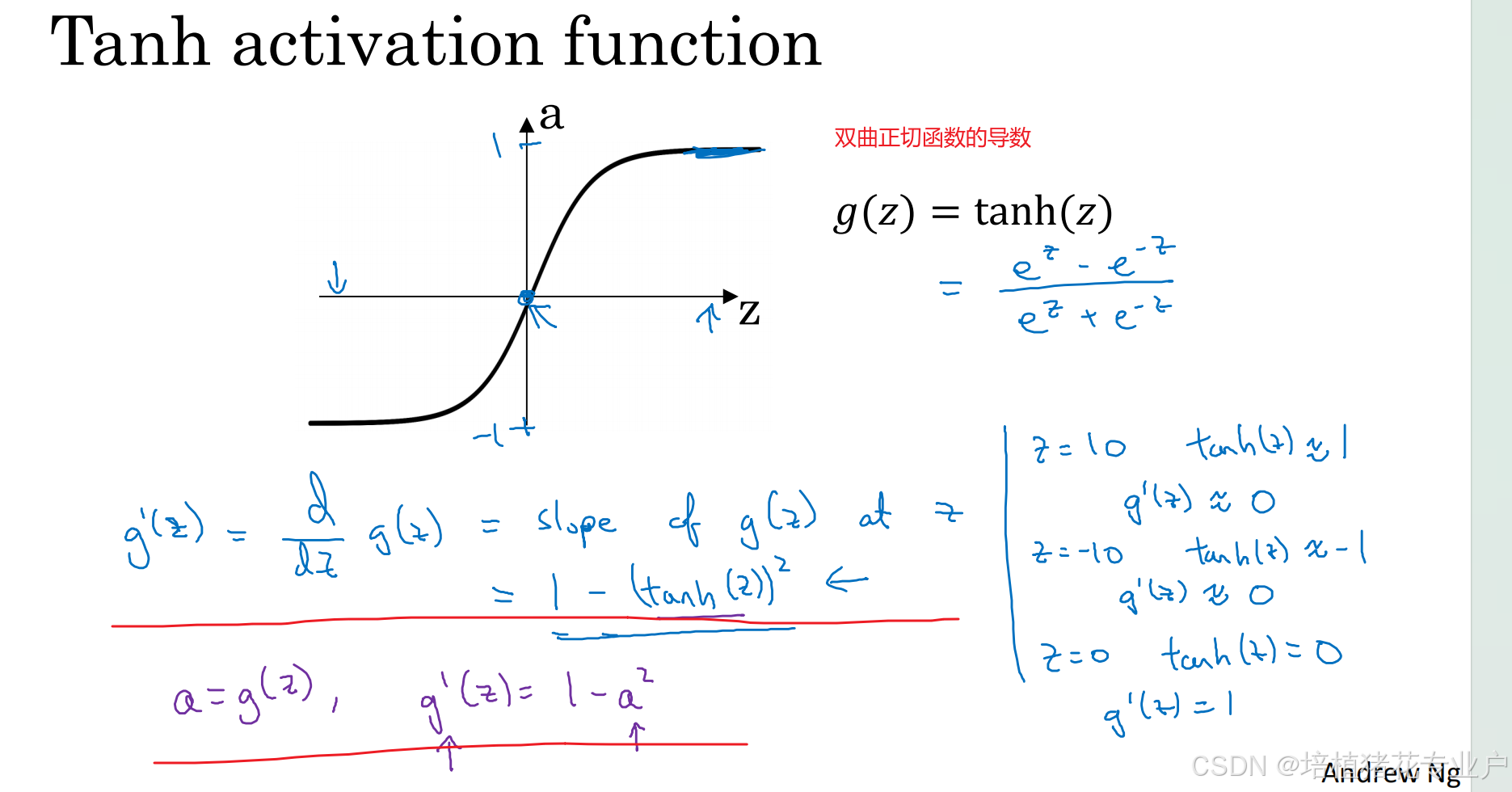

32.激活函数的导数

33.神经网络的梯度下降法

34.(选修)直观理解反向传播

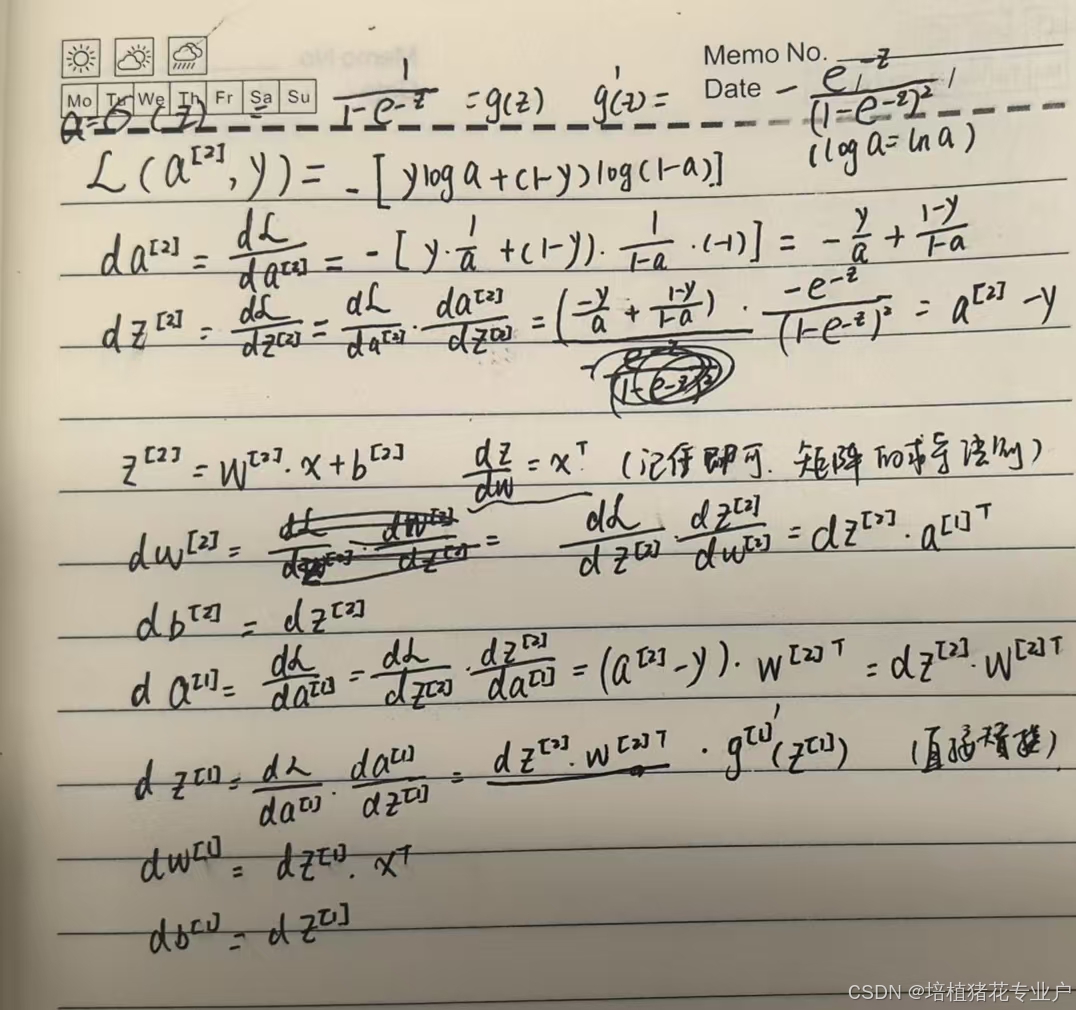

反向传播公式手推:

35.随机初始化

补充:每个激活函数的权重也是一样的

单层神经网络设为0.01应该还可以,如果是深层的需要尝试其他的constant

36.深层神经网络

介绍了一些符号约定。

a[l]最后一层的a l表示层数

856

856

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?