AI 竞赛正以前所未有的速度加速,继 Meta 昨天推出其新的开源 Llama 3.1 模型之后,法国 AI 初创公司 Mistral AI 也加入了竞争。

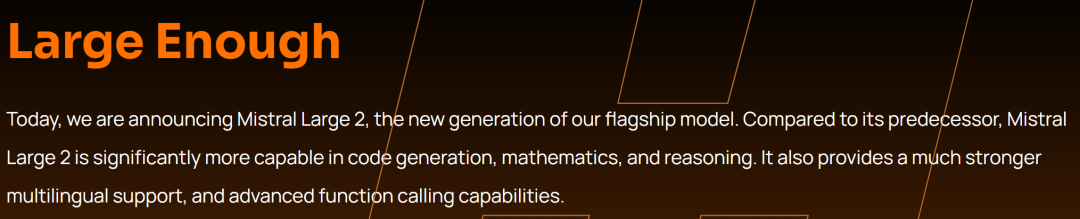

刚刚,Mistral AI 宣布其旗舰开源模型的下一代产品:Mistral Large 2,该模型拥有 1230 亿个参数,在代码生成、数学、推理等方面与 OpenAI 和 Meta 的最新尖端模型不相上下。

紧随 Llama 3.1 405B 之后,Mistral Large 2 的发布让开源大模型的赛道一下子热闹起来,而这一模型的特点是 ——「足够大」。

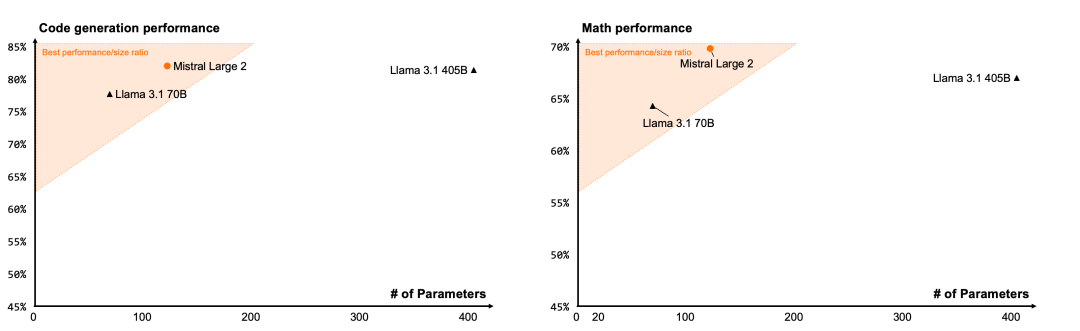

具体来说,虽然 Mistral Large 2 参数量低于 Llama 3.1 的 4050 亿,但两者性能接近。并且在多个基准测试中与 GPT-4o、Anthropic 的 Claude 3.5 Sonnet 媲美。

今年 2 月,Mistral AI 推出了最初的 Large 模型,其上下文窗口包含 32,000 个 token,新版模型在此基础上构建,具有更大的 128,000 个上下文窗口(大约相当于一本 300 页的书)—— 与 OpenAI 的 GPT-4o 和 GPT-4o mini 以及 Meta 的 Llama 3.1 相匹配。

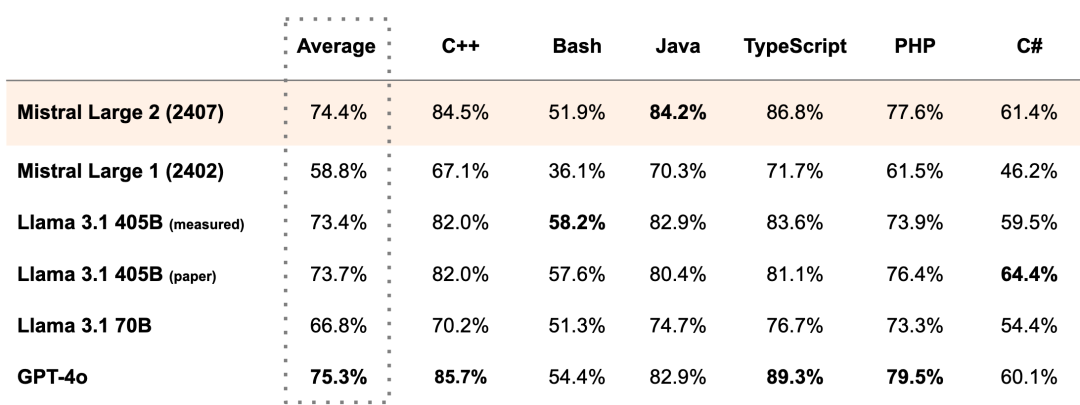

目前,Mistral Large 2 支持数十种语言,包括法语、德语、西班牙语、意大利语、葡萄牙语、阿拉伯语、印地语、俄语、中文、日语和韩语,以及 80 多种编程语言,包括 Python、Java、C、C++、JavaScript 和 Bash。

Mistral AI 指出,新模型将继续突破成本效率、速度和性能的界限,同时为用户提供新功能,包括高级函数调用和检索,以构建高性能的 AI 应用。

不过,值得注意的是,Mistral Large 2 虽然是开放的,但只限于研究和非商业用途。它提供了开放的权重,允许第三方根据自己的需求对模型进行微调。这一协议是对用户使用条件的一个重要限制。对于需要自行部署 Mistral Large 2 的商业用途,必须提前获取 Mistral AI 商业许可证。

性能表现

在多项评估指标上,Mistral Large 2 刷新了性能和服务成本的新标准。特别是在 MMLU 上,预训练版本实现了 84.0% 的准确率。

代码与推理

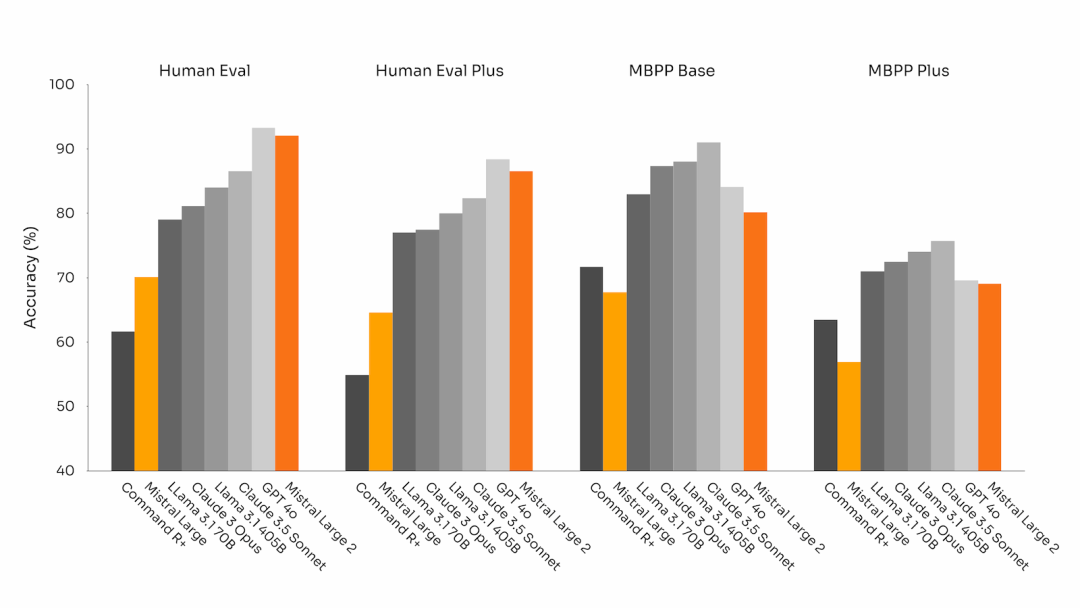

Mistral AI 基于此前 Codestral 22B 和 Codestral Mamba 的经验,在很大一部分代码上训练了 Mistral Large 2。

Mistral Large 2 的表现远远优于上一代的 Mistral Large,并且与 GPT-4o、Claude 3 Opus 和 Llama 3 405B 等顶尖模型相当。

Mistral AI 还投入了大量精力来增强模型的推理能力,重点之一就是尽量减少模型产生「幻觉」或产生看似合理但实际上不正确或不相关信息的倾向。这是通过微调模型来实现的,使其在回复时更加谨慎和敏锐,确保其提供可靠和准确的输出。

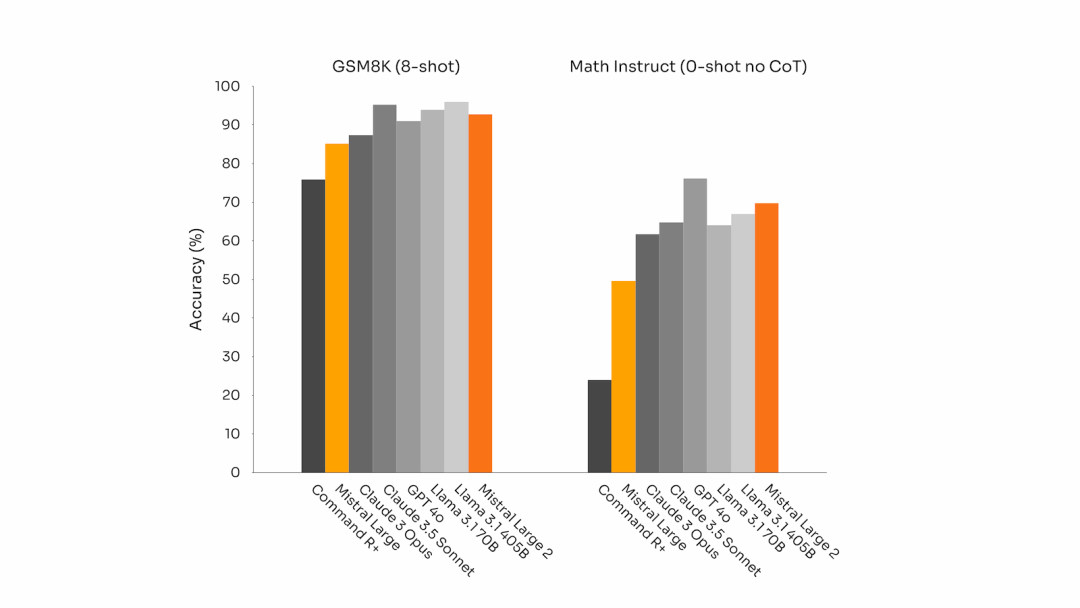

此外,在找不到解决方案或没有足够的信息来提供一个自信的答案时,Mistral Large 2 会承认(自己答不出来)。这种对准确性的追求体现在了数学基准测试中模型性能的提高,下图展示了其增强的推理和解决问题的能力:

代码生成基准上的性能准确性(所有模型都通过相同的评估流程进行基准测试)。

MultiPL-E 上的性能准确性(除 paper 外,所有模型都通过相同的评估流程进行基准测试)。

GSM8K(8-shot)和 MATH(0-shot,无 CoT)生成基准上的性能准确性(所有模型都通过相同的评估流程进行基准测试)。

指令遵循与对齐

Mistral AI 大幅提升了 Mistral Large 2 的指令遵循和对话能力。新的 Mistral Large 2 尤其擅长遵循精确指令和处理长时间的多轮对话。

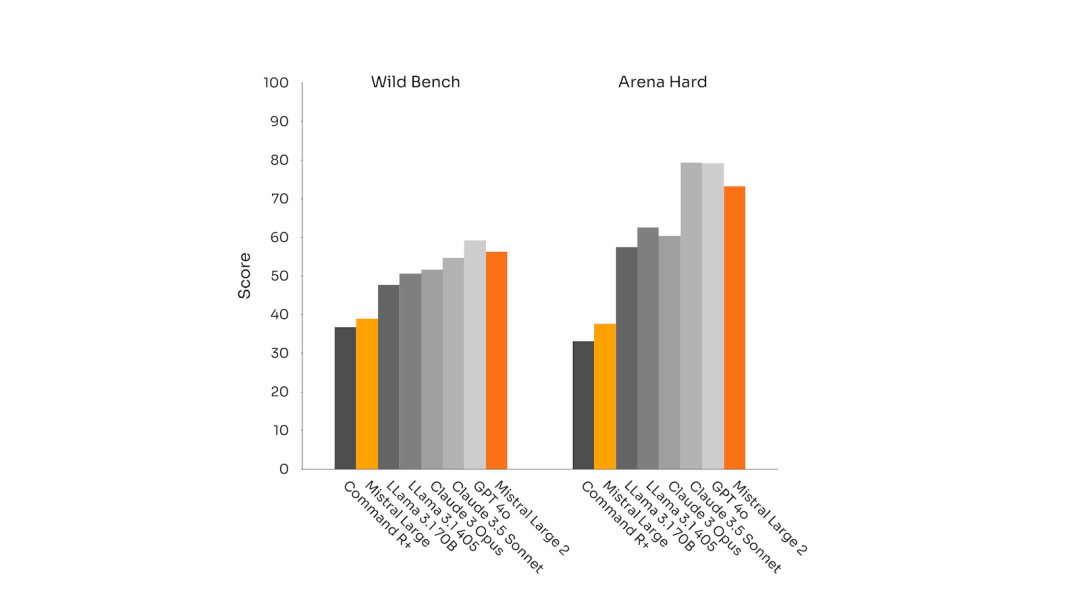

以下是其在 MT-Bench、Wild Bench 和 Arena Hard 基准测试中的表现:

模型在通用对齐基准测试中的性能(所有模型均通过相同的评估 pipeline 进行测试)

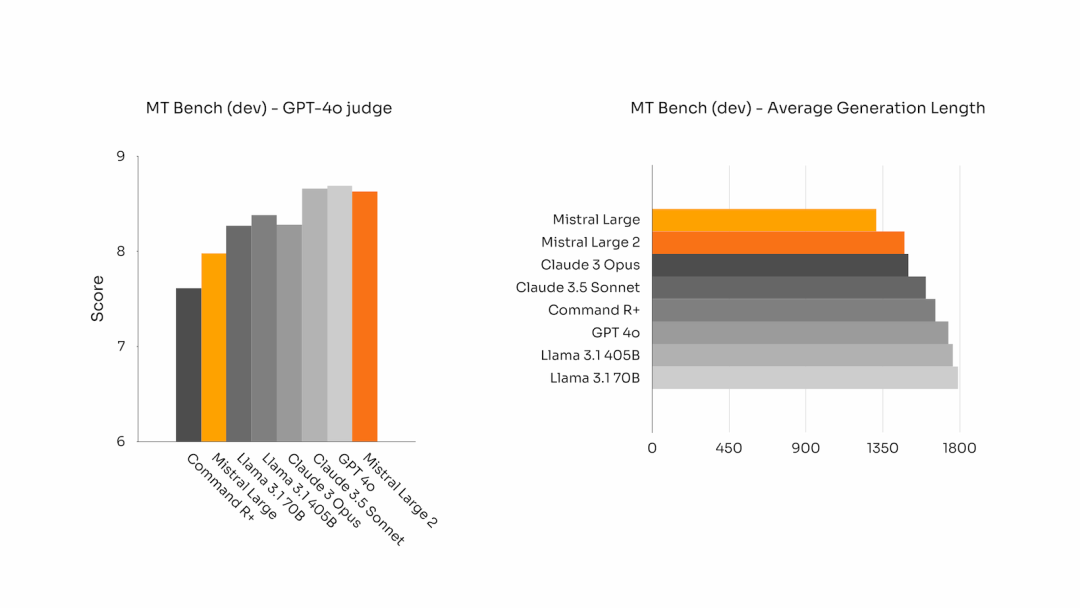

在某些基准测试中,生成较长的回答往往会提高评分。然而,在许多商业应用中,简洁至关重要,这是因为简洁的模型生成能够加快交互速度,并降低推理成本。

所以 Mistral AI 花费了大量精力,确保生成的内容尽可能简明扼要。

下图展示了在 MT Bench 基准测试的问题上,不同模型生成的回答的平均长度:

语言多样性

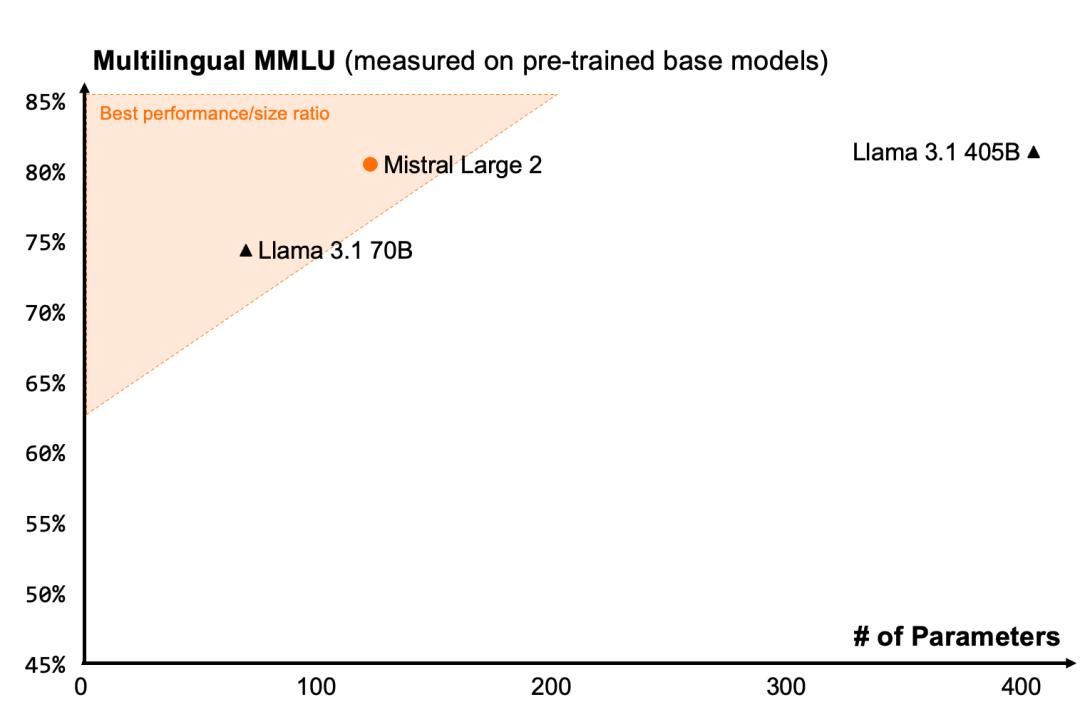

当今大量的商业化应用场景涉及处理多语言文档。Mistral Large 2 在大量多语言数据上进行了训练,特别是在英语、法语、德语、西班牙语、意大利语、葡萄牙语、荷兰语、俄语、中文、日语、韩语、阿拉伯语和印地语方面都表现优异。

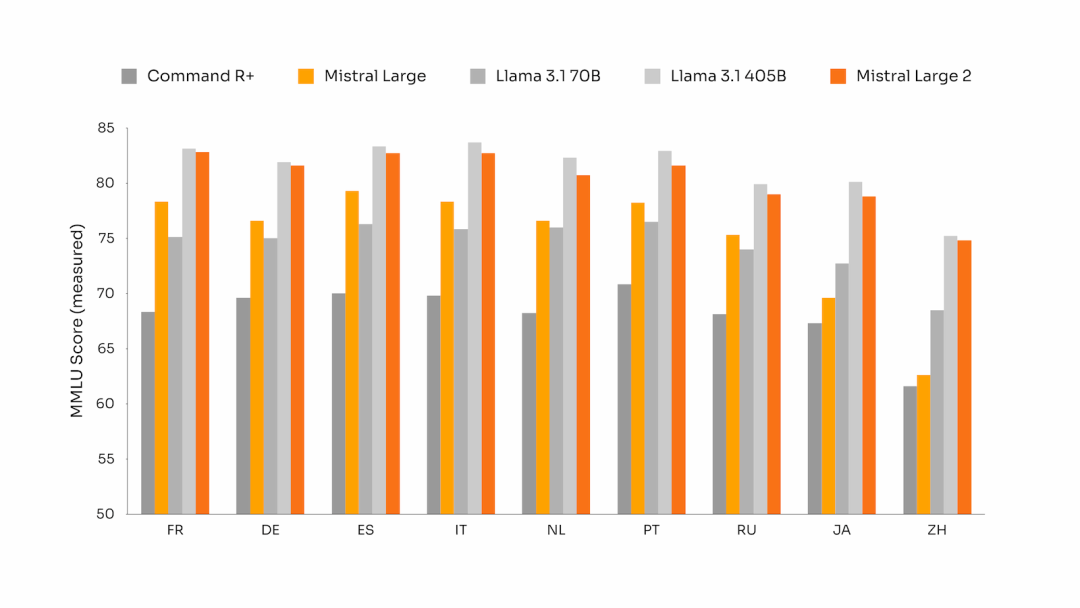

以下是 Mistral Large 2 在多语言 MMLU 基准测试中的性能结果,主要是与之前的 Mistral Large、Llama 3.1 模型以及 Cohere 的 Command R+ 的对比:

多语言 MMLU 性能(以基础预训练模型测量)

工具使用与函数调用

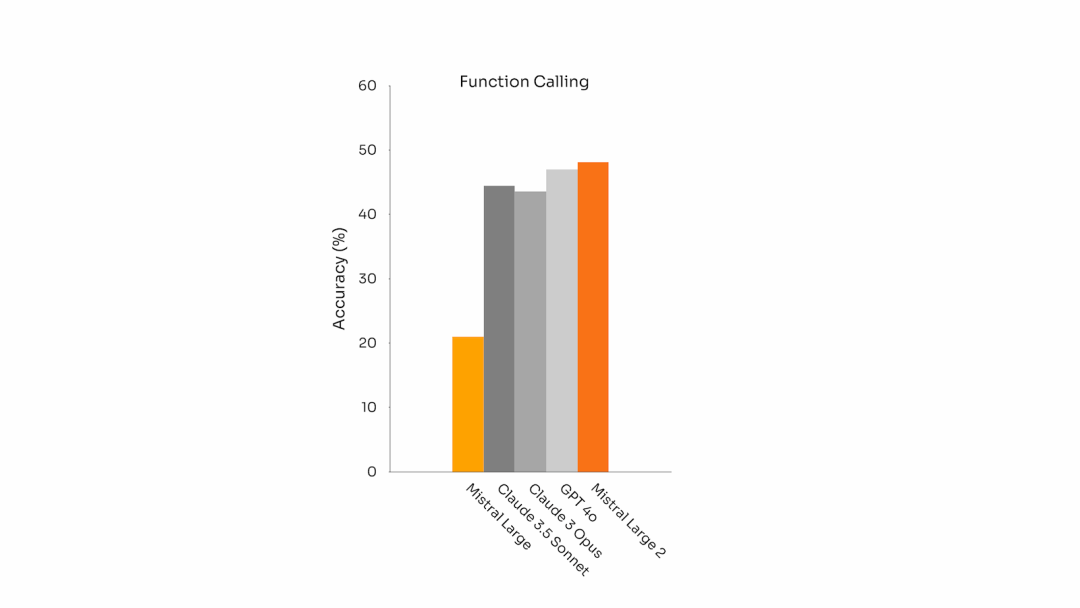

Mistral Large 2 配备了增强的函数调用和检索技能,经过训练能够熟练地执行并行和顺序函数调用,使其能够成为复杂业务应用程序的强大引擎。

下图为 Mistral Large 2 在函数调用上与其他主流模型的准确性对比:

试用 Mistral Large 2

用户可以通过 la Plateforme 上使用 Mistral Large 2,名称为 mistral-large-2407 ,并在 le Chat 上测试。它的版本是 24.07(Mistral 对所有模型采用的都是 YY.MM 版本编号系统),API 名称为 mistral-large-2407。

指令模型的权重已提供,托管在 HuggingFace 上。

权重链接:https://huggingface.co/mistralai/Mistral-Large-Instruct-2407

Mistral AI 正在将 la Plateforme 上的产品整合为两个通用模型:Mistral Nemo 和 Mistral Large,以及两个专业模型:Codestral 和 Embed。随着他们逐步淘汰 la Plateforme 上的旧模型,所有的 Apache 模型(包括 Mistral 7B、Mixtral 8x7B 和 8x22B、Codestral Mamba、Mathstral)仍然可以使用 Mistral AI 的 SDK——mistral-inference 和 mistral-finetune 进行部署和微调。

从今天开始,他们扩展了 la Plateforme 上的微调功能:现在,这些功能适用于 Mistral Large、Mistral Nemo 和 Codestral。

此外,Mistral AI 与云服务提供商都有合作,Mistral Large 2 将很快登陆这些平台。Mistral AI 扩大了与 Google Cloud Platform 的合作,通过 Managed API 将 Mistral AI 的模型引入 Vertex AI。与此同时,还可以在 Amazon Bedrock、Azure AI Studio 和 IBM watsonx.ai 上找到。

参考链接:

https://mistral.ai/news/mistral-large-2407/

https://venturebeat.com/ai/mistral-shocks-with-new-open-model-mistral-large-2-taking-on-llama-3-1/

https://techcrunch.com/2024/07/24/mistral-releases-large-2-meta-openai-ai-models/

339

339

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?