作者:李宝珠

编辑:xixi、李宝珠

HyperAI超神经为大家上线了 Llama 3.1 405B 和 Mistral Large 2407 的一键部署教程,无需输入任何命令,只需点击「克隆」即可体验。

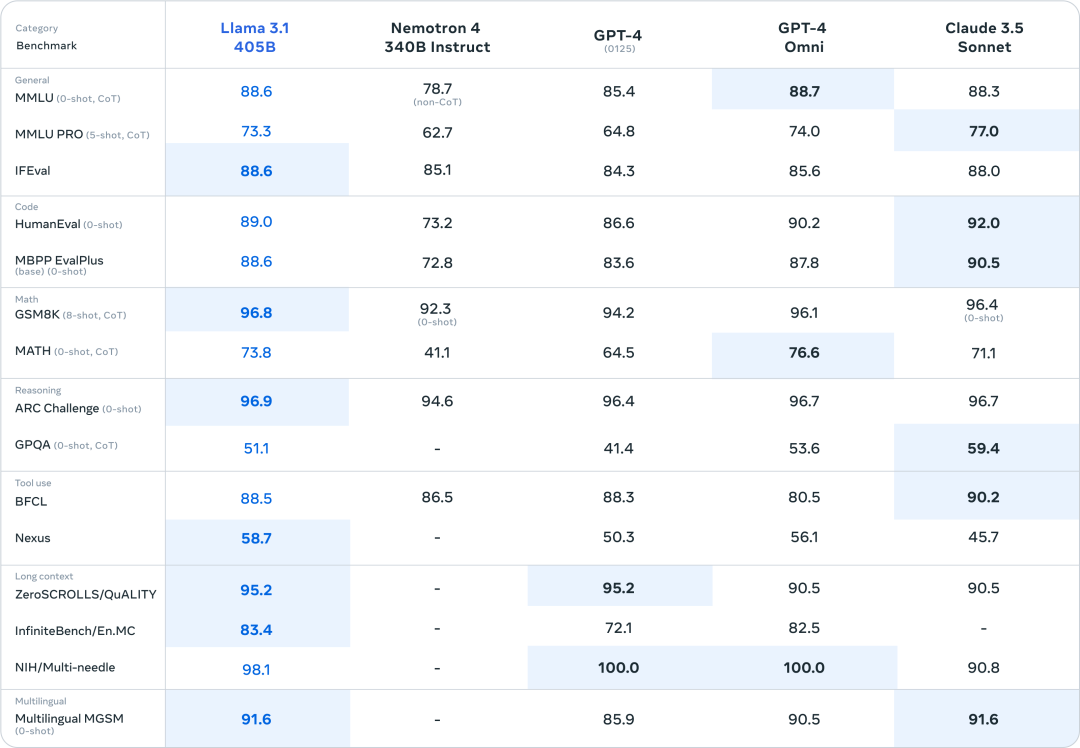

当地时间 7 月 23 日,Meta 正式发布 Llama 3.1,超大号的 405B 参数版本强势开启了开源模型的高光时刻,在多项基准测试中,表现追平甚至超越了现有 SOTA 模型 GPT-4o 和 Claude 3.5 Sonnet。

扎克伯格也在 Llama 3.1 发布当日撰写了一篇题为「开源 AI 是前进之路」的长文,称 Llama 3.1 将成为行业的转折点。与此同时,业界一方面对于 Llama 3.1 所展现的强大能力跃跃欲试,另一方面也期待闭源大模型将如何接招。

有意思的是,Llama 3.1 这厢才问鼎王座,那厢 Mistral AI 就正面硬刚,发布 Mistral Large 2 并直指 405B 模型的「软肋」——难部署。

毫无疑问,405B 参数规模所需的硬件能力对于个人开发者而言,并不是一道能够轻易跨过的门槛,大多数爱好者只能望而却步。而 Mistral Large 2 模型参数量仅有 123B,不足 Llama 3.1 405B 的三分之一,部署门槛也随之降低,但性能却可以与 Llama 3.1「掰一掰手腕」。

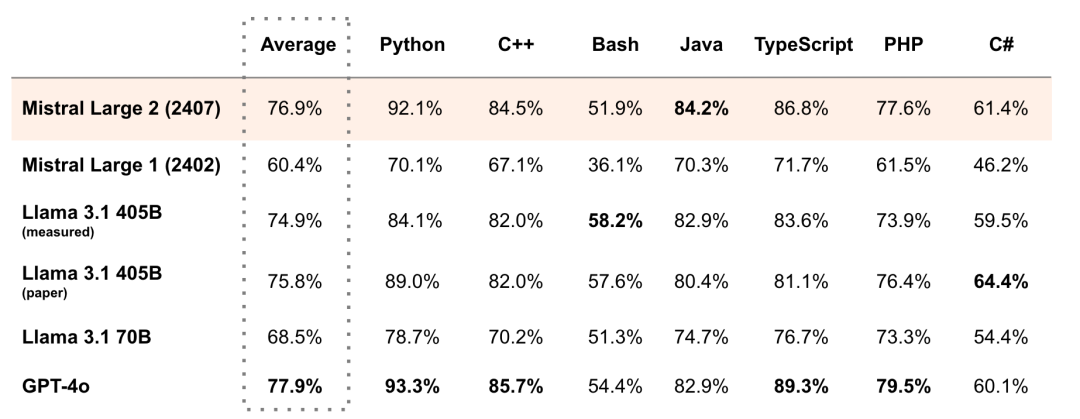

例如,在 MultiPL-E 的多种编程语言基准测试中,Mistral Large 2 的平均得分超越 Llama 3.1 405B,与 GPT-4o 相差 1%,在 Python、C++、Java 等方面均超越 Llama 3.1 405B。正如其官方所言,Mistral Large 2 在评估指标的性能/服务成本方面开辟了新的前沿。

一边是目前的开源模型参数规模「天花板」,另一边是超高「性价比」的开源新时代引领者,相信小伙伴们都不想错过!别着急,HyperAI超神经为大家上线了 Llama 3.1 405B 和 Mistral Large 2407 的一键部署教程,无需输入任何命令,只需点击「克隆」即可体验。

* 使用 Open WebUI 一键部署 Llama 3.1 405B 模型:

https://go.hyper.ai/iyL60

* 使用 Open WebUI 一键部署 Mistral Large 2407 123B:

https://go.hyper.ai/Bwf6G

同时,我们还准备了进阶教程,大家可以按需选择:

* 一键部署 Llama 3.1 405B 模型 OpenAI 兼容 API 服务:

https://go.hyper.ai/1AiDi

* 一键部署 Mistral Large 2407 123B 模型 OpenAI 兼容 API 服务:

https://go.hyper.ai/Smexo

小编使用 Open WebUI 一键部署 Mistral Large 2407 123B,并进行了测试,针对大模型频频翻车的「9.9 与 9.11 哪个大」的问题,Mistral Large 2 也未能幸免:

感兴趣的小伙伴速来体验吧,详细教程如下 ⬇️

Demo 运行

本次文字教程会以「使用 Open WebUI 一键部署 Mistral Large 2407 123B」和「一键部署 Llama 3.1 405B 模型 OpenAI 兼容 API 服务」为例,为大家拆解操作步骤。

使用 Open WebUI 一键部署 Mistral Large 2407 123B

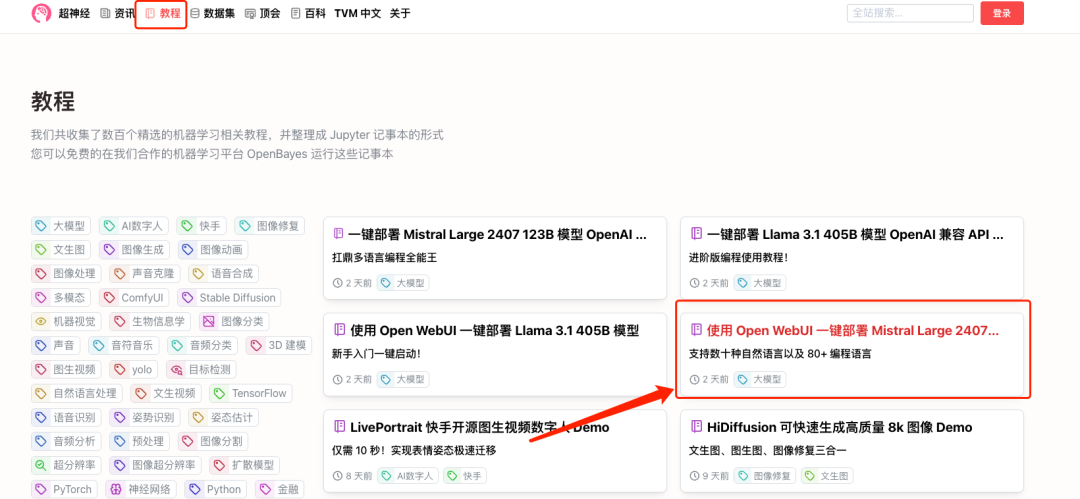

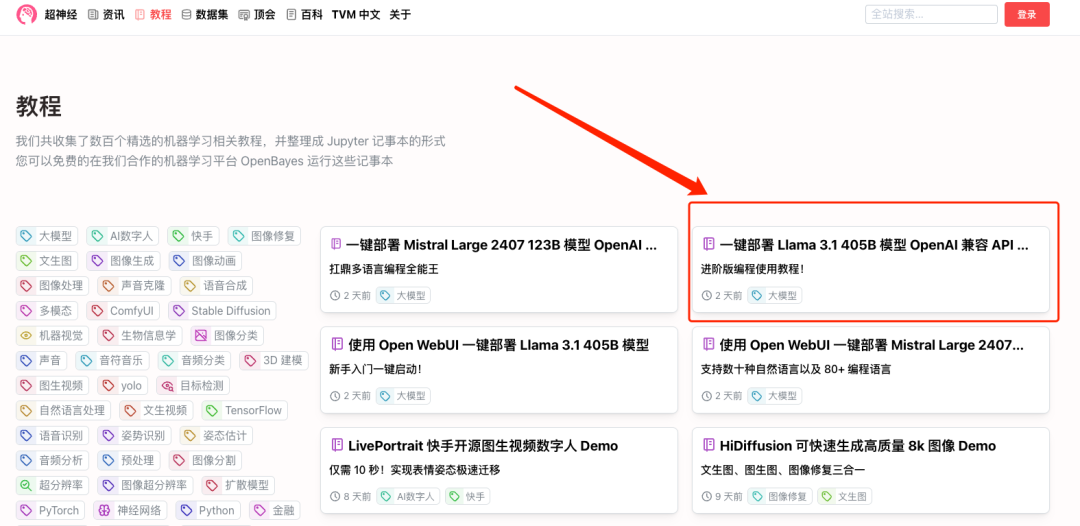

1. 登录 hyper.ai,在「教程」页面,选择「使用 Open WebUI 一键部署 Mistral Large 2407 123B」,点击「在线运行此教程」。

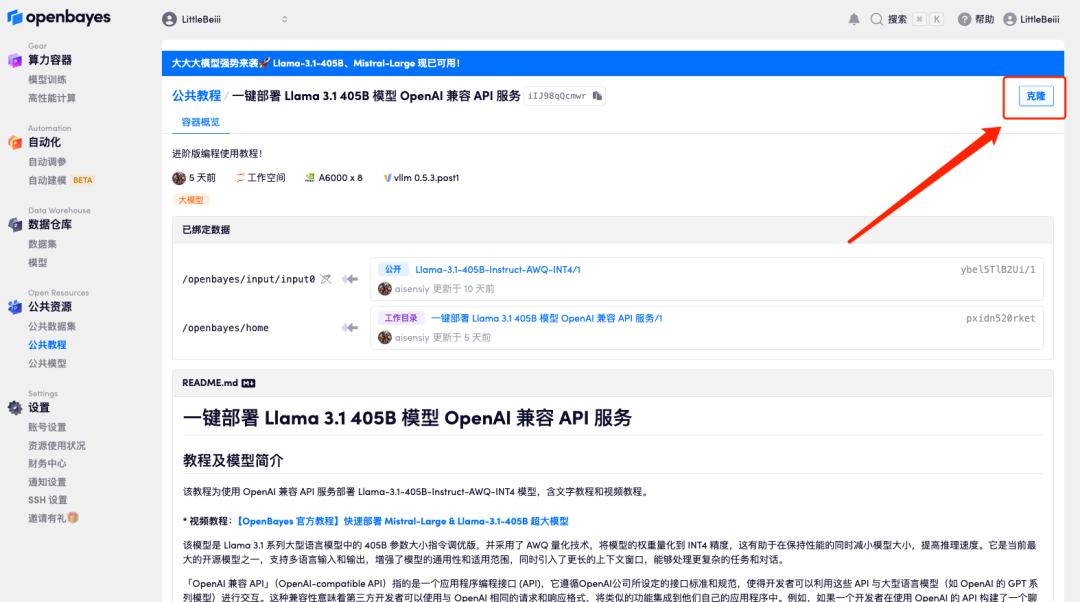

2. 页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

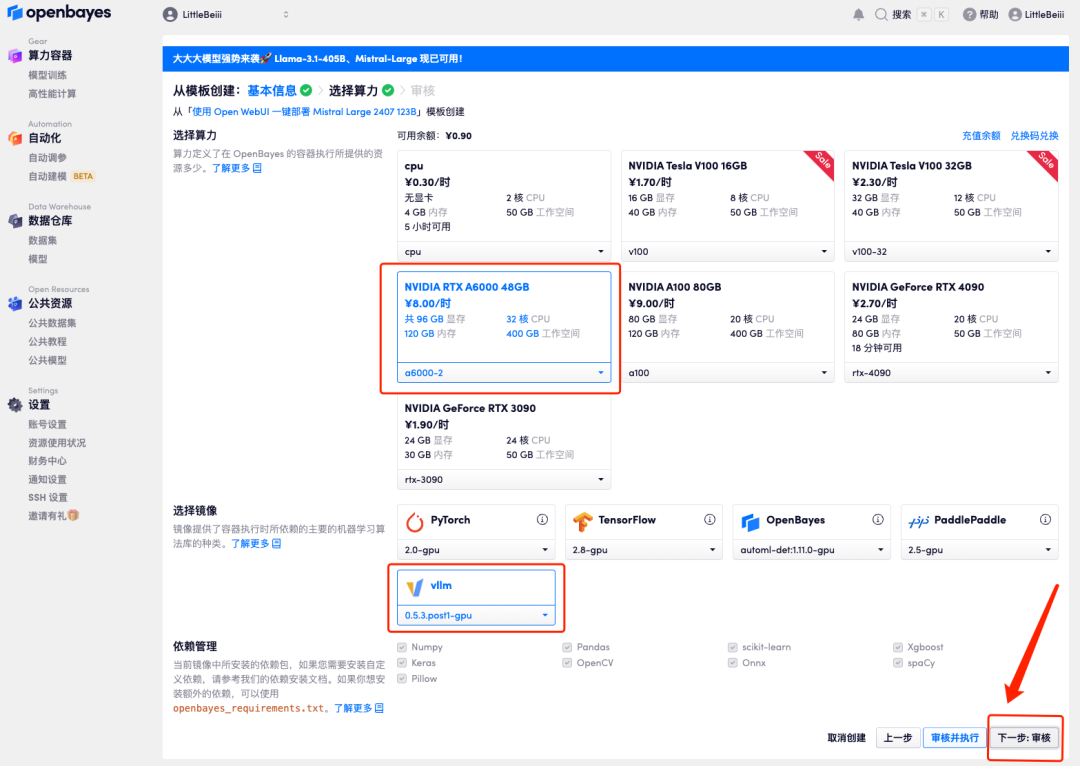

3. 点击右下角「下一步:选择算力」。

4. 页面跳转后,选择「NVIDIA RTX A6000-2」以及 「vllm」镜像,点击「下一步:审核」。新用户使用下方邀请链接注册,可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费时长!

HyperAI超神经专属邀请链接(直接复制到浏览器打开):

https://openbayes.com/console/signup?r=6bJ0ljLFsFh_Vvej

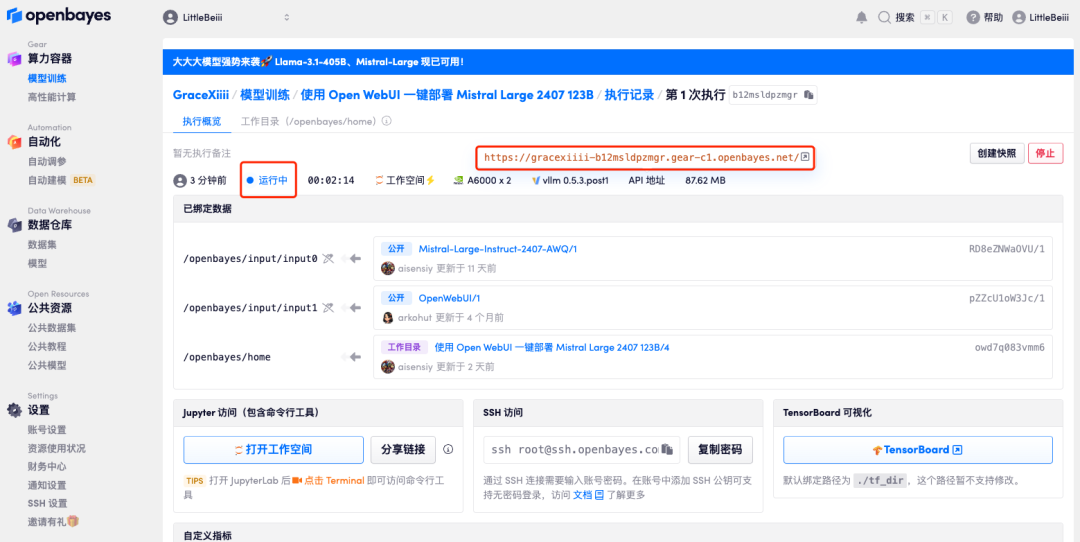

5. 确认无误后,点击「继续执行」,等待分配资源,首次克隆需等待 2 分钟左右的时间。当状态变为「运行中」后,点击「API 地址」边上的跳转箭头,即可跳转至 Demo 页面。请注意,用户需在实名认证后才能使用 API 地址访问功能。

若超过 10 分钟仍处于「正在分配资源」状态,可尝试停止并重启容器;若重启仍无法解决,请在官网联系平台客服。

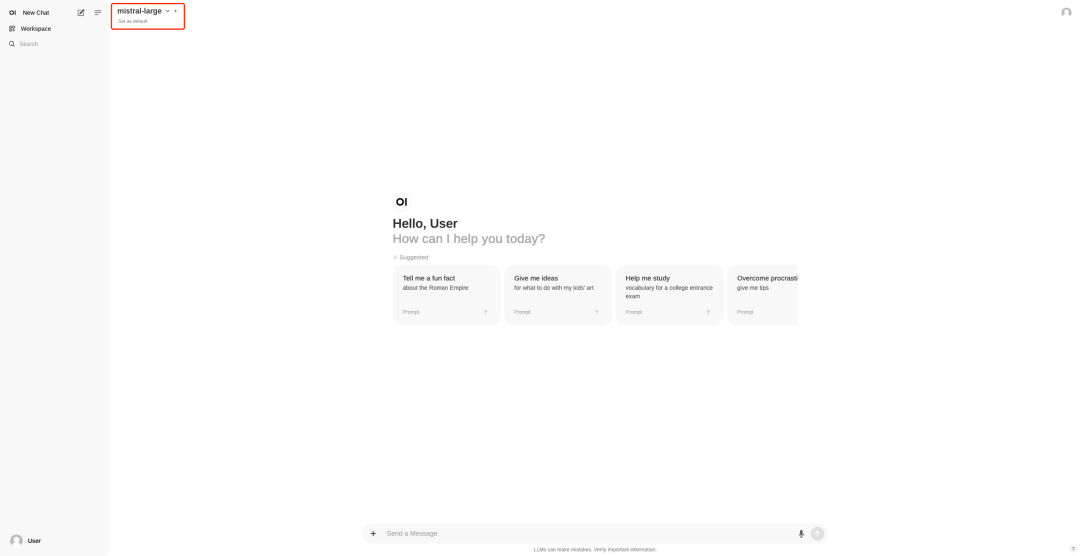

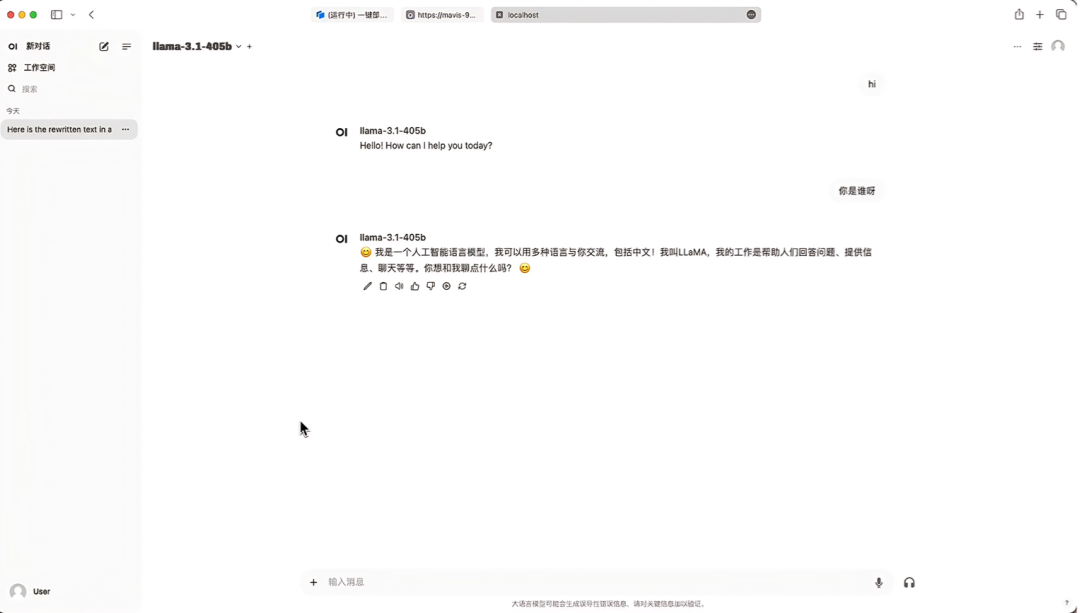

6. 打开 Demo 后,即可立即开启对话。

一键部署 Llama 3.1 405B 模型 OpenAI 兼容 API 服务

1. 想要部署 OpenAI 兼容 API 服务的小伙伴,在教程界面选择「一键部署 Llama 3.1 405B 模型 OpenAI 兼容 API 服务」,同样,点击「在线运行教程」

2. 页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

3. 点击右下角「下一步:选择算力」。

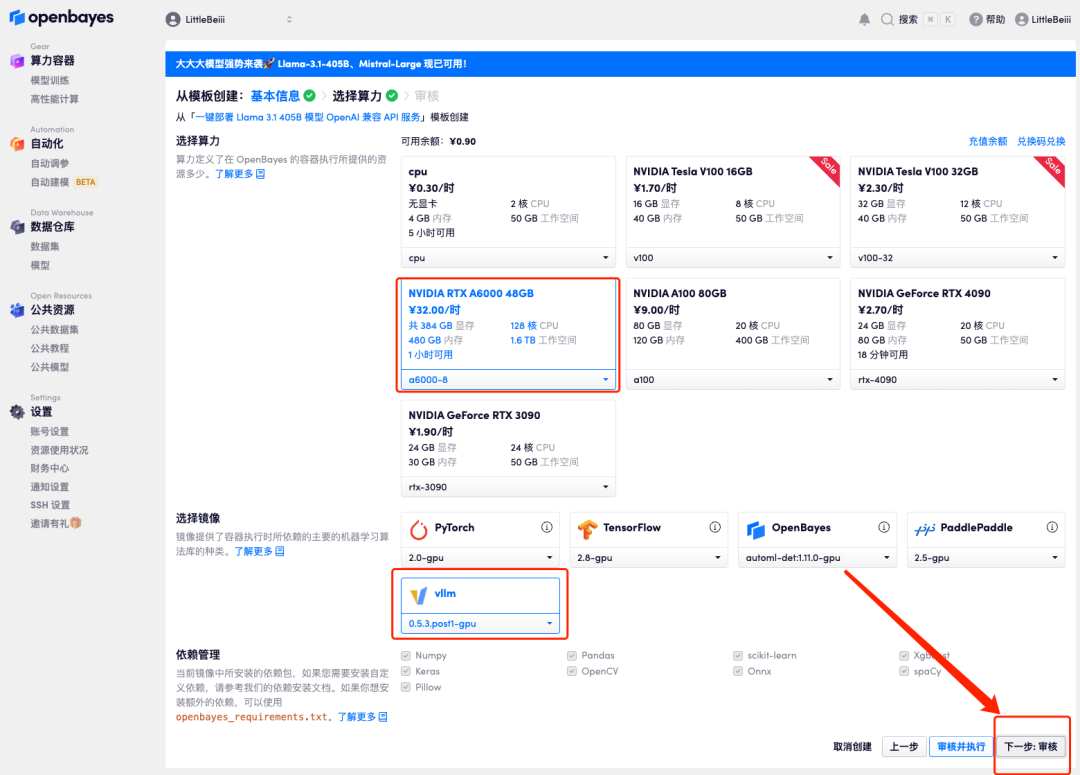

4. 页面跳转后,因模型较大,算力资源需要选择「NVIDIA RTX A6000-8」,镜像依旧选择「vllm」,点击「下一步:审核」。

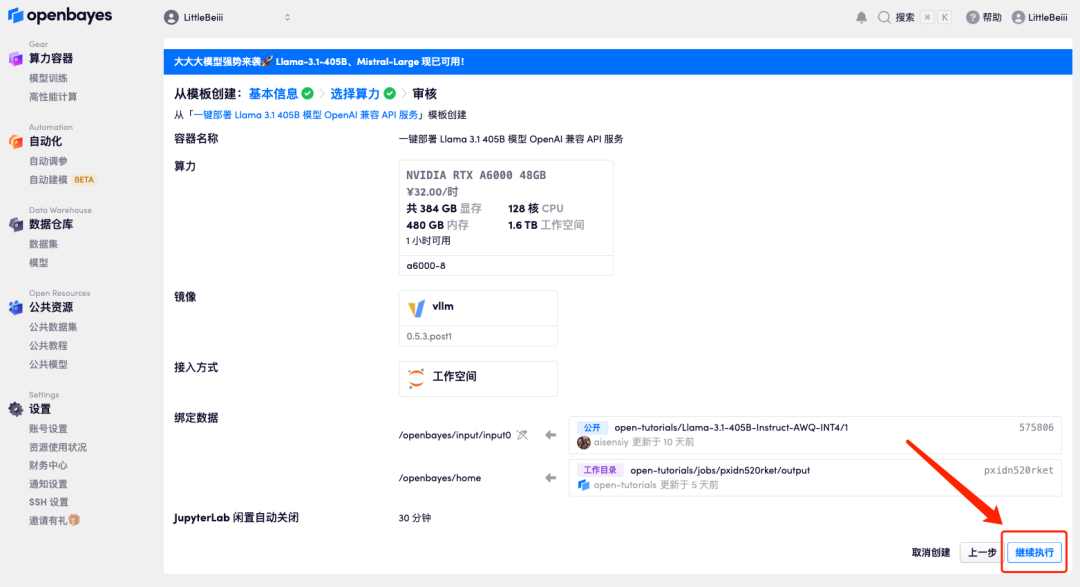

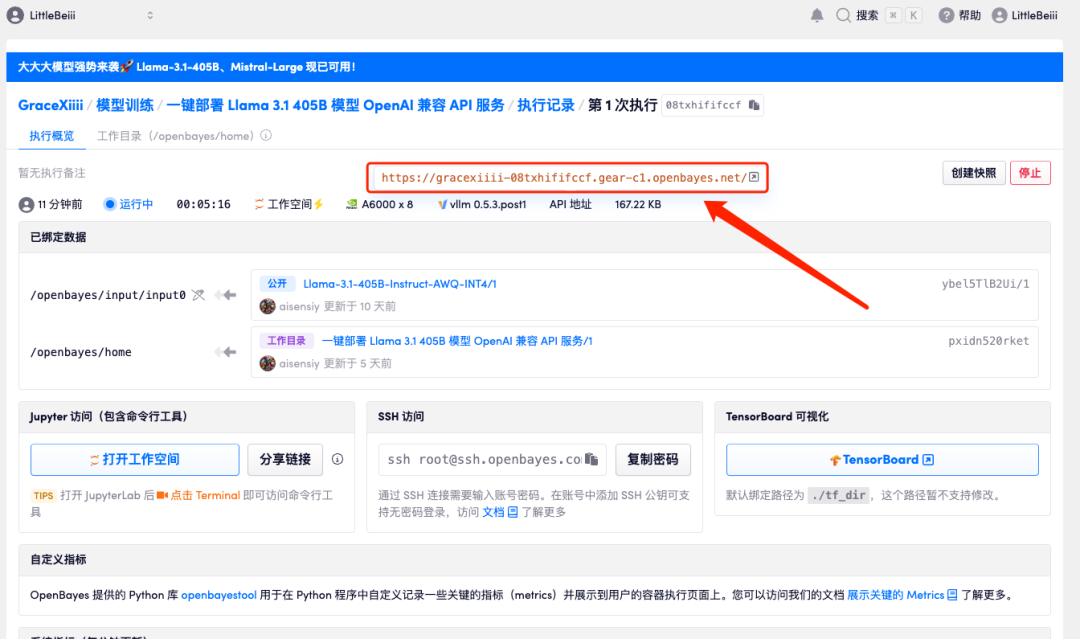

5. 确认无误后,点击「继续执行」,等待分配资源,首次克隆需等待 6 分钟左右的时间,待状态显示为「运行中」后,模型会自动开始加载。

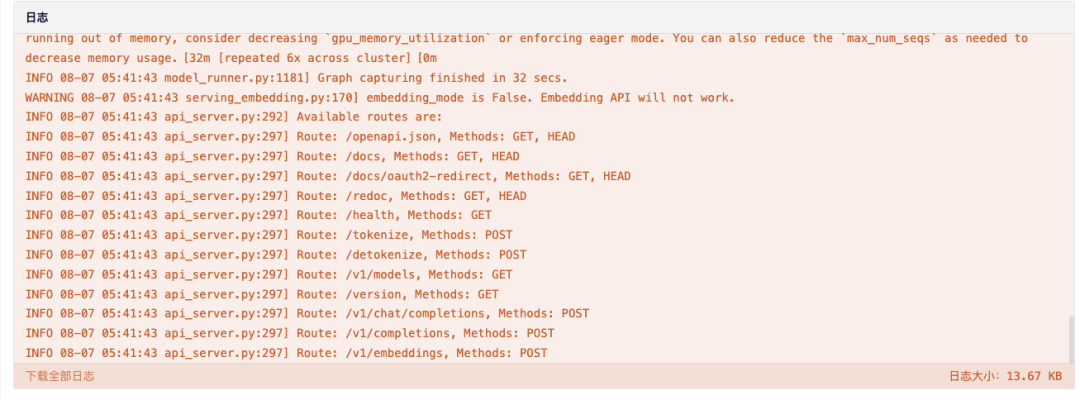

6. 将该界面拉至最底部,当日志显示以下路由信息时,说明服务已经启动成功,打开 API 地址。

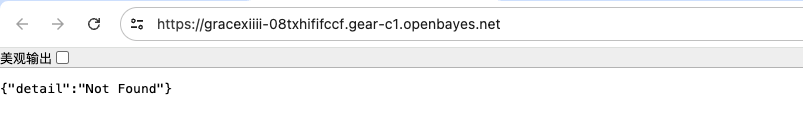

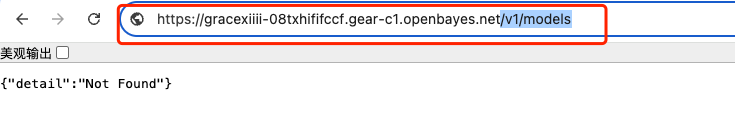

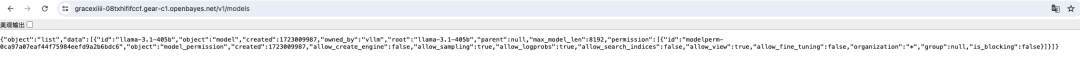

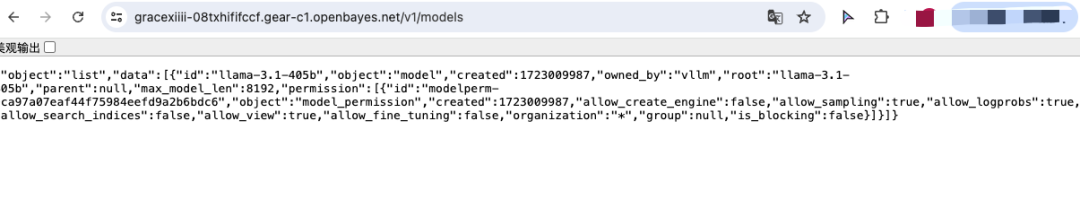

7. 打开后,会默认显示 404 的信息,在红框处添加额外的参数「/v1/models」即可显示当前模型的部署信息。

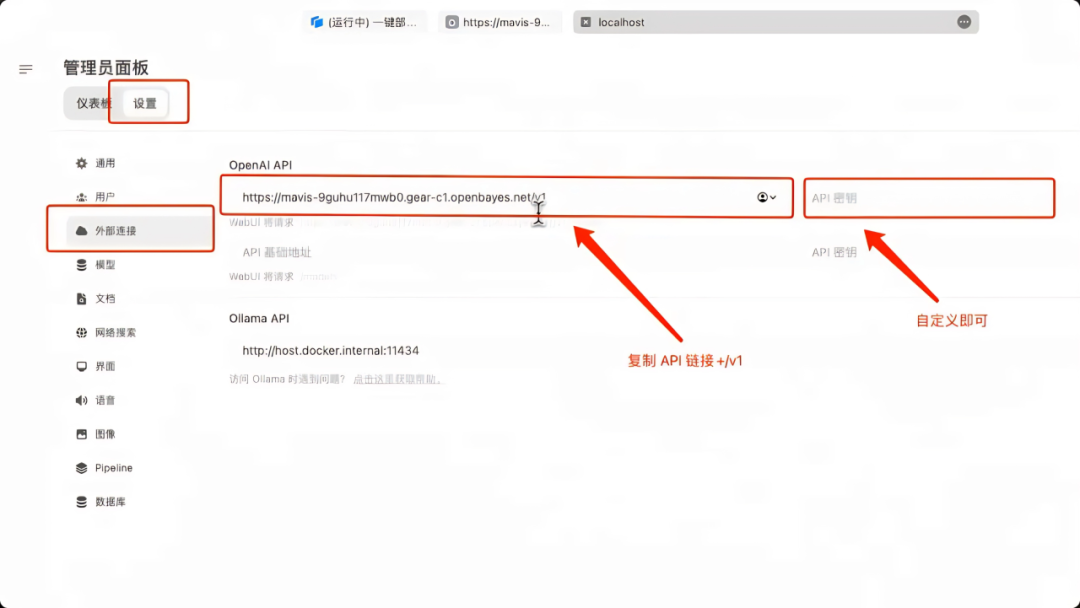

8. 在本地起一个 Open WebUI 的服务,在「外部连接」处起一个额外的连接,在「OpenAPI」处填写之前的 API 地址并 ➕「/v1」,这里没有设置任何「API 密钥」自定义输入即可。点击右下角保存。

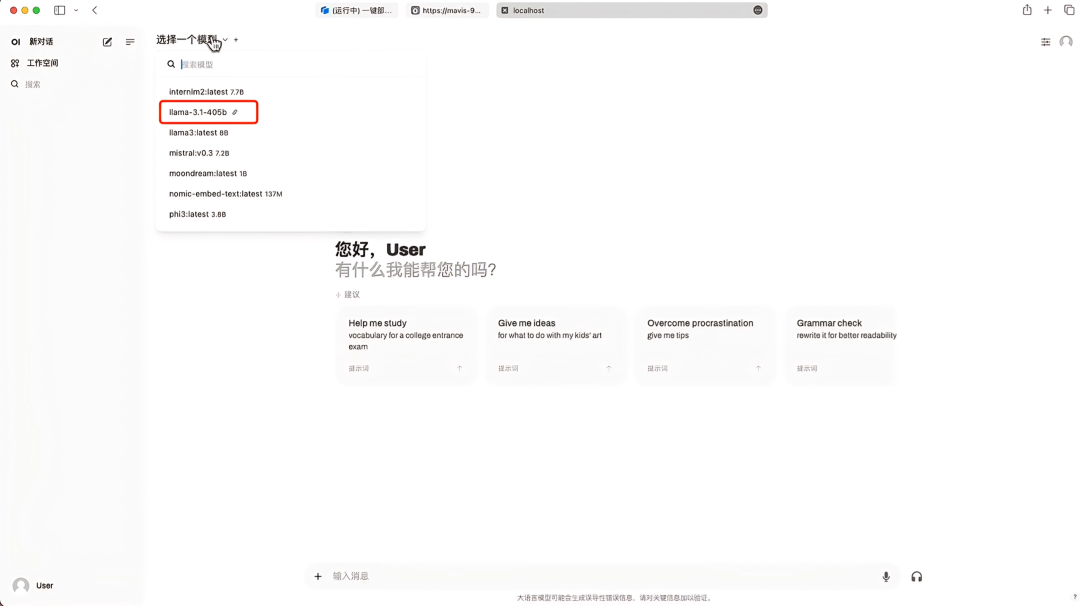

9. 保存后,在「选择模型」这里就可以看到出现了 Llama-3.1-405B,选择该模型后,即可开启对话啦!

最后推荐一个线上学术分享活动,感兴趣的小伙伴扫码即可参与!

往期推荐

戳“阅读原文”,免费获取海量数据集资源!

625

625

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?