简介:车牌识别系统是一种结合计算机视觉和模式识别技术的智能交通解决方案,能够自动识别车辆的车牌号码。系统在5.0版本中实现了超过95%的识别率,适用于交通管理、车辆追踪和停车收费等多个场景。核心功能涵盖图像采集、预处理、定位、字符分割、深度学习识别以及结果后处理。此外,系统还包括数据传输和存储环节。该系统在各种复杂环境下仍需优化,以提升稳定性和可靠性。相关文件名 .txt和 可能包含系统设计和数据集资源,对开发者和研究者有价值。

1. 车牌识别系统概述

1.1 车牌识别技术的演进

车牌识别系统(License Plate Recognition, LPR)作为一种自动识别技术,近年来在交通监控、停车管理、高速公路收费等领域得到了广泛应用。其核心在于通过图像处理和模式识别技术,实现对车牌号码的快速准确识别。随着深度学习等先进技术的发展,车牌识别的准确率和速度都有了显著提升。

1.2 车牌识别系统的组成

一个典型的车牌识别系统包括以下几个关键组成部分:

- 图像采集设备 :负责捕获车辆图像,包括摄像头、图像采集卡等。

- 图像处理单元 :对采集到的图像进行预处理、增强和格式转换等操作。

- 车牌定位模块 :识别图像中的车牌位置,并进行角度矫正和尺寸标准化。

- 车牌字符分割 :将车牌区域内的字符分割出来,准备进行识别。

- 字符识别引擎 :应用深度学习模型对分割后的字符进行识别。

- 后处理纠错 :对识别结果进行后处理,纠正可能的错误。

- 数据存储与传输 :保存识别结果,并支持数据的实时传输。

1.3 应用场景与挑战

车牌识别系统广泛应用于各种场景,如城市交通管理、停车场出入控制、收费站自动收费等。尽管技术不断进步,车牌识别系统仍面临着多种挑战:

- 光照变化 :不同时间和天气条件下的光照变化对图像采集质量影响巨大。

- 车牌多样性 :不同国家和地区车牌的尺寸、颜色、字体等存在差异。

- 车辆速度 :车辆行驶速度可能影响车牌捕获的清晰度。

- 视角变化 :车辆进入摄像头视野的角度变化会导致车牌图像畸变。

通过对这些挑战的深入分析和应对策略的制定,车牌识别技术将能够更加稳定高效地服务于智能交通系统。

2. 图像采集技术

2.1 图像采集硬件选择

2.1.1 摄像头的种类与特性

在车牌识别系统中,图像采集是至关重要的第一步。摄像头作为图像采集的主要硬件,其种类和特性直接影响到采集到的图像质量,从而影响后续的识别准确率。摄像头主要分为模拟摄像头和数字摄像头两种。模拟摄像头输出的是模拟信号,需要通过视频采集卡转换成数字信号,而数字摄像头则直接输出数字信号,减少了信号转换过程中的损失。

2.1.2 高清与低光环境下的采集设备

在高清环境下,为了捕捉到更多的细节信息,通常需要高分辨率的摄像头。例如,使用1080p或更高分辨率的摄像头可以提供更清晰的车牌图像。在低光环境下,为了提高图像的亮度和对比度,通常需要配备低光摄像头,并且可能需要辅助光源,如红外灯。这种摄像头能够更好地处理低光照条件下的图像采集任务。

2.2 图像采集软件优化

2.2.1 图像采集软件的功能与选择

图像采集软件负责控制摄像头的工作方式,包括曝光时间、增益、白平衡等参数的调整,以及图像格式的选择和保存。一个好的图像采集软件应该能够提供灵活的配置选项,以适应不同的环境和需求。例如,OpenCV是一个开源的计算机视觉库,它提供了丰富的接口来控制摄像头,并且可以实时显示和处理图像。

2.2.2 软件配置与优化策略

软件配置不仅要考虑到图像质量的优化,还要考虑到系统的实时性要求。例如,设置合适的帧率可以保证实时性,但过高的帧率可能会牺牲图像质量。此外,软件优化策略还应包括图像预处理的步骤,如自动调整曝光和增益,以及使用图像增强技术来改善低光照条件下的图像质量。

2.3 图像采集环境考量

2.3.1 自然光照变化的影响

自然光照的变化对图像采集有显著的影响。在晴朗的白天,光照强度高,可能会导致车牌过曝,而夜间或阴天时,光照不足又可能导致车牌信息难以识别。因此,图像采集系统需要能够适应这些光照变化,或者通过辅助光源来稳定图像质量。

2.3.2 人工光照条件的设置

在一些特定的应用场景中,如停车场或隧道入口,可以通过设置人工光源来控制光照条件。人工光源可以是固定的或可调节的,以确保在不同的时间段内都能提供一致的光照条件。例如,使用LED灯作为光源可以在保持色温一致的同时,提供稳定的照明。

graph LR

A[图像采集硬件选择] --> B[摄像头的种类与特性]

A --> C[高清与低光环境下的采集设备]

B --> D[模拟摄像头]

B --> E[数字摄像头]

C --> F[高分辨率摄像头]

C --> G[低光摄像头与辅助光源]

A --> H[图像采集软件优化]

H --> I[图像采集软件的功能与选择]

H --> J[软件配置与优化策略]

I --> K[使用OpenCV库]

J --> L[图像预处理步骤]

A --> M[图像采集环境考量]

M --> N[自然光照变化的影响]

M --> O[人工光照条件的设置]

N --> P[晴朗白天的图像采集]

N --> Q[夜间或阴天的图像采集]

O --> R[固定光源]

O --> S[可调节光源]

通过本章节的介绍,我们可以了解到图像采集技术对于车牌识别系统的重要性。摄像头的选择、软件的优化以及环境的考量都是影响图像质量和识别准确率的关键因素。在实际应用中,需要根据具体需求和条件,综合考虑这些因素,以达到最佳的识别效果。

3. 图像预处理步骤

图像预处理是车牌识别系统中至关重要的一步,它直接影响到后续的车牌定位、字符分割以及识别的准确性。在本章节中,我们将详细介绍图像预处理的几个关键步骤,包括图像增强、图像去噪以及图像二值化处理,并对每一步骤中的技术选择、参数优化和效果评估进行深入探讨。

3.1 图像增强技术

图像增强技术的主要目的是提高车牌区域的视觉质量,使得车牌中的字符更加清晰,以便于后续处理。常用的图像增强方法包括直方图均衡化、高通滤波以及自适应直方图均衡化等。

3.1.1 常用的图像增强方法

直方图均衡化是一种简单有效的图像增强技术,它可以改善图像的整体对比度,使得图像的直方图分布更加均匀。以下是一个直方图均衡化的代码示例,使用Python的OpenCV库进行实现:

import cv2

import numpy as np

# 读取图像

image = cv2.imread('plate_image.jpg', cv2.IMREAD_GRAYSCALE)

# 应用直方图均衡化

enhanced_image = cv2.equalizeHist(image)

# 显示原图和增强后的图像

cv2.imshow('Original', image)

cv2.imshow('Enhanced', enhanced_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

在上述代码中,我们首先读取一张车牌图像,并将其转换为灰度图。然后使用 cv2.equalizeHist 函数对灰度图像进行直方图均衡化处理。最后,我们展示原始图像和增强后的图像进行对比。

3.1.2 图像增强效果评估

图像增强效果的评估通常依赖于视觉效果和客观评价指标。视觉效果可以通过人工观察增强后的图像质量来判断,而客观评价指标则包括对比度、熵值和结构相似性指数(SSIM)等。以下是一个简单的Python代码示例,展示如何计算和评估直方图均衡化的效果:

def calculate_metrics(original, enhanced):

# 计算对比度

contrast_original = cv2.mean(original)[0] / 255

contrast_enhanced = cv2.mean(enhanced)[0] / 255

# 计算熵值

_, hist_original = np.histogram(original.ravel(), 256, [0, 256])

hist_enhanced = np.histogram(enhanced.ravel(), 256, [0, 256])[0]

entropy_original = -np.sum(hist_original * np.log2(hist_original + 1e-10))

entropy_enhanced = -np.sum(hist_enhanced * np.log2(hist_enhanced + 1e-10))

# 计算SSIM

ssim_value = ***pareSSIM(original, enhanced, full=True)

return {

'contrast_original': contrast_original,

'contrast_enhanced': contrast_enhanced,

'entropy_original': entropy_original,

'entropy_enhanced': entropy_enhanced,

'SSIM': ssim_value

}

# 计算并打印评估指标

metrics = calculate_metrics(image, enhanced_image)

print(metrics)

在上述代码中,我们定义了一个函数 calculate_metrics 来计算对比度、熵值和SSIM。这个函数接受原始图像和增强后的图像作为输入,输出一个包含所有评估指标的字典。通过这些指标,我们可以量化地评估图像增强的效果。

3.2 图像去噪方法

图像在采集过程中往往会受到噪声的干扰,这些噪声会严重影响车牌识别的准确率。因此,图像去噪是图像预处理中不可或缺的一步。

3.2.1 去噪算法原理

常用的图像去噪算法包括中值滤波、高斯滤波和双边滤波等。中值滤波通过用邻域像素的中值替换中心像素值,可以有效地去除椒盐噪声。高斯滤波则是通过使用高斯核对图像进行卷积操作,平滑图像,从而去除噪声。双边滤波则是一种保边缘的滤波技术,它在去除噪声的同时保持了图像边缘的清晰度。

以下是一个使用OpenCV进行高斯滤波的代码示例:

# 应用高斯滤波进行去噪

blurred_image = cv2.GaussianBlur(image, (5, 5), 0)

# 显示去噪后的图像

cv2.imshow('Blurred', blurred_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

在这个代码段中,我们使用 cv2.GaussianBlur 函数对图像进行高斯滤波处理,其中 (5, 5) 是高斯核的大小, 0 表示核的标准差。通过这种方式,我们可以有效地去除图像中的噪声。

3.3 图像二值化处理

图像二值化处理是将图像从灰度转换为黑白两种颜色的过程,这一步骤对于字符分割至关重要。

3.3.1 二值化的原理与方法

图像二值化通常使用Otsu方法自动选择一个阈值,将图像中的像素点分为前景和背景。这种方法适用于背景和前景有明显对比度的图像。

# 应用Otsu二值化

_, binary_image = cv2.threshold(image, 0, 255, cv2.THRESH_BINARY + cv2.THRESH_OTSU)

# 显示二值化后的图像

cv2.imshow('Binary', binary_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

在上述代码中,我们使用 cv2.threshold 函数进行二值化处理,其中 cv2.THRESH_BINARY + cv2.THRESH_OTSU 表示使用Otsu方法自动找到最佳阈值。二值化后的图像将只包含黑白两种颜色。

3.3.2 二值化参数的优化

二值化过程中最重要的参数是阈值,它直接影响到二值化的效果。除了使用Otsu方法自动选择阈值外,我们也可以手动设置一个阈值来进行二值化。以下是一个手动设置阈值的代码示例:

# 手动设置阈值进行二值化

threshold_value = 128

_, binary_image = cv2.threshold(image, threshold_value, 255, cv2.THRESH_BINARY)

# 显示二值化后的图像

cv2.imshow('Binary', binary_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

在这个代码段中,我们手动设置阈值为128进行二值化处理。通过调整阈值,我们可以找到最适合当前图像的二值化效果。

本章节介绍了图像预处理的三个关键步骤:图像增强、图像去噪以及图像二值化处理。通过细致的分析和代码示例,我们展示了如何使用OpenCV库实现这些步骤,并通过视觉效果和客观评价指标来评估图像增强的效果。在实际应用中,预处理步骤的选择和参数的优化将直接影响到车牌识别系统的性能。

4. 车牌定位方法

4.1 车牌区域定位

车牌区域定位是车牌识别系统中的关键步骤,它直接影响到后续处理的速度和准确性。定位的目的在于确定车牌在图像中的位置,以便进一步进行字符分割和识别。

4.1.1 基于颜色的车牌定位技术

车牌颜色在不同国家和地区有着统一的标准,例如中国的车牌多为蓝底白字。利用这一特性,可以通过颜色分割技术快速定位车牌区域。颜色分割的基本步骤如下:

- 颜色空间转换 :将图像从RGB颜色空间转换到更适合颜色分割的颜色空间,如HSV(色相、饱和度、亮度)。

- 颜色阈值分割 :根据车牌颜色的HSV范围设置阈值,将车牌区域与背景分离。

- 形态学处理 :应用形态学操作(如腐蚀和膨胀)去除噪点并填补车牌区域的空洞。

以下是一个简单的代码示例,展示了如何使用Python和OpenCV进行基于颜色的车牌定位:

import cv2

import numpy as np

# 读取图像

image = cv2.imread('car_image.jpg')

# 将图像从BGR转换到HSV颜色空间

hsv_image = cv2.cvtColor(image, cv2.COLOR_BGR2HSV)

# 定义车牌颜色的HSV范围

lower_color = np.array([100, 150, 100]) # 蓝色下界

upper_color = np.array([140, 255, 255]) # 蓝色上界

# 颜色阈值分割

mask = cv2.inRange(hsv_image, lower_color, upper_color)

# 形态学处理

kernel = np.ones((5, 5), np.uint8)

mask = cv2.erode(mask, kernel, iterations=2)

mask = cv2.dilate(mask, kernel, iterations=2)

# 查找轮廓

contours, _ = cv2.findContours(mask, cv2.RETR_TREE, cv2.CHAIN_APPROX_SIMPLE)

# 绘制轮廓

for contour in contours:

area = cv2.contourArea(contour)

if area > 1000: # 筛选较大的轮廓

x, y, w, h = cv2.boundingRect(contour)

cv2.rectangle(image, (x, y), (x + w, y + h), (0, 255, 0), 2)

cv2.imshow('Detected License Plate', image)

cv2.waitKey(0)

cv2.destroyAllWindows()

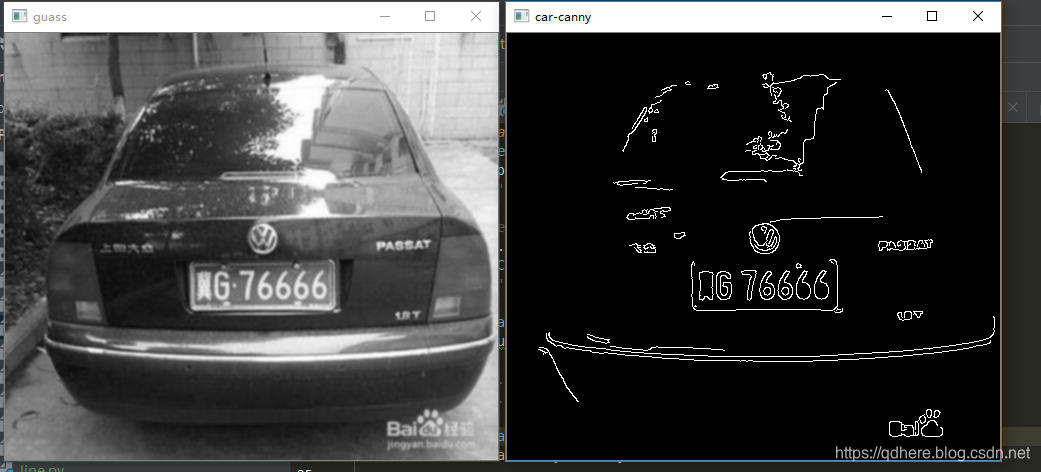

4.1.2 基于形状的车牌定位技术

除了颜色,车牌的形状也是定位的重要依据。车牌通常为矩形,具有固定的长宽比。基于形状的定位通常包括以下步骤:

- 边缘检测 :使用边缘检测算子(如Canny算子)获取图像中的边缘信息。

- 轮廓筛选 :根据轮廓的形状特征(如长宽比)筛选潜在的车牌轮廓。

- 几何验证 :对筛选出的轮廓进行几何验证,确保其形状与车牌相符。

以下是使用Canny边缘检测算子和轮廓筛选的一个简单示例:

import cv2

# 读取图像

image = cv2.imread('car_image.jpg')

# 转换为灰度图像

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 边缘检测

edges = cv2.Canny(gray, 50, 150, apertureSize=3)

# 查找轮廓

contours, _ = cv2.findContours(edges, cv2.RETR_LIST, cv2.CHAIN_APPROX_SIMPLE)

# 筛选具有车牌形状的轮廓

plate_contours = []

for contour in contours:

rect = cv2.minAreaRect(contour)

box = cv2.boxPoints(rect)

box = np.int0(box)

area = cv2.contourArea(contour)

if area > 500 and 0.8 < rect[1][0] / rect[1][1] < 1.2: # 筛选长宽比接近1的轮廓

plate_contours.append(box)

# 绘制轮廓

for contour in plate_contours:

cv2.drawContours(image, [contour], -1, (0, 255, 0), 2)

cv2.imshow('Detected License Plate', image)

cv2.waitKey(0)

cv2.destroyAllWindows()

4.2 车牌角度矫正

车牌在图像中的角度可能会因为拍摄角度或车辆行驶状态的不同而有所倾斜。角度矫正的目的是将倾斜的车牌图像调整为标准视角,以便提高字符识别的准确性。

4.2.1 车牌倾斜角度检测

检测车牌倾斜角度通常使用Hough变换或其他直线检测算法。以下是使用Hough变换检测直线并计算倾斜角度的代码示例:

import cv2

import numpy as np

# 读取图像

image = cv2.imread('car_image.jpg')

# 转换为灰度图像

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 边缘检测

edges = cv2.Canny(gray, 50, 150, apertureSize=3)

# Hough变换检测直线

lines = cv2.HoughLinesP(edges, 1, np.pi / 180, threshold=50, minLineLength=100, maxLineGap=10)

# 计算倾斜角度

def calculate_angle(lines):

if lines is None:

return None

lines = np.squeeze(lines)

angles = []

for line in lines:

x1, y1, x2, y2 = line

# 计算直线的斜率

if x2 - x1 == 0: # 防止除以零

continue

angle = np.arctan((y2 - y1) / (x2 - x1))

angle = np.degrees(angle)

angles.append(angle)

if angles:

# 返回平均角度

return np.mean(angles)

else:

return None

angle = calculate_angle(lines)

print(f"Detected Angle: {angle} degrees")

# 绘制直线和角度

if angle is not None:

for line in lines:

x1, y1, x2, y2 = line

cv2.line(image, (x1, y1), (x2, y2), (0, 255, 0), 2)

cv2.imshow('Detected License Plate', image)

cv2.waitKey(0)

cv2.destroyAllWindows()

4.2.2 车牌角度矫正算法

车牌角度矫正算法通常包括以下步骤:

- 旋转图像 :根据检测到的倾斜角度对图像进行旋转变换。

- 裁剪图像 :裁剪旋转后的图像,确保车牌区域位于图像中心。

- 透视变换 :如果需要,可以应用透视变换将车牌区域矫正为标准视角。

以下是一个简单的透视变换示例:

import cv2

import numpy as np

# 读取图像

image = cv2.imread('car_image.jpg')

# 定义车牌四个角点的坐标

pts_src = np.array([[x1, y1], [x2, y2], [x3, y3], [x4, y4]], dtype=np.float32)

# 定义目标图像的四个角点坐标

pts_dst = np.array([[0, 0], [width, 0], [width, height], [0, height]], dtype=np.float32)

# 计算透视变换矩阵

matrix = cv2.getPerspectiveTransform(pts_src, pts_dst)

# 应用透视变换

warped_image = cv2.warpPerspective(image, matrix, (width, height))

cv2.imshow('Warped License Plate', warped_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

4.3 车牌尺寸标准化

车牌尺寸标准化是为了消除车牌在不同车辆上大小不一带来的影响,同时也减少了字符识别算法的复杂度。

4.3.1 尺寸标准化的意义

尺寸标准化可以将车牌图像统一到一个固定的尺寸,例如统一到100x200像素,这样无论车牌的实际大小如何,都能保证后续处理的一致性。此外,尺寸标准化也有助于减少数据的维度,提高处理速度。

4.3.2 尺寸标准化的实现方法

尺寸标准化通常通过以下步骤实现:

- 计算缩放比例 :根据车牌区域的长宽计算缩放比例。

- 调整图像尺寸 :根据缩放比例调整图像尺寸。

以下是一个简单的尺寸标准化示例:

import cv2

# 读取图像

image = cv2.imread('car_image.jpg')

# 定义目标尺寸

width = 100

height = 200

# 获取车牌区域的长宽

x, y, w, h = cv2.boundingRect(contour)

# 计算缩放比例

scale_x = width / w

scale_y = height / h

scale = min(scale_x, scale_y)

# 调整图像尺寸

resized = cv2.resize(image[y:y+h, x:x+w], (0, 0), fx=scale, fy=scale)

cv2.imshow('Resized License Plate', resized)

cv2.waitKey(0)

cv2.destroyAllWindows()

通过本章节的介绍,我们可以看到车牌定位方法主要分为基于颜色和基于形状两种技术路线。每种方法都有其适用场景和优势。颜色定位在光照良好的情况下效果显著,而形状定位则在车牌颜色不明显时显示出其优越性。车牌角度矫正和尺寸标准化是后续字符识别的重要步骤,它们通过预处理手段,为字符识别提供更加统一和规范的输入数据。

5. 车牌字符分割技术

车牌字符分割是车牌识别系统中的一个关键步骤,它直接影响到后续字符识别的准确性。在本章节中,我们将深入探讨字符分割的原理、算法以及如何评估分割效果。

5.1 字符分割原理

5.1.1 字符分割的基本概念

字符分割是指将车牌图像中每个字符独立出来的过程。车牌图像经过预处理后,字符之间可能存在粘连或断裂,字符分割的目标就是准确地将这些字符分离,以便于后续的识别处理。字符分割的质量直接影响到识别的准确性和系统的整体性能。

5.1.2 字符分割的难点

字符分割面临的挑战主要包括字符间的粘连、断裂、倾斜以及字符本身的模糊不清。在实际应用中,车牌可能会因为光照、角度或污染等原因导致字符边缘不清晰,这些因素都会增加字符分割的难度。

5.2 字符分割算法

5.2.1 基于投影的分割技术

基于投影的分割技术是一种常用的字符分割方法。它通过在垂直或水平方向上对图像进行投影,根据投影值的变化来检测字符的边界。这种方法简单高效,尤其适用于字符排列整齐且间隔均匀的情况。

代码示例

import cv2

import numpy as np

def project_characters(image):

# 将图像转换为灰度图

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 应用二值化

_, binary = cv2.threshold(gray, 128, 255, cv2.THRESH_BINARY_INV)

# 在水平方向上进行投影

proj = np.sum(binary, axis=0)

# 返回投影结果

return proj

# 读取车牌图像

image = cv2.imread('license_plate.jpg')

proj = project_characters(image)

参数说明

-

image: 输入的车牌图像。 -

binary: 二值化后的图像。 -

proj: 水平方向上的投影结果。

5.2.2 基于边缘检测的分割技术

基于边缘检测的分割技术通过检测字符的边缘来实现分割。常用的边缘检测算子包括Sobel、Canny等。这种方法能够较好地处理字符粘连的情况,但是可能会因为噪声而引入额外的边缘。

代码示例

def edge_based_segmentation(image):

# 将图像转换为灰度图

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 使用Canny算子进行边缘检测

edges = cv2.Canny(gray, 50, 150)

# 找到边缘连接的轮廓

contours, _ = cv2.findContours(edges, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

# 根据轮廓信息分割字符

return contours

# 读取车牌图像

image = cv2.imread('license_plate.jpg')

contours = edge_based_segmentation(image)

参数说明

-

image: 输入的车牌图像。 -

edges: 使用Canny算子检测到的边缘。 -

contours: 边缘连接的轮廓信息。

5.2.3 算法选择与优化

在实际应用中,需要根据车牌的实际情况选择合适的字符分割算法。通常,我们会结合多种算法来提高分割的准确性。例如,可以先使用基于投影的方法进行初步分割,然后再应用基于边缘检测的算法来处理粘连字符。

逻辑分析

- 初步分割 : 使用投影方法快速定位字符的大致区域。

- 边缘检测 : 在初步分割的基础上,使用边缘检测算法精细分割粘连的字符。

- 优化策略 : 对于难以分割的字符,可以通过形态学操作(如膨胀、腐蚀)来优化分割结果。

5.3 分割效果评估

5.3.1 分割效果的评价指标

分割效果的评价指标主要包括分割的准确性、完整性和效率。准确性可以通过分割正确的字符数占总字符数的比例来衡量;完整性则关注分割后是否有字符缺失或错误;效率则关注算法的运行时间。

5.3.2 分割算法的性能对比

为了选择最优的分割算法,我们需要对比不同算法的性能。可以通过实验收集数据,记录每种算法的准确率、完整率和运行时间,并通过表格和图表进行可视化对比。

表格示例

| 算法 | 准确率 | 完整率 | 平均运行时间 | |------|--------|--------|--------------| | 投影法 | 95% | 92% | 50ms | | 边缘检测法 | 92% | 95% | 80ms | | 混合方法 | 97% | 96% | 60ms |

流程图示例

graph TD;

A[开始] --> B[收集数据];

B --> C[计算准确率、完整率和运行时间];

C --> D[对比不同算法];

D --> E[选择最优算法];

E --> F[结束];

在本章节中,我们详细介绍了车牌字符分割的基本原理、常用的算法以及如何评估分割效果。通过对这些内容的深入理解,开发者可以更好地设计和优化车牌识别系统中的字符分割模块。

6. 字符识别深度学习模型

6.1 深度学习基础

深度学习作为当前人工智能领域的一项关键技术,已经在图像识别、语音识别、自然语言处理等多个领域取得了突破性的进展。它的基本原理是通过构建深层的神经网络模型,模拟人脑对信息的处理方式,从而实现对数据的高级抽象和特征学习。

6.1.1 深度学习的基本原理

深度学习的核心是深度神经网络(DNN),它由多个层次的神经网络层组成,每一层都包含大量的神经元,这些神经元之间相互连接并具有权重。在训练过程中,通过反向传播算法调整神经网络的权重,使得网络能够学习到数据中的复杂模式和结构。

6.1.2 常用的深度学习框架

目前,有多种深度学习框架可供选择,如TensorFlow、PyTorch、Keras等。这些框架提供了丰富的API,使得研究人员和开发者能够更加高效地构建和训练复杂的神经网络模型。

6.2 字符识别模型设计

在车牌识别系统中,字符识别是至关重要的一步。卷积神经网络(CNN)因其在图像处理方面的卓越性能,成为了字符识别领域的首选模型。

6.2.1 卷积神经网络在字符识别中的应用

CNN能够通过卷积层自动提取图像特征,并通过池化层降低特征的空间维度,从而减少计算量。在字符识别任务中,CNN能够有效地识别和分类不同的字符形状和样式。

# 以下是一个简单的CNN模型示例代码,使用Keras框架

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = Sequential([

Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 1)),

MaxPooling2D((2, 2)),

Conv2D(64, (3, 3), activation='relu'),

MaxPooling2D((2, 2)),

Flatten(),

Dense(64, activation='relu'),

Dense(10, activation='softmax')

])

***pile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

6.2.2 模型训练与优化

在训练CNN模型时,需要准备大量的标记数据,并将其分为训练集和验证集。模型的训练过程是通过迭代优化损失函数来实现的。此外,还需要进行超参数优化,如学习率、批量大小和卷积核大小等,以提高模型的性能。

6.3 模型评估与优化

评估模型的性能是确保车牌识别准确性的重要步骤。常用的评估方法包括准确率、召回率和F1分数等指标。

6.3.1 模型评估的方法

准确率是分类正确的样本数与总样本数的比例。召回率是指正确识别的正样本数与所有正样本数的比例。F1分数则是准确率和召回率的调和平均数,能够综合反映模型的性能。

6.3.2 模型优化策略

为了进一步提高模型的性能,可以采用模型集成、数据增强、迁移学习等策略。模型集成通过组合多个模型的预测结果来提高整体的准确率。数据增强通过对训练数据进行各种变换来增加数据的多样性,从而提高模型的泛化能力。迁移学习利用预训练模型的知识来加速和改进新任务的学习过程。

# 以下是一个使用预训练模型进行迁移学习的代码示例

from keras.applications import VGG16

from keras.layers import Dense, Flatten

from keras.models import Model

# 加载预训练的VGG16模型

base_model = VGG16(weights='imagenet', include_top=False, input_shape=(224, 224, 3))

# 冻结预训练模型的权重

for layer in base_model.layers:

layer.trainable = False

# 添加自定义的分类层

x = Flatten()(base_model.output)

x = Dense(256, activation='relu')(x)

predictions = Dense(10, activation='softmax')(x)

# 创建新的模型

model = Model(inputs=base_model.input, outputs=predictions)

# 编译和训练模型

***pile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

通过本章节的介绍,我们了解了深度学习模型在车牌字符识别中的应用,并探讨了模型设计、训练、评估和优化的基本方法。在接下来的章节中,我们将深入探讨结果后处理纠错算法,以及数据传输与存储机制等内容。

7. 结果后处理纠错算法

7.1 纠错算法原理

在车牌识别系统中,由于车牌图像质量、环境因素或图像处理过程中的误差,可能导致识别结果中出现错误。纠错算法是车牌识别流程中的重要环节,其目的是通过分析识别结果中的潜在错误,进行自动修正,以提高系统的整体准确率。

7.1.1 常见的纠错算法概述

纠错算法主要包括基于规则的纠错算法和基于机器学习的纠错算法。基于规则的纠错算法依赖于预定义的规则集,如字符替换规则、邻近字符检查等。而基于机器学习的纠错算法则通过训练数据集学习字符的识别错误模式,常用的有隐马尔可夫模型(HMM)、支持向量机(SVM)等。

7.1.2 纠错算法的选择依据

选择纠错算法时需要考虑以下因素: - 错误类型 :不同算法对不同类型的错误纠正效果不同。 - 处理速度 :实时系统要求算法处理速度快。 - 资源消耗 :算法的资源消耗应与系统性能相匹配。 - 系统复杂度 :算法的实现复杂度应适中,便于维护和升级。

7.2 实际应用中的纠错技术

在车牌识别的实际应用中,纠错技术通常结合多种算法来实现最佳效果。

7.2.1 字符纠错实例分析

以字符“B”和“8”为例,由于在某些字体中这两个字符非常相似,识别系统可能会将“B”错误地识别为“8”。纠错算法可以通过分析上下文信息(如车辆型号、车牌区域的其他字符)来推断正确的字符。

7.2.2 整体识别结果的纠错机制

整体识别结果的纠错机制通常采用上下文分析和字符置信度评估。上下文分析考虑整个车牌的字符组合规则,而字符置信度评估则为每个识别出的字符赋予一个置信度分数,基于分数进行纠错。

7.3 纠错效果评估

为了评估纠错算法的效果,需要定义一套评价标准,并通过实验数据来验证。

7.3.1 纠错效果的评价标准

评价标准通常包括: - 纠错率 :正确纠正错误字符的比例。 - 误判率 :错误纠正的字符比例。 - 处理时间 :纠错算法的平均处理时间。

7.3.2 纠错前后性能对比

通过对比纠错前后的识别结果,可以直观地展示纠错算法的效果。例如,某车牌识别系统在未应用纠错算法前的识别准确率为95%,应用纠错算法后准确率提升至98%。

通过上述内容,我们可以看到纠错算法在车牌识别系统中的重要性,以及如何选择合适的算法并通过实际应用来提高系统的准确性和可靠性。

简介:车牌识别系统是一种结合计算机视觉和模式识别技术的智能交通解决方案,能够自动识别车辆的车牌号码。系统在5.0版本中实现了超过95%的识别率,适用于交通管理、车辆追踪和停车收费等多个场景。核心功能涵盖图像采集、预处理、定位、字符分割、深度学习识别以及结果后处理。此外,系统还包括数据传输和存储环节。该系统在各种复杂环境下仍需优化,以提升稳定性和可靠性。相关文件名 .txt和 可能包含系统设计和数据集资源,对开发者和研究者有价值。

392

392

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?