简介:编码是将字符转换为计算机可识别的二进制形式的过程,是计算机处理文本的基础。本文深入探讨了包括ASCII、Windows系列编码、GB2312、GBK、BIG5在内的多种编码系统,并分析了它们的应用领域和重要性。了解这些编码表对于开发者来说至关重要,有助于正确处理文本数据,并避免数据交换时出现乱码问题。此外,文章也介绍了Unicode标准,它解决了不同编码间的兼容性问题,是全球软件和互联网的标准。

1. 编码基础知识介绍

1.1 编码的定义与重要性

编码是信息在计算机系统中表达和处理的基础,它允许人们使用各种字符集来代表文本、数字和其他数据。对于软件开发和信息技术的专业人士来说,理解编码原理是至关重要的。编码不仅涉及到字符如何存储和传输,还关系到数据的交换与兼容性,这对于维护系统间的信息互通和用户体验有着直接影响。

1.2 编码的工作原理简述

在计算机内部,所有的数据都以二进制形式存储。编码规则定义了这些二进制序列如何与字符、符号或指令相对应。例如,一个文本编辑器需要知道每一个字符在内存中是如何被存储的,这样才能正确地显示和编辑文本。因此,正确的编码使用和转换能够确保数据的准确性和程序的可移植性。

1.3 编码在开发中的应用

在软件开发中,选择合适的编码格式对于应用的国际化和本地化处理至关重要。例如,网页开发者需要确保网页能够正确地显示多种语言,这就需要使用到能够兼容多种语言编码的字符集。此外,开发者还需使用相应的编程接口和库来处理各种编码转换,确保数据在不同系统和应用之间正确无误地共享。

2. ASCII编码标准及其扩展

2.1 ASCII编码的历史与原理

2.1.1 ASCII编码的发展背景

ASCII(American Standard Code for Information Interchange,美国信息交换标准代码)是一个七位的字符编码标准,广泛应用于计算机系统,它是由美国国家标准化组织(ANSI)在1963年制定的。ASCII码最初的设计目的是为了在美国的计算机系统中提供一个统一的字符编码标准,使得计算机能够处理英文文本,从而促进了计算机之间以及不同制造商之间设备的信息交换。

ASCII编码的产生是计算机技术发展的必然结果。在计算机早期发展阶段,不同的计算机制造商使用各自不同的字符编码系统,这导致了数据交换的困难。ASCII的出现,提供了一个标准化的解决方案,极大地促进了信息处理和通信技术的融合与发展。

ASCII编码最初定义了128个字符,其中包含了大小写英文字母、数字、标点符号以及控制字符。由于ASCII仅使用了7位二进制数(0-127),因此可以表示128种不同的字符。

2.1.2 ASCII编码的结构和使用

ASCII编码的结构是基于字符集的设计,每个字符对应一个唯一的数字编码。由于它使用7位二进制数表示字符,因此可以分为两个部分:可打印字符和控制字符。

- 可打印字符 :这部分字符包括了英文字母(大写和小写)、数字0-9和一些标点符号、特殊符号。这些字符通常在日常的文本处理和打印中使用。

- 控制字符 :这部分字符包括了从0到31的编码,它们用于控制设备的行为,如换行(LF,编码为10)、回车(CR,编码为13)等。这些控制字符不直接对应可打印的字符。

在使用ASCII编码时,最常见的是通过键盘输入字符,然后通过操作系统和应用程序将这些字符转换为相应的ASCII码,再进行存储和传输。同时,ASCII码的标准化使得不同系统之间交换文本数据成为可能。

ASCII编码的使用非常广泛,它不仅在早期计算机系统中扮演着重要角色,而且在现代计算机系统中,ASCII码仍然作为基础字符集被广泛使用。例如,网页上的英文内容大多使用ASCII编码存储和传输。

flowchart LR

A[开始输入] -->|文本输入| B[ASCII编码转换]

B --> C[存储或传输]

C --> D[接收设备解码]

D -->|显示或使用| E[完成通信]

2.2 Windows系列编码的变迁

2.2.1 Windows 1251编码

Windows 1251编码是微软为Windows操作系统设计的扩展ASCII编码之一,用于西里尔字母的计算机编码。由于西里尔字母在俄语、乌克兰语以及其他斯拉夫语族中的使用,Windows 1251编码的诞生满足了Windows系统在多语言环境下的需求。

该编码包含了128个ASCII字符,覆盖了标准ASCII编码的所有内容,同时扩展了另外128个字符,以适应西里尔字母表以及其他特殊字符的需求。Windows 1251编码通常用于东欧国家以及俄罗斯等地区的计算机系统。

2.2.2 Windows 1252编码

Windows 1252编码是Windows操作系统中用于拉丁语系字符的另一种扩展ASCII编码。它扩展了标准ASCII编码,增加了西欧语言中常用的特殊字符,如重音符号、货币符号等。

Windows 1252编码解决了在西欧语言中,某些ASCII码位置上的字符无法使用的问题。例如,标准ASCII编码中,0x80到0x9F之间的字符是未定义的,Windows 1252则为这些位置定义了新的字符。这使得Windows 1252成为了一个更为全面和实用的编码方式,特别是在处理包含多种特殊字符的西欧文本时。

2.2.3 Windows 1253至Windows 1258编码简述

微软公司为支持其他语言开发了一系列的编码标准,统称为Windows-125x系列编码。这些编码包括了从Windows 1253(用于希腊语)到Windows 1258(用于越南语)的多种编码。每个编码针对不同语言的字符集进行了相应的扩展,以满足不同地区的语言书写需要。

Windows-125x系列编码的推出,体现了微软在操作系统本地化方面的努力。通过这些编码的使用,Windows操作系统能够更好地服务于全球不同语言的用户,同时也推动了全球计算机文化的交流与融合。

| 编码 | 描述 | | --- | --- | | Windows 1251 | 西里尔字母扩展 | | Windows 1252 | 西欧语言扩展 | | Windows 1253 | 希腊语扩展 | | ... | ... | | Windows 1258 | 越南语扩展 |

在实践中,了解和使用Windows-125x系列编码需要结合具体的语言环境。这通常涉及到在软件中正确设置字符编码,确保文本的正确读写。随着Unicode的广泛使用,Windows-125x编码的使用有所减少,但在特定的应用领域和历史数据中,这些编码依然有着重要的地位。

3. 中文编码标准深度解析

3.1 GB2312国标简体中文编码

3.1.1 GB2312编码的构成和设计思想

GB2312编码,全称为《信息交换用汉字编码字符集 基本集》,是中国国家标准简体中文字符集,发布于1980年。它包括了6763个汉字和682个其他符号。GB2312的设计基于字符频率和使用场合,分为两级,一级汉字覆盖常用汉字和部分地名用字,二级汉字则包括了一些专业术语中的生僻字。GB2312使用了两个字节表示一个汉字,其中第一个字节为高位字节(0xA1-0xF7),第二个字节为低位字节(0xA1-0xFE),且高位字节的范围决定了该汉字属于哪一级。

3.1.2 GB2312编码的应用和限制

GB2312在发布后迅速成为中国计算机系统中文信息交换的标准,对简化中文信息处理流程起了重要作用。然而,随着计算机技术和中文信息处理需求的发展,GB2312的局限性也逐渐显现。比如,它无法表示所有的汉字,对少数民族文字支持不足,以及对于日益增长的新词汇、专有名词等缺乏足够的编码空间。

// GB2312编码示例代码

// 以"中国"为例,其GB2312编码为0xD6D0 0xB9FA

unsigned char chinese[] = { 0xD6, 0xD0, 0xB9, 0xFA };

printf("GB2312编码的'中国'为: %02X %02X %02X %02X\n", chinese[0], chinese[1], chinese[2], chinese[3]);

// 输出: GB2312编码的'中国'为: D6 D0 B9 FA

在实际应用中,处理GB2312编码的文本时,需要考虑编码转换,尤其是在和现代Unicode编码相互转换时,需要使用专门的库函数或API来进行精确的转换。

3.2 GBK中文编码的升级与优势

3.2.1 GBK编码的特点和编码范围

GBK编码,即《汉字内码扩展规范》,是对GB2312的扩展。GBK旨在解决GB2312汉字不足的问题,并支持更多的汉字和符号。GBK编码能够表示21000多个汉字以及一些其他字符,几乎覆盖了所有印刷和阅读中使用的汉字。GBK同样采用两个字节来表示一个字符,但相比于GB2312,其编码范围更为宽泛。

// GBK编码示例代码

// 以"扩展"为例,其GBK编码为0xCED2 0xCFC5

unsigned char extended[] = { 0xCE, 0xD2, 0xCF, 0xC5 };

printf("GBK编码的'扩展'为: %02X %02X %02X %02X\n", extended[0], extended[1], extended[2], extended[3]);

// 输出: GBK编码的'扩展'为: CE D2 CF C5

GBK编码能够与GB2312兼容,意味着任何能正确显示GB2312的系统在升级后也能正确显示GBK编码的汉字,这样的设计使得GBK在技术上具有很好的延续性。

3.2.2 GBK与GB2312的兼容性分析

GBK和GB2312的兼容性主要表现在它们的编码空间设计上。GBK保留了GB2312的编码区域,并在其基础上向高位扩展。这意味着所有的GB2312编码在GBK中同样有效,而GBK增加了额外的编码空间以支持更多的字符。在实际使用中,一个能够识别GBK编码的程序自然也能够识别GB2312编码,但反过来则不成立。

3.3 BIG5繁体中文编码的区域应用

3.3.1 BIG5编码的结构和历史

BIG5编码,是台湾地区广泛使用的繁体中文字符集标准。BIG5收录了13060个汉字,基本覆盖繁体中文的使用。BIG5编码的结构和历史与GB2312类似,也是由两个字节来表示一个字符,范围为0x8140至0xF9FE。由于两岸信息交流的特殊性,BIG5的使用导致了一定程度上的文字交流障碍。

// BIG5编码示例代码

// 以"繁体"为例,其BIG5编码为0xA5C1 0xB7A4

unsigned char traditional[] = { 0xA5, 0xC1, 0xB7, 0xA4 };

printf("BIG5编码的'繁体'为: %02X %02X %02X %02X\n", traditional[0], traditional[1], traditional[2], traditional[3]);

// 输出: BIG5编码的'繁体'为: A5 C1 B7 A4

BIG5编码虽然支持繁体汉字,但因为没有统一的两岸标准编码,导致了繁简体转换以及信息交换的复杂性。

3.3.2 BIG5编码在两岸的应用差异

由于历史原因,两岸在信息处理上采用了不同的编码标准。台湾地区广泛使用BIG5编码,而中国大陆则主要采用GB系列编码。这种差异给两岸的信息交流带来了不便,特别是在互联网发展早期,两岸之间的电子文档交换需要进行复杂的编码转换。随着Unicode标准的普及和两岸之间的信息技术合作,这些问题正在逐步得到解决。Unicode作为一种国际标准,有效地支持了两岸繁简体中文的兼容与转换,大大简化了编码处理流程。

graph LR

A[简体中文文本] --> |编码转换| B(GBK)

B --> |信息交换| C(BIG5编码)

C --> |编码转换| D[繁体中文文本]

style B fill:#f9f,stroke:#333,stroke-width:2px

style C fill:#ccf,stroke:#333,stroke-width:2px

通过上述流程图可以看出,在两岸间的信息交流过程中,编码转换是关键步骤之一。适当的编码转换工具和技术能够确保信息的准确性和完整性。随着技术的不断进步,两岸之间的信息交流正变得越来越便捷。

在下一章节中,我们将深入探讨Unicode与UTF-8编码的全球化视角,以及它们如何在Web和数据存储中发挥着重要作用。

4. Unicode与UTF-8编码的全球化视角

4.1 Unicode标准的发展与原理

4.1.1 Unicode编码的起源和目标

Unicode的起源可以追溯到1988年,当时由美国的一群计算机制造商和软件公司联合成立了Unicode Consortium,目的是为了创建一套统一的字符编码方案。在此之前,世界上存在着成百上千种不同的字符编码系统,这给计算机系统间的文本交换带来了极大的困难。Unicode的目标是为每个字符提供一个唯一的编码,不管它出现在哪里。

Unicode在设计上坚持了三个原则:通用性、一致性、简单性和可访问性。它试图容纳世界上所有的字符集,无论这些字符是古代的还是现代的,无论是用于科学、技术还是文学领域。Unicode的目标还包括了与现存编码系统的兼容性,以及最小化对现有软件和硬件资源的影响。

4.1.2 Unicode编码的实现和转换

Unicode最初采用的是16位固定长度的编码方式(称为UTF-16),这使得它能够编码65536个不同的字符。随着字符集的不断扩展,Unicode Consortium引入了代理对(surrogate pairs)的概念,从而能够表示更多的字符,比如一些历史文字和表情符号。

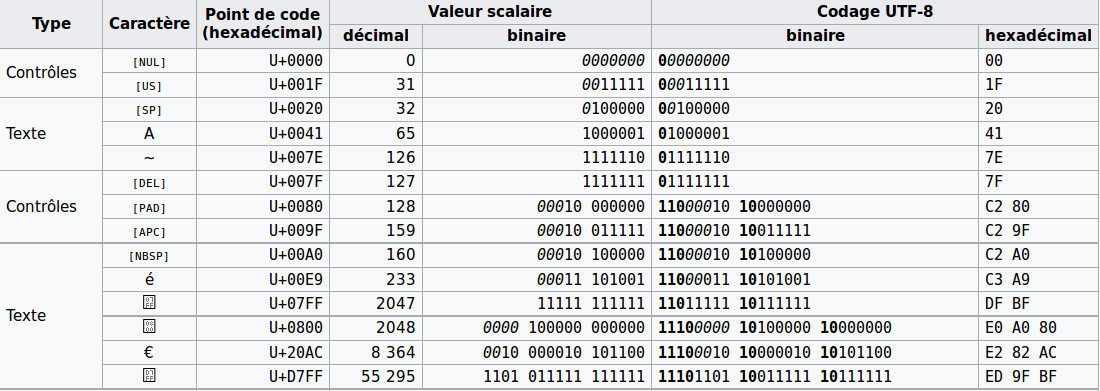

随着互联网的普及,出现了UTF-8编码格式,它是Unicode的一个变种,采用可变长度(1到4个字节)编码方式,实现了对ASCII编码的完全兼容,同时又具备了表达Unicode所有字符的能力。UTF-8编码格式由于其对ASCII的向后兼容性,以及对非英文字符的优秀支持,迅速成为网络传输和存储文本的首选编码。

4.1.3 Unicode与ASCII的兼容性

Unicode与ASCII编码兼容,这是因为Unicode在设计之初就考虑到了与ASCII的无缝对接。在UTF-8编码中,ASCII字符集中的128个字符编码与原始ASCII编码完全相同。这意味着,ASCII编码的文本可以在不改变其编码的情况下直接被当作UTF-8处理,这大大简化了从传统编码向Unicode过渡的过程。

4.2 UTF-8编码的特性与优势

4.2.1 UTF-8编码的兼容性与效率

UTF-8编码格式是Unicode的一种实现方式,它具有良好的兼容性,尤其是在处理大量使用ASCII字符的文本时。UTF-8的特点是在表示英文字母时仅使用一个字节,这样就与ASCII编码保持了100%的兼容,而且对后续字节的处理使得它能够表示世界上几乎所有的字符。

在效率上,UTF-8也表现出色。由于其设计原理,它能够将字符编码所需的字节数量降到最低,尤其是对于使用ASCII字符较多的文本,UTF-8的存储效率接近原生的ASCII编码。对于包含更多非ASCII字符的文本,UTF-8能够平滑过渡到使用更多的字节,而不会出现传统多字节编码常见的对齐问题。

4.2.2 UTF-8在Web和数据存储中的应用

在Web应用中,UTF-8已经成为标准的编码方式。大多数现代浏览器和服务器都默认使用UTF-8编码,这极大地提高了网站的国际化和多语言支持能力。由于UTF-8在存储和传输方面的优势,它也成为了数据库系统和文件存储中的首选编码格式。

在数据存储方面,UTF-8编码还解决了传统编码方案在不同操作系统间交换文件时经常遇到的乱码问题。例如,一个在Windows系统下使用GB2312编码的文本文件,在Linux系统下打开时可能会出现乱码,而使用UTF-8则几乎不会发生这类问题。由于这些特性,UTF-8成为了处理多语言数据的通用编码标准。

4.3 Unicode和UTF-8在编程中的应用示例

4.3.1 Python中处理Unicode和UTF-8的代码示例

在现代编程语言中,如Python,对Unicode和UTF-8的支持已经成为了内建功能。以下是一个简单的Python代码示例,展示了如何在Python中处理字符串的Unicode编码:

# Python 3中的Unicode字符串示例

text = "你好,世界!" # Unicode字符串

print(text) # 输出: 你好,世界!

print(text.encode('utf-8')) # 将Unicode字符串编码为UTF-8字节序列

输出结果:

你好,世界!

b'\xe4\xbd\xa0\xe5\xa5\xbd\xef\xbc\x8c\xe4\xb8\x96\xe7\x95\x8c\xef\xbc\x81'

# 将UTF-8编码的字节序列解码为Unicode字符串

bytes_sequence = text.encode('utf-8')

decoded_text = bytes_sequence.decode('utf-8')

print(decoded_text) # 输出: 你好,世界!

4.3.2 Python代码逻辑解读与参数说明

在上面的代码示例中,我们展示了如何在Python中创建Unicode字符串,以及如何进行编码和解码操作。在Python中,字符串默认是Unicode的,所以我们可以直接赋值并打印,而不需要特别的编码声明。

-

text.encode('utf-8'):这行代码将Unicode字符串text编码成UTF-8格式的字节序列。encode方法是Python字符串的方法,'utf-8'是传递给它的编码参数。 -

bytes_sequence.decode('utf-8'):这行代码将之前编码得到的UTF-8格式的字节序列bytes_sequence解码回原始的Unicode字符串。decode方法也是Python字符串的方法,'utf-8'是传递给它的解码参数。

通过这个简单的例子,我们可以看到在Python中处理Unicode和UTF-8是相当直接和便捷的。Python的这种特性极大地简化了多语言文本的处理,尤其是在进行国际化和本地化开发时。

4.3.3 探讨Unicode在不同编程语言中的实现差异

虽然Python提供了非常直观的Unicode和UTF-8处理方式,但在其他编程语言中,实现可能略有不同。例如,在Java中,所有的字符串都是Unicode编码的,而字节类型的数据则需要显式声明编码方式。以下是Java中处理Unicode和UTF-8的代码示例:

import java.nio.charset.StandardCharsets;

public class UnicodeExample {

public static void main(String[] args) {

String text = "你好,世界!"; // Java中的字符串默认是Unicode的

byte[] bytes = text.getBytes(StandardCharsets.UTF_8); // 将字符串编码为UTF-8字节序列

String decodedText = new String(bytes, StandardCharsets.UTF_8); // 将UTF-8字节序列解码为字符串

System.out.println(decodedText); // 输出: 你好,世界!

}

}

在上述Java代码中,我们使用了 getBytes 方法和 StandardCharsets.UTF_8 参数来获取UTF-8编码的字节序列。 new String(bytes, StandardCharsets.UTF_8) 构造函数则用于从UTF-8字节序列创建字符串。

通过比较Python和Java的代码示例,我们可以看到虽然实现细节略有不同,但核心的Unicode和UTF-8处理逻辑是相似的。编程语言提供了一套工具和API来处理Unicode和UTF-8编码,确保开发者能够方便地进行文本的编码和解码操作。

4.3.4 Unicode和UTF-8编码的实际应用场景与挑战

Unicode和UTF-8编码的广泛应用带来了诸多便利,尤其是在处理国际化文本时。它们的应用场景包括但不限于:

- Web开发 :Unicode和UTF-8已经成为网络标准,支持多语言网站开发。

- 数据库存储 :数据库管理系统使用Unicode和UTF-8来存储多种语言的文本数据。

- 操作系统 :现代操作系统支持Unicode和UTF-8,确保不同语言的正确显示和处理。

- 文件系统 :Unicode和UTF-8编码允许文件系统存储和检索非英文文本文件。

然而,在实践中也存在一些挑战,比如:

- 老旧系统的兼容性问题 :某些早期系统可能不支持Unicode和UTF-8,需要通过特定的库或工具进行转换。

- 字体支持问题 :尽管Unicode能表示几乎所有字符,但并非所有系统都安装了支持所有Unicode字符的字体。

- 多语言搜索与排序问题 :在多语言文本处理时,需要考虑文本的搜索和排序规则,这些规则会因语言不同而有很大差异。

通过这些应用场景和挑战的讨论,我们可以看到Unicode和UTF-8编码为处理多语言文本提供了强大的支持,但在实际应用中仍然需要考虑和解决各种技术问题。

5. 多语言应用中的编码转换与兼容问题

5.1 编码转换的重要性与方法

5.1.1 跨语言编码转换的必要性

随着全球化的加速,软件和互联网服务需要支持多种语言环境,这使得编码转换变得不可或缺。不同地区、不同设备以及不同操作系统可能使用不同的编码标准,这造成了数据交换时的兼容性问题。对于任何希望建立全球影响力的软件产品来说,能够正确处理编码转换是基本要求。

例如,在某些场景中,一个应用程序可能需要从一个使用GBK编码的数据库读取数据,然后将这些数据在使用UTF-8编码的Web界面中展示。如果编码转换处理不当,用户就可能看到乱码或者收到错误信息,从而影响用户体验。

5.1.2 编码转换工具和技术

为了实现有效的编码转换,IT行业发展出了多种工具和技术。其中一些工具是独立的软件库,例如iconv,它提供了强大的命令行工具,用于转换不同编码之间的数据。同时,编程语言通常也会提供内置的方法或者库来处理编码转换,例如Python中的 encode 和 decode 方法。

此外,现代浏览器和服务器都支持自动的内容协商和字符编码转换,这样可以在Web应用中更便捷地处理多语言编码问题。不过,自动协商并不总是能够完美解决所有问题,了解基本的编码转换原理依然是非常必要的。

示例代码展示:

以下是一个使用Python进行编码转换的简单示例:

# 示例: Python中使用 encode 和 decode 方法进行编码转换

text_in_gbk = '中文数据'

text_in_utf8 = text_in_gbk.encode('gbk') # 将GBK编码的字符串转换为字节串(UTF-8)

text_back_in_gbk = text_in_utf8.decode('utf-8') # 将UTF-8字节串转换回GBK编码的字符串

print(f"原始GBK编码字符串: {text_in_gbk}")

print(f"GBK编码转换为UTF-8编码字节串: {text_in_utf8}")

print(f"UTF-8编码字节串转换回GBK编码: {text_back_in_gbk}")

执行逻辑说明:首先,我们创建一个GBK编码的字符串,然后使用 encode 方法将其转换为UTF-8编码的字节串。最后,使用 decode 方法将UTF-8编码的字节串转换回GBK编码的字符串。这样完成了从GBK到UTF-8以及从UTF-8回GBK的双向转换。

参数说明:在 encode 和 decode 方法中,第一个参数指定了目标编码格式。对于 encode 方法,默认源编码格式是系统当前的编码,而对于 decode 方法,默认目标编码格式是系统当前的编码。

5.2 多语言应用中的国际化处理

5.2.1 国际化的编码问题与解决方案

国际化(Internationalization)通常简称i18n,它包含所有使得软件产品可以适应多种语言和区域设置的技术和过程。其中,编码问题尤其需要关注,因为正确的编码转换能够确保字符在不同语言环境下正确显示。

解决编码问题的第一步通常是确定应用的默认编码,这通常是UTF-8,因为它支持几乎所有的字符集。接下来,确保应用正确处理输入、输出以及存储中的编码转换。为了达到这一目标,开发者应该:

- 明确各个组件支持的编码格式。

- 对所有外部输入进行编码检测和转换。

- 在内部处理和存储时使用统一的编码格式。

- 在展示给用户之前将数据转换为用户的界面编码。

5.2.2 本地化与编码的关系

本地化(Localization)通常简称l10n,是指对软件产品进行调整,使其适应特定语言和文化的特定市场。尽管编码转换是本地化过程中的一部分,但本地化涵盖了更广泛的范围,比如货币格式、日期和时间格式、文本方向等。

在本地化处理中,编码转换尤其重要,因为必须确保在不同的本地化版本中,字符能够正确显示。例如,在阿拉伯语和希伯来语中,文本是从右向左书写的,这就要求软件不仅要支持相应的字符编码,还要正确处理文本方向。

为了系统地进行编码转换和本地化,开发者通常需要依赖专门的国际化和本地化(i18n和l10n)框架,这些框架提供了自动化的工具和库来处理这些复杂的问题。这样做不仅提高了软件产品的国际化程度,也大大简化了开发和维护的工作量。

表格:常见语言编码与应用范围

| 编码标准 | 应用范围 | |----------|----------------------| | UTF-8 | 网页、数据库、操作系统 | | GBK | 简体中文操作系统、数据库 | | GB2312 | 简体中文文本文件 | | BIG5 | 繁体中文操作系统、数据库 | | ISO-8859 | 西欧语言处理 |

流程图:编码转换流程

graph LR

A[开始] --> B[确定源编码]

B --> C{是否支持源编码}

C -- 是 --> D[将源编码转换为UTF-8]

C -- 否 --> E[错误处理]

D --> F[处理或显示文本]

E --> G[结束]

F --> G

通过上述流程图,我们可以看到一个典型的编码转换流程,这有助于理解在多语言应用中进行编码转换时,各阶段需要进行的操作。

6. 编码技术的未来趋势与挑战

编码技术是信息系统的基础,随着技术的不断进步和全球化的深入发展,编码技术正面临着前所未有的挑战与机遇。新的技术需求和应用场景不断涌现,推动编码技术持续进化。

6.1 新兴编码标准的挑战与机遇

6.1.1 新兴编码标准的概览

随着互联网技术的快速发展,数据量呈爆炸性增长,这对编码标准提出了新的挑战。为了更高效地存储和传输数据,新兴编码标准如Base64url、Punycode等相继出现。其中,Base64url解决了URL中加号和斜杠的编码问题,而Punycode则使Unicode文本能在DNS系统中使用。

此外,表情符号编码(如emoji)的广泛使用,也让Unicode编码体系不断扩展。Unicode版本的更新,不断将新的符号纳入标准,这既是对编码体系的挑战也是对技术发展的一种机遇。

6.1.2 对现有编码体系的影响和挑战

新兴编码标准对现有体系产生了深远的影响。例如,Web技术的快速发展需要编码标准不仅能高效传输文本,还需要能良好支持多媒体内容。这就要求编码标准不仅要有足够的扩展性,还要有高效的数据处理能力。

对于开发者而言,这意味着他们需要不断更新自己的知识库,学习新的编码方法,以便应对各种编程场景。同时,操作系统和编程语言也需要不断进行更新,以支持新的编码标准。

6.2 编码技术的发展趋势与展望

6.2.1 编码技术的发展方向

编码技术的发展方向主要集中在解决现有编码标准的局限性,同时扩展支持更多语言和符号。一种趋势是朝向更高效的编码算法发展,以减少数据传输和存储的需求。例如,压缩技术的结合使用可以显著减小数据大小,提高效率。

此外,随着人工智能技术的发展,自适应编码算法开始受到关注。这些算法可以根据上下文环境,动态选择最合适的编码方式,从而优化数据的传输效率和存储空间的利用。

6.2.2 编码技术的未来影响

未来编码技术将更加注重国际化和个性化的需求,为适应不同文化背景的用户提供更丰富的表达方式。随着物联网的普及,编码技术也可能涉及更多非文本信息的编码,如状态监测、传感器数据等。

随着量子计算的发展,传统的编码技术将面临被颠覆的可能。量子编码理论的研究将为编码技术带来新的突破,未来的编码技术有可能在量子通信、量子存储等新兴领域发挥关键作用。

总之,编码技术的发展将呈现出多方向性、高效率和强适应性等特点。从业者需要密切关注这一领域的新动态,以便在编码技术的变革中抓住新的机遇。

简介:编码是将字符转换为计算机可识别的二进制形式的过程,是计算机处理文本的基础。本文深入探讨了包括ASCII、Windows系列编码、GB2312、GBK、BIG5在内的多种编码系统,并分析了它们的应用领域和重要性。了解这些编码表对于开发者来说至关重要,有助于正确处理文本数据,并避免数据交换时出现乱码问题。此外,文章也介绍了Unicode标准,它解决了不同编码间的兼容性问题,是全球软件和互联网的标准。

1442

1442

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?