简介:城市轮廓算法是一种用于描绘地图对象,特别是城市区域边界的技术,广泛应用于数据分析、城市规划和地理信息可视化。该算法通过构建多边形边界来反映城市的地理形状,涉及到数据结构的选择、点聚类、边界检测和多边形构造等多个环节。文章详细探讨了城市轮廓算法的实现原理及其应用,包括数据预处理、聚类、边界检测、多边形构造和拓扑校验等步骤,并提供输出和可视化方法。

1. 城市轮廓算法基础概念

城市轮廓算法作为地理信息系统(GIS)空间分析技术的分支,在城市发展、规划和管理过程中发挥着关键作用。城市轮廓不仅仅是地表上的一个几何形状,它还蕴含了丰富的地理信息和社会经济数据,例如人口分布、土地利用类型、交通流量等。

本章将从城市轮廓算法的基本概念开始讲起,逐步深入至其发展历史及在不同领域的应用背景。我们首先定义什么是城市轮廓,继而探讨其算法原理以及在现实世界中解决问题的能力。通过这一章节的学习,读者将获得城市轮廓算法的全面了解,为后续章节中算法实现和技术应用的深入探讨打下坚实的理论基础。

2. 数据结构在地理信息系统中的应用

地理信息系统(GIS)是一个收集、存储、分析和展示地理数据的综合系统,它依赖于高效的数据结构来处理复杂的地理空间数据。在GIS中,数据结构的选择直接影响到数据的存储效率和查询响应时间,对算法的性能有着决定性的作用。本章旨在探讨GIS中应用的数据结构,以及它们在城市轮廓算法中的应用和优化。

2.1 GIS中的空间数据结构

2.1.1 常见空间数据结构概述

在GIS中,空间数据结构是存储和管理空间信息的基础。常见的空间数据结构包括栅格数据结构和矢量数据结构。栅格数据由像素阵列组成,适合表示连续空间数据,比如卫星遥感图像。而矢量数据结构由点、线、面元素构成,更适合表达离散的空间实体,如地图中的道路、行政区边界等。

在城市轮廓算法中,矢量数据结构因其能够精确表示形状边界而更受青睐。如四叉树和R树等层次数据结构,它们通过空间划分来管理空间数据,既能够加快查询速度,也便于执行高效的更新和插入操作。

2.1.2 空间数据结构的选择与优化

选择合适的空间数据结构对于GIS系统而言至关重要。例如,四叉树适用于二维空间的递归划分,能够高效地进行空间查询和管理。而R树则是专门为多维空间设计的,能够处理更高维度的数据,适用于复杂的查询需求。

优化空间数据结构通常涉及到算法效率的提升和存储空间的节约。在某些情况下,结合多种数据结构和索引技术能够实现更优的性能,如使用R*树来优化R树,减少树的深度和提高查询速度。

2.2 数据结构在空间查询中的应用

2.2.1 空间索引技术

空间索引是提高GIS空间查询效率的关键技术。常见的空间索引技术包括格网索引、四叉树索引、R树索引等。它们通过为数据创建索引结构,来加速对数据的检索过程。

格网索引适用于大规模的空间数据集,它将空间区域划分为规则的网格,通过格网标识快速定位空间对象。四叉树索引则适用于二维空间数据,它通过递归划分空间,构建一棵多级树结构。

R树及其变种是目前GIS中广泛使用的空间索引技术,特别是处理多维空间数据的场合。R树的每个节点都包含一组最小边界矩形(MBR),通过MBR的重叠情况来减少查询中的数据访问量。

2.2.2 查询优化策略

查询优化策略的目的是减少查询的响应时间,并提高查询效率。这通常需要结合具体的查询需求和数据特性来制定。例如,在查询城市轮廓数据时,可以针对特定的查询类型设计索引,如点查询、范围查询和最近邻查询等。

在实际应用中,查询优化还可能涉及到索引数据的预加载、查询语句的优化、查询结果的缓存机制等。这些优化手段可以显著提升查询性能,尤其是对于处理大规模空间数据集的GIS系统。

2.3 数据结构在空间分析中的应用

2.3.1 空间关系的计算方法

空间关系的计算是GIS空间分析的核心部分,它包括计算空间对象的位置关系、方向关系、距离关系等。例如,点与多边形的包含关系判断、线与线的交叉判断等。

这些计算通常基于空间索引技术来实现,通过索引快速定位到相关空间对象,然后进行几何和拓扑的计算。空间关系计算方法的有效性直接影响到城市轮廓提取的准确性和效率。

2.3.2 空间分析的操作类型

空间分析包括一系列操作,如缓冲区分析、叠加分析、网络分析等。这些操作在数据结构的支撑下,可以有效地实现城市轮廓的提取和分析。

例如,叠加分析操作可以通过将不同图层的空间数据进行合并和分析,来辅助识别城市中的不同区域和功能分区。缓冲区分析则可以用来确定特定地理要素的邻近区域,为城市规划提供决策支持。

在城市轮廓算法中,空间分析的准确性和效率至关重要,合理的数据结构选择和优化,能够显著提高分析结果的准确度和响应速度。

本章内容提供了对GIS中数据结构应用的全面解析,并通过具体应用案例,展示了这些数据结构在空间查询和空间分析中的重要作用。接下来的章节将重点解析数据预处理方法,这是确保城市轮廓算法能够准确运行的基础步骤。

3. 数据预处理方法

3.1 数据清洗与质量控制

数据异常值和噪声的处理

数据清洗的第一步是识别和处理数据中的异常值和噪声。在城市轮廓算法中,异常值和噪声会干扰轮廓的准确提取,因此需要通过特定的统计方法或算法来定位并修正或删除这些值。常见的方法有标准差阈值法,箱形图分析以及基于距离的异常点检测等。

例如,标准差阈值法是通过计算数据集的平均值和标准差,然后排除那些远离平均值超过三倍标准差的数据点。这种方法在假设数据分布接近正态分布时效果较好。需要注意的是,实际地理信息系统中的数据往往不服从标准分布,因此可能需要结合其他方法,如箱形图分析,以获得更可靠的异常值检测。

数据完整性检查与修复

数据完整性检查的目标是识别数据集中的缺失值和不一致的数据。在地理信息系统中,这些缺失值可能是由于传感器故障、通信问题或数据录入错误导致的。处理缺失数据的策略通常包括删除含有缺失数据的记录、使用均值、中位数或众数等统计方法填充缺失值,或者利用预测模型进行填充。

数据一致性检查则确保数据集中的信息是逻辑上一致的。例如,在城市规划数据集中,建筑物的边界坐标不应该超出城市的总用地范围。当发现数据不一致时,需要采取措施修正或与数据提供方沟通确认,以保证数据的准确性和可靠性。

3.2 数据归一化与格式统一

数据类型的转换

在地理信息系统中,数据类型可能包括栅格数据、矢量数据以及其他类型的传感器数据。数据类型转换的目的是使不同来源和格式的数据能够互相兼容,以便进行进一步的处理和分析。栅格数据通常通过像素值表示信息,而矢量数据则通过点、线、面的几何结构来表达。在某些情况下,需要将矢量数据转换为栅格数据以进行特定类型的分析,反之亦然。

例如,可以使用GDAL/OGR库来实现不同数据格式之间的转换。GDAL支持大多数的栅格和矢量数据格式,并提供了一系列的命令行工具和API接口,方便用户进行数据格式转换和处理。代码示例如下:

# GDAL命令行工具转换矢量格式

gdal_translate -of GTiff input.shp output.tiff

在上述命令中, -of 参数指定了输出格式, input.shp 是输入的矢量文件, output.tiff 是转换后的栅格文件。

数据格式标准化

数据格式的标准化是预处理步骤中的重要一环。标准的数据格式能够确保不同系统和应用之间能够顺利交换数据,同时便于存储、检索和分析。常用的地理信息系统标准化格式包括GeoJSON、KML、Shapefile等。

GeoJSON是一种轻量级的数据交换格式,它可以很容易地被编程语言解析和生成,适用于Web应用程序。KML是基于XML的文件格式,主要用于地理信息的标记和可视化。Shapefile是ESRI公司开发的一种流行的矢量数据格式,广泛应用于GIS软件中。

代码逻辑分析与参数说明

使用 GDAL/OGR 库进行数据格式转换是一个通用的做法,因为 GDAL/OGR 支持大多数的空间数据格式。 gdal_translate 是 GDAL 中一个非常基础的工具,可以用来将数据从一种格式转换到另一种格式。在上述示例代码中, -of GTiff 指定了输出格式为 GeoTIFF 格式,该格式广泛应用于栅格数据的存储和交换。

在处理地理数据时,通常需要将数据转换为统一的格式以便进行分析。例如,一些分析可能需要将矢量数据转换为栅格数据,或者将不同来源的数据统一格式进行对比和整合。在实际操作中,根据数据处理需求选择合适的转换工具和参数是很重要的。

3.3 数据融合与空间参考

多源数据融合技术

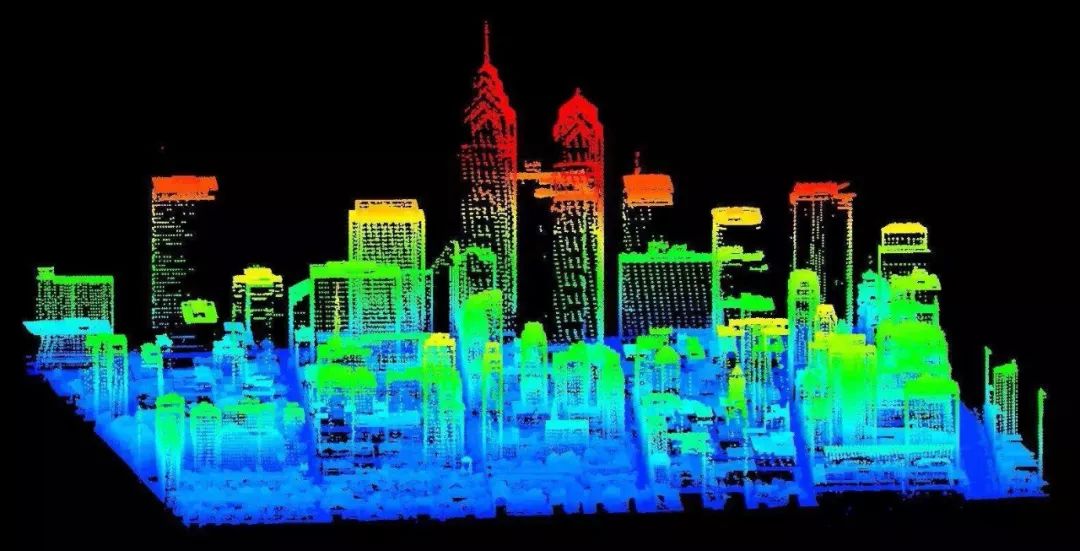

多源数据融合技术是在城市轮廓提取中不可或缺的步骤。城市轮廓的精确提取常常需要结合来自不同传感器和数据源的信息,如卫星影像、地面激光扫描数据(LiDAR)、GIS地图数据等。数据融合技术可以将这些不同来源、不同精度和不同分辨率的数据整合到一个统一的参考框架中。

数据融合的方法有多种,包括像素级融合、特征级融合和决策级融合。像素级融合通常用于栅格数据,它直接在像素值上操作;特征级融合侧重于融合矢量数据的几何特征;决策级融合则是在更高层次上对不同来源的数据进行分析和决策。

空间参考系统的建立与转换

在进行多源数据融合之前,需要建立一个统一的空间参考系统(SRS),确保不同数据源在同一个坐标框架下。空间参考系统包括地理坐标系统(如WGS84)和投影坐标系统(如UTM),它们定义了数据的空间定位方式。数据融合前的空间参考转换是通过坐标转换实现的,可以使用诸如PROJ库来执行精确的坐标转换。

下面的示例代码展示了如何使用PROJ库将WGS84坐标系中的点转换为UTM坐标系:

import proj

# 初始化WGS84坐标系统

wgs84 = proj.Proj(init='epsg:4326')

# 初始化UTM坐标系统(假设区域位于UTM区域32N)

utm = proj.Proj(init='epsg:32632')

# 坐标转换

x, y = proj.transform(wgs84, utm, lon, lat)

# 输出转换后的坐标

print(f"转换后的坐标为: x={x}, y={y}")

代码逻辑分析与参数说明

在上述Python代码中,首先导入了 proj 库,这是Python环境下的投影库,可以实现坐标转换。接着定义了两个坐标系对象, wgs84 和 utm 。 wgs84 对象通过EPSG代码 epsg:4326 来指定WGS84坐标系,而 utm 对象则通过EPSG代码 epsg:32632 来指定北半球的UTM区域32N。

代码中使用了 proj.transform 方法来执行坐标转换。这个方法接受三个参数:源坐标系对象、目标坐标系对象以及要转换的点的经纬度坐标。转换完成后,我们将得到的坐标打印出来。

在实际应用中,多源数据融合常常涉及更为复杂的数据处理流程,包括数据的配准、融合算法的选择、融合结果的质量评估等。这就要求数据处理人员不仅需要熟悉相关的数据转换工具,还需要根据实际的业务需求来选择合适的转换策略。

表格展示

下表展示了几种常用的坐标系统及它们的EPSG代码:

| 坐标系统类型 | EPSG代码 | 描述 | | --- | --- | --- | | WGS84 | epsg:4326 | 世界地理坐标系统,广泛用于全球定位 | | UTM区域32N | epsg:32632 | 北半球的通用横轴墨卡托投影区域32 | | Web Mercator | epsg:3857 | 互联网地图服务中常用的投影系统 | | 国家坐标系统 | epsg:23700 | 中国的国家坐标系统 |

通过这样的表格,我们可以清晰地对比和理解不同的坐标系统以及它们适用的场景。在执行多源数据融合之前,选择正确的坐标系统是至关重要的,这将直接影响到最终城市轮廓提取的准确性。

mermaid格式流程图展示

在多源数据融合的过程中,一个典型的流程图如下:

graph LR

A[开始数据融合] --> B[数据配准]

B --> C[选择融合策略]

C --> D[执行数据融合]

D --> E[质量评估]

E --> F{是否满足要求?}

F -- 是 --> G[输出融合后的数据]

F -- 否 --> H[调整融合参数]

H --> C

以上流程图展示了一个标准的多源数据融合过程。首先需要进行数据的配准,确保所有数据在同一参考框架下。接着根据数据的特点选择合适的融合策略,如像素级融合、特征级融合或决策级融合。然后执行数据融合,融合完成后进行质量评估,评估结果需要满足特定的精度要求。如果结果不满足要求,则需要回到融合策略的选择步骤进行调整,直到得到满意的结果。

4. 城市轮廓提取关键技术

4.1 点聚类方法

城市轮廓提取的第一步通常是对离散的地理数据点进行聚类,以识别出代表城市轮廓的区域。点聚类方法是这一过程中不可或缺的技术,其中DBSCAN(Density-Based Spatial Clustering of Applications with Noise)是应用最为广泛的一种算法。

4.1.1 DBSCAN聚类算法详解

DBSCAN算法是一种基于密度的空间聚类算法,它将具有足够高密度的区域划分为簇,而将低密度区域视为噪声。该算法的优势在于它不需要预先设定簇的数量,可以发现任意形状的簇,并且能够有效地处理噪声点。

DBSCAN算法的核心概念包括核心对象、边界对象和噪声点。核心对象是被足够多的其他点所包围的对象,边界对象是那些位于核心对象邻近区域内但密度不足以成为核心对象的点,噪声点是既不是核心对象也不是边界对象的点。

算法的关键参数有:ε(eps),邻域半径;MinPts,形成核心对象所需的最小点数。这些参数的选择对算法的效果有着直接影响。ε决定了聚类的紧密程度,MinPts影响了算法对噪声的容忍度。

以下是一个DBSCAN算法的基本实现,假设我们有一个地理数据点集合:

from sklearn.cluster import DBSCAN

import numpy as np

# 示例数据,实际数据应为地理坐标点

X = np.array([

[1.0, 2.0], [2.0, 2.0], [2.5, 2.0],

[6.0, 1.0], [5.0, 1.0], [3.0, 1.5]

])

# 初始化DBSCAN模型,设置邻域半径和最小点数

db = DBSCAN(eps=1, min_samples=2).fit(X)

labels = db.labels_

# 输出聚类结果

print(labels)

在代码执行后,每个点会被分配一个标签值,其中-1通常用于表示噪声点。DBSCAN聚类结果中,具有相同标签值的点被认为是属于同一个簇。

4.1.2 其他聚类算法与DBSCAN的比较

除了DBSCAN之外,还有多种其他聚类方法可供选择,如K-means、层次聚类等。每种算法都有其适用场景和优缺点。K-means算法对于凸形状的簇效果较好,但对于任意形状的簇则不如DBSCAN有效。层次聚类则提供了层次化的簇结构,便于分析,但其计算复杂度较高。

| 聚类算法 | 适用场景 | 优点 | 缺点 | |----------|----------|------|------| | DBSCAN | 任意形状的簇,处理噪声 | 不需要指定簇的数量,能发现任意形状的簇 | 对参数的选择敏感,数据维度较高时性能下降 | | K-means | 凸形状的簇 | 算法简单,易于实现和理解 | 需要预先指定簇的数量,不擅长处理噪声和任意形状的簇 | | 层次聚类 | 生成簇的层次结构 | 提供详细的簇层次信息 | 计算代价大,不适合大规模数据集 |

4.2 边界检测技术

边界检测技术在城市轮廓提取过程中负责识别区域的边缘,从而形成连续的轮廓线。边界检测的常用方法包括基于梯度的方法和基于深度学习的边界检测技术。

4.2.1 基于梯度的方法

基于梯度的边界检测技术,如Sobel算子和Canny边缘检测算法,利用图像中像素强度变化的梯度信息来检测边缘。梯度算子通过局部差分来计算图像的梯度幅值,从而确定边缘的位置。

例如,Sobel算子是一种常用的边缘检测算子,它通过两个卷积核在水平和垂直方向上分别卷积图像,来分别提取水平方向和垂直方向的梯度信息。边缘点是这两个方向梯度幅值的局部最大值。

Sobel算子的一个简化版本可以用以下代码表示:

import numpy as np

import matplotlib.pyplot as plt

from scipy.signal import convolve2d

def sobel_edge_detection(image):

# Sobel算子核

Gx = np.array([[-1, 0, 1], [-2, 0, 2], [-1, 0, 1]])

Gy = np.array([[1, 2, 1], [0, 0, 0], [-1, -2, -1]])

# 对图像进行卷积计算梯度

Ix = convolve2d(image, Gx, mode='same')

Iy = convolve2d(image, Gy, mode='same')

# 计算梯度幅值

edge_gradient = np.hypot(Ix, Iy)

edge_gradient = edge_gradient / edge_gradient.max() * 255

return edge_gradient

# 加载图像并转换为灰度

image = plt.imread('city_image.png')

gray_image = np.dot(image[...,:3], [0.299, 0.587, 0.114])

# 应用Sobel边缘检测

edges = sobel_edge_detection(gray_image)

# 显示结果

plt.imshow(edges, cmap='gray')

plt.show()

通过这种方式,我们可以获得图像中的边缘信息,进而辅助城市轮廓的提取。梯度方法简单易实现,但对噪声敏感,可能需要预处理步骤来减少噪声干扰。

4.2.2 基于深度学习的边界检测技术

随着深度学习技术的发展,基于深度学习的边界检测技术逐渐成为主流。通过构建卷积神经网络(CNN),模型可以自动学习数据的特征表示,从而实现更为精确的边界检测。

一个经典的深度学习边界检测模型是U-Net,它是一种专门为图像分割任务设计的全卷积网络,通过使用跳跃连接将编码器和解码器的特征图进行融合,保留了丰富的上下文信息,有利于准确地检测边缘。

实现U-Net模型需要使用深度学习框架,如TensorFlow或PyTorch。以下是一个简化的U-Net架构示例:

import tensorflow as tf

from tensorflow.keras.layers import Input, Conv2D, MaxPooling2D, Conv2DTranspose, concatenate

def unet_model(input_shape):

inputs = Input(input_shape)

# 编码器(下采样)

c1 = Conv2D(64, (3, 3), activation='relu', kernel_initializer='he_normal', padding='same')(inputs)

p1 = MaxPooling2D((2, 2))(c1)

c2 = Conv2D(128, (3, 3), activation='relu', kernel_initializer='he_normal', padding='same')(p1)

p2 = MaxPooling2D((2, 2))(c2)

...

# 解码器(上采样)

up1 = Conv2DTranspose(128, (2, 2), strides=(2, 2), padding='same')(c5)

merge1 = concatenate([c4, up1], axis=3)

...

# 输出层

outputs = Conv2D(1, (1, 1), activation='sigmoid')(up6)

model = tf.keras.Model(inputs=[inputs], outputs=[outputs])

return model

# 创建U-Net模型

unet = unet_model(input_shape=(256, 256, 3))

unet.summary()

通过训练这样的网络模型,可以实现对城市轮廓边缘的精准识别。深度学习方法通常需要大量的标注数据进行训练,并且训练成本较高,但能够获得更好的结果。

4.3 多边形构造算法

将边界检测到的边缘转换为闭合的多边形是城市轮廓提取的最后一步。多边形构造算法包括扫描线算法、Ear Clipping算法等。

4.3.1 扫描线算法原理与实现

扫描线算法是一种常用的多边形构造算法,它从上到下扫描图像,记录边缘点的位置,并在适当的位置闭合多边形。该算法的关键在于找到边缘点的顺序,并确定何时闭合多边形。

一个简化的扫描线算法实现可以是:

def scanline_polygon_construction(edges):

# 初始化扫描线和多边形顶点列表

scanline = []

polygon = []

for y in range(edges.height):

# 检测当前扫描线与边缘的交点

for x, edge in enumerate(edges):

# 如果交点处于扫描线水平范围内

if edge.left <= y <= edge.right:

scanline.append((x, y))

# 对扫描线上的点进行排序

scanline.sort(key=lambda point: point[1])

# 构造多边形顶点

polygon.append(scanline.pop(0))

while scanline:

polygon.append(scanline.pop(0))

# 如果有连续的顶点相同,则闭合多边形

if polygon[-2] == polygon[-1]:

polygon.pop(-1)

break

return polygon

# 假设edges是一个边缘检测结果的类或结构体,包含图像的高度和边缘信息

edges = ...

polygon = scanline_polygon_construction(edges)

4.3.2 Ear Clipping算法的应用场景

Ear Clipping算法是一种基于多边形内点的算法,它通过寻找多边形内的“耳”并将其“剪切”下来,逐步构造出闭合的多边形。该算法在处理复杂形状的多边形构造时具有优势。

简单地说,一个“耳”是指一个多边形的凸顶点,它和它相邻的两个顶点一起构成一个三角形,并且这个三角形不包含多边形中的任何其他顶点。

Ear Clipping算法的实现较为复杂,涉及到顶点的选取、三角形的判断和顶点列表的更新等步骤。以下是该算法的简化示例:

def ear_clipping_polygon_construction(polygon):

# 检查多边形是否可剪切

if not is_polygon_convex(polygon):

raise ValueError("输入的多边形不是凸多边形。")

# 迭代寻找和剪切耳

while len(polygon) > 3:

for i in range(len(polygon)):

p1, p2, p3 = polygon[i-1], polygon[i], polygon[(i+1) % len(polygon)]

if is_ear(p1, p2, p3, polygon):

# 移除耳点并更新多边形列表

polygon.pop(i)

break

return polygon

def is_ear(p1, p2, p3, polygon):

# 判断三点是否构成“耳”

# ...

return True

# 假设polygon是一个包含多边形顶点的列表

polygon = [/* 多边形顶点坐标 */]

final_polygon = ear_clipping_polygon_construction(polygon)

Ear Clipping算法能够有效处理包含凹形的复杂多边形,但计算复杂度较高,适用于处理相对较小规模的数据集。

5. 城市轮廓算法的优化与应用

在GIS领域,城市轮廓算法的应用日益广泛,为了提高算法效率,满足大规模地理空间数据处理的需求,优化算法的性能和实现方法变得至关重要。本章将深入分析在实际应用中遇到的挑战,并提出相应的优化策略,同时讨论如何将城市轮廓算法应用于现实问题的解决方案。

5.1 拓扑校验流程

城市轮廓算法的拓扑校验是一个重要的步骤,它确保了城市边界线之间的关系符合地理空间数据的拓扑规则。校验过程中的错误检测和修正对保证数据质量至关重要。

5.1.1 拓扑关系的错误检测与修正

在拓扑关系错误检测中,常见的问题是节点的悬挂、重复的边界以及多边形的重叠。错误的检测通常依赖于算法对数据集中的拓扑规则的理解。以下是检测拓扑错误的伪代码示例:

def detect_topological_errors(data_set):

errors = []

# 检查悬挂节点

for node in data_set.nodes:

if node.is_hanging():

errors.append(f"Suspension node detected at {node.position}")

# 检查重叠多边形

for polygon in data_set.polygons:

if polygon.is_overlapping():

errors.append(f"Overlapping polygon detected in {polygon}")

# 检查重复边界

for edge in data_set.edges:

if edge.is_duplicate():

errors.append(f"Duplicate edge found between {edge.start_node} and {edge.end_node}")

return errors

def fix_topological_errors(errors):

for error in errors:

# 根据错误类型实施修复策略

if "Suspension node" in error:

# 挂起节点的修复逻辑

pass

elif "Overlapping polygon" in error:

# 重叠多边形的修复逻辑

pass

elif "Duplicate edge" in error:

# 重复边界的修复逻辑

pass

5.1.2 校验流程的自动化实现

为了提高拓扑校验流程的效率,可以实现自动化校验。使用自动化工具,如ArcGIS的拓扑检查器,可以对数据集进行全面检查,并提供修改建议。通过编写脚本或使用内置功能,可以减少人工干预,提升处理速度。

5.2 输出和可视化技术

城市轮廓算法的输出需要易于处理和高效可视化。在这一节中,将探讨有效的数据输出格式以及可视化技术的创新应用。

5.2.1 高效的数据输出格式

为了提高数据处理效率,城市轮廓算法的输出可以采用矢量数据格式,如Shapefile、GeoJSON等。这些格式有利于后续的空间分析和处理。此外,可以使用压缩格式来减小文件大小,提高传输速度。

{

"type": "FeatureCollection",

"features": [

{

"type": "Feature",

"properties": {},

"geometry": {

"type": "Polygon",

"coordinates": [

[ [-122.4194, 37.7749], [-122.4194, 37.7749], ...]

]

}

}

]

}

5.2.2 可视化技术的创新应用

随着Web技术的发展,可以使用WebGL、Three.js等技术实现城市轮廓的三维可视化,提供更加直观的展示。这样的可视化不仅有助于理解空间数据,还可以用于虚拟现实和增强现实应用中。

5.3 优化策略与大规模数据处理

大规模地理空间数据处理是GIS领域的一大挑战。在本节中,将探讨机器学习、空间索引技术和分布式计算框架如何帮助优化城市轮廓算法。

5.3.1 机器学习在轮廓算法中的应用

机器学习可以用于自动化检测城市轮廓中的异常情况,如未注册的建筑或变化区域。深度学习模型,如卷积神经网络(CNN)可以被训练用于图像识别和分类。

5.3.2 空间索引技术的优化

为了提高查询效率,城市轮廓算法可以利用空间索引技术,如R树或四叉树。这些索引可以加快空间数据的检索速度,特别是在查询特定区域内的建筑或特征时。

graph TD

A[开始] --> B[初始化R树索引]

B --> C[插入数据点]

C --> D{查询空间}

D -- Yes --> E[返回匹配的数据项]

D -- No --> F[继续查询]

E --> G[结束]

F --> D

5.3.3 分布式计算框架的选择与部署

分布式计算框架如Apache Hadoop或Apache Spark可用于处理大规模空间数据。这些框架将数据和计算分散到多个节点上,提高了处理速度和容错能力。

通过这些优化方法,城市轮廓算法能够在保持高精度的同时,应对大规模数据集,从而实现更加高效的GIS应用。

在本章中,我们讨论了城市轮廓算法在优化和应用方面的重要方面,包括拓扑校验流程、输出和可视化技术以及针对大规模数据处理的优化策略。上述内容为GIS领域中城市轮廓算法的实际应用提供了理论依据和技术指导。

简介:城市轮廓算法是一种用于描绘地图对象,特别是城市区域边界的技术,广泛应用于数据分析、城市规划和地理信息可视化。该算法通过构建多边形边界来反映城市的地理形状,涉及到数据结构的选择、点聚类、边界检测和多边形构造等多个环节。文章详细探讨了城市轮廓算法的实现原理及其应用,包括数据预处理、聚类、边界检测、多边形构造和拓扑校验等步骤,并提供输出和可视化方法。

3085

3085

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?