哈哈部署都俩个一起说了 先说一个部署框架 在说基本的方式哦 这个最坑的还是也昂看硬件吧 反正懂得都懂 我也发过几个坑的帖子 群里也好多人遇到过

当收集数据、数据清洗、搭建环境、训练模型、模型评估测试后,终于可以应用到具体场景,但是,突然发现不知道怎么调用自己的模型,更不清楚怎么去部署模型! 哈哈

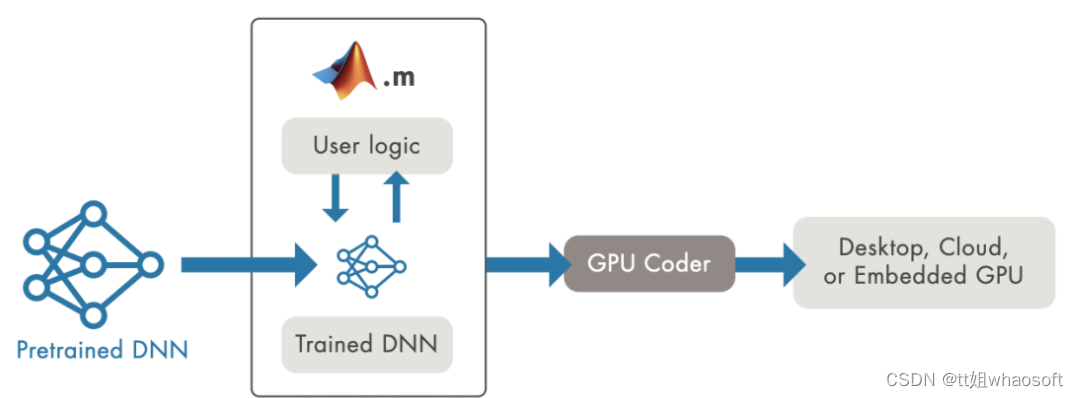

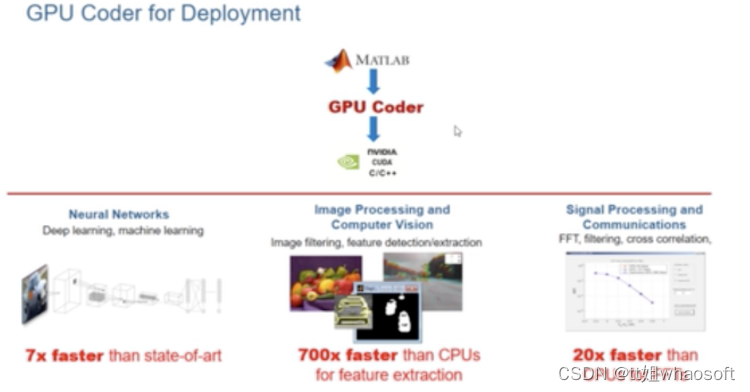

使用GPU Coder生成整个端到端应用程序的代码

将深度学习模型部署到生产环境面临两大挑战:

- 我们需要支持多种不同的框架和模型,这导致开发复杂性,还存在工作流问题。数据科学家开发基于新算法和新数据的新模型,我们需要不断更新生产环境

- 如果我们使用英伟达GPU提供出众的推理性能。首先,GPU是强大的计算资源,每GPU运行一个模型可能效率低下。在单个GPU上运行多个模型不会自动并发运行这些模型以尽量提高GPU利用率

Matlab案例 (说实话我没用过这个~)

能从数据中学习,识别模式并在极少需要人为干预的情况下做出决策的系统令人兴奋。深度学习是一种使用神经网络的机器学习,正迅速成为解决对象分类到推荐系统等许多不同计算问题的有效工具。然而,将经过训练的神经网络部署到应用程序和服务中可能会给基础设施经理带来挑战。多个框架、未充分利用的基础设施和缺乏标准实施,这些挑战甚至可能导致AI项目失败。今天就探讨了如何应对这些挑战,并在数据中心或云端将深度学习模型部署到生产环境。

一般来说,我们应用开发人员与数据科学家和IT部门合作,将AI模型部署到生产环境。数据科学家使用特定的框架来训练面向众多使用场景的机器/深度学习模型。我们将经过训练的模型整合到为解决业务问题而开发的应用程序中。然后,IT运营团队在数据中心或云端运行和管理已部署的应用程序。

部署需求

需求一:简单的demo演示,只看看效果

caffe、tf、pytorch等框架随便选一个,切到test模式,拿python跑一跑就好,顺手写个简单的GUI展示结果;高级一点,可以用CPython包一层接口,然后用C++工程去调用

需求二:要放到服务器上去跑,不要求吞吐和时延

caffe、tf、pytorch等框架随便选一个,按照官方的部署教程,老老实实用C++部署,例如pytorch模型用工具导到libtorch下跑。这种还是没有脱离框架,有很多为训练方便保留的特性没有去除,性能并不是最优的。另外,这些框架要么CPU,要么NVIDIA GPU,对硬件平台有要求,不灵活;还有,框架是真心大,占内存(tf还占显存),占磁盘。

需求三:放到服务器上跑,要求吞吐和时延(重点是吞吐)

这种应用在互联网企业居多,一般是互联网产品的后端AI计算,例如人脸验证、语音服务、应用了深度学习的智能推荐等。由于一般是大规模部署,这时不仅仅要考虑吞吐和时延,还要考虑功耗和成本。所以除了软件外,硬件也会下功夫。

硬件上,比如使用推理专用的NVIDIA P4、寒武纪MLU100等。这些推理卡比桌面级显卡功耗低,单位能耗下计算效率更高,且硬件结构更适合高吞吐量的情况。

软件上,一般都不会直接上深度学习框架。对于NVIDIA的产品,一般都会使用TensorRT来加速。TensorRT用了CUDA、CUDNN,而且还有图优化、fp16、int8量化等。

需求四:放在NVIDIA嵌入式平台上跑,注重时延

比如PX2、TX2、Xavier等,参考上面,也就是贵一点。

需求五:放在其他嵌入式平台上跑,注重时延

硬件方面,要根据模型计算量和时延要求,结合成本和功耗要求,选合适的嵌入式平台。

比如模型计算量大的,可能就要选择带GPU的SoC,用opencl/opengl/vulkan编程;也可以试试NPU,不过现在NPU支持的算子不多,一些自定义Op多的网络可能部署不上去;

对于小模型,或者帧率要求不高的,可能用CPU就够了,不过一般需要做点优化(剪枝、量化、SIMD、汇编、Winograd等)。在手机上部署深度学习模型也可以归在此列,只不过硬件没得选,用户用什么手机你就得部署在什么手机上。

上述部署和优化的软件工作,在一些移动端开源框架都有人做掉了,一般拿来改改就可以用了,性能都不错。

需求六:上述部署方案不满足你的需求

比如开源移动端框架速度不够——自己写一套。比如像商汤、旷世、Momenta都有自己的前向传播框架,性能应该都比开源框架好。只不过自己写一套比较费时费力,且如果没有经验的话,很有可能费半天劲写不好

NVIDIA Jetson上的目标检测生成和部署CUDA代码 ( 当然了 这里还是有点坑的~~~ 可以找我来咨询)

### triton-inference-server

深度学习部署神器 我反正没也用过 不过这个是英伟达的框架哦 主要是这个花钱 所以你明白的~~

triton作为一个NVIDIA开源的商用级别的服务框架,个人认为很好用而且很稳定,API接口的变化也不大,我从2020年的20.06切换到2022年的22.06,两个大版本切换,一些涉及到代码的工程变动很少,稍微修改修改就可以直接复用,很方便。

本系列讲解的版本也是基于22.06。

本系列讲解重点是结合实际的应用场景以及源码分析,以及写一些triton周边的插件、集成等。非速成,适合同样喜欢深入的小伙伴。

什么是triton inference server?

肯定很多人想知道triton干啥的,学习这个有啥用?这里简单解释一下:

- triton可以充当服务框架去部署你的深度学习模型,其他用户可以通过http或者grpc去请求,相当于你用flask搭了个服务供别人请求,当然相比flask的性能高很多了

- triton也可以摘出C-API充当多线程推理服务框架,去除http和grpc部分,适合本地部署多模型,比如你有很多模型要部署,然后分时段调用,或者有pipeline,有了triton就省去你处理显存、内存和线程的麻烦

注意,还有一个同名的triton是GPU编程语言,类似于TVM的TVMscript,需要区分,这篇文章中的triton指的是triton inference server

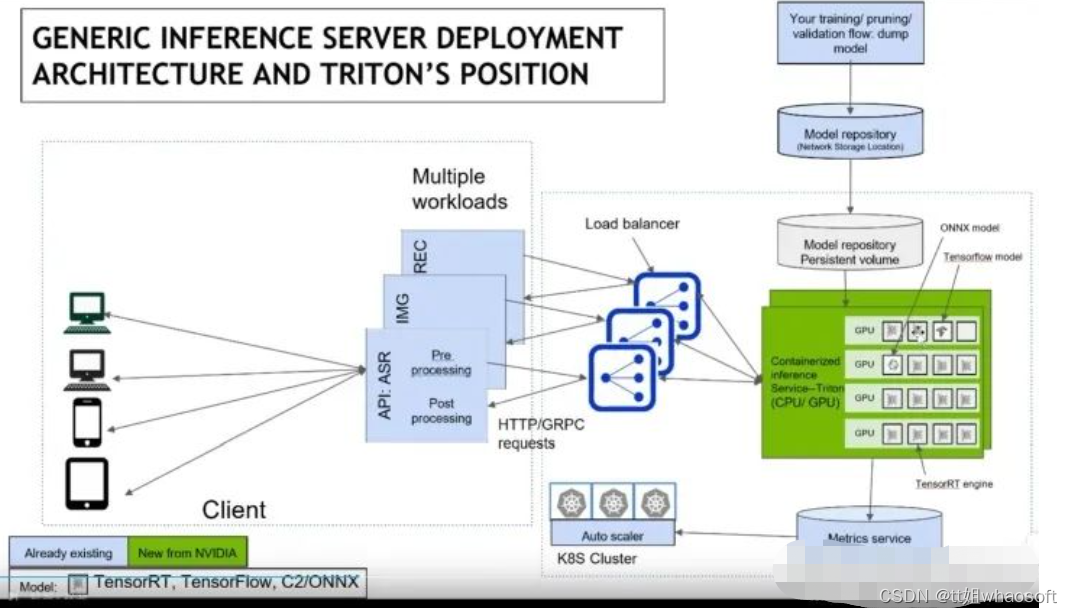

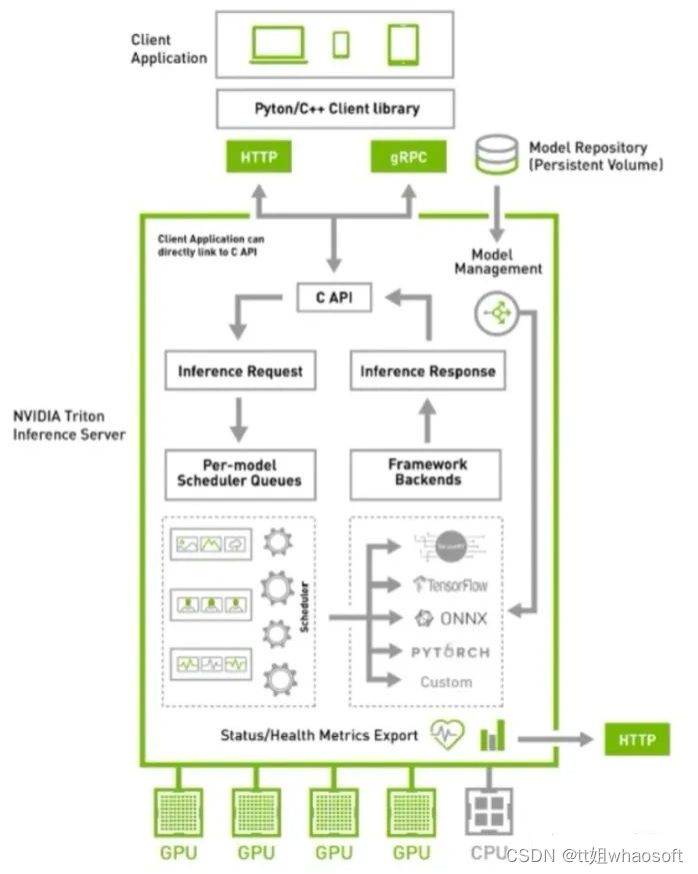

借用官方的图,triton的使用场景结构如下:

涉及到运维部分,我也不是很懂,抛去K8S后,结构清爽了些:

triton的一些优点

通过上述的两个结构图,可以大概知道triton的一些功能和特点:

- 支持HTTP/GRPC

- 支持多backend,TensorRT、libtorch、onnx、paddle、tvm啥的都支持,也可以自己custom,所以理论上所有backend都可以支持

- 单GPU、多GPU都可以支持,CPU也支持

- 模型可以在CPU层面并行执行

- 很多基本的服务框架的功能都有,模型管理比如热加载、模型版本切换、动态batch,类似于之前的tensorflow server

- 开源,可以自定义修改,很多问题可以直接issue,官方回复及时

- NVIDIA官方出品,对NVIDIA系列GPU比较友好,也是大厂购买NVIDIA云服务器推荐使用的框架

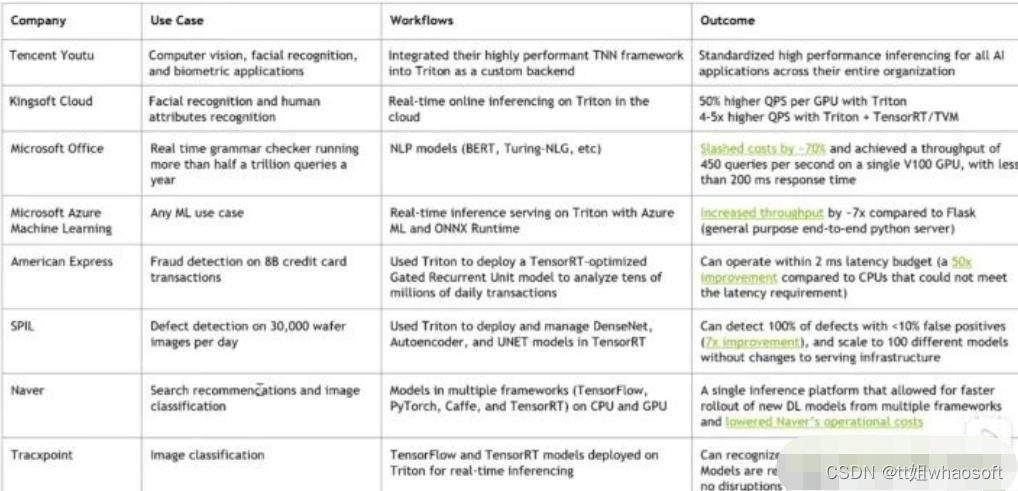

- 很多公司都在用triton,真的很多,不管是互联网大厂还是NVIDIA的竞品都在用,用户多代表啥不用我多说了吧

如何学习triton

两年前开始学习的时候,官方资料比较匮乏, 只能通过看源码来熟悉triton的使用方式,所幸知乎上有个关于TensorRT serving不错的教程(https://www.zhihu.com/people/pwlazy/posts),跟着看了几篇大致了解了triton的框架结构。那会triton叫做TensorRT serving,专门针对TensorRT设计的服务器框架,后来才变为triton,支持其他推理后端的。

现在triton的教程比较多了,官方的docs写着比较详细,还有issue中各种用例可以参考,B站上也有视频教程(https://www.bilibili.com/video/BV1KS4y1v7zd/),比两年前的生态要好了不少。

当然,最重要的,还是上手使用,然后看源码, 然后客制化。

源码学习

从triton的源码中可以学到:

- C++各种高级语法

- 设计模式

- 不同backend(libtorch、TensorRT、onnxruntime等)如何正确创建推理端,如何多线程推理

- C++多线程编程/互斥/队列

- API接口暴露/SDK设计

- CMAKE高级用法

等等等等,不列举了,对于程序员来说,好的源码就是好的学习资料。当然,也可以看老潘的文章哈。

triton系列教程计划

triton相关系列也会写一些文章,目前大概规划是这些:

- 什么是triton以及triton入门、triton编译、triton运行

- triton管理模型、调度模型的方式

- triton的backend介绍、自定义backend

- 自定义客户端,python和c++

- 高级特性、优先级、rate limiter等等

编译和安装

一般来说,如果想快速使用triton,直接使用官方的镜像最快。但是官方镜像有个尴尬点,那就是编译好的镜像需要的环境一般都是最新的,和你的不一定一致 !

比如22.09版本的镜像需要的显卡驱动为520及以上,如果想满足自己的显卡驱动,就需要自行编译了。官方也提供了使用镜像的快速使用方法:

triton官方仓库

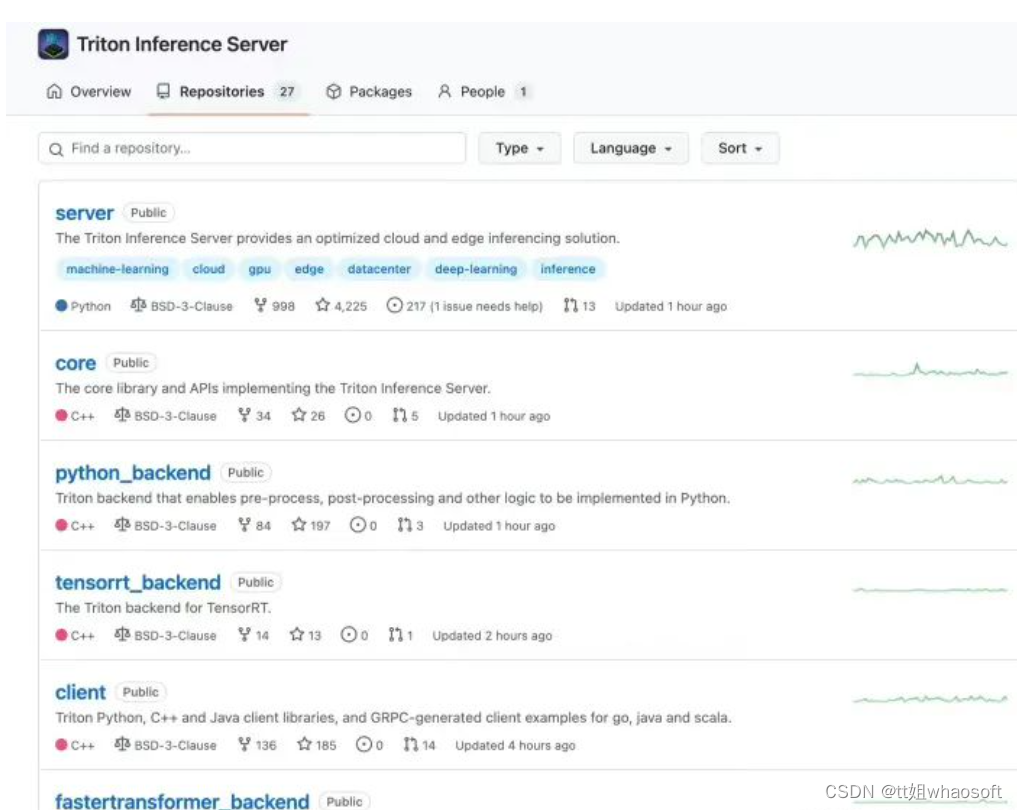

两年前的triton只有一个大仓库,tensorrt_backend也默认在triton主仓库中,但是现在tensorrt_backend被拆分出来了,很显然triton除了支持tensorrt还支持很多其他的后端,我们可以自定义使用很多后端。

现在是目前的triton包含的一些仓库:

- [server] triton服务外层框架,包含了http收发请求,服务内存分配等一些功能代码

- [core] triton主框架,如果处理请求、后端管理、模型调度啥的全在这里

- [common] 通用工具,没啥好说的,打日志的代码在这里

- [backend] backend后端框架代码,存放了一些后端通用父类,自定义后端可以集成这些类仿写新的后端

- [third_party] triton使用的第三方库的汇总,主要是cmake里头会包含

- [tensorrt_backend] tensorrt后端代码

- [pytorch_backend] libtorch后端代码

最开始的时候,server、core、common、backend这些代码仓库都是合在一起的,后来都拆分出来了,增加了triton的灵活性。

比如,上述的core仓库可以单独暴露出cAPI作为动态链接库供其他程序调用,去掉http、grpc的外层请求接口,直接一步到位调用。

一般来说,我们都是从最主要的server开始编,编译的时候会链接core、common、backend中的代码,其他自定义backend(比如tensorrt_backend)在编译的时候也需要带上common、core、backend这三个仓库,这些关系我们可以从相应的CMakeList中找到。

自行编译

如果想要研究源码,修改源码实现客制化,那么自行编译是必须的。

triton的编译和安装其实很简单,唯一的难点就是需要加速,因为triton在编译的时候会clone很多第三方库,第三方库也会克隆它们需要的第三方库,这些库当然都是国外的,所以有个好的网络环境很重要。

比如在编译triton的时候需要下载grpc这个库,grpc又依赖很多第三方其他库,网络不好的话,会经常遇到下面的问题:

开加速是最好的办法,不管是UI还是命令行,都有相应的软件可以用,比如clash。

如果你的服务器实在是开不了加速,也有其他办法,那就是将triton库中大部分重量级库的git地址全换为国内的。

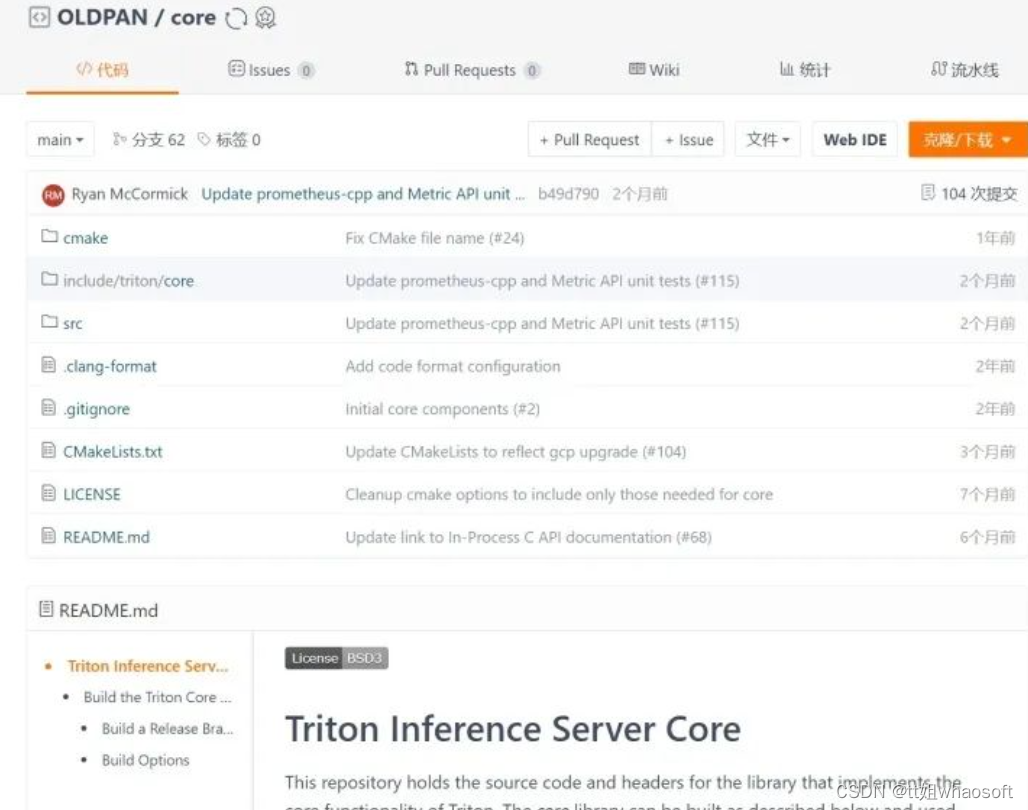

怎么替换,我是在gitee中,同步github上的仓库,比如triton的core仓库,同步过来,就可以使用国内的地址了。

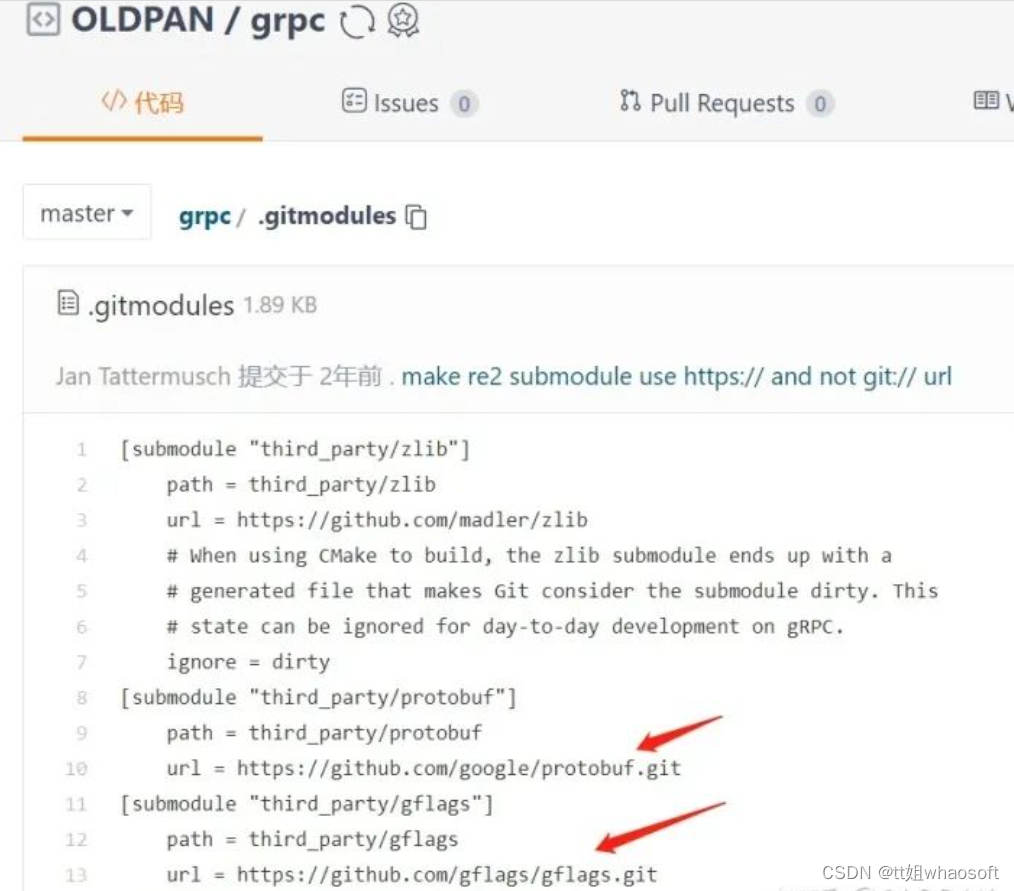

当然也需要将这些库的submodule中的库也修改为国内源,比如grpc这个库依赖很多第三方库,克隆的时候,这是要一个一个下载的:

改起来稍微麻烦,还需要注意,要改特定commit分支的git地址:

如果有部分第三方库下载太慢下来不下来,我们可以手动进入/tmp/tritonbuild/tritonserver/build/_deps/repo-third-party-build/grpc-repo/src/grpc/third_part目录然后手动git clone xxx,然后执行一下git submodule init / git submodule update下就可以带进去。

示例:

太麻烦了,不过确实为一种办法呃呃。

还有一点,triton每次build都会clone,是因为其用了cmake中的ExternalProject_Add指令,假如我们已经有下载好的grpc,那么直接替换到server/build/_deps/repo-third-party-build/grpc-repo/src中然后将/data/oldpan/software/server/build/_deps/repo-third-party-src/CMakeLists.txt:

注释掉git下载部分,修改自己本地的就行,就不需要每次再clone一遍了。

说了这么多,总之,最好的办法当然还是开科学,全局一下就OK,省去那么多麻烦事儿。

搞定好网络问题,编译triton就很简单了!

在克隆好的server的目录下执行以上命令(下面是我的设置,我们可以个根据自己的需求进行修改)就可以了。

执行这个命令后triton就会构建docker在docker中编译,最终会创建3个镜像:

- tritonserver:latest

- tritonserver_buildbase:latest

- tritonserver_cibase:latest

最终编译好的tritonserver_buildbase:latest镜像,我们可以在其中开发,因为环境都帮忙配好了,只需要再执行编译命令,就可以编译了,我们也可以自定义源码进行个性功能的开发。

在镜像中开发

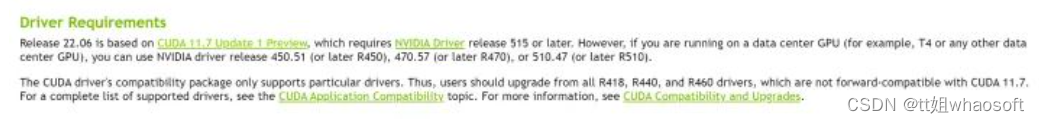

需要注意,在编译的时候需要pull官方默认的镜像,而这个镜像是有显卡驱动限制的,比如r22.06需要显卡驱动版本为470。

同志们看看自己的显卡驱动,别下了不能用hhh

可以通过triton镜像历史查看镜像版本要求:

接上,我们不是编译好了triton镜像,直接进去就可以开发了:

在docker中修改triton的源码,继续执行以下命令就可以编译,和之前的区别就是加了 --no-container-build参数。

我们如果想编译debug版本的triton,可以在命令中添加:--build-type=Debug。

另外,原始triton镜像中已经有tensorrt,如果想换版本,可以删除原始docker中的旧的tensorrt,自行安装新的tensorrt即可:

说下运行流程吧!

讲了这么多铺垫,接下来简单说下运行流程。

这里通过代码简单梳理下triton运行的整体流程,之后的具体细节,放到接下来的篇章讲解。

首先一开始,main函数在servers/main.cc下,triton在启动的时候会执行以下函数:

TRITONSERVER_ServerNew这个函数中,会:

- new一个triton类

InferenceServer对象 - 根据参数设置配置一下,执行一堆Set函数

- 配置好参数后,

Init服务,这里初始化服务的状态,校验参数 - 创建各种模块,经常使用的有后端管理

TritonBackendManager以及模型仓库管理ModelRepositoryManager - 再进行一些检查、配置一些状态

在启动过程中最重要的是模型仓库,运行triton当然你要有模型,要不然你开它干嘛?

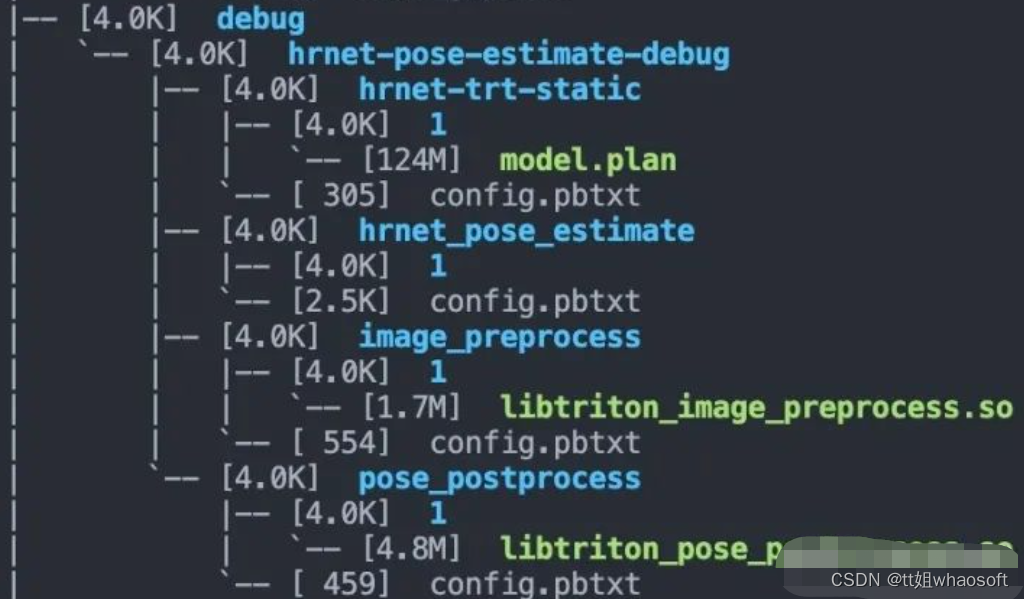

这里我使用的模型仓库目录结构如下(是一个识别姿态的hrnet,hrnet官方有很多预训练模型,转tensorrt也很简单):

debug目录下有一个模型文件夹叫做hrnet-pose-estimate-debug的模型文件夹,这个文件夹地址(/path/to/hrnet-pose-estimate-debug)需要传给triton启动命令行,文件夹内的四个子模型文件夹,会被triton检测到并且一一加载。

需要注意的是,除了hrnet_pose_estimate这个其余三个在目录的1子目录下有个so或者model.plan,这代表hrnet-trt-static和image_preprocess还有pose_postprocess都属于model,使用了backend,backend会在各自的config中指明:

因为hrnet-trt-static是tensorrt的模型,所以backend设置为tensorrt,model.plan就是tensorrt的engine。其backend的so文件我放到了其他位置(放到和model.plan同目录也是可以的),而另外两个预处理和后处理的backend就放到了模型仓库中,也就是libtorch_image_preprocess.so和libtriton_pose_postprocess,包含了你的backend代码,封装成so供triton调用

关于backend、model以及modelinstanc的关系,说实话稍微复杂点,各自有完整的生命周期,这个嘛,之后文章说,感兴趣的也可以提前看官方文档的介绍:

然后我们就启动triton吧!

模型加载成功之后会输出:

加载好之后,我们开启了http端口,端口号为8000,另一个是metric接口,端口号8001

此时可以使用http请求试一下。

简单请求

请求的话有http和grpc协议,我对http协议熟悉些,所以就搞http吧。

官方也提供了客户端,C++和python的都可以有,可以直接使用官方的,也可以根据官方提供的http协议构造自己的客户端,只要会构造body,一切都很简单。

请求协议可以参考官方:

这里我们用python简单构造一个body:

就可以发送请求,结果也会传回response里。我们也可以使用curl命令,直接传递构造好的body(这个body将上述的push_data写到本地即可):

结果就不发了,验证没啥问题。

关于如何使用curl直接请求triton,有一些相关链接可以参考:

- https://github.com/triton-inference-server/server/issues/2563

- https://github.com/triton-inference-server/server/issues/1822

后记

算是开triton的新坑了,已经有一些草稿了,正在填充文件中:

triton inference server,很好用的服务框架,开源免费,经过了各大厂的验证,用于生产环境是没有任何问题。各位发愁flask性能不够好的,或者自建服务框架功能不够全的,可以试试triton,老潘很推荐的哦。

1414

1414

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?