继OpenAI的🍓曝光,如雨后春笋般的Q*方法涌现之后,Google DeepMind于昨日又发布了Alpha系列中的AlphaProof以及AlphaGeometry 2并捧得了2024 IMO🥈..不得不说在AI4M/S这条路上,有一部分人真的是要一条道儿走到“黑”呢~而这也相信会给这部分心怀初心和信仰的人一针强心剂。

不论是AI4M还是4S,当前的技术路线或框架思想更多还是围绕在llm与rl之上并逐小步的在取得一些进展,虽然与llm当初那种暴力出奇迹的跨越式爆发不同..

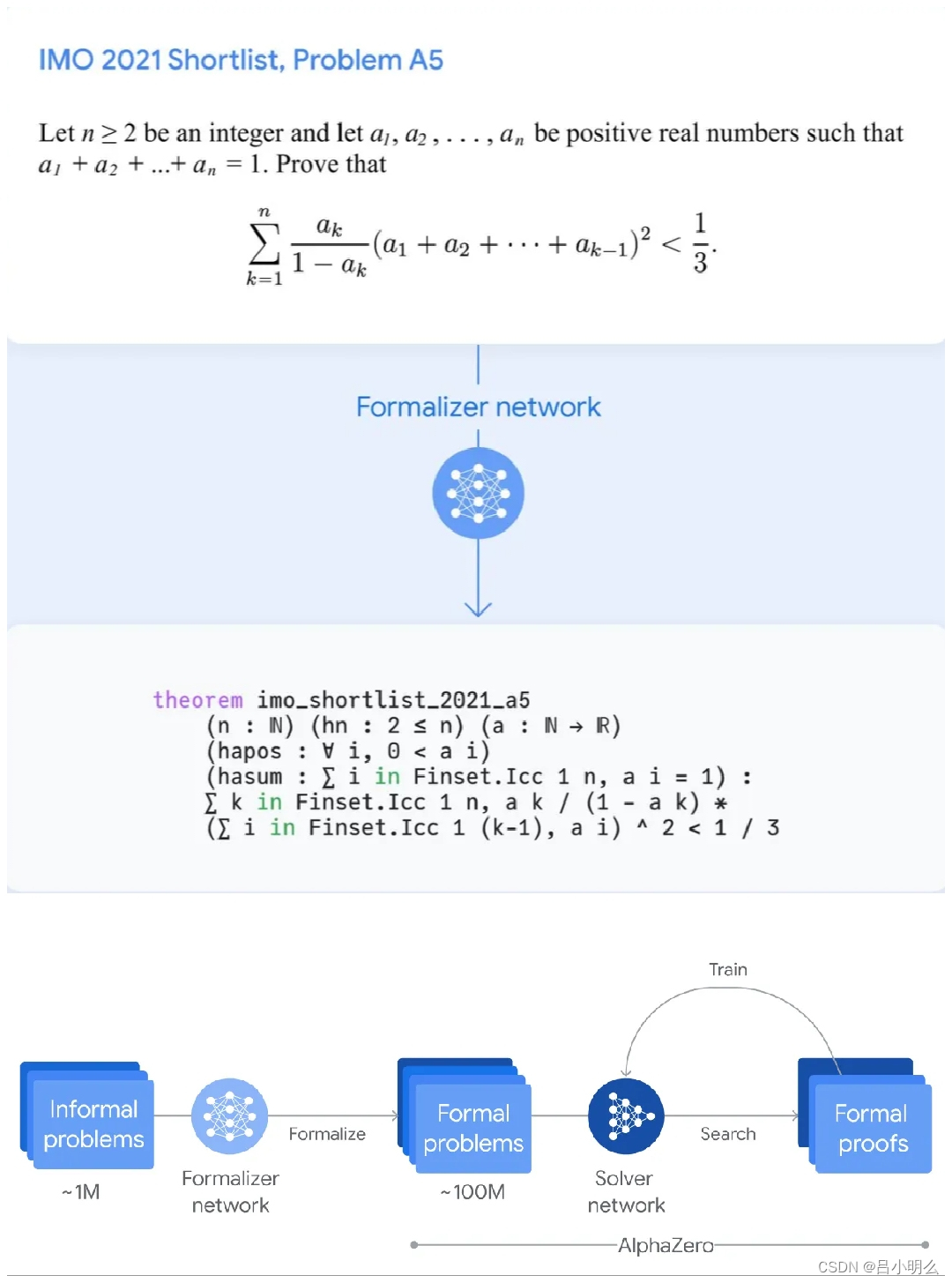

之所以在进展上不同,我想也许问题是出在三个方面:① 数据、② 学习的范式、③ 形式化。

针对“数据“,我想是显而易见的 - 深邃的数理概念空间的复杂性在不逊于真实物理世界空间的情况下,相对可用于模型训练的样本数量是比较棘手的瓶颈。

对于“学习范式”的问题,如llm的这种next token prediction自回归监督学习与rl(如Q*)本身在训练思想、监督形式等方面有着天然的不同且后者在训练过程的复杂度要高很多,针对rl下的Q也有更多复杂问题待进一步探索和解决。这块大家可以参考4天前我记录的一些想法,标题「Q*s' AGI」。

当然还有第3个方面:“形式化”...坦率说,从去年AlphaGeometry刚刚发布启始,就时不时的忍不住的思考形式化这一问题,但因为时间和精力原因也没有进行较系统性的思考,也仅仅在今年初写的那篇文章标题:「融合RL与LLM思想,探寻世界模型以迈向AGI」中进行了一些浅显的思考和探索,大伙感兴趣也可以翻看阅读我的历史专栏或置顶🔝文章/笔记,或baidu一下自寻出处:)

今天就当立个flag抛个砖,对于形式化,先将问题提出来~后续深入探索并持续跟大伙分享。

我想针对形式化,首先我可能要向自己提出三个问题,当然也非常希望大家后续发表自己的一些看法和观点:

① 人类的自然语言符号化系统算是一个完备的形式化系统吗?是否与lean这种形式化语言证明系统有着本质区别和差异?差异在哪?

② 如何构建一个可形式化自验证、足够灵活、完备、且表征最大化的形式化符号系统?是可行的吗?

③ 如①中所提及,自然语言如果可以作为一个更开放的形式化语言系统,那么在采用rl或甚至其它更好的学习范式时,对反馈验证形式、监督信号,学习过程,训练的方法以及数据分布的考量都有哪些?

④ …

5841

5841

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?