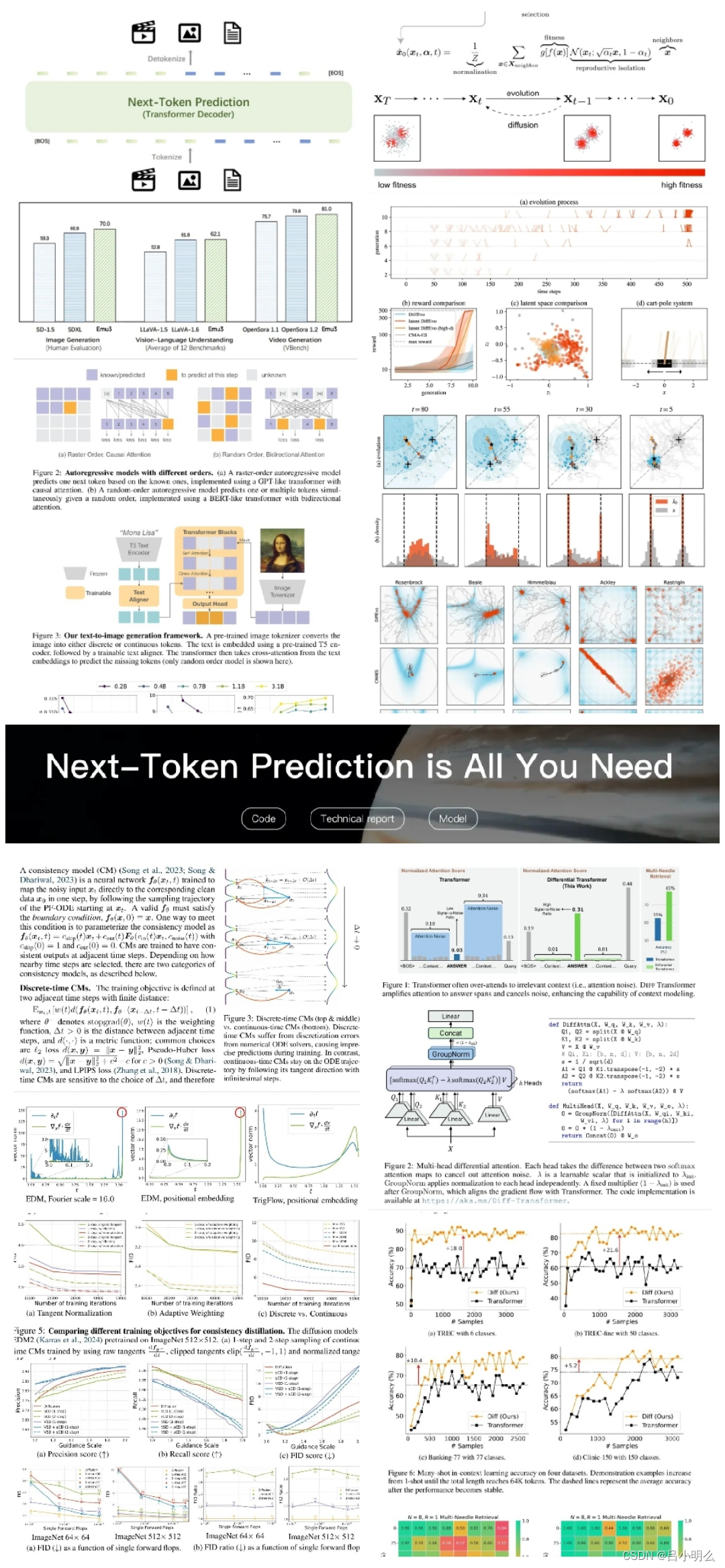

最近不管是在视觉领域还是文本领域,在Transformer下的自解码AR自回归还是Diffusion的扩散生成之间都在发生着不少的变化与演进,包括从文本生成和system2复杂推理的AR条件预测向扩散机制的演进, 再到图像/视频扩散生成“自回归”到next token prediction的统一。

对于上述前者的演进路径,随着Sora的问世和扩散思想的大行其道,我们看到了诸多围绕文本的扩散合成方法并取得的SOTA效果:

- 包括来自MIT的Diffusion Forcing;

- Meta的Transfusion;

- 来自TPAMI2024的Diffusion Mechanism in Residual Neural Network: Theory and Applications;

- 以及近期哈佛等欧美多所名校的学者在机器学习和生物学的融合研究中,所揭示的“扩散模型与进化算法”观点;

ps:以上内容之前我的历史笔记均匀论述,感兴趣的大伙可翻看之前笔记或文章。

然而最近这两周,我们看到事情似乎正在朝着相反的演进路径发展:

- 包括“谢赛宁所提出的表征对齐技术-REPA”中对自监督视觉编码下的高质量表征对扩散生成任务的重要意义;

- 智源研究院于上周正式发布的Emu3所建立的横跨文本/图像/视频next token prediction端到端统一的原生“世界模型”;

- 紧随其后谷歌联合MIT发布的Fluid,进一步探索了文本符号与视觉信息不同模

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?