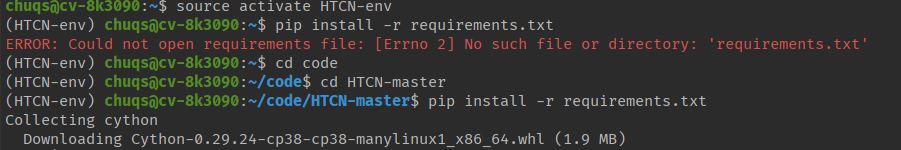

1.配置环境时可以利用配置文件,采用命令:pip install -r requirement.txt

方法:首先在pycharm中利用tools->deployment-configuration连接服务器设置mappings,再利用upload将工程代码上传到服务器指定位置

随后在服务器的.conda文件夹内创建自己的工程环境

在pycharm内打开工程,利用settings将工程的解释器选择为ssh对应工程的解释器

选择tools->start ssh sessions与服务器发起远程会话:

首先进入我们自己的环境,并且在远程终端内调整路径到我们的工程文件下(要让pycharm能找到requirements.txt的位置),否则如图所示找不到requirement文件位置

改变路径到工程文件夹下,输入命令pip install -r requirement.txt即可

并输入pip install -r requirement.txt

2.设置自己的环境的pytorch以及CUDA版本

例如代码要求环境配置为pytorch版本1.0.1 CUDA版本10.0.130 进入环境后输入代码

conda install pytorch=1.0.1 cudatoolkit=10.0.130 -c pytorch下载完成后我们可以打开python交互模式来查询pytorch以及CUDA的版本

source activate HTCN-env #首先进入环境

python3

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1203

1203

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?