归一化是深度学习和机器学习中一个非常重要的步骤,它通过对数据或网络层的输出进行变换,使其符合特定的标准,有效缓解不同特征间由于量纲和数值范围差异造成的影响,加速模型的收敛速度,并提高模型精度。

大多数归一化方法的设计思路都是即插即用的,以适应不同的训练策略和数据特性。这种设计能帮助我们有效加速训练过程并提升模型性能,而不需要对网络结构进行重大调整。也就是说我们可以直接在现有模型中替换相应的层,这样写论文的时候能省很多功夫。

为方便小伙伴们集成和使用,加速论文进度,我这次挑选了10个即插即用的归一化模型及其变体,有2024年最新的,也有经典必备的,已开源的代码我也贴心附上~

论文原文以及开源代码需要的同学看文末

BCN: Batch Channel Normalization for Image Classification

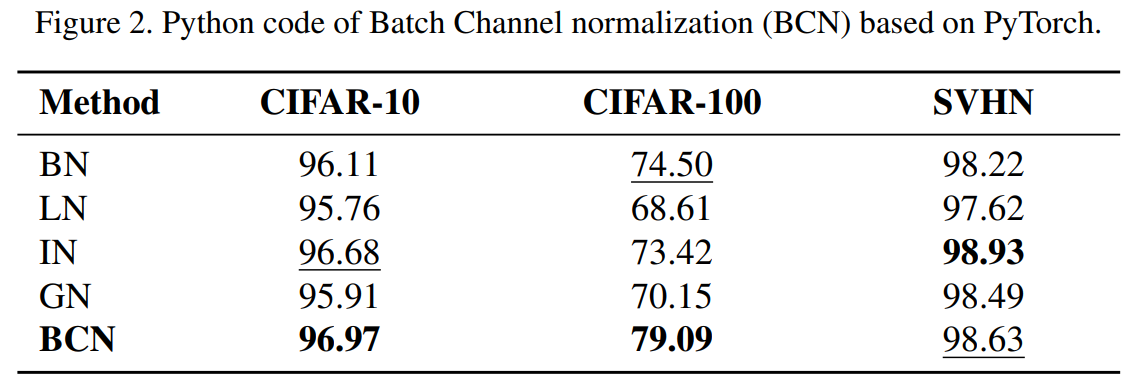

方法:论文介绍了一种新的归一化技术,称为Batch Channel Normalization(BCN),用于图像分类任务。BCN的目标是克服现有归一化方法的局限性,并充分利用BN和LN的优势,无缝应用于各种版本的CNN(卷积神经网络)或Vision Transformer架构。

创新点:

-

批通道归一化(Batch Channel Normalization,BCN):与以往的归一化技术不同,BCN旨在沿着(C,N,H,W)轴进行归一化。BCN首先沿着(C,H,W)轴计算层输入的均值(µ1)和方差(σ21),然后沿着(L,H,W)轴计算均值(µ2)和方差(σ22),最后根据自适应参数组合归一化的输出。

-

通过将BCN应用于几种流行的模型(ResNet,DenseNet,Vi-sion Transformer [5]和BYOL)的图像分类任务中,实验证明BCN在新模型(如ViT)中的性能表现更好。

Unified Batch Normalization: Identifying and Alleviating the Feature Condensation in Batch Normalization and a Unified Framework

方法:论文介绍了一种称为特征凝聚(feature condensation)的现象。从特征凝聚的角度出发,提出了一种统一的方法,即统一批量归一化(Unified Batch Normalization,UBN)框架。UBN通过设置一个预定义的阈值来纠正特征凝聚,改善特征表示,并对BN的每个组件进行修正,显著提高测试性能和训练效率。

创新点:

-

作者在第一阶段引入了一个简单的特征凝聚阈值,用于在训练过程中选择统计数据,有效地减轻了特征凝聚问题,并促进了更动态和适应性的学习路径。

-

为了改善BN的整体性能,作者提出了一个统一的框架,包括对BN各个组件的修正。这个框架可以应用于不同的训练场景。

AFN: Adaptive Fusion Normalization via Encoder-Decoder Framework

方法:论文研究了一种新的归一化方法,称为自适应融合归一化(Adaptive Fusion Normalisation,AFN)。研究者通过在批次之间计算统计数据来改进批归一化(Batch Normalisation,BN)方法,提出了AFN方法。AFN方法在图像分类任务和领域泛化任务中表现出比之前的归一化方法更好的性能。

创新点:

-

引入自适应融合归一化AFN方法,通过在批归一化BN模型中添加更多参数,从而在特定任务上表现出优于以往归一化方法的性能。

-

AFN方法在单领域泛化任务上的性能优于以前的SOTA归一化方法(ASRNorm),在Digits、CIFAR-10-C和PACS基准测试中的表现分别提高了0.9%、0.6%、1.3%和1.6%。

Context Normalization Layer with Applications

方法:论文提出了一种新的归一化技术,称为上下文归一化(CN)。通过将数据建模为多个组分的混合模型,CN使用每个组分的均值和方差来对小批量中的每个样本进行归一化,以提高数据表示的区分能力。

创新点:

-

提出了上下文归一化(CN)方法,该方法利用定义的上下文来捕捉潜在的分布变化。CN通过使用特定于其上下文的均值和标准差来对小批量中的每个样本进行归一化。通过将上下文视为高斯混合的组成部分,作者在模型训练期间学习其参数,消除了EM算法的需要。这提高了CN的效率并简化了其实现。

-

通过一系列全面的实验,证明CN不仅加速了模型的收敛,还实现了更高的最终测试准确性。突显了该方法在提高模型整体性能方面的有效性。

关注下方《学姐带你玩AI》🚀🚀🚀

回复“归一化10”获取全部论文+代码

码字不易,欢迎大家点赞评论收藏

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?