一、安装大模型

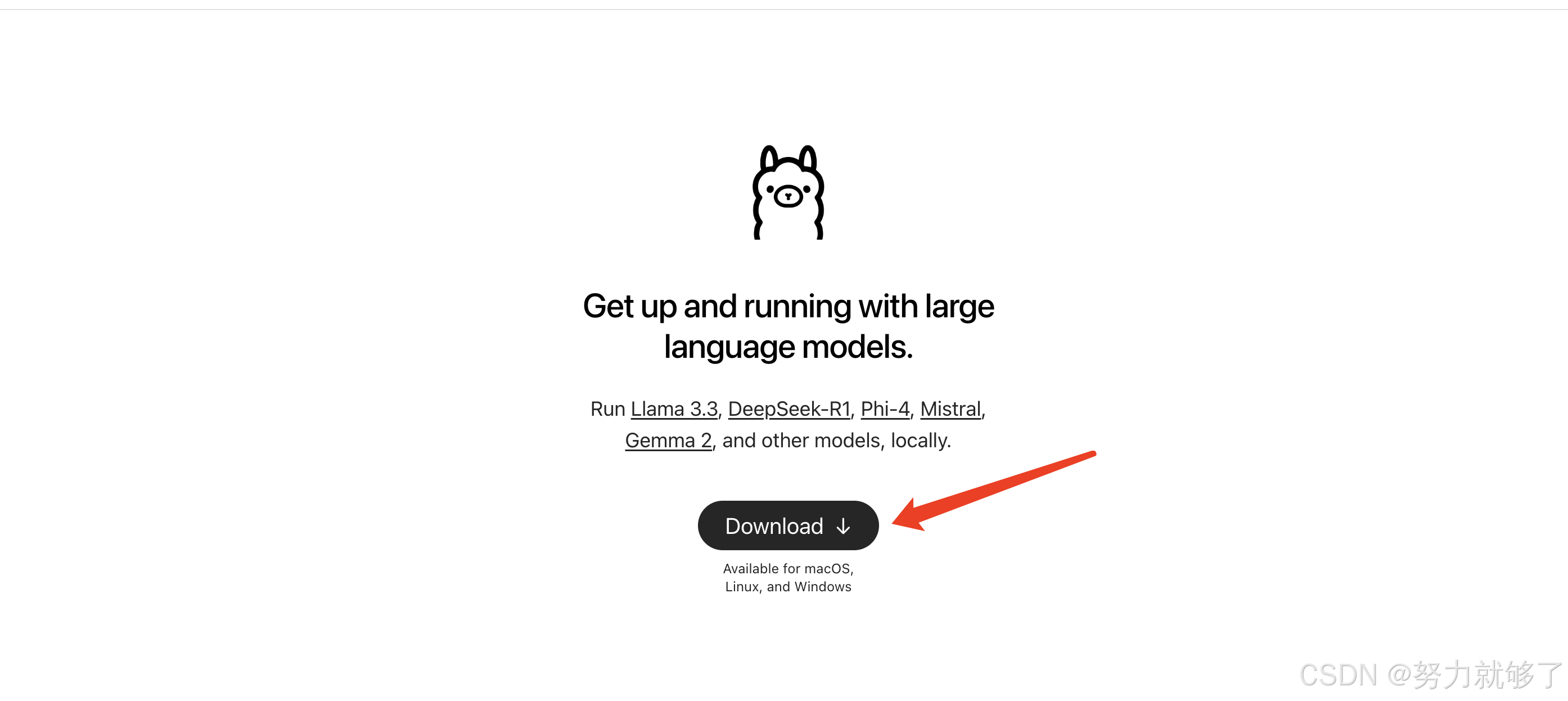

1、首先是下载 ollama点击下载;

选择适合自己操作系统的版本,ollama是一个开源的 LLM(大型语言模型)服务工具,用于本地环境快速搭建部署大模型。

2、傻瓜式安装ollama即可,默认安装路径是不需要配置环境变量的;

安装ollama会强制安装到c盘,所以环境变量是配置好的,下次再进入执行cmd黑窗口就行

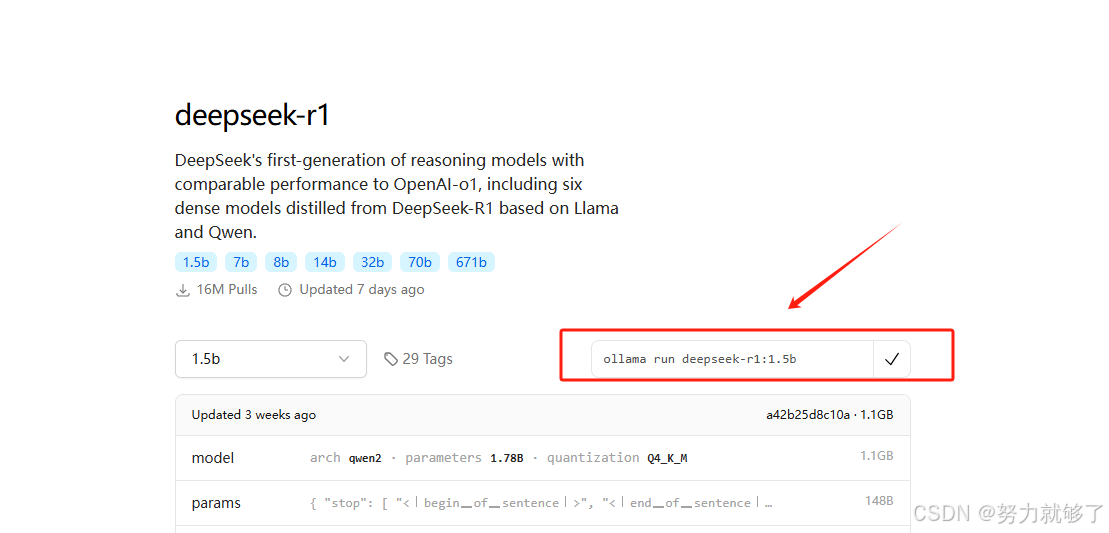

3、选择大模型,比如deepseek R1;

4、点击对应大模型,选择合适的版本,比如1.5b;

5、复制右侧执行脚本下载大模型并启动;

第一次执行命令可能会下载失败,多执行几次就好了!!!

如果退出或者关闭命令窗口,再次进入也是通过 ollama run deepseek-r1:1.5b 命令启动大模型;

6、测试效果;

二、安装前端可视化页面open-webUI

1、下载miniconda点击下载;

选择适合自己操作系统的版本,下载后需要配置环境变量;

2、下载 python点击下载;

python 也需要配置环境变量,如果之前已经安装过就可以忽略该步骤;

3、创建webUI环境:conda create -n open-webui pyhton==3.12.6

⚠️注意:python 需要配置环境变量且版本号一致!

4、激活webUI环境:activate open-webui

5、在open-webui环境下安装依赖:pip install open-webui

6、启动open-webui服务:open-webui serve

⚠️注意:启动 open-webui 的时候需要保证大模型服务是启动状态!

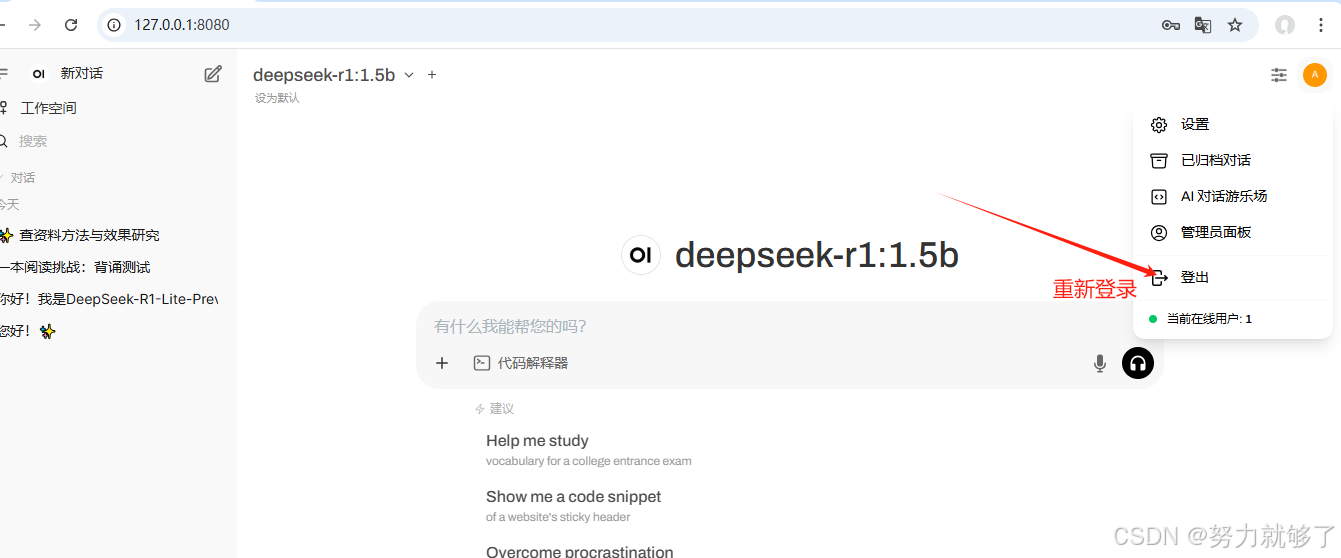

7、访问页面:127.0.0.1:8080

8、创建账户

9、选择自己的模型就可以使用了

三、搭建本地知识库

1、设置解析文档需要使用的大模型

2、上传文件到知识库

3、进入大模型选择上传的文件

5、重新登录防止不生效

6、测试效果

通过后台日志可以看到确实是使用的上传文件进行的解析匹配

这是我上传的文件,通过测试发现 1.5b 的效果不是很好,或者是我提供的文件格式不太好,可以试试以问答模式提供的文件效果。

四、总结

1、作为开发人员,肯定是希望能通过 api 的模式调用大模型,下面介绍下ollama的 api 使用方式。

Ollama默认端口为 11434

Ollama api:

获取模型列表 : http://localhost:11434/api/tags

对话生成文本: curl -X POST http://127.0.0.1:11434/api/generate -d'{"model":"deepseek-r1:1.5b", "prompt":"我是谁", "stream":false}'

model: 使用的大模型;

prompt: 提示词,交互信息

stream: 是否以流的形式返回

2、通过测试发现1.5b 版本的效果不尽如人意,所以建议如果自己机器性能如果可以的话,可以考虑下载高版本的。我自己电脑配置为12G 的内存,测试 1.5b 时比较困难,大家可以参考下。

3、ollama不仅可以部署 deepseek,还可以选择其他大模型,感兴趣的可以试试。

492

492

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?