文章目录

什么是 Celery?

Celery是一个简单、灵活且可靠的,处理大量消息的分布式系统,专注于实时处理的异步任务队列,同时也支持任务调度。

Celery的架构由三部分组成,消息中间件(message broker),任务执行单元(worker)和任务执行结果存储(task result store)组成。

消息中间件

Celery本身不提供消息服务,但是可以方便的和第三方提供的消息中间件集成。包括,RabbitMQ, Redis等等

任务执行单元

Worker是Celery提供的任务执行的单元,worker并发的运行在分布式的系统节点中。

任务结果存储

Task result store用来存储Worker执行的任务的结果,Celery支持以不同方式存储任务的结果,包括AMQP, redis等

另外, Celery还支持不同的并发和序列化的手段

并发:Prefork, Eventlet, gevent, threads/single threaded

序列化:pickle, json, yaml, msgpack. zlib, bzip2 compression, Cryptographic message signing 等等

使用场景

celery是一个强大的分布式任务队列的异步处理框架,它可以让任务的执行完全脱离主程序,甚至可以被分配到其他主机上运行。我们通常使用它来实现异步任务(async task)和定时任务(crontab)。

异步任务:将耗时操作任务提交给Celery去异步执行,比如发送短信/邮件、消息推送、音视频处理等等

定时任务:定时执行某件事情,比如每天数据统计

Celery 的优点

Simple(简单)

Celery 使用和维护都非常简单,并且不需要配置文件。

Highly Available(高可用)

woker和client会在网络连接丢失或者失败时,自动进行重试。并且有的brokers 也支持“双主”或者“主/从”的方式实现高可用。

Fast(快速)

单个的Celery进程每分钟可以处理百万级的任务,并且只需要毫秒级的往返延迟(使用 RabbitMQ, librabbitmq, 和优化设置时)

Flexible(灵活)

Celery几乎每个部分都可以扩展使用,自定义池实现、序列化、压缩方案、日志记录、调度器、消费者、生产者、broker传输等等。

Celery安装

你可以安装Celery通过Python包管理平台(PyPI)或者源码安装

使用pip安装:

pip install -U Celery

或着:

sudo easy_install Celery

Celery 使用

celery 分为两大块,生产者【任务发布者】和消费者【任务执行者】。他们通过中间件进行协调。这个中间件官方推荐 RabbitMQ,不过 Redis 使用更加简单,本文以 redis 为例编写代码。

下面的过程,先严格按照我的操作来,后面再做发散性的思考。

备注:我的主机是 windows,windows 上开启 celery 的工作进程会有些小问题。

任务发布者和任务执行者在同一台机器上

创建项目 demo 项目

demo 下创建任务代码文件 celery_task.py

import celery

import time

# 任务发布 redis, 任务执行者会去这里取任务

broker = 'redis://192.168.1.10:6379/0'

# 任务执行结果存储 redis

backend = 'redis://192.168.1.10:6379/1'

# celery 应用的名称是 test

cel = celery.Celery('test', backend=backend, broker=broker)

@cel.task

def send_email(name):

print(f'向{name}发送邮件。。。')

time.sleep(5)

print(f'向{name}发送邮件完成。。。')

return 'ok'

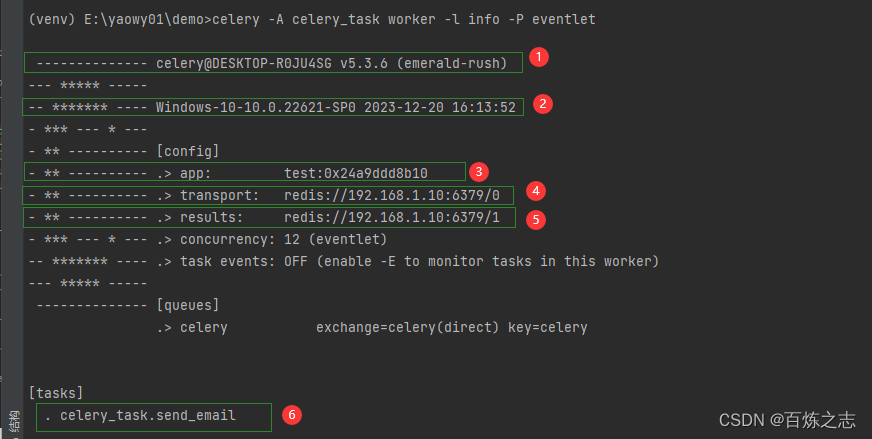

启动消费者

windows 启动 celery 工作进程会有一些小问题,解决办法

- 安装 eventlet

- 启动命令 celery -A celery_task worker -l info -P eventlet

celery -A celery_task worker -l info -P eventlet

启动的时候 celery 会打印一些配置信息

- celery 版本

- 当前主机的系统

- 注册到 celery 的应用, test 正是我们前面代码里面创建 celery 应用的名字

- 中间件地址,到时候任务消费者就可以从这里取任务

- 结果存储地址

- 任务

这里 celery 消费者扫描到了一个任务,如果 celery_task 里面装配了两个任务代码,这里就可以看到两个。

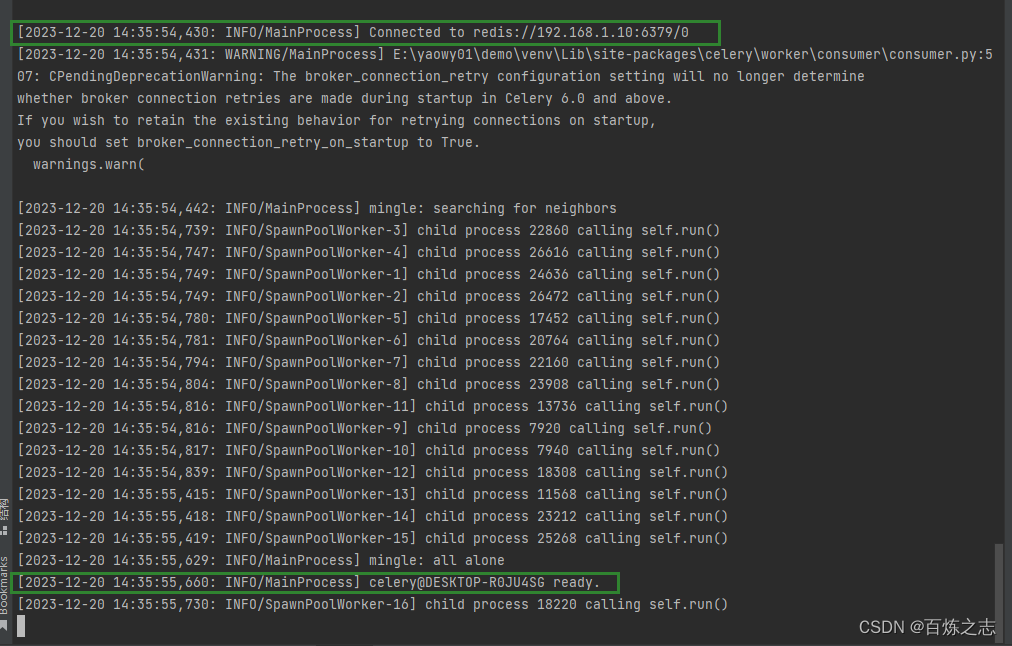

连接rendis, 并且做好了准备。

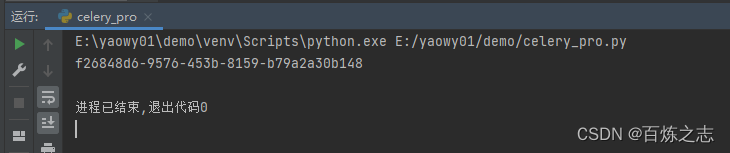

发布任务

项目下,与 celery_task 同级目录,创建文件 celery_pro

from celery_task import send_email

res = send_email.delay('yaowy')

print(res.id)

这份代码可以直接执行。

现象

任务生产者

任务消费者

【思考】

【1】celery 是一个分布式任务队列的异步处理框架,它可以让任务的执行完全脱离主程序,甚至可以被分配到其他主机上运行。

重点是这个分布式,再看架构图,发布者向 redis 中发布任务,消费者从 redis 中获取任务,所以生产者和消费者是可以完全分开的,在不同的机器上。

我们假设工作的代码特别庞大,代码可能传递到 redis 中去吗?不可能,大概是传递一个路径,当做找包的过程,也就是说,在生产者这边,方法名和以及对应的包路径与生产者这边一致的话,两边的工作函数内部就可以不一样,随便写。

任务发布者和任务执行者在两台机器上

在 ubuntu 上创建文件 celery_task,他与 windows 上的同名文件内容如下

先在ubuntu上开启 celery 工作进程,然后再windows 上发送任务

可以看到异步任务执行了。

跟我们想的是一样的,需要注意的是,celery 工作进程需要在 celery_task 文件所在的目录下开启。

celery -A celery_task worker -l info 命令是怎么回事

- celery 是经过特殊处理的Python包,也就是我们使用

pip install celery安装的这个 celery,他可以像软件一样执行。 - -A celery_task 寻找 名为 celery_task 的Python文件,好去加载并执行他,这个文件里面就定义了 celery 应用

- 启动一个工作机器 worker

注意,如果 celery_task 不是一个文件,而是一个目录,那么他就会去目录里面继续寻找名为 celery 的 Python 文件,当 celery_task 是一个文件夹的时候,内部的应用文件名必须叫 celery,他会像加载之前的 celery_task 时候一样加载 celery 文件中的代码。

如果 celery_task 是一个文件夹的话,就是另外一种配置方式了,是多任务执行,这种执行方式可以更加方便我们灵活定义任务。

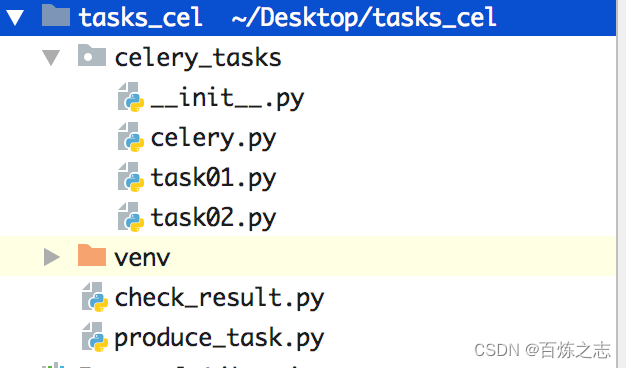

Celery 的多任务结构

celery.py:

from celery import Celery

cel = Celery('celery_demo',

broker='redis://127.0.0.1:6379/1',

backend='redis://127.0.0.1:6379/2',

# 包含以下两个任务文件,去相应的py文件中找任务,对多个任务做分类

include=['celery_tasks.task01',

'celery_tasks.task02'

])

# 时区

cel.conf.timezone = 'Asia/Shanghai'

# 是否使用UTC

cel.conf.enable_utc = False

task01.py,task02.py:

#task01

import time

from celery_tasks.celery import cel

@cel.task

def send_email(res):

time.sleep(5)

return "完成向%s发送邮件任务"%res

#task02

import time

from celery_tasks.celery import cel

@cel.task

def send_msg(name):

time.sleep(5)

return "完成向%s发送短信任务"%name

produce_task.py:

from celery_tasks.task01 import send_email

from celery_tasks.task02 import send_msg

# 立即告知celery去执行test_celery任务,并传入一个参数

result = send_email.delay('yuan')

print(result.id)

result = send_msg.delay('yuan')

print(result.id)

check_result.py:

from celery.result import AsyncResult

from celery_tasks.celery import cel

async_result = AsyncResult(id="562834c6-e4be-46d2-908a-b102adbbf390", app=cel)

if async_result.successful():

result = async_result.get()

print(result)

# result.forget() # 将结果删除,执行完成,结果不会自动删除

# async.revoke(terminate=True) # 无论现在是什么时候,都要终止

# async.revoke(terminate=False) # 如果任务还没有开始执行呢,那么就可以终止。

elif async_result.failed():

print('执行失败')

elif async_result.status == 'PENDING':

print('任务等待中被执行')

elif async_result.status == 'RETRY':

print('任务异常后正在重试')

elif async_result.status == 'STARTED':

print('任务已经开始被执行')

开启work:celery worker -A celery_task -l info -P eventlet,添加任务(执行produce_task.py),检查任务执行结果(执行check_result.py)

Django 配置 celery

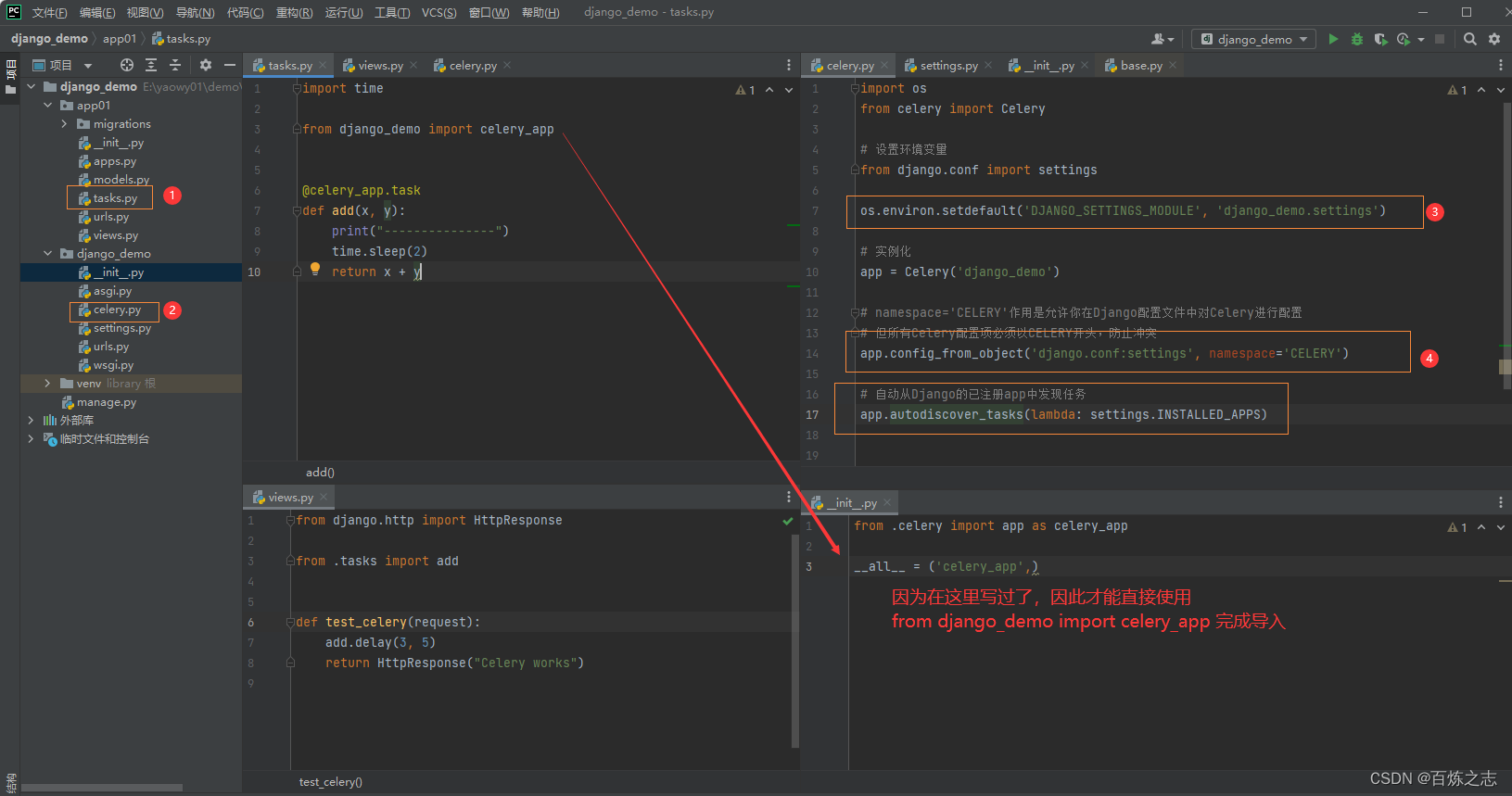

目录结构

【1】每个应用下的 tasks 文件,必须叫这个名字,在 django 应用目录下,与 models 文件平齐

【2】项目主应用下,必须叫这个名字,联想一下多任务目录结构,其实是一个原理,执行命令的时候,因为项目主应用名是个文件夹,所以要在该目录下寻找一个名为 celery 的文件,加载他的代码,然后执行,启动 worker 进程

【3】加载 django 环境,其实就相当于一个测试脚本执行而已

【4】加载 settings 中的 celery 配置

【5】导入 django 项目下的所有应用,方便寻找这些应用下的 tasks 文件,从而从这些文件里面寻找所有的 task,注册进 celery worker 中去,所以第二步中,每个应用下的 tasks,必须是这个名字

源码里面就是这么找的。

django配置

settings.py

INSTALLED_APPS = [

'django.contrib.admin',

'django.contrib.auth',

'django.contrib.contenttypes',

'django.contrib.sessions',

'django.contrib.messages',

'django.contrib.staticfiles',

'django_celery_results', # 注册celery_result 应用,方便后面查询 result 的执行结果

'app01'

]

# 如果docker部署的redis,使用redis://redis:6379

CELERY_BROKER_URL = "redis://192.168.1.10:6379/0"

# celery时区设置,建议与Django settings中TIME_ZONE同样时区,防止时差

# Django设置时区需同时设置USE_TZ=True和TIME_ZONE = 'Asia/Shanghai'

CELERY_TIMEZONE = TIME_ZONE

# 为django_celery_results存储Celery任务执行结果设置后台

# 格式为:db+scheme://user:password@host:port/dbname

# 支持数据库django-db和缓存django-cache存储任务状态及结果

CELERY_RESULT_BACKEND = "django-db"

# celery内容等消息的格式设置,默认json

CELERY_ACCEPT_CONTENT = ['application/json', ]

CELERY_TASK_SERIALIZER = 'json'

CELERY_RESULT_SERIALIZER = 'json'

# 为任务设置超时时间,单位秒。超时即中止,执行下个任务。

CELERY_TASK_TIME_LIMIT = 300

# 为存储结果设置过期日期,默认1天过期。如果beat开启,Celery每天会自动清除。

# 设为0,存储结果永不过期

CELERY_RESULT_EXPIRES = 0

# 任务限流

CELERY_TASK_ANNOTATIONS = {'tasks.add': {'rate_limit': '10/s'}}

# Worker并发数量,一般默认CPU核数,可以不设置

CELERY_WORKER_CONCURRENCY = 2

# 每个worker执行了多少任务就会死掉,默认是无限的

# CELERY_WORKER_MAX_TASKS_PER_CHILD = 200

执行命令

celery -A django_demo worker -l info -P eventlet

然后启动 django 项目,浏览器请求测试接口。不出意外的话是可以打通的。

django 配置 celery 的时候,是有严格得目录以及文件名要求的,只有这样才能少传参数,对吧? Django项目本身也是一个目录要求非常严格的框架

507

507

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?