摘要

最近主流的掩模蒸馏方法是通过从教师网络的特征图中重建学生网络的选择性掩模区域来实现的。在这些方法中,需要适当的选择掩模区域,使重构的特征像教师特征一样具有足够的识别和表示能力。然而,以前的掩模蒸馏方法只关注空间掩模,使得得到的掩模区域偏向于空间重要性,而没有编码信息通道线索。在这项研究中,我们设计了一个双掩模知识蒸馏(DMKD)框架,它可以捕获空间上重要的和通道上的信息线索,用于全面的掩模特征重建。更具体的说,我们采用双重注意机制来引导各自的掩模分支,从而导致构建的特征编码具有双重意义。此外,通过自调整加权策略实现重构特征的融合,实现特征的有效提取。

1、介绍

早期的知识蒸馏方法主要关注网络的输出头部,代表性方案包括基于Logit的分类蒸馏和基于head的检测蒸馏。最近,基于特征的蒸馏策略由于其理想的任务不可知的灵活性受到了越来越多的关注。特别是,特征蒸馏有利于学生网络模仿教师特征,增强表征能力。在目标检测中,各种先进的特征蒸馏方法得到了发展。具体来说,经典的FitNet在全局特征级别上进行蒸馏。FGD的发展是为了在一个统一的框架内区分前景蒸馏和背景蒸馏。CWD简单地最小化了两个网络的通道概率图之间的KL散度,并且蒸馏过程倾向于每个通道的最显著区域。

在特征蒸馏方法中,最近的研究表明,学生模型最好首先从教师模型中重建重要特征,而不是跟随教师生成竞争表征。例如,MGD提出掩码学生网络特征图中的像素,通过一个简单的块重构出教师模型的特征。AMD在学生网络的特征图上进行了注意引导的特征掩码,这样就可以通过空间自适应特征掩模来识别特定区域的重要特征,而不是之前的方法中的随机掩模。

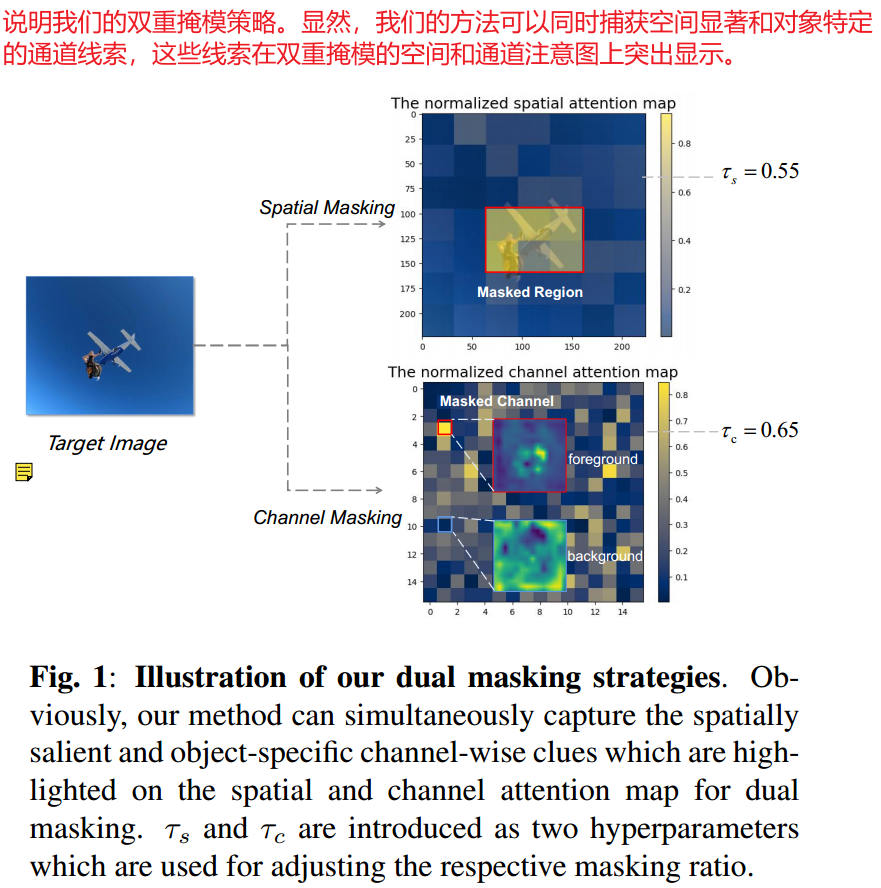

虽然当前的掩模特征蒸馏方法有助于提高学生模型的性能,但上述方法中选择性掩模区域的生成仅考虑空间重要性。例如,MGD执行与位置无关的随机特征掩码,导致重建非信息和语义无关的区域。这种限制在AMD中有所缓解,AMD利用空间屏蔽来识别空间显著区域,但他仍然无法识别对密集预测任务至关重要的信息通道。在本研究中,不同的是,我们试图捕获空间重要区域和对象感知通道线索,这两者都可以通过双重注意机制获得。特别是,采用图1所示的双掩模策略进行掩模特征重建,以全面表征重要的目标感知特征。

方法

Preliminaries

在详细阐述我们所提出的方法之前,我们简要回顾一下基本的基于特征的蒸馏框架,其表述为:

L

b

a

s

e

=

∑

c

=

1

C

∑

h

=

1

H

∑

w

=

1

W

M

S

E

(

θ

a

l

i

g

n

(

F

c

;

h

;

w

S

)

,

F

c

;

h

;

w

T

)

L_{base} = \sum_{c=1} ^ C \sum_{h=1} ^ H \sum_{w=1} ^W MSE(\theta _{align}(F_{c;h;w} ^S),F_{c;h;w} ^T)

Lbase=c=1∑Ch=1∑Hw=1∑WMSE(θalign(Fc;h;wS),Fc;h;wT)

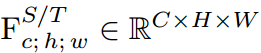

是从学生网络和教师网络生成的特征图。MSE(.)表示可学习函数

是从学生网络和教师网络生成的特征图。MSE(.)表示可学习函数 对齐的学生特征与教师特征之间的拟合误差。它可以从上述基于vanilla特征的蒸馏模式的公式迫使学生的原始特征是可能接近教师的对应特征。从这个意义上说,教师充当了直接模仿的模版,特征蒸馏可以被识别为一种简单明了的算法,因为学生和教师网络的特征直接用于表示匹配。

对齐的学生特征与教师特征之间的拟合误差。它可以从上述基于vanilla特征的蒸馏模式的公式迫使学生的原始特征是可能接近教师的对应特征。从这个意义上说,教师充当了直接模仿的模版,特征蒸馏可以被识别为一种简单明了的算法,因为学生和教师网络的特征直接用于表示匹配。

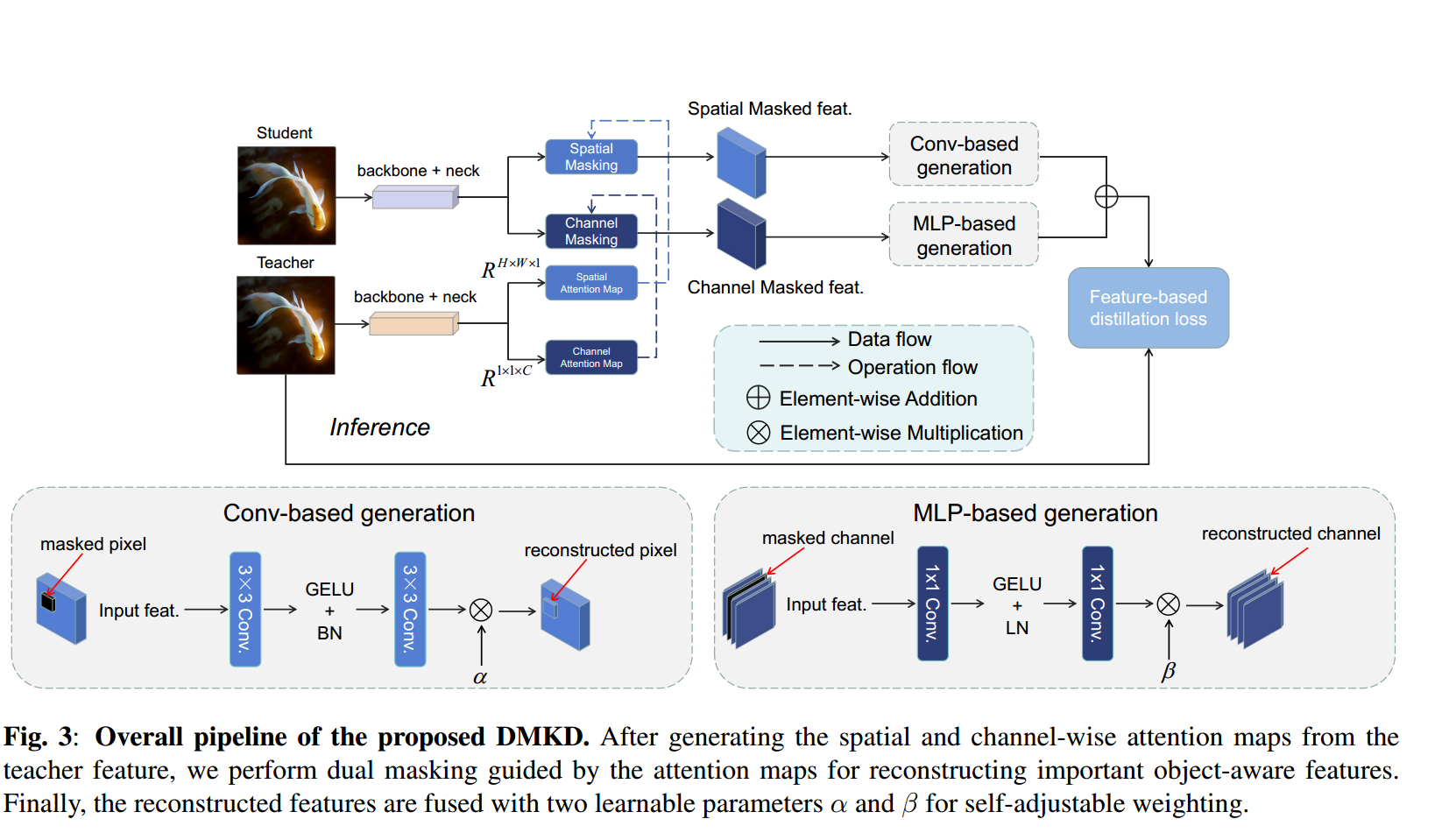

我们的DMKD框架

为了将对象感知语义全面编码到学生网络中,我们开发了一种双掩模知识蒸馏(DKMD)框架,在该框架中,空间显著区域和信道通道都被发现,以便更好地重建掩模特征。值得注意的是,我们的模型可以被视为一个即插即用的增强模块,适用于vanilla的基于特征的蒸馏方法。如图3所示,

我们的DMKD包括三个关键步骤:双注意图生成,注意引导掩模和自调节加权融合。首先,空间和通道方面的注意图是由教师特征生成的,公式如下:

A

s

=

ϕ

a

l

i

g

n

(

S

i

g

m

o

i

d

(

1

C

T

<

∣

∣

F

1

T

∣

∣

2

2

,

.

.

.

.

,

∣

∣

F

n

T

∣

∣

2

2

)

)

A^s = \phi _{align} (Sigmoid(\frac{1}{CT} < ||F_1^T||_2^2,....,||F_n^T||^2_2))

As=ϕalign(Sigmoid(CT1<∣∣F1T∣∣22,....,∣∣FnT∣∣22))

A s = S i g m o i d ( 1 H W T ∑ h = 1 H ∑ w = 1 W F h , w , 1 T , . . . . , F h , w , C T ) A^s = Sigmoid(\frac{1}{HWT} \sum _{h=1} ^H \sum _{w=1} ^W F_{h,w,1}^T,....,F_{h,w,C}^T) As=Sigmoid(HWT1h=1∑Hw=1∑WFh,w,1T,....,Fh,w,CT)

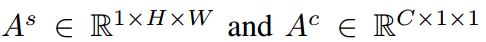

其中, 分别为空间注意图和通道注意图。

分别为空间注意图和通道注意图。 是教师特征映射的第n个向量。

是教师特征映射的第n个向量。 为C-th通道的特征映射。引入T来调整分布。

为C-th通道的特征映射。引入T来调整分布。

接下来,将得到的双注意图 用于导出相应的掩模图

用于导出相应的掩模图

,其阈值分别为

,其阈值分别为 。

。

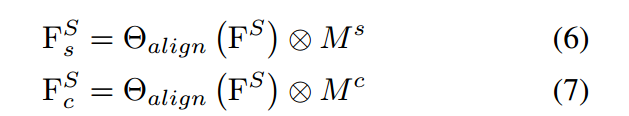

其中 分别与

分别与 具有相同的形状。然后,我们利用它们对学生特征进行空间和通道掩模,生成两个掩模特征

具有相同的形状。然后,我们利用它们对学生特征进行空间和通道掩模,生成两个掩模特征 。

。

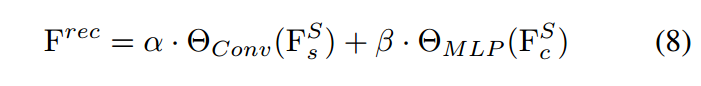

最后,分别采用基于卷积和多层感知机(MLP)的两种不同的生成块来重建空间和信道屏蔽特征,值得注意的是,信道重建时由MLP实现的,这与MGD和AMD的空间重建不同,因为信道特征是空间独立的。换句话说,这个生成应该只关注通道间的相互作用。

因此,蒸馏损失可以建立在重构的学生特征和对应的教师特征上。

514

514

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?