文章目录

Network in Network论文阅读笔记2014

Abstract

我们提出了一种新的深度网络结构,叫做“Network in Network(NIN)”来增强模型对感受野内部local patches的辨别力。传统的卷积层使用线性滤波器,然后使用非线性激活函数来扫描输入。**而我们使用更复杂的结构建立了一个micro神经网络来在感受野之中对数据进行抽象。**我们使用多层感知机MLP来实现这个微型神经网络,MLP是一种很好的函数近似器。==我们通过在输入上以与CNN近似的方式,使用微型神经网络进行滑窗,得到特征图,然后特征图输出到下一层。==深层的NIN网络可以靠堆叠小网络实现。通过微型神经网络增强了局部模型,我们可以在分类层,对特征图使用全局平均池化(global average pooling),与传统的FC层相比,它更易于解释且不易过拟合。我们使用NIN在CIFAR-10和CIFAR-100上得到当今最好水平,在SVHM和MINST得到了较好的表现。

1.Introduction

CNN包括一系列卷积层和池化层,卷积层将卷积核与卷积核的感受野范围内的输入做内积,然后接一个非线性激活函数,输出结果叫做特征图。

CNN中的卷积核对于它包含的data来说是一种广义线性模型(Generalized linear model,GLM),我们认为GLM的抽象等级比较低。**所谓抽象,我们的意思是该特征对于相同概念的变体是不变的。**使用一个更有力的非线性函数近似器替换GLM可以提升模型的抽象能力。**当要学习的潜在concepts是线性可分得时候,GLM可以取得很好的抽象效果,也就是说,不同的概念可以由GLM定义的平面分开。**因此,传统的CNN简单的就假设这些潜在概念是线性可分得。然而,实际情况下,同种概念的数据也可能以一种非线性流形存在,因此可以表示这些概念的representations通常都是输入的高度非线性函数。在NIN中,我们使用一个“micro network”替代GLM,这个微小网络是一个普通的非线性函数近似器(approximator)。我们选择MLP作为微小网络的实例,它是一个通用函数逼近器和也是一个可通过反向传播训练的神经网络。

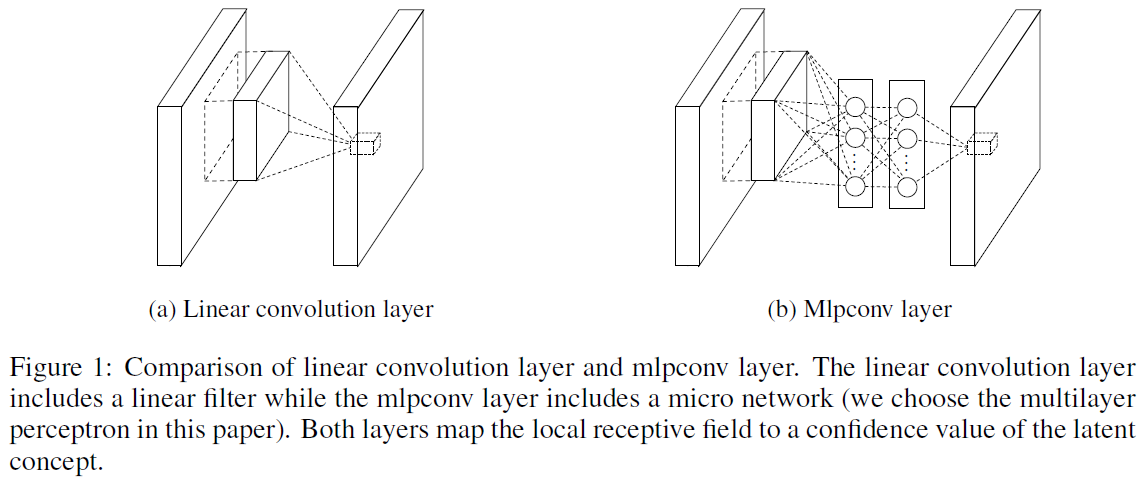

在图1中,我们比较了我们的结构mlpconv以及CNN,这两种结构都是把感受野内输入输出成特征向量。==mlpconv把输入的局部块,通过一个MPL(有多个带非线性激活函数的FC层),映射成输出特征向量。这个MLP在所有的局部感受野中是共享的,通过使用MLP进行滑窗(与CNN类似)来得到特征图,然后传入下一层。==多个mlpconvs堆叠起来就是我们的网络结构NIN。

与传统的CNN使用FC层用作分类不同,我们直接将最后一个mlpconv层在空间上的输出通过一个全局平均池化层,把这个特征图的空间平均输出作为分类的信度,把这个输出向量送到softmax层。在传统的CNN中,由于FC层之间类似黑盒,因此很难解释来自目标层的类别级别的信息如何传递回先前的卷积层。相反,全局平均池化层更加有意义、可解释,因为增强了特征图与类别之间的联系,这是通过使用了micro network的更强的局部模型实现的。另外,FC层更易于过拟合,十分依赖dropout正则化,然而全局平均池化自己就是一个结构上的正则器,它可以防止总体结构的过拟合。

2.Concolutional Neural Networks

经典的CNN网络由多个堆叠的卷积层和空间池化层组成,通过线性的卷积核+非线性激活函数(ReLU、sigmoid、tanh等)生成特征图。使用ReLU为例子,特征图由下面式子计算:

f i , j , k = m a x ( w k T x i , j , 0 ) f_{i,j,k}=max(w_k^Tx_{i,j},0) fi,j,k=max(wkTxi,j,0)

这里面 ( i , j ) (i,j) (i,

NIN网络引入了微神经网络结构增强模型对局部区域的辨别力,使用多层感知机(MLP)作为卷积层的替代。通过MLP在感受野内抽象数据,提高模型的非线性表示能力。全局平均池化作为分类层,提供可解释性并降低过拟合风险。实验显示,NIN在CIFAR-10、CIFAR-100、SVHN和MINST数据集上表现出色。

NIN网络引入了微神经网络结构增强模型对局部区域的辨别力,使用多层感知机(MLP)作为卷积层的替代。通过MLP在感受野内抽象数据,提高模型的非线性表示能力。全局平均池化作为分类层,提供可解释性并降低过拟合风险。实验显示,NIN在CIFAR-10、CIFAR-100、SVHN和MINST数据集上表现出色。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

813

813

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?