子集搜索与评价

我们先来理解以下概念:

相关特征:对当前学习任务有用的属性;

无关特征:对当前学习任务无用的属性;

特征选择:从给定的特征集合中选择出相关特征子集的过程,相当于直接在属性操作上降维,但是过程中必须保证不丢失重要特征。

- 为什么要进行特征选择?原因:①为了解决属性过多导致的维数灾难问题;②去除不相关的特征往往会降低学习任务的难度。

要在初始的特征集合中选取一个包含了所有重要信息的特征子集,我们必须要避免遭遇组合爆炸,需要产生一些候选子集,对它们进行评价,最终直到找不出更好的候选子集为止。

那么我们就产生了两个问题:1.如何根据评价结果获取下一个候选特征子集?2.如何评价候选特征子集的好坏?

第一个环节是子集搜索(subset search)问题,有以下三种策略:

1.前向搜索:初始将每个特征当做一个候选特征子集,然后从当前所有的候选子集中选择出最佳的特征子集;接着在上一轮选出的特征子集中添加一个新的特征,同样地选出最佳特征子集;最后直至选不出比上一轮更好的特征子集。

2.后向搜索:初始将所有特征作为一个候选特征子集;接着尝试去掉上一轮特征子集中的一个特征并选出当前最优的特征子集;最后直到选不出比上一轮更好的特征子集。

3.双向搜索:将前向搜索与后向搜索结合起来,即在每一轮中既有添加操作也有剔除操作。

这三种策略都属于贪心的,故都是仅考虑了使本轮选定集最优,故有几率得不到全局最优解。若不进行穷举,这样的问题无法避免。

第二个环节是子集评价(subset evaluation)问题,即根据我们之前学过的信息熵和信息增益的计算方法,来比较判断特征子集包含的有助于分类的信息多少。信息增益越大,意味着特征子集包含的有助于分类的信息越多,因此,我们可基于训练数据D来计算其信息增益,以此作为评价准则。

-

特征选择方法 = 特征子集搜索机制 + 子集评价机制

-

常见的特征选择方法大致可分为三类:过滤式(filter)、包裹式(wrapper)和嵌入式(embedding)。

过滤式选择

- 过滤式方法:先对数据集进行特征选择,然后再训练学习器,特征选择与后续学习器无关。这相当于先用特征特征选择过程对初始特征进行过滤,再用过滤后的特征来训练模型。

Relief是一种著名的过滤式特征选择方法。该方法利用“相关统计量”来度量特征的重要性。该统计量是一个向量,每个分量分别对应于一个初始特征,而特征子集的重要性则是由子集中每个特征所对应的相关统计量分量之和来决定。

- Relief特征选择方法:

1.制定一个阈值τ,然后选择比阈值τ大的相关统计分量所对应的特征;

2.指定欲选取特征个数k,然后选择相关统计分量最大的k个特征。

接下来的问题就是如何计算相关统计量:

对于每个示例xi,Relief先在xi的同类样本中寻找其最近邻,这称为猜中近邻(near-hit);再从xi的异类样本中寻找其最近邻,称为猜错近邻(near-miss);相关统计量对应于属性j的分量为:

- 公式理解:对于near-hit,两者j属性的距离越小越好,对于near-miss,j属性距离越大越好。若xi与其猜中近邻在属性j上的距离小于xi与其猜错近邻的距离,则说明属性j对分类同类与异类样本是有益的,于是增大属性j所对应的统计量分量;反之相对。

包裹式选择

- 包裹式选择:直接把最终将要使用的学习器性能作为特征自己的评价标准,因此从性能上看,包裹式特征选择比过滤式特征选择更好,但是由于需要多次训练学习器,计算开销会大得多。

由于包裹式特征选择方法直接针对给定学习器进行优化,因此从最终学习器性能来看,包裹式特征选择比过滤式特征选择更好,但计算开销更大。

LVW(Las Vegas Wrapper) 是一个典型的包裹式特征选择方法,它在拉斯维加斯方法下使用随机策略来搜索。

- 它的算法步骤为:

1.循环的每一轮随机产生特征子集;

2.在产生的子集上通过交叉验证推断当前特征子集的误差;

3.进行多次循环,在其中选择误差最小的那个特征子集,或循环次数达到规定上限T次,就停止循环。

这种方法开销较大,故设置了停止参数,有可能无法给出解,若无时间限制,那它就能给出解。

嵌入式选择与L1正则化

- 嵌入式:是一种将特征选择与学习器训练完全融合的特征选择方法,即将特征选择融入学习器的优化过程中。相当于把属性和权重嵌入到目标函数中进行学习任务。

L1范数和L2范数正则化都有助于降低过拟合风险。除此之外,L1范数比L2范数更易于获得稀疏解,即它求得的w有更多零分量。

求解L1正则化的结果是得到了仅采用一部分特征的模型。基于L1正则化的学习方法就是一种嵌入式特征选择方法,其特征选择过程与学习器训练过程融为一体,同时完成。

- 总的来说:L1范数会趋向产生少量的特征,其他特征的权值都是0;L2会选择更多的特征,这些特征的权值都会接近于0。这样L1范数在特征选择上就十分有用,而L2范数则具备较强的控制过拟合能力。

稀疏表示与字典学习

- 特征选择所考虑的问题是特征具有稀疏性,即矩阵中的许多列与当前学习任务无关,通过特征选择去除这些列,则学习器训练过程仅需在较小的矩阵上进行,学习任务的难度可能有所降低,涉及的计算和存储开销会减少,学得的模型可解释性也会提高。

可以这样理解稀疏性:每个文档作为一个样本,每一列为字典中的字,则这样形成的矩阵中,每行有大量的零元素,且对于每个文档样本,每列零元素出现的位置往往很不相同。

稀疏表达可以给学习任务带来好处:1.文本数据由于具有高度稀疏性而线性可分;2.稀疏表达已经有着高效的存储解决方案,不会造成存储上的巨大负担。

很多数据集并不是稀疏的,而是稠密的,我们有时需要将数据转化为稀疏表示(sparse representation),而且希望是“恰当稀疏”而不是“过渡稀疏”。

- 为普通稠密表示的样本通过寻求合适的字典而找到一个合适的稀疏表示形式的过程就叫做字典学习(dictionary learning),或者稀疏编码。

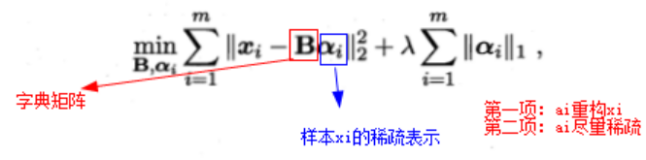

给定一个数据集,字典学习/稀疏编码指的便是【通过一个字典将原数据转化为稀疏表示】,因此最终的目标就是求得字典矩阵B及稀疏表示α。

压缩感知

压缩感知:关注的是通过欠采样信息来恢复全部信息。在实际问题中,为了方便传输和存储,我们一般将数字信息进行压缩,这样就有可能损失部分信息,我们需要根据已有的信息来重构出全部信号,比如奈奎斯特采样定理。

压缩感知的前提是已知的信息具有稀疏表示。

- 压缩感知关注的是如何利用信号本身所具有的稀疏性,从部分观测样本中恢复原信号。

- 它可以分为两部分:

感知测量:对原始信号进行处理以获得稀疏样本表示,涉及傅里叶变换、小波变换、字典学习、稀疏编码等;

重构恢复:基于稀疏性从少量观测中复原信号,也是压缩感知的精髓。a

266

266

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?