分类和回归

监督学习问题主要可以分为两类,即分类问题和回归问题

分类问题预测数据属于哪一类别 ;----离散

回归问题根据数据预测一个数值; ----连续

通俗地讲,分类问题就是预测数据属于哪一种类型,比如上面的房屋出售预测,提供房屋的一些特征,预测房屋能不能出售出去,回归问题就是预测一个数值,比如给出房屋的一些特征,预测房价;

分类问题

在监督学习中,当输出变量Y取有限个离散值时,预测问题就成了分类(classification)问题;

监督学习从数据中学习一个分类模型或一个分类决策函数,称为分类器(classifier);分类器对新的输入进行预测,称为分类;

分类问题解决方法:K近邻,决策树,感知机,逻辑斯蒂回归(Logistic回归)、支持向量机,朴素贝叶斯,神经网络等;

精确率和召回率

评价分类器性能的指标一般是分类准确率(accuracy),它定义为分类器对测试集正确分类的样本数与总样本数之比

对于二类分类问题,常用的评价指标是精确率(precision)与召回率(recall);

通常以关注的类为正类,其他为负类,按照分类器在测试集上预测的正确与否,会有四种情况出现,他们的总数分别记作:

-TP :将正类预测为正类的数目

-FN :将正类预测为负类的数目

-FP :将负类预测为正类的数目

-TN :将负类预测为负类的数目

回归问题

huige

huige

回归问题用于预测输入变量和输出变量之间的关系;

回归模型就是表示从输入变量到输出变量之间映射的函数;

回归问题的学习等价于函数拟合:选择一条函数曲线,使其很好地拟合已知数据,并且能够很好地预测未知数据;

回归问题的分类:

按照输入变量的个数:一元回归和多元回归

按照模型类型:线性回归和非线性回归

回归学习的损失函数:平方损失函数

如果选取平方损失函数作为损失函数,回归问题可以用最著名的最小二乘法(least squraes)来求解

模型求解算法

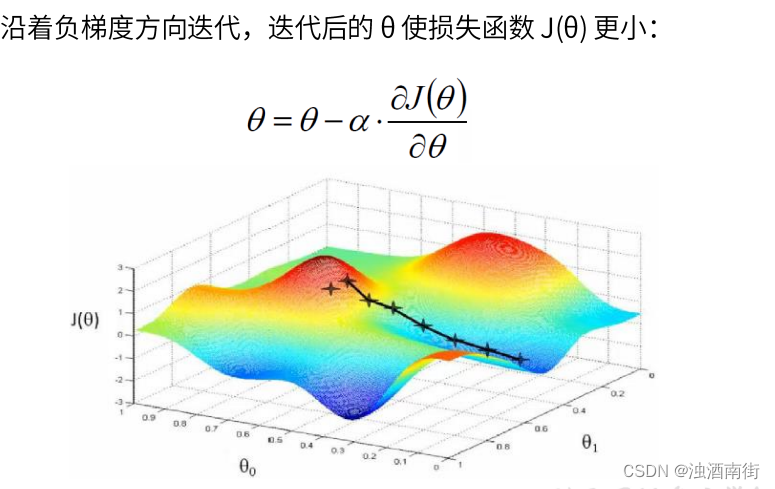

梯度下降法

梯度下降法(gradient descent)是一种常用的一阶优化函数,是求解无约束优化问题最简单、最经典的方法之一

梯度方向:函数变化增长最快的方向(变量沿此方向变化时函数增长最快)

负梯度方向:函数变化减少最快的方向(变量沿此方向变化时函数减少最快)

损失函数是系数的函数,如果系数沿着损失函数的负梯度方向变化,此时损失函数减少最快,能够以最快速度下降到极小值

梯度下降不一定能够找到全局的最优解,有可能是一个局部最优解;如果损失函数是凸函数,梯度下降的解就一定是全局最优解

牛顿法和拟牛顿法

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?